OpenAI, Anthropic e Google continuano a spingere i confini dei modelli linguistici di grandi dimensioni con le loro ultime offerte di punta: o3 di OpenAI (e la sua variante migliorata o3-pro), Claude Opus 4 di Anthropic e Gemini 2.5 Pro di Google. Ognuno di questi modelli offre innovazioni architetturali uniche, punti di forza in termini di prestazioni e integrazioni di ecosistema che soddisfano diversi casi d'uso, dall'assistenza alla codifica di livello aziendale ai miglioramenti della ricerca rivolta ai consumatori. Questo confronto approfondito esamina la cronologia delle versioni, le capacità tecniche, le prestazioni di benchmark e le applicazioni consigliate per aiutare le organizzazioni a scegliere il modello più adatto alle proprie esigenze.

Cos'è o3 di OpenAI e come si è evoluto?

OpenAI ha introdotto o3 per la prima volta il 16 aprile 2025, posizionandolo come "il nostro modello più intelligente", progettato per contesti estesi e risposte altamente affidabili. Poco dopo, il 10 giugno 2025, OpenAI ha rilasciato o3-pro, una variante ottimizzata per le prestazioni, disponibile per gli utenti Pro in ChatGPT e tramite API, che offre inferenza più rapida e throughput più elevato in presenza di carichi di lavoro elevati.

Finestra di contesto e produttività

OpenAI o3 offre un Gettone da 200K finestra di contesto sia per l'input che per l'output, consentendo la gestione di documenti estesi, basi di codice o conversazioni multi-turn senza frequenti troncamenti. La sua produttività è di circa 37.6 token/sec, che, pur non essendo il migliore, garantisce una reattività costante per carichi di lavoro sostenuti.

Ragionamento deliberativo avanzato

- “Catena di pensiero privata”: o3 è stato addestrato tramite apprendimento per rinforzo a pianificare e ragionare attraverso passaggi intermedi prima di produrre il risultato finale, migliorando notevolmente la sua capacità di deduzione logica e scomposizione dei problemi.

- Allineamento deliberativo: Incorpora tecniche di sicurezza che guidano il modello ad aderire in modo più affidabile alle linee guida attraverso un ragionamento passo dopo passo, riducendo gli errori più gravi in attività complesse del mondo reale.

Prezzi e integrazione aziendale

Il prezzo di OpenAI per o3 è di circa $2 per milione di token di input e al $8 per milione di token di outputCiò lo posiziona nella fascia media: più conveniente rispetto ai modelli premium come Claude Opus 4 per carichi di lavoro pesanti, ma più costoso rispetto alle alternative più economiche come Gemini 2.5 Pro. Fondamentalmente, le aziende traggono vantaggio dall'integrazione perfetta con il più ampio ecosistema API OpenAI, che comprende incorporamenti, messa a punto ed endpoint specializzati, riducendo al minimo i costi di integrazione.

In che modo Claude Opus 4 si differenzia sul mercato?

Anthropic ha annunciato Claude Opus 4 il 22 maggio 2025, pubblicizzandolo come "il miglior modello di codifica al mondo", con prestazioni costanti su attività complesse e di lunga durata e flussi di lavoro degli agenti. È stato lanciato simultaneamente nell'API di Anthropic e tramite Amazon Bedrock, rendendolo accessibile ai clienti AWS tramite le funzioni LLM e l'API REST di Bedrock...

Capacità di “pensiero” estese

Una caratteristica distintiva dell'Opus 4 è la sua “pensiero esteso” Modalità beta, che alloca dinamicamente il calcolo tra il ragionamento sul modello e le invocazioni degli strumenti (ad esempio, ricerca, recupero, API esterne). In combinazione con i "riepiloghi di pensiero", gli utenti ottengono visibilità sulla catena di ragionamento interna del modello, fondamentale per le applicazioni sensibili alla conformità nei settori finanziario e sanitario.

Compromessi tra prezzi e contesto

At $15 per milione di token di input e al $75 per milione di token di output, Claude Opus 4 si trova in cima alla gamma dei prezzi. Il suo Gettone da 200K finestra di input (con un Gettone da 32K Il limite di output è inferiore alla finestra da 2.5 milione di token di Gemini 1 Pro, ma è sufficiente per la maggior parte delle attività di revisione del codice e di ragionamento in forma estesa. Anthropic giustifica il sovrapprezzo enfatizzando l'intensità di calcolo interna e la fedeltà costante della catena di pensiero, con risparmi fino al 90% tramite il caching dei prompt e del 50% tramite l'elaborazione batch. I budget di pensiero estesi sono inclusi per i livelli a pagamento; gli utenti gratuiti possono accedere solo alla variante Sonnet.

Quali sono le caratteristiche e le prestazioni uniche di Gemini 2.5 Pro?

Rilasciato come livello "Pro" di nuova generazione di Google, Gemelli 2.5 Pro si rivolge alle organizzazioni che necessitano di un contesto massiccio, input multimodali e scalabilità conveniente. In particolare, supporta fino a Token 1,048,576 in un unico prompt, in entrata, e Token 65,535 in uscita, consentendo flussi di lavoro di documenti end-to-end che si estendono su centinaia di migliaia di pagine.

Contesto superiore e multimodalità

Gemini 2.5 Pro brilla con il suo 1M-token finestra di contesto, facilitando casi d'uso come l'analisi dei contratti legali, l'estrazione di brevetti e il refactoring completo della base di codice. Il modello accetta nativamente testo, codice, immagini, audio, PDF e fotogrammi video, semplificando le pipeline multimodali senza fasi di pre-elaborazione separate.

In che modo Gemini migliora la ricerca multimodale e conversazionale?

Gemini 2.5 Pro si distingue per la sua metodologia "query fan-out": scompone le query complesse in sotto-domande, esegue ricerche parallele e sintetizza al volo risposte complete e colloquiali. Grazie al supporto per input di testo, voce e immagini, la modalità AI sfrutta le capacità multimodali di Gemini per soddisfare diverse interazioni utente, sebbene sia ancora in una fase iniziale e possa occasionalmente interpretare erroneamente le query.

Prezzi competitivi

Con un tasso di input di Da 1.25 a 2.50 $ per milione di token e Da 10 a 15 $ per milione di token in uscita, Gemini 2.5 Pro offre il meglio prezzo-token rapporto tra i tre. Ciò lo rende particolarmente interessante per applicazioni ad alto volume e ad alta intensità di documenti, in cui i contesti lunghi determinano il consumo di token più delle metriche di performance grezze. Con piani premium che sbloccano budget "Deep Think" e una maggiore produttività. Gli abbonamenti Google AI Pro e Ultra includono l'accesso a Gemini 2.5 Pro insieme ad altri strumenti come la generazione video Veo e NotebookLM.

Architetture e capacità sottostanti

OpenAI o3: ragionamento riflessivo su larga scala

o3 di OpenAI è un trasformatore pre-addestrato generativo riflessivo, progettato per dedicare ulteriore tempo di deliberazione ad attività di ragionamento logico passo-passo. Dal punto di vista architettonico, si basa sulla struttura portante del trasformatore di GPT-4, ma incorpora un meccanismo di "budget di pensiero": il modello alloca dinamicamente più cicli di calcolo a problemi complessi, creando catene di pensiero interne prima di generare output. Ciò si traduce in prestazioni notevolmente migliorate in domini che richiedono ragionamento multi-step, come matematica avanzata, ricerca scientifica e sintesi di codice.

Claude Opus 4: Ragionamento ibrido per flussi di lavoro estesi

Claude Opus 4 di Anthropic è il modello più potente finora, ottimizzato per la codifica e i flussi di lavoro agentici sostenuti. Come o3, sfrutta un core di trasformazione, ma introduce modalità di ragionamento ibride – risposte quasi istantanee ("pensiero rapido") rispetto a deliberazioni estese ("pensiero profondo") – che gli consentono di mantenere il contesto su migliaia di passaggi e ore di elaborazione. Questo approccio ibrido rende Opus 4 particolarmente adatto per pipeline di ingegneria del software di lunga durata, attività di ricerca multifase e orchestrazione di agenti autonomi.

Gemini 2.5 Pro: pensiero multimodale con budget adattivi

Gemini 2.5 Pro di Google DeepMind estende le capacità native di multimodalità e ragionamento di Gemini. Introduce "Deep Think", un meccanismo di pensiero parallelo adattivo che distribuisce sottoattività su moduli interni, sintetizzando i risultati in risposte coerenti. Gemini 2.5 Pro vanta anche una finestra di contesto eccezionalmente lunga, che gli consente di acquisire intere basi di codice, grandi set di dati (testo, audio, video) e documenti di progettazione in un unico passaggio, fornendo al contempo controlli granulari sui budget di pensiero per il compromesso tra prestazioni e costi.

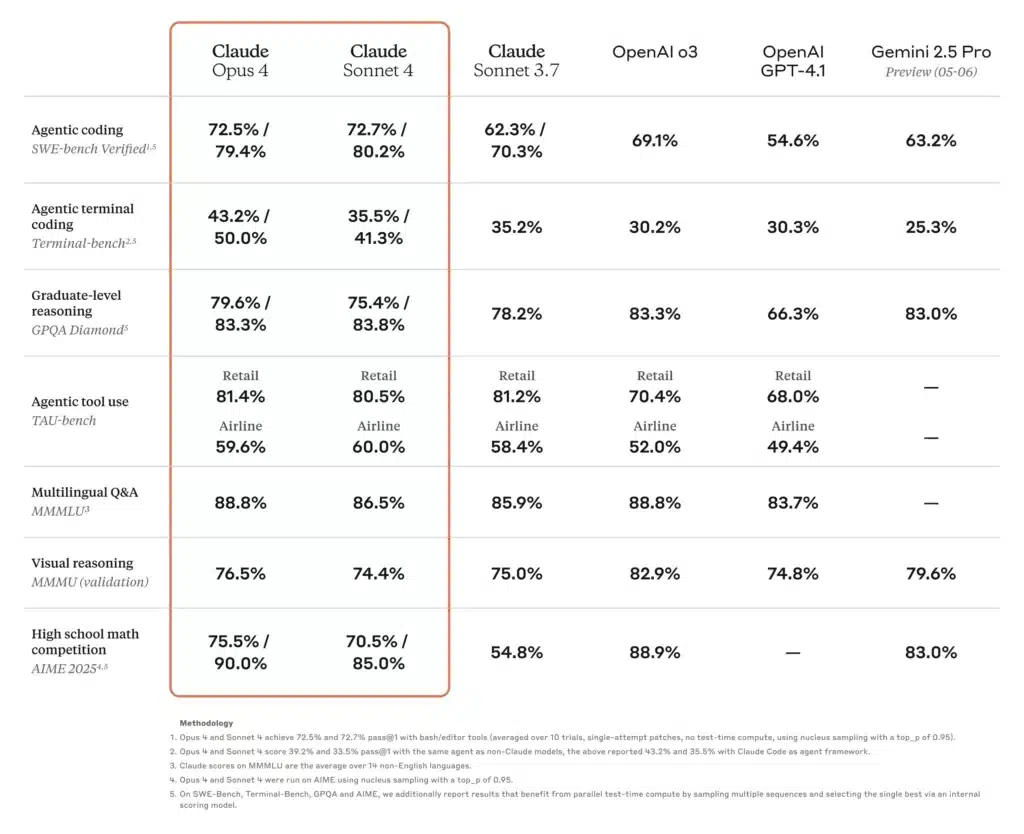

Come si confrontano i benchmark delle prestazioni tra questi modelli?

Ragionamento accademico e scientifico

In una recente classifica di SciArena, o3 ha superato i suoi pari nelle domande di ragionamento tecnico valutate dai ricercatori, a dimostrazione della forte fiducia della comunità nella sua accuratezza scientifica. Nel frattempo, Claude Opus 4 ha dimostrato prestazioni superiori nei benchmark basati su agenti che richiedono una risoluzione di problemi prolungata per più ore, superando i modelli Sonnet fino al 30% nei compiti di TAU-bench e di ragionamento predittivo. Gemini 2.5 Pro è in testa anche in molti benchmark accademici, raggiungendo il primo posto su LMArena per le misure di preferenza umana e mostrando margini significativi nei test di matematica e scienze.

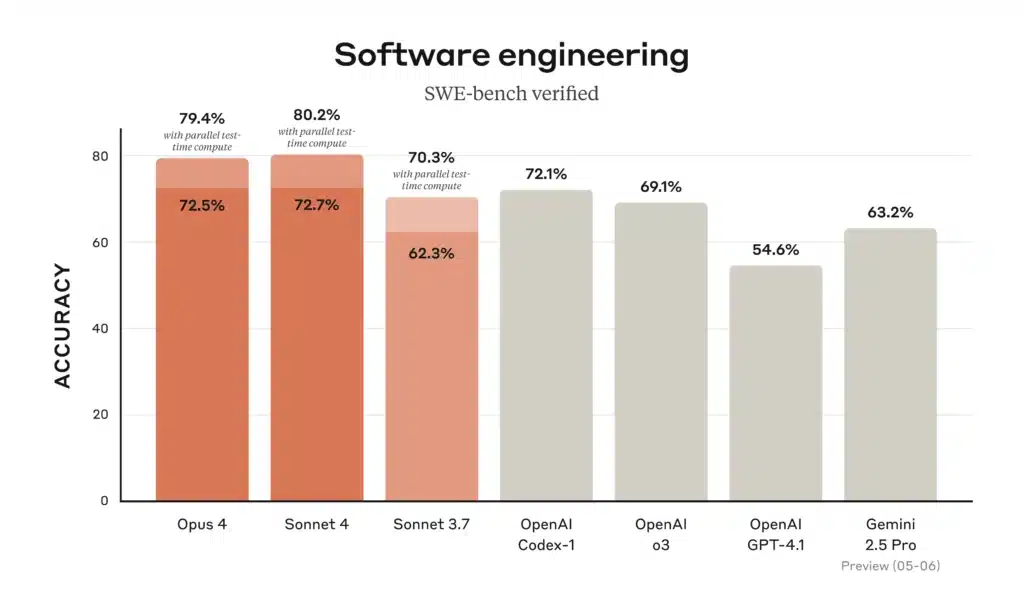

Coding e ingegneria del software

Nelle classifiche di programmazione, Gemini 2.5 Pro "è in testa alla popolare WebDev Arena" e guida i benchmark di programmazione più comuni, grazie alla sua capacità di caricare e analizzare interi repository. Claude Opus 4 detiene il titolo di "miglior modello di programmazione al mondo", con il 72.5% su SWE-bench e il 43.2% su Terminal-bench, benchmark focalizzati su attività software complesse e di lunga durata. o3 eccelle anche nella sintesi e nel debug del codice, ma è leggermente inferiore a Opus 4 e Gemini in scenari di ingegneria multi-step e su larga scala; tuttavia, la sua intuitiva catena di pensiero lo rende altamente affidabile per le singole attività di programmazione.

Utilizzo degli strumenti e integrazione multimodale

Il design multimodale di Gemini 2.5 Pro, che elabora testo, immagini, audio e video, gli conferisce un vantaggio nei flussi di lavoro creativi come simulazioni interattive, analisi visiva dei dati e storyboard video. L'utilizzo di strumenti agentici di Claude Opus 4, tra cui la CLI di Claude Code e le operazioni integrate del file system, eccelle nella creazione di pipeline autonome tra API e database. o3 supporta la navigazione web, l'analisi dei file, l'esecuzione di Python e il ragionamento sulle immagini, rendendolo un versatile "coltellino svizzero" per attività in formato misto, sebbene con limiti di contesto più brevi rispetto a Gemini 2.5 Pro.

Come si confrontano questi modelli negli scenari di codifica del mondo reale?

Quando si tratta di assistenza alla codifica, i benchmark raccontano solo una parte della storia. Gli sviluppatori cercano una generazione di codice accurata, capacità di refactoring e la capacità di comprendere il contesto del progetto distribuito su più file.

Precisione e tassi di allucinazione

- Claude Opus 4 è leader nell'evitamento delle allucinazioni, con meno casi di riferimenti API inesistenti o firme di libreria errate, fondamentali per le basi di codice mission-critical. Il suo tasso di allucinazioni è riportato a ~ 12% su ampi audit del codice rispetto a ~ 18% per Gemelli e ~ 20% per o3.

- Gemelli 2.5 Pro eccelle nelle trasformazioni di massa (ad esempio, la migrazione di modelli di codice su decine di migliaia di righe), grazie alla sua vasta finestra di contesto, ma occasionalmente ha difficoltà con sottili errori logici in grandi blocchi di codice.

- OpenAI o3 rimane il punto di riferimento per frammenti rapidi, generazione di boilerplate e debug interattivo grazie alla sua latenza stabile e all'elevata disponibilità, ma gli sviluppatori spesso eseguono la convalida incrociata con un altro modello per individuare errori nei casi limite.

Ecosistema di strumenti e API

- Entrambi o3 e al Gemini sfruttare strumenti estesi, rispettivamente l'API di chiamata delle funzioni di OpenAI e il framework Actions integrato di Google, consentendo un'orchestrazione fluida del recupero dei dati, delle query del database e delle chiamate API esterne.

- Claude Opus 4 viene integrato in framework agenti come Claude Code (strumento CLI di Anthropic) e Amazon Bedrock, offrendo astrazioni di alto livello per la creazione di flussi di lavoro autonomi senza orchestrazione manuale.

Quale modello offre il miglior rapporto qualità-prezzo?

Il bilanciamento tra capacità grezze, lunghezza del contesto e costi porta a diverse conclusioni sul "miglior valore" a seconda delle caratteristiche del carico di lavoro.

Casi d'uso ad alto volume e incentrati sui documenti

Se si elaborano vasti corpora, come archivi legali, letteratura scientifica o archivi aziendali,Gemelli 2.5 Pro spesso emerge come il vincitore. Il suo 1M-token finestra e prezzo di $ 1.25- $ 2.50 (ingresso) e $ 10- $ 15 I token (di output) forniscono una struttura dei costi imbattibile per attività di lungo contesto.

Ragionamento approfondito e flussi di lavoro multi-step

Quando l'accuratezza, la fedeltà della catena di pensiero e le capacità degli agenti a lungo termine sono importanti, come nella modellazione finanziaria, nei controlli di conformità legale o nelle pipeline di ricerca e sviluppo,Claude Opus 4, nonostante il prezzo più elevato, può ridurre il sovraccarico di gestione degli errori e migliorare la produttività end-to-end riducendo al minimo le ripetizioni e i cicli di revisione umana.

Adozione aziendale bilanciata

Per i team che cercano prestazioni affidabili per scopi generali senza scalabilità estrema, OpenAI o3 Offre una via di mezzo. Con un ampio supporto API, prezzi moderati e solidi risultati di benchmark, rimane una scelta interessante per piattaforme di data science, automazione dell'assistenza clienti e integrazioni di prodotti in fase iniziale.

Quale modello di intelligenza artificiale dovresti scegliere per le tue esigenze specifiche?

In definitiva, il modello ideale dipende da tre fattori principali:

- Scala del contesto: Per carichi di lavoro che richiedono ampie finestre di input, Gemini 2.5 Pro è la scelta migliore.

- Profondità del ragionamento: Se i tuoi compiti prevedono una logica multi-step e una bassa tolleranza agli errori, Claude Opus 4 offre una coerenza superiore.

- Sensibilità ai costi e adattamento all'ecosistema: Per le attività generiche all'interno dello stack OpenAI, in particolare quando è importante l'integrazione con le pipeline di dati esistenti, o3 rappresenta un'opzione equilibrata e conveniente.

Valutando il profilo del token della tua applicazione (input vs. output), la tolleranza alle allucinazioni e i requisiti degli strumenti, puoi selezionare il modello che si allinea in modo ottimale sia alle esigenze tecniche che ai vincoli di budget.

Ecco una tabella comparativa affiancata che riassume le specifiche principali, le metriche delle prestazioni, i prezzi e i casi d'uso ideali per OpenAI o3, Anthropic Claude Opus 4 e Google Gemini 2.5 Pro:

| Caratteristica/metrica | OpenAI o3 | Claude Opus 4 | Gemelli 2.5 Pro |

|---|---|---|---|

| Finestra di contesto (in entrata/in uscita) | 200 K token / 200 K token | 200 K token / 32 K token | 1 048 576 gettoni / 65 535 gettoni |

| Velocità effettiva (token/sec) | ~ 37.6 | ~ 42.1 | ~ 83.7 |

| Latenza media | ~2.8 secondi | ~3.5 secondi | ~2.52 secondi |

| Benchmark di codifica (SWE-bench) | 69.1% | 72.5% | 63.2% |

| Benchmark matematico (AIME-2025) | 78.4%¹ | 81.7%¹ | 83.0% |

| Tasso di allucinazioni (verifica del codice) | ~ 20% | ~ 12% | ~ 18% |

| Input multimodali | Testo e codice | Testo e codice | Testo, codice, immagini, audio, PDF, video |

| Supporto “Chain-of-Thought” | Standard | Pensiero esteso con riassunti | Standard |

| API di chiamata di funzioni/strumenti | Sì (funzioni OpenAI) | Sì (tramite agenti antropici e Bedrock) | Sì (Google Actions) |

| Prezzi (token di input) | $2.00 / M di token | $15.00 / M di token | $ 1.25–$ 2.50 / M token |

| Prezzi (token di output) | $8.00 / M di token | $75.00 / M di token | $ 10–$ 15 / M token |

| Casi d'uso ideali | Chatbot generici, assistenza clienti, frammenti di codice rapidi | Ragionamento profondo, basi di codice complesse, agenti autonomi | Analisi di documenti su larga scala, flussi di lavoro multimodali |

I punteggi matematici AIME-2025 per o3 e Opus 4 sono valori medi approssimativi basati sui parametri di riferimento riportati.

Iniziamo

CometAPI è una piattaforma API unificata che aggrega oltre 500 modelli di intelligenza artificiale (IA) di provider leader, come la serie GPT di OpenAI, Gemini di Google, Claude di Anthropic, Midjourney, Suno e altri, in un'unica interfaccia intuitiva per gli sviluppatori. Offrendo autenticazione, formattazione delle richieste e gestione delle risposte coerenti, CometAPI semplifica notevolmente l'integrazione delle funzionalità di IA nelle tue applicazioni. Che tu stia sviluppando chatbot, generatori di immagini, compositori musicali o pipeline di analisi basate sui dati, CometAPI ti consente di iterare più velocemente, controllare i costi e rimanere indipendente dal fornitore, il tutto sfruttando le più recenti innovazioni nell'ecosistema dell'IA.

Gli sviluppatori possono accedere Gemelli 2.5 Pro,Claude Opus 4 e al API O3 attraverso CometaAPI, le ultime versioni dei modelli elencate sono quelle aggiornate alla data di pubblicazione dell'articolo. Per iniziare, esplora le capacità del modello in Parco giochi e consultare il Guida API per istruzioni dettagliate. Prima di accedere, assicurati di aver effettuato l'accesso a CometAPI e di aver ottenuto la chiave API. CometaAPI offrire un prezzo molto più basso rispetto al prezzo ufficiale per aiutarti a integrarti.

In definitiva, la scelta tra la serie o3 di OpenAI, Claude Opus 4 di Anthropic e Gemini 2.5 Pro di Google dipende da specifiche priorità organizzative, che si tratti di prestazioni tecniche di alto livello, integrazione aziendale sicura o esperienze multimodali fluide per i consumatori. Allineando i casi d'uso ai punti di forza e all'ecosistema di ciascun modello, è possibile sfruttare l'avanguardia dell'IA per guidare l'innovazione in ricerca, sviluppo, formazione e oltre.

Nota dell'autore: Al 31 luglio 2025, ciascuno di questi modelli continua a evolversi, con frequenti aggiornamenti minori e miglioramenti dell'ecosistema. Prima di prendere una decisione definitiva, fare sempre riferimento alla documentazione API CometAPI più recente e ai benchmark delle prestazioni.