L'intelligenza artificiale per l'editing delle immagini si è evoluta da semplice giocattolo a vero e proprio strumento di workflow in pochi mesi, non anni. Se avete bisogno di rimuovere sfondi, scambiare volti, mantenere un personaggio in più scatti o effettuare compositing multi-step con prompt in linguaggio naturale, diversi nuovi modelli promettono di farlo più velocemente e con meno correzioni manuali. In questo post confronto tre degli strumenti di cui si parla in questo momento: Immagine GPT-1 di OpenAI, Qwen-Image Edit, il virale Banana nano modelli (Gemini-2.5-Flash-Image), e Flux KontextIllustrerò i punti di forza di ognuno di essi, i punti deboli e fornirò consigli pratici in base all'obiettivo che si desidera raggiungere.

Quali sono le capacità fondamentali che definiscono l'eccellenza nell'intelligenza artificiale per immagini?

"Il migliore" dipende dalle tue esigenze. La mia valutazione si basa su sette criteri pratici. Prima di analizzare i singoli modelli, è fondamentale comprendere le capacità fondamentali che definiscono l'eccellenza nella generazione e nell'editing delle immagini tramite intelligenza artificiale. Queste possono essere ampiamente classificate in:

- Qualità e fedeltà della generazione: Si riferisce alla capacità dell'IA di produrre immagini altamente realistiche, esteticamente gradevoli e coerenti a partire da prompt di testo. I fattori includono dettagli, illuminazione, composizione e assenza di artefatti o distorsioni.

- Versatilità e precisione di editing: Oltre alla generazione iniziale, un'intelligenza artificiale avanzata dovrebbe offrire solide funzionalità di editing, tra cui l'inpainting (riempimento di parti mancanti), l'outpainting (estensione delle immagini), la rimozione/aggiunta di oggetti, il trasferimento di stile e il controllo preciso su elementi specifici.

- Velocità ed efficienza: Per i flussi di lavoro professionali, il tempo impiegato per generare o modificare le immagini è fondamentale. Un'elaborazione più rapida senza sacrificare la qualità è un vantaggio significativo.

- Esperienza utente e accessibilità: Un'interfaccia intuitiva, controlli chiari e facilità di integrazione nei flussi di lavoro esistenti sono essenziali per un'adozione diffusa e la soddisfazione degli utenti.

- Considerazioni etiche e caratteristiche di sicurezza: Con l'aumento della potenza dell'intelligenza artificiale, lo sviluppo e l'implementazione responsabili diventano cruciali. Questo include misure di salvaguardia contro la generazione di contenuti dannosi o di parte.

- Modelli di costo-efficacia e di determinazione dei prezzi: Sebbene alcuni strumenti offrano livelli gratuiti, per gli utenti attenti al budget è essenziale comprendere la struttura dei prezzi per le funzionalità avanzate e l'uso commerciale.

- Modifiche coerenti in più fasi — preservare l'identità/gli oggetti attraverso più modifiche o immagini.

Io tendo a essere pratico: un modello che produce immagini leggermente meno "wow-factor" ma consente di ottenere modifiche riproducibili, veloci e affidabili sarà migliore di uno appariscente che necessita di molta pulizia.

Quali sono i modelli presi in considerazione e cosa li rende diversi?

Istantanea rapida del modello

- gpt-image-1 (OpenAI) — un modello multimodale nativo rilasciato su API nell'aprile 2025 che supporta direttamente la generazione e la modifica iterativa delle immagini all'interno della stessa API multimodale Responses/Images.

- Immagine Flash Gemini 2.5 (Google) — annunciato il 26 agosto 2025 ("nano-banana"); progettato per una generazione rapida e a bassa latenza e per un editing avanzato (fusione multi-immagine, coerenza dei caratteri); include la filigrana SynthID per la provenienza.

- Qwen-Image-Edit (QwenLM / gruppo Alibaba) — una versione di Qwen-Image (fondazione 20B) per l'editing delle immagini che enfatizza la modifica precisa e bilingue del testo e la modifica combinata di semantica e aspetto.

- FLUX.1 Kontext (varianti della piattaforma Flux / Black Forest Labs / Flux) — famiglia di modelli (Dev / Pro / Max) focalizzati sulla modifica rapida, locale e contestuale con coerenza dei caratteri e flussi di lavoro iterativi.

Perché proprio questi quattro?

Coprono i punti di progettazione più rilevanti che i professionisti del design si pongono nel 2025: integrazione multimodale (OpenAI), scala + produzione più conoscenza del mondo (Google), editing di precisione e ricerca aperta (Qwen) ed editing iterativo UX-first (Flux). Ognuno di essi presenta diversi compromessi in termini di costi, latenza e aree di eccellenza (rendering del testo, fusione multi-immagine, editing iterativo, conservazione delle aree invariate).

GPT-Image-1 (OpenAI) — il peso massimo dello sviluppatore

Che cosa è: GPT-Image-1 di OpenAI è un modello multimodale nativo che accetta input di testo e immagini e supporta la generazione e la modifica delle immagini (inpainting, image-to-image) tramite la loro API Images. Si posiziona come modello di livello produttivo per l'integrazione tra app e servizi. È progettato come un modello nativo testo+immagine in grado di accettare input di immagini e prompt di testo ed eseguire modifiche con un controllo preciso.

Quali sono i punti di forza di GPT-image-1?

- Comprensione semantica eccezionale: Uno dei principali punti di forza di GPT-image-1 risiede nella sua capacità di interpretare testi complessi e sfumati. Gli utenti possono descrivere scene complesse, stati d'animo specifici e concetti astratti con notevole precisione, e l'IA produce spesso immagini che riflettono fedelmente queste descrizioni.

- Fotorealismo di alta qualità: Quando richiesto, GPT-image-1 fornisce spesso risultati sorprendentemente realistici, con un'attenzione impressionante alle texture, all'illuminazione e alle composizioni naturali. Questo lo rende uno strumento formidabile per il rendering fotorealistico e la concept art.

- Interpretazione creativa: Oltre alla mera traduzione letterale, GPT-image-1 mostra un certo grado di interpretazione creativa, spesso aggiungendo dettagli sottili o tocchi stilistici che esaltano l'appeal artistico complessivo dell'immagine generata. Questo può essere particolarmente utile per l'ideazione e l'esplorazione di diversi concetti visivi.

- Solide basi per l'iterazione: La sua capacità di generare concetti iniziali di alta qualità rappresenta un ottimo punto di partenza per ulteriori perfezionamenti, sia nell'ambito delle capacità di editing dell'IA (se disponibili) sia tramite software di progettazione grafica tradizionale.

Quali sono i limiti di GPT-image-1?

- Controllo sui dettagli fini: Sebbene eccellenti per concetti generali, ottenere un controllo assoluto a livello di pixel o una manipolazione precisa di elementi molto piccoli può a volte essere difficile. Questo è un ostacolo comune per molte IA generative, il cui output è in qualche modo deterministico in base al prompt.

- Disponibilità e integrazione: A seconda della specifica implementazione, le funzionalità di editing diretto di GPT-image-1 potrebbero essere meno robuste o integrate rispetto alle piattaforme di editing di immagini dedicate. Gli utenti potrebbero dover esportare e utilizzare altri strumenti per un editing post-generazione intensivo.

- Richieste computazionali: La generazione di immagini molto dettagliate con prompt complessi può richiedere un elevato dispendio di risorse computazionali, con conseguenti tempi di elaborazione più lunghi rispetto a modelli più specializzati e leggeri per modifiche rapide.

Nano Banana (immagine Flash di Google / Gemini 2.5)

Che cosa è: "Nano Banana" è il nome giocoso dato al recente aggiornamento di immagini Gemini di Google (Gemini 2.5 Flash Image). È stato posizionato come un generatore/editor di immagini di nuova generazione all'interno dell'ecosistema Gemini di Google, pubblicizzato per modifiche multi-step più efficaci e dettagliate e una maggiore coerenza nelle modifiche fotografiche.

Dove si distingue Gemini-2.5-Flash-Image nel panorama dell'intelligenza artificiale visiva?

Gemini-2.5-Flash-Image, una versione più recente progettata per garantire velocità ed efficienza, è la soluzione di Google che punta a un equilibrio tra output di alta qualità e rapidità di elaborazione. La designazione "Flash" indica specificamente la sua architettura ottimizzata per risposte più rapide, rendendola particolarmente adatta ad applicazioni in cui la generazione e l'editing in tempo reale o quasi reale sono cruciali.

Cosa rende Gemini-2.5-Flash-Image un valido contendente?

- Generazione incredibilmente veloce: Come suggerisce il nome, la velocità è un vantaggio fondamentale. Gemini-2.5-Flash-Image eccelle nella generazione rapida di immagini, il che è prezioso per i professionisti creativi che hanno scadenze ravvicinate o per applicazioni interattive.

- Ottima qualità dell'immagine: Nonostante la sua velocità, il modello non compromette significativamente la qualità dell'immagine. Produce immagini coerenti e visivamente accattivanti, generalmente prive di artefatti significativi, rendendolo competitivo con modelli più lenti e con un maggiore consumo di risorse in molti casi d'uso.

- Comprensione multimodale: Sfruttando il framework più ampio di Gemini, spesso trae vantaggio da una comprensione multimodale avanzata, il che significa che può potenzialmente interpretare non solo il testo ma anche altre forme di input per guidare la generazione e la modifica delle immagini, anche se questo varia a seconda dell'API specifica.

- Funzionalità di modifica integrate: Gemini-2.5-Flash-Image è in genere dotato di funzionalità di modifica integrate, come l'inpainting (riempimento delle parti mancanti di un'immagine), l'outpainting (estensione di un'immagine oltre i suoi bordi originali) e la manipolazione degli oggetti, il che lo rende una soluzione più completa per i flussi di lavoro di immagini end-to-end.

Quali sono le aree di miglioramento per Gemini-2.5-Flash-Image?

- Picco di fotorealismo: Pur essendo valido, potrebbe non raggiungere sempre l'apice assoluto del fotorealismo, tipico di alcuni dei modelli più lenti e grandi, per scene estremamente complesse e ricche di sfumature. Può esserci un leggero compromesso tra velocità e fedeltà assoluta.

- Sfumature artistiche per stili complessi: Per stili artistici molto specifici o richieste estremamente astratte, alcuni utenti potrebbero trovarlo leggermente meno capace di catturare le sfumature artistiche più sottili rispetto ai modelli addestrati su vasti set di dati storici dell'arte.

- Controllo sul testo generato (all'interno delle immagini): Come molti modelli generativi, generare un testo perfettamente coerente e scritto correttamente all'interno di un'immagine può ancora rappresentare una sfida.

Che cos'è Qwen-Image-Edit?

Che cosa è: Qwen-Image-Edit (team Alibaba / Qwen) — modello di modifica delle immagini basato sulla famiglia Qwen-Image; vanta una solida modifica del testo bilingue (cinese e inglese), controllo semantico e dell'aspetto e fedeltà alla modifica diretta delle immagini.

Quali sono i punti di forza unici di Qwen-Image Edit?

- Precisione di modifica superiore: Qwen-Image Edit vanta spesso algoritmi avanzati per l'inpainting, l'outpainting e la manipolazione degli oggetti, che consentono modifiche estremamente precise e fluide. Eccelle nel mantenere la coerenza visiva anche quando si apportano modifiche significative.

- Modifica contestuale: Un punto di forza fondamentale è la sua capacità di riconoscere il contesto. Quando si rimuove un oggetto, ad esempio, riempie in modo intelligente il vuoto con contenuti che si integrano logicamente con l'ambiente circostante, rendendo la modifica praticamente impercettibile.

- Trasferimento e armonizzazione dello stile: Qwen-Image Edit può essere estremamente efficace nel trasferire stili da un'immagine all'altra o nell'armonizzare diversi elementi all'interno di un'immagine per creare un aspetto coerente. Questo è prezioso per i designer che lavorano con risorse visive diverse.

- Rimozione/aggiunta di oggetti robusti: La sua capacità di aggiungere o rimuovere oggetti mantenendo luci, ombre e prospettiva è davvero impressionante, consentendo ricostruzioni di scene complesse o operazioni di decluttering.

- Upscaling e miglioramento delle immagini: Spesso include funzionalità avanzate per l'upscaling delle immagini senza perdita di qualità e per migliorare i dettagli, i colori e l'aspetto visivo generale.

Quali sono i potenziali punti deboli di Qwen-Image Edit?

- Focus sulla generazione iniziale: Sebbene possa generare immagini, il suo punto di forza e la sua ottimizzazione principale risiedono spesso nell'editing. La sua generazione iniziale di testo in immagini potrebbe essere buona, ma potenzialmente non altrettanto creativa o fotorealistica come i modelli incentrati esclusivamente sulla generazione, a seconda della versione specifica.

- Curva di apprendimento per funzionalità avanzate: La precisione e la profondità dei suoi strumenti di modifica potrebbero richiedere una curva di apprendimento leggermente più ripida per gli utenti che non hanno familiarità con i concetti avanzati di manipolazione delle immagini.

- Intensità di risorse per modifiche complesse: Le modifiche altamente complesse e multistrato possono comunque essere impegnative dal punto di vista computazionale, comportando potenzialmente tempi di elaborazione più lunghi per attività molto grandi o intricate.

Quali innovazioni apporta Flux Kontext all'intelligenza artificiale delle immagini?

Che cosa è: Kontext di Flux (talvolta commercializzato come FLUX.1 Kontext) è uno strumento di editing/generazione di immagini pensato per designer e team di brand. Enfatizza modifica contestuale, tipografia precisa, trasferimenti di stile e UI/UX rigorosi per lavori di progettazione iterativa.

Quali sono i punti di forza di Flux Kontext?

- Coesione contestuale: Il punto di forza principale di Flux Kontext è la sua capacità di comprendere e mantenere il contesto attraverso più generazioni o modifiche di immagini. Questo è prezioso per creare narrazioni visive coerenti, character design o linee di prodotto in cui l'armonia visiva è essenziale.

- Miglioramento della coerenza nelle serie: Se devi generare una serie di immagini che condividono uno stile, un carattere o un ambiente comune, Flux Kontext mira a ridurre le incongruenze che possono affliggere altri modelli.

- Stile adattivo: Può adattare il suo output in base a immagini generate in precedenza o a una guida di stile definita, dando vita a un processo creativo più snello e meno iterativo.

- Specializzato in Brand e Narrative: Particolarmente utile per il marketing, il branding e lo storytelling, dove un'identità visiva unificata è fondamentale.

- Comprensione rapida nel contesto: La sua rapida comprensione non riguarda solo l'immagine corrente, ma anche il modo in cui si inserisce in un contesto più ampio o in un insieme di istruzioni.

Quali sono i limiti di Flux Kontext?

- Potenziale per la focalizzazione di nicchia: La sua enfasi sul contesto e sulla coerenza potrebbe significare che non è sempre il leader assoluto nel fotorealismo grezzo e autonomo o nell'estrema diversità artistica, se questo è l'unico requisito.

- Benchmark meno documentati pubblicamente: In quanto attore più nuovo o più specializzato, i dati di benchmark pubblici potrebbero essere meno disponibili rispetto ai modelli più consolidati.

- Dipendente da un input contestuale chiaro: Per sfruttarne i punti di forza, gli utenti devono fornire informazioni contestuali chiare o definire in modo efficace il quadro narrativo, il che potrebbe richiedere un approccio di sollecitazione diverso.

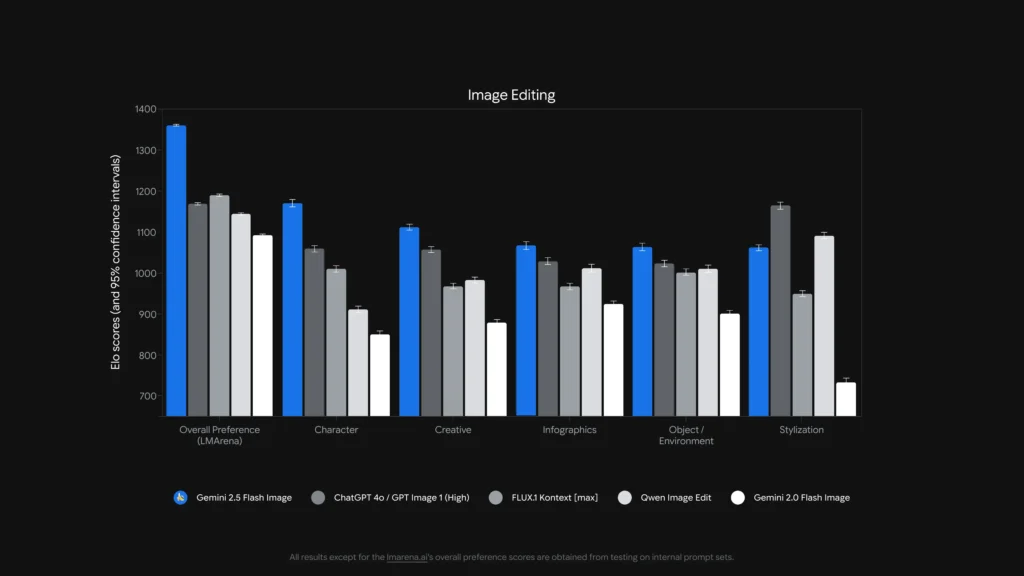

Quale modello è il migliore per l'editing delle immagini?

Per single, modifiche precise senza maschera e al modifica del testo all'interno delle immagini, Modifica immagine Qwen e al Immagine Flash Gemini 2.5 (e modelli specializzati come FLUX.1 Kontext) sono tra i più forti. Per modifiche complesse concatenate in più fasi, combinando un front-end LLM con istruzioni avanzate (varianti Gemini o GPT) con un modello di immagine si ottengono spesso i risultati migliori: alcuni lavori di benchmark hanno dimostrato che il prompting in stile Chain-of-Thought (Gemini-CoT) migliora il successo dell'editing in più fasi.

modifiche locali, coerenza dei caratteri, gestione del testo

- Modifica immagine Qwen prende di mira esplicitamente entrambi semantico e al aspetto modifiche — ad esempio, sostituzione di oggetti, rotazione, sostituzione precisa di testo — esplicitamente costruite come un modifica delle immagini modello con doppio percorso (controllo semantico tramite Qwen2.5-VL + controllo dell'aspetto tramite codificatore VAE). Pubblicizza un robusto bilingue (cinese/inglese) modifiche di testo nelle immagini (ad esempio, modificare il testo del cartello, le etichette dei prodotti) preservando lo stile, il che è raro e prezioso per i lavori di localizzazione e confezionamento.

- Immagine Flash Gemini 2.5 Supporta modifiche mascherate, modifiche locali guidate da prompt (sfocatura dello sfondo, rimozione di una persona, modifica della posa) e fusione di più immagini. Google pubblicizza modifiche basate su prompt e basate sulla regione, oltre a vantaggi in termini di conoscenza del mondo (ad esempio, una migliore semantica degli oggetti del mondo reale). Il modello aggiunge anche un filigrana invisibile SynthID per generare/modificare le immagini per agevolare la provenienza e il rilevamento.

- FLUX.1 Kontext: si posiziona come un risolutore di contesto immagine-immagine, ottimizzato per modifiche locali precise e contestuali e per la sperimentazione iterativa. I revisori ne elogiano la capacità di preservare il contesto e la semantica della scena durante le modifiche locali. FLUX.1 Kontext e Flux Kontext UI sono stati elogiati nei test pratici comparativi per i flussi di lavoro di editing iterativo e la leggibilità del testo, rendendolo una scelta pratica per i flussi di lavoro che richiedono numerose iterazioni rapide (risorse di marketing, miniature).

- Immagine GPT-1: supporta le operazioni di modifica (richieste di testo+immagine per le modifiche) e gli strumenti di OpenAI integrano modelli di concatenamento e di progettazione dei prompt; le prestazioni sono elevate ma dipendono dalla progettazione dei prompt e potrebbero risultare inferiori ai modelli specializzati di modifica prima nell'editing fine-grain (ad esempio, sostituzione esatta di testo bilingue) in alcuni test.

Parametri di riferimento come ComplexBench-Edit e al CompBench dimostrano che molti modelli falliscono ancora quando le modifiche sono concatenate o interdipendenti, ma che combinare un LLM per l'analisi delle istruzioni con un modello di immagine robusto (orchestrazione LLM→modello di immagine) o utilizzando prompt CoT può ridurre gli errori. Ecco perché alcuni flussi di lavoro di produzione uniscono i modelli (ad esempio, un LLM di ragionamento più un generatore di immagini) per le modifiche complesse.

Chi è il più bravo a modificare il testo nelle immagini?

- Modifica immagine Qwen È stato progettato espressamente per l'editing di testo preciso bilingue (cinese + inglese) e riporta risultati superiori nei benchmark di editing di testo (note tecniche pubbliche di Qwen e punteggi riportati). Gli artefatti e le demo open source di Qwen mostrano un'accurata conservazione di font, dimensioni e stile durante le modifiche.

- gpt-immagine-1 e al Immagine Flash Gemini 2.5 entrambi fanno progressi nella resa del testo, ma i parametri di riferimento accademici e le note dei fornitori indicano che permangono delle sfide per testi brevi/dettagliati e lunghi passaggi testuali: i miglioramenti sono incrementali e variano in base al prompt e alla risoluzione.

Analisi comparativa: funzionalità, modifica

Per fornire un quadro più chiaro, raggruppiamo gli aspetti chiave di questi modelli di intelligenza artificiale leader in una tabella comparativa.

| Caratteristica/capacità | Immagine GPT-1 (OpenAI) | Gemini-2.5-Flash-Image (Google) | Qwen-Image-Edit (Alibaba) | FLUX.1 Kontext |

|---|---|---|---|---|

| Generazione nativa + modifica | Sì. Testo+immagine multimodale in un'unica API. | Sì, generazione nativa e editing mirato; fusione multi-immagine e coerenza dei caratteri enfatizzate. | Focalizzata sulla montaggio (Qwen-Image-Edit) con controllo semantico + aspetto. | Concentrato su modifiche ad alta fedeltà, immagine per immagine. |

| Profondità di modifica (regolazioni locali) | Alto (ma generalista) | Molto alto (richieste mirate + modifiche senza maschera) | Molto alto per modifiche semantiche/testuali (supporto testo bilingue). | Molto alto: pipeline di modifica sensibili al contesto. |

| Gestione del testo nell'immagine | Bene, dipende dal prompt | Migliorato (il fornitore mostra modelli e demo di modifica dei cartelli) | Migliori tra questi per modifiche di testo leggibili in bilingue. | Ottimo per preservare lo stile; la leggibilità dipende dal prompt. |

| Coerenza carattere/oggetto | Buono con sollecitazione attenta | Forte (caratteristica esplicita) | Medio (l'attenzione è rivolta all'editing piuttosto che all'identità multi-immagine) | Forte grazie ai flussi di lavoro di editing iterativi. |

| Latenza / throughput | Adeguata | Bassa latenza / alta produttività (Modello Flash) | Varia in base all'hosting (locale/HF vs cloud) | Progettato per modifiche iterative rapide in SaaS ospitati. |

| Provenienza / filigrana | Nessuna filigrana obbligatoria (meccanismi di policy) | Filigrana invisibile SynthID per le immagini. | Dipende dall'host | Dipende dall'host |

Note: La "profondità di modifica" misura quanto siano precise e affidabili le modifiche locali nella pratica; la "gestione del testo" valuta la capacità di posizionare/modificare testo leggibile all'interno delle immagini

E per quanto riguarda la latenza, l'ergonomia degli sviluppatori e l'integrazione aziendale?

Opzioni di latenza e distribuzione

- Immagine Flash Gemini 2.5 sottolinea bassa latenza ed è disponibile tramite Gemini API, Google AI Studio e Vertex AI: una scelta ideale per le app aziendali che necessitano di throughput prevedibile e integrazione cloud. Google riporta anche i prezzi approssimativi dei token per immagine (e il blog degli sviluppatori include un esempio di prezzo per immagine).

- gpt-immagine-1 è disponibile tramite l'API OpenAI Images e vanta un'ampia integrazione con l'ecosistema (Playground, partner come Adobe/Canva). Il prezzo è tokenizzato e varia in base al livello di qualità dell'immagine (OpenAI pubblica le conversioni da token a dollari).

- Flux Kontext si concentra su un'esperienza utente interattiva veloce e offre crediti + tempi di modifica ridotti nelle demo dei prodotti, utili per i designer e per un'iterazione rapida. Qwen fornisce artefatti aperti e accesso alla ricerca (ideale se si desidera auto-ospitare o ispezionare gli interni).

Quanto costano questi servizi? Qual è il migliore?

I prezzi cambiano frequentemente: di seguito sono riportati i numeri dichiarati dall'editore (agosto 2025) e i calcoli rappresentativi dei costi per immagine, laddove i fornitori li hanno pubblicati.

Prezzi pubblicati (dichiarazioni del fornitore)

| Modello / Fornitore | Panoramica dei prezzi pubblici (pubblicata) | Stima approssimativa per immagine |

|---|---|---|

| gpt-image-1 (OpenAI) | Prezzi tokenizzati (input di testo $ 5 / 1 milione, input di immagine $ 10 / 1 milione, output di immagine $ 40 / 1 milione). OpenAI nota che questo corrisponde a circa $ 0.02- $ 0.19 per immagine generata a seconda della qualità/dimensione. | ~$0.02 (bassa qualità/miniatura) → ~$0.19 (quadrato di alta qualità) |

| Immagine Flash Gemini 2.5 (Google) | $ 30 per 1 milione di token in uscita e esempio: ogni immagine ≈ 1290 token di output (~$0.039 per immagine) secondo il blog dello sviluppatore. Prezzi applicati tramite Gemini API / Vertex. | ~$0.039 per immagine (esempio Google) |

| Flusso Kontext (Flusso) | Livello gratuito con crediti; le pagine dei prodotti Flux mostrano 10 crediti gratuiti e modifiche tipiche al prezzo di crediti 5; livelli di abbonamento disponibili per gli utenti più assidui. (Pagina del prodotto del fornitore). | Costi molto bassi per modifiche occasionali; abbonamento per un uso intensivo. |

| Modifica immagine Qwen (QwenLM) | Open release e artefatti GitHub: accesso aperto per la ricerca con esempi gratuiti; le distribuzioni commerciali variano a seconda dell'integratore (self-hosted vs cloud). Non esiste un prezzo canonico per immagine; tende a essere più basso se self-hosted. |

Interpretazione del valore: Se hai bisogno di immagini di grandi volumi ELETTRICA In produzione e desiderate un prezzo per immagine prevedibile, l'esempio di Google per immagine è estremamente competitivo. Se i vostri costi sono dominati dall'editing umano o dal tempo di progettazione iterativa, Flux o l'esecuzione di Qwen in locale potrebbero essere più economici. OpenAI offre un ampio ecosistema di SDK e numerosi partner, che valgono il livello superiore per la comodità di integrazione.

Prezzo in CometAPI

| Modello | Immagine GPT-1 | Gemini-2.5-Flash-Image | FLUX.1 Kontext |

| Prezzo | Gettoni di input $ 8.00; Gettoni di output $ 32.00 | $0.03120 | flux kontext pro: $0.09600 flux-kontext-max: $0.19200 |

Consigli pratici e rapidi per ottenere i migliori risultati

Suggerimenti su prompt e flusso di lavoro (applicabili a tutti i modelli)

- Sii esplicito sulla composizione: angolazione della telecamera, illuminazione, atmosfera, lunghezza focale, obiettivo e relazioni spaziali tra gli oggetti. Esempio: “Primo piano da 35 mm, ridotta profondità di campo, soggetto centrato, luce morbida sul bordo in alto a sinistra.”

- Utilizzare la raffinazione iterativa per le modifiche: esegui prima modifiche strutturali grossolane, quindi procedi con i perfezionamenti di texture e illuminazione. Modelli come FLUX e Gemini sono progettati per supportare il perfezionamento in più fasi.

- Per il testo nelle immagini: fornisci il testo esatto che desideri e aggiungi "renderizza come segnale leggibile ad alto contrasto con rilievo realistico" — per modifiche bilingue usa Qwen-Image-Edit quando hai bisogno di fedeltà cinese/inglese.

- Utilizzare immagini di riferimento: per garantire la coerenza dei personaggi o delle varianti del prodotto, fornisci immagini di riferimento di alta qualità e prompt di ancoraggio come "corrispondi al personaggio in riferimento_01: caratteristiche facciali, colore del costume e illuminazione". Gemini e Flux enfatizzano la fusione/coerenza di più immagini.

- Modifiche con mascheramento vs modifiche senza mascheramento: ove possibile, fornire una maschera per limitare strettamente le modifiche. Quando si utilizza la modalità "maskless", aspettarsi occasionali effetti di spillover. I modelli variano: Flux/Gemini gestiscono bene le modifiche senza maschera, ma una maschera è comunque utile.

- Usa il Immagine GPT / GPT-4o per prompt compositivi complessi con più oggetti, conteggi e vincoli spaziali. Utilizzare un'unica istruzione esatta per generazione, quando possibile.

Suggerimenti su costi e latenza

Dosaggio: utilizza API batch o funzioni cloud per generare numerose varianti in modo efficiente. Gemini-2.5-Flash è ottimizzato per la produttività se hai bisogno di volumi elevati.

Qualità della messa a punto vs prezzo: OpenAI espone livelli di immagini bassi/medi/alti; genera bozze a bassa qualità e finalizza a qualità alta.

verdetto finale

- Ideale per produzione e integrazione: Immagine GPT-1 — ideale per le esigenze API, la composizione e l'integrazione in strumenti professionali.

- Ideale per la coerenza fotorealistica del consumatore: Banana nano — L'aggiornamento delle immagini Gemini di Google si distingue per le modifiche naturali e sequenziali dei ritratti e per un'esperienza utente accessibile.

- Migliore esperienza mobile/editor: Flux Kontext — ottime modifiche conversazionali al telefono con poco attrito.

- Se si misurano le modifiche chirurgiche del testo e l'editing bilingue/multilingue → Qwen-Image-Edit** è lo specialista migliore e una scelta eccellente quando è importante la precisione del testo all'interno delle immagini.

Iniziamo

CometAPI è una piattaforma API unificata che aggrega oltre 500 modelli di intelligenza artificiale (IA) di provider leader, come la serie GPT di OpenAI, Gemini di Google, Claude di Anthropic, Midjourney, Suno e altri, in un'unica interfaccia intuitiva per gli sviluppatori. Offrendo autenticazione, formattazione delle richieste e gestione delle risposte coerenti, CometAPI semplifica notevolmente l'integrazione delle funzionalità di IA nelle tue applicazioni. Che tu stia sviluppando chatbot, generatori di immagini, compositori musicali o pipeline di analisi basate sui dati, CometAPI ti consente di iterare più velocemente, controllare i costi e rimanere indipendente dal fornitore, il tutto sfruttando le più recenti innovazioni nell'ecosistema dell'IA.

Gli sviluppatori possono accedere Immagine GPT-1, FLUX.1 Kontext e al Immagine Flash Gemini 2.5 tramite CometAPI, le ultime versioni dei modelli elencate sono quelle aggiornate alla data di pubblicazione dell'articolo. Per iniziare, esplora le capacità del modello in Parco giochi e consultare il Guida API per istruzioni dettagliate. Prima di accedere, assicurati di aver effettuato l'accesso a CometAPI e di aver ottenuto la chiave API. CometaAPI offrire un prezzo molto più basso rispetto al prezzo ufficiale per aiutarti a integrarti.

L'ultima integrazione Modifica immagine Qwen apparirà presto su CometAPI, quindi restate sintonizzati! Pronti per iniziare a modificare le immagini? → Iscriviti oggi a CometAPI !

Prezzo in CometAPI

| Modello | Immagine GPT-1 | Gemini-2.5-Flash-Image | FLUX.1 Kontext |

| Prezzo | Gettoni di input $ 8.00; Gettoni di output $ 32.00 | $0.03120 | flux kontext pro: $0.09600 flux-kontext-max: $0.19200 |