Google I/O 2025 は、Google のエコシステム全体で AI 主導のエクスペリエンスへの明確なシフトを示すもので、主力 AI モデル Gemini のメジャーアップデート、開発者ツールの強化、検索、Workspace、Chrome への AI 中心の機能導入が発表されました。主なイノベーションには、マルチモーダルアシスタンスの Gemini Live、会話型インタラクションの AI Mode in Search、3D ビデオ通話の Google Beam などがあり、AI 支援コーディングの Jules や高忠実度画像生成の Imagen 4 などの新ツールも含まれていました。ハードウェア面では、Android XR プラットフォームは Google のスマートグラスへの新たな投資を示し、Android 16 と Pixel Fold のプレビューはシステム全体への AI のより深い統合を示唆していました。これらの進歩をサポートするために、Google は段階的な AI サブスクリプションプラン (月額 20 ドルの AI Pro と月額 250 ドルの AI Ultra) を導入し、プレミアム AI サービスの収益化に向けた動きを強調しました。最後に、Google は、Fire Sat による AI を活用した山火事検知と、Wing によるドローンによる災害救助試験を通じて、社会貢献への取り組みを強調しました。

AIとジェミニの進化

ジェミニ2.5以降

Googleの次世代AIアシスタント「Gemini」は、推論機能が大幅に改善されバージョン2.5に進化しました(モデル名: gemini-2.5-flash-preview-05-20)、マルチモーダル理解、およびレイテンシーです。

Gemini 2.5のFlashプレビューは、コーディングや複雑なタスクにおける応答時間を短縮します。Thought Summariesと今後導入予定の「Thinking Budgets」により、モデル推論の透明性とコスト管理が向上します。

コンシューマー分野では、Gemini Live がカメラ、音声、ウェブデータを融合し、状況に応じたタスクをリアルタイムで実行します。これにより、スマートフォンのカメラ映像から瞬時に翻訳や物体識別が可能になります。

アストラ計画とマリナー計画

プロジェクト・アストラは、テキストや音声プロンプトを超えて、視覚的な手がかりを理解し、画面上のインタラクションに直接応答できる汎用AIインターフェースの開発を目指しています。一方、 プロジェクトマリナー AI を活用して複数ステップのタスクを自律的に処理し、予約やオンライン ショッピングなどの日常的なワークフローを自動化します。

開発者中心のツール

ジュールとイマージェン4

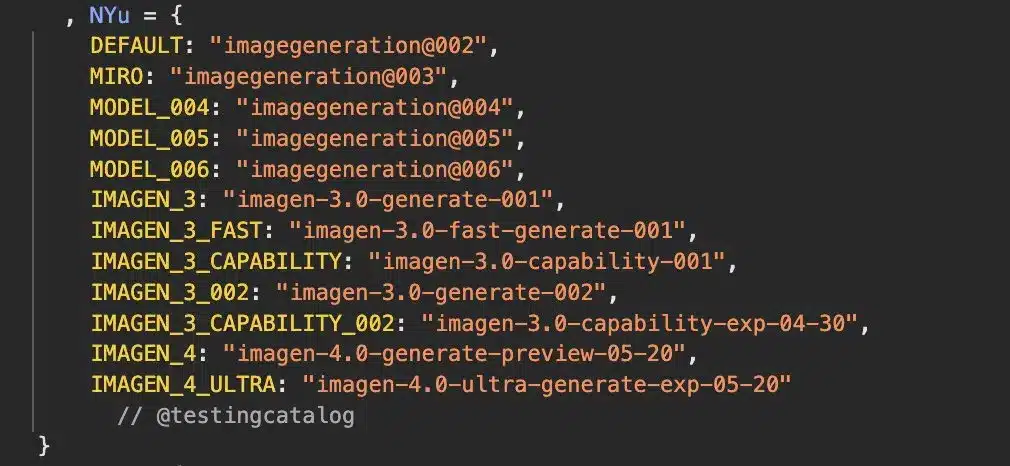

開発者の場合、 ジュール Android Studio に緊密に統合された AI 駆動型コーディング アシスタントとして導入され、コンテキスト認識型のコード提案と自動リファクタリングを提供します。 画像4Google の画像生成モデルの最新バージョンである は、アーティストや UI デザイナーのニーズに応える、これまでにない詳細さとスタイルの制御を実現します。

フローとVeo 3

Googleが紹介した Flow および ヴェオ3テキストプロンプトやストーリーボードを高品質のアニメーションに変換するAI搭載のビデオ作成ツール、 ステッチは、シンプルなスケッチからレスポンシブなUIモックアップを生成するツールです。これらのツールは、AIを通じてクリエイティブコンテンツ制作の民主化を目指すGoogleの取り組みを象徴しています。

検索、ワークスペース、Chrome

検索におけるAIモード

刷新 AIモード Google 検索では、会話形式で回答を提示し、ウェブコンテンツや個人データ(メール、カレンダーの予定など)から動的に情報を取得し、パーソナライズされた回答を提供します。また、検索における実験的な AR ショッピング機能もプレビューされ、ユーザーは購入前に商品を仮想的に試着できるようになりました。

ワークスペースの機能強化

Gmailの導入 パーソナライズされたスマート返信 各ユーザーの文章スタイルを模倣する機能が追加され、Meet では現在、デバイス上の AI を活用した 20 以上の言語でのライブ翻訳が可能で、遅延の低減とプライバシーの強化を実現しています。Google ドキュメントとスプレッドシートには、コンテンツの作成とデータ分析タスクの自動化のための生成 AI ヘルパーがまもなく統合される予定です。

ハードウェアの革新

Android XR スマートグラス

下 Android XR バナー広告で、Googleはジェントルモンスターおよびワービーパーカーとの提携を発表し、ARナビゲーション、状況に応じた通知、リアルタイム翻訳オーバーレイを備えた次世代スマートグラスを発表しました。開発者は、このプラットフォームのSDKを利用して没入型体験を構築できます。

Pixel FoldとAndroid 16のプレビュー

開発者プレビュー Android 16 環境コンテキストプロンプトやシステム全体の生成壁紙など、AIファーストの新しいシステムAPIを披露した。Googleはまた、今後予定されている ピクセルフォールド写真撮影とマルチタスクのためのシームレスな AI 統合を強調しています。

サブスクリプション プランと価格

Google は、高度な AI サービスのための階層型サブスクリプション モデルを発表しました。

- AIプロ 月額 20 ドルで、Gemini の使用制限の拡張と新機能への優先アクセスが提供されます。

- AIウルトラ 月額 250 ドルで、ミッションクリティカルなアプリケーション向けの専用 GPU リソースとエンタープライズ グレードの SLA が含まれます。

この戦略は、幅広い採用のために無料層を維持しながら、プレミアム AI 機能を収益化する方向への Google のシフトを反映しています。

Google I/O 2025は、Googleがプラットフォーム全体へのAIの組み込みに注力し、画期的な開発者ツール、消費者向け機能、そして社会貢献活動のバランスをとっていることを実証しました。今後数か月かけて展開されるこれらのテクノロジーは、AIファーストの世界において、ユーザーが情報、創造性、そしてデバイスと関わる方法を根本から変える可能性を秘めています。

スタートガイド

CometAPIは、Geminiファミリーを含む数百のAIモデルを一貫したエンドポイントに集約する統合RESTインターフェースを提供します。APIキー管理、使用量制限、課金ダッシュボードも組み込まれており、複数のベンダーURLと認証情報を管理する手間が省けます。

開発者はアクセスできる Gemini 2.5 フラッシュ プレ API (最新モデル:gemini-2.5-flash-preview-05-20)と ジェミニ 2.5 プロ API などを通じて コメットAPIまず、プレイグラウンドでモデルの機能を調べ、 APIガイド 詳細な手順については、こちらをご覧ください。開発者によっては、モデルを使用する前に組織の確認が必要となる場合がありますのでご注意ください。