DeepSeekは 実験的 と呼ばれるモデル DeepSeek-V3.2-Exp on 2025 年 9 月 29 日は、長コンテキストワークロードの推論コストを大幅に削減することを目的とした新しいスパースアテンションメカニズム(DeepSeek Sparse Attention、DSA)を導入し、同時にAPI価格を約半額に値下げしました。このガイドでは、このモデルの概要、アーキテクチャと機能のハイライト、APIへのアクセス方法と使用方法(コード例付き)、従来のDeepSeekモデルとの比較、そして本番環境でのレスポンスの解析と処理方法について説明します。

DeepSeek-V3.2-Expとは何ですか?

DeepSeek-V3.2-Expは、DeepSeekのV3トラックにおける実験的なイテレーションです。2025年9月下旬に発表されたこのリリースは、生の精度を大幅に向上させるものではなく、拡張されたコンテキスト長に対するアーキテクチャの最適化を検証する「中間」段階として位置付けられています。その目玉となるイノベーションは、 **DeepSeek スパースアテンション(DSA)**長い入力の一部に選択的に注目して計算コストとメモリコストを削減しながら、出力品質を V3.1-Terminus と同等に保つことを目指す注目パターンです。

実際にそれが重要な理由:

- ロングコンテキストタスクのコスト: DSAは注目度の2乗コストをターゲットとし、非常に長い入力(複数文書の検索、長いトランスクリプト、大規模なゲームワールドなど)の計算コストを削減します。典型的なロングコンテキストのユースケースでは、APIの使用コストが大幅に削減されます。

- 互換性とアクセシビリティ: DeepSeek API は OpenAI 互換のリクエスト形式を使用するため、多くの既存の OpenAI SDK ワークフローをすぐに適応できます。

DeepSeek V3.2-Exp の主な機能とアーキテクチャは何ですか?

DeepSeek Sparse Attention (DSA) とは何ですか? また、どのように機能しますか?

DSAは 細粒度スパースアテンション コンテキスト全体にわたって密な注意を計算するのではなく、トークンに選択的に注意を向けるように設計された方式。要約すると:

- モデルは、各レイヤーまたはブロックで注目するトークンのサブセットを動的に選択し、長い入力長の FLOP を削減します。

- 選択は、学習した選択ポリシーとルーティングヒューリスティックの組み合わせを活用して、推論タスクの「重要な」コンテキストを保持するように設計されています。

V3.2-Expの中核的なイノベーションであるDSAは、特にコンテキスト長が長くなる場合の推論コストを削減しながら、出力品質をdense-attentionモデルに近い状態に保つことを目的としています。リリースノートとモデルページでは、トレーニング構成がV3.1-Terminusに準拠していることが強調されており、ベンチマーク指標の差はトレーニング全体の変更ではなく、sparse-attentionメカニズムを反映しています。

V3.2-Exp には他にどのようなアーキテクチャ/機能が搭載されていますか?

- ハイブリッドモード(思考モード vs 非思考モード): DeepSeek は 2 つのモデル ID を公開します。

deepseek-chat(考えずに素早く返信)とdeepseek-reasoner(思考連鎖や中間推論コンテンツを公開できる思考モード)。これらのモードにより、開発者はスピードと明示的な推論の透明性を自由に選択できます。 - 非常に大きなコンテキスト ウィンドウ: V3.x ファミリは非常に大きなコンテキストをサポートしており (V3 ラインは現在のアップデートで DeepSeek に 128K のコンテキスト オプションを提供します)、複数のドキュメントのワークフロー、長いログ、および知識の多いエージェントに適しています。

- JSON 出力と厳密な関数呼び出し (ベータ版): APIは、

response_formatJSON出力(および厳密な関数呼び出しのベータ版)を強制できるオブジェクト。ツール統合のために、予測可能な機械解析可能な出力が必要な場合に役立ちます。 - ストリーミングと推論トークン: APIはストリーミングレスポンスをサポートし、推論モデルの場合は異なる推論コンテンツトークン(多くの場合、

reasoning_content) を使用すると、モデルの中間ステップを表示または監査できます。

CometAPI 経由で DeepSeek-V3.2-Exp API にアクセスして使用するにはどうすればよいですか?

DeepSeekは意図的にOpenAIスタイルのAPIフォーマットを維持しているため、既存のOpenAI SDKや互換ツールを異なるベースURLで再ターゲットできます。DeepSeek-V3.2-Expへのアクセスには、低価格でマルチモーダルな集約ゲートウェイであるCometAPIの使用をお勧めします。DeepSeekは、V3.2-Expの動作にマッピングされたモデル名を公開します。例:

DeepSeek-V3.2-Exp-thinking — 推論/思考モードは V3.2-Exp にマッピングされています。

DeepSeek-V3.2-Exp-thinking — 非推論/チャット モードは V3.2-Exp にマッピングされています。

認証方法とベース URL は何ですか?

- APIキーを取得する CometAPI 開発者コンソールから (そのサイトで申請してください)。

- ベースURL: (

https://api.cometapi.comorhttps://api.cometapi.com/v1(OpenAI 互換パス用)。OpenAI 互換性により、多くの OpenAI SDK を小さな変更で DeepSeek に再ポイントできます。

どのモデル ID を使用すればよいですか?

DeepSeek-V3.2-Exp-thinking— 思考モードでは、思考の連鎖/推論コンテンツを表示します。どちらも最新のリリースノートでV3.2-Expにアップグレードされました。DeepSeek-V3.2-Exp-nothinking— 考えずに、素早く応答し、典型的なチャット/補完の使用。

例: 単純な curl リクエスト (チャット完了)

curl -s https://api.cometapi.com/v1/chat/completions \

-H "Authorization: Bearer $cometapi_API_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "deepseek-v3.2-exp",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Summarize the attached meeting transcript in 3 bullet points."}

],

"max_tokens": 512,

"stream": false

}'

例: Python (OpenAI互換クライアントパターン)

このパターンは、OpenAIクライアントをCometAPIのベースURL(またはCometAPIのSDK)に指定することで機能します。以下の例はDeepSeekのドキュメントスタイルに従っています。

import os

import requests

API_KEY = os.environ

url = "https://api.deepseek.com/v1/chat/completions"

headers = {

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

}

payload = {

"model": "deepseek-v3.2-exp",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Extract action items from the following notes..."}

],

"max_tokens": 800

}

r = requests.post(url, headers=headers, json=payload)

r.raise_for_status()

print(r.json())

特別なSDKは必要ありません — ただし、すでにOpenAIのSDKを使用している場合は、多くの場合、再構成することができます base_url および api_key 同じ通話パターンを維持します。

高度な使用法: 推論を可能にするか reasoning_content

モデルの内部的な思考の連鎖(監査、蒸留、中間ステップの抽出など)が必要な場合は、 DeepSeek-V3.2-Exp-thinkingを選択します。 reasoning_content フィールド(および関連するストリームまたはトークン)は推論モードのレスポンスで利用可能です。APIドキュメントには、 reasoning_content 最終的な回答の前に生成されたCoTを検査するためのレスポンスフィールドとして使用できます。注:これらのトークンはモデル出力の一部であるため、公開すると課金に影響する可能性があります。

ストリーミングと部分的な更新

"stream": trueSSE (サーバー送信イベント) 経由でトークン デルタを受信するためのリクエストで。stream_optionsおよびinclude_usageストリーム中に使用状況メタデータが表示される方法とタイミングを調整できます (増分 UI に役立ちます)。

DeepSeek-V3.2-Exp は以前の DeepSeek モデルと比べてどうですか?

V3.2-Exp と V3.1-Terminus

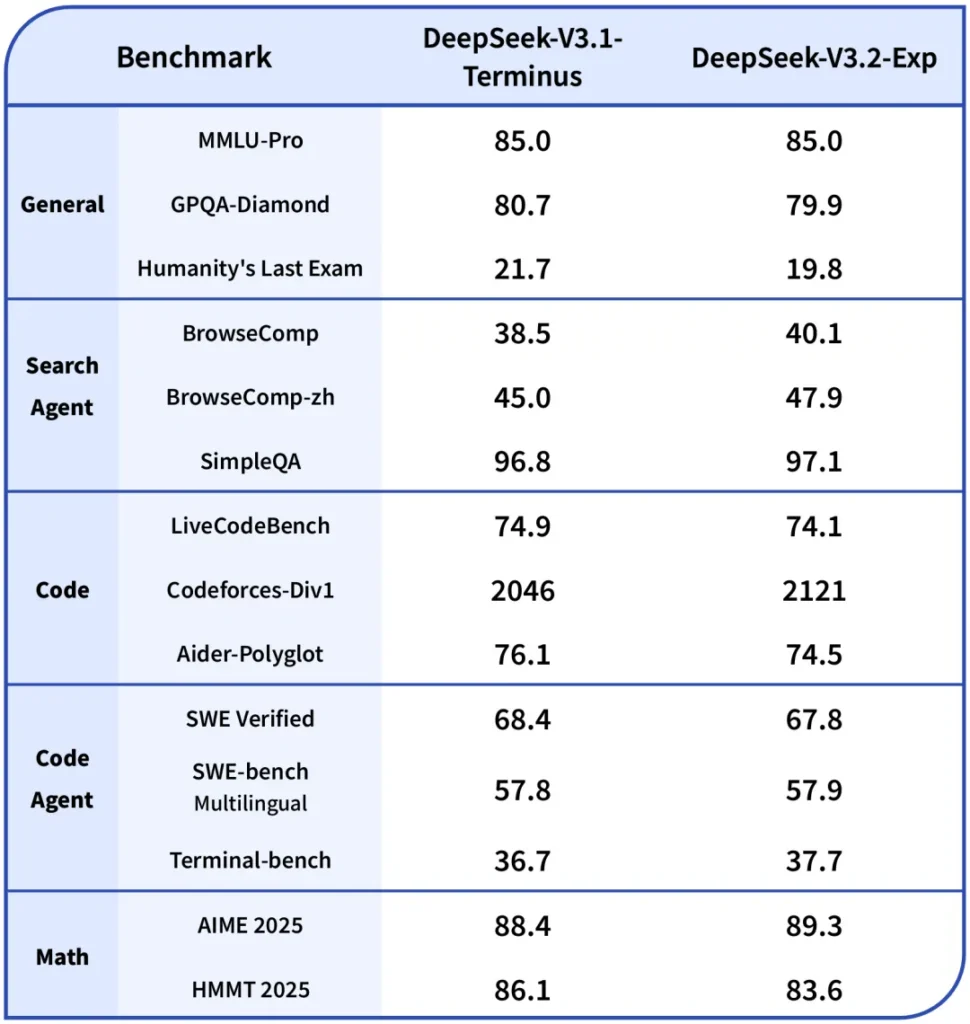

- 主な違い: V3.2-Expでは、スパースアテンション機構が導入され、長いコンテキストの計算量を削減しながら、トレーニングレシピの残りの部分はV3.1と整合が保たれています。これにより、DeepSeekは効率性の向上について、より明確な同一条件での比較を行うことができました。()

- ベンチマーク: 公開ノートによると、V3.2-Exp は、多くの推論/コーディング タスクで V3.1 とほぼ同等のパフォーマンスを発揮しますが、長いコンテキストでは大幅にコストが削減されます。ただし、注意のスパース性が必要なトークンの相互作用とどのように相互作用するかによって、特定のタスクでは依然として軽微な回帰が発生する可能性があることに注意してください。

V3.2-Exp vs R1 / 旧リリース

- R1とV3ラインは異なる設計目標に基づいています(R1は歴史的に、異なるアーキテクチャのトレードオフと、一部のブランチにおけるマルチモーダル機能に重点を置いてきました)。V3.2-Expは、長いコンテキストとスループットに重点を置いたV3ファミリーの改良版です。ワークロードがシングルターンの生の精度ベンチマークに集中している場合、違いはそれほど大きくない可能性があります。マルチドキュメントパイプラインで動作している場合、V3.2-Expのコストプロファイルの方が魅力的である可能性があります。

Claude Sonnet 4.5 にアクセスするには

CometAPIは、OpenAIのGPTシリーズ、GoogleのGemini、AnthropicのClaude、Midjourney、Sunoなど、主要プロバイダーの500以上のAIモデルを、開発者にとって使いやすい単一のインターフェースに統合する統合APIプラットフォームです。一貫した認証、リクエストフォーマット、レスポンス処理を提供することで、CometAPIはAI機能をアプリケーションに統合することを劇的に簡素化します。チャットボット、画像ジェネレーター、音楽作曲ツール、データドリブン分析パイプラインなど、どのようなアプリケーションを構築する場合でも、CometAPIを利用することで、反復処理を高速化し、コストを抑え、ベンダーに依存しない環境を実現できます。同時に、AIエコシステム全体の最新のブレークスルーを活用できます。

開発者はアクセスできる DeepSeek V3.2 拡張 CometAPIを通じて、 最新モデルバージョン 公式ウェブサイトで常に更新されています。まずは、モデルの機能について調べてみましょう。 プレイグラウンド そして相談する APIガイド 詳細な手順についてはこちらをご覧ください。アクセスする前に、CometAPIにログインし、APIキーを取得していることを確認してください。 コメットAPI 統合を支援するために、公式価格よりもはるかに低い価格を提供します。

準備はいいですか?→ 今すぐCometAPIに登録しましょう !

結論

DeepSeek-V3.2-Expは、V3クラスの出力品質を維持しながら、ロングコンテキスト作業をより安価かつ実現可能にすることを目的とした実用的な実験的リリースです。長文文書、トランスクリプト、または複数文書の推論を扱うチームにとって、パイロット版として試してみる価値があります。APIはOpenAIスタイルのインターフェースに準拠しているため、統合が容易になり、DSAメカニズムと、大規模構築の経済計算を変革する大幅な価格引き下げの両方を実現します。他の実験モデルと同様に、包括的な評価、インストルメンテーション、段階的なロールアウトが不可欠です。