DeepSeekがリリース ディープシークV3.2 高性能版 DeepSeek-V3.2-スペシャルは、新しいスパースアテンションエンジン(DSA)、エージェント/ツールの挙動の改善、そして内部推論を可視化する「思考」(思考連鎖)モードを備えています。両モデルはDeepSeekのAPI(OpenAI互換エンドポイント)から利用可能で、モデル成果物/技術レポートは公開されています。

DeepSeek V3.2とは何ですか?

DeepSeek V3.2は、DeepSeek V3ファミリーの製品版後継機であり、大規模で長いコンテキストの生成モデルファミリーであり、 推論優先 ワークフローとエージェントの使用。V3.2では、以前の実験的な改善(V3.2-Exp)を、DeepSeekのアプリ、Web UI、APIで公開されるメインストリームモデルラインに統合しました。高速な会話型出力と専用の 思考 数学、デバッグ、計画などの複数ステップの推論タスクに適した (思考の連鎖) モード。

V3.2 が重要な理由 (簡単な説明)

DeepSeek V3.2 は、次の 3 つの実用的な理由で注目に値します。

- 長いコンテキスト: 最大 128K のトークン コンテキスト ウィンドウ。長いドキュメント、法的契約、複数のドキュメントの調査に適しています。

- 推論重視の設計: このモデルは、思考の連鎖(「思考」)をワークフローとツールの使用に統合します。これは、中間の推論ステップを必要とするエージェント アプリへの移行です。

- コストと効率: DSA (スパース アテンション) の導入により、長いシーケンスの計算が削減され、大規模なコンテキストでの推論のコストが大幅に削減されます。

DeepSeek-V3.2-Speciale とは何ですか? ベースの v3.2 とどう違うのですか?

「Speciale」バリアントの何が特別なのでしょうか?

DeepSeek V3.2-Specialeは 高度な計算能力、高度な推論能力 v3.2ファミリーのバリアントです。バランス版のv3.2バリアントと比較して、Specialeは多段階推論、数学、エージェントタスク向けに特別に調整(および事後学習)されています。学習中は、人間からのフィードバックによる強化学習(RLHF)と拡張された内部思考連鎖を使用します。この一時的なエンドポイントとSpeciale APIアクセスは、期限付きとして発表されました(Specialeパスのエンドポイントは2025年12月15日に有効期限切れとなります)。

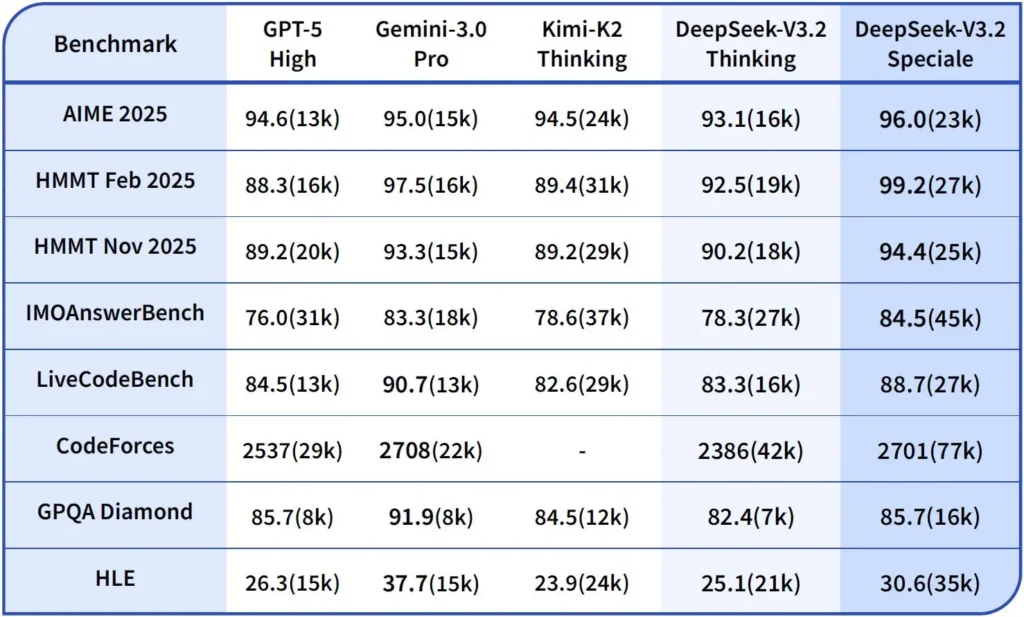

パフォーマンスとベンチマーク

DeepSeek-V3.2-Specialeは、V3.2の高計算能力と推論に最適化されたバージョンです。Specialeバージョンは、以前の数学モデルDeepSeek-Math-V2を統合しており、ワークロードが以下の要件を満たす場合に使用できるモデルとして位置付けられています。 可能な限り深い思考の連鎖、多段階の問題解決、競争的推論(例えば、数学オリンピックスタイル)、複雑なエージェントのオーケストレーション.

数学の定理を証明し、論理的推論を独自に検証することができ、複数の世界クラスのコンテストで目覚ましい成果を上げています。

- IMO(国際数学オリンピック)金メダル

- CMO(中国数学オリンピック)金メダル

- ICPC(国際コンピュータプログラミングコンテスト)第2位(ヒューマンコンテスト)

- IOI(国際情報オリンピック)10位(人間コンテスト)

DeepSeek v3.2 の推論モードとは何ですか?

DeepSeekは明示的に 思考/推論モード これによりモデルは 思考の連鎖 (CoT) 出力の個別の部分として 最終的な答えです。APIはこのCoTを公開し、クライアントアプリケーションがそれを検査、表示、または抽出できるようにします。

仕組み — APIが提供するもの

reasoning_contentフィールド: 思考モードが有効になっている場合、応答構造にはreasoning_content最終フィールドと同じ高さのCoTフィールドcontentこれにより、クライアントはプログラムで内部手順にアクセスできるようになります。- 思考中のツール呼び出し: V3.2はツール呼び出しをサポートすると主張している 以内 思考の軌跡: このモデルは推論ステップとツールの呼び出しをインターリーブできるため、複雑なタスクのパフォーマンスが向上します。

DeepSeek v3.2 APIが推論を実装する方法

バージョン 3.2 では、複数ターンの会話にわたって一貫した推論ロジックを維持するための標準化された推論チェーン API メカニズムが導入されています。

- 各推論リクエストには、

reasoning_contentモデル内のフィールド。 - ユーザーがモデルに推論を続行させたい場合、このフィールドを次のターンに渡す必要があります。

- 新しい疑問が始まると、古い

reasoning_content論理汚染を防ぐためにクリアする必要があります。 - モデルは推論モードで「推論 → ツール呼び出し → 再推論」ループを複数回実行できます。

DeepSeek v3.2 APIにアクセスして使用するにはどうすればいいですか?

ショート: CometAPIはOpenAIスタイルのゲートウェイであり、多くのモデル(DeepSeekファミリーを含む)を https://api.cometapi.com/v1 変更することでモデルを交換できます model リクエスト内の文字列。まずはCometAPIにサインアップしてAPIキーを取得してください。

直接 DeepSeek ではなく CometAPI を使用する理由は何ですか?

- CometAPI は課金、レート制限、モデル選択を一元管理します (コードを変更せずにプロバイダーを切り替える予定がある場合に便利です)。

- 直接DeepSeekエンドポイント(例:

https://api.deepseek.com/v1)は依然として存在し、プロバイダー固有の機能を公開する場合があります。利便性のためにCometAPIを選択するか、プロバイダーネイティブのコントロールについてはベンダーの直接エンドポイントを選択してください。CometAPIを利用する前に、どの機能(Speciale、試験的なエンドポイントなど)がCometAPIで利用できるかを確認してください。

ステップA - CometAPIアカウントを作成し、APIキーを取得する

- CometAPI(サインアップ/コンソール)にアクセスし、APIキーを生成します(ダッシュボードには通常、

sk-...)。秘密にしておいてください。 コメットAPI

ステップB - 利用可能なモデル名を正確に確認する

- CometAPIが公開する正確なモデル文字列を確認するには、モデルリストをクエリしてください(モデル名にはバリアントサフィックスが含まれる場合があります)。名前をハードコーディングする前に、モデルエンドポイントを使用してください。

curl -s -H "Authorization: Bearer $COMET_KEY" \

https://api.cometapi.com/v1/models | jq .

DeepSeekのエントリを探します(例: deepseek-v3.2 or deepseek-v3.2-exp)にアクセスし、正確なIDをメモしてください。CometAPIは /v1/models リスト.

ステップC — 基本的なチャット通話を行う(curl)

交換する <COMET_KEY> および deepseek-v3.2 確認したモデルID:

curl https://api.cometapi.com/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer <COMET_KEY>" \

-d '{

"model": "deepseek-v3.2",

"messages": [

{"role":"system","content":"You are a helpful assistant."},

{"role":"user","content":"Summarize DeepSeek v3.2 in two sentences."}

],

"max_tokens":300

}'

これは OpenAI スタイルの呼び出しパターンと同じです。CometAPI は選択されたプロバイダーに転送します。

互換性と注意事項

- Claude Code 環境での Think Mode の有効化をサポートします。

- コマンドライン (CLI) では、モデル名 deepseek-reasoner を入力するだけです。

- ただし、現時点では Cline や RooCode などの非標準ツールとは互換性がない可能性があります。

- 通常のタスクには非思考モードを使用し、複雑な論理的推論には思考モードを使用することをお勧めします。

実践的な導入パターン: いくつかのアーキテクチャ例

1 — 開発者ワークフローの支援エージェント

- モード: 複雑なコード生成とテスト作成のために呼び出される Speciale (思考モード)、インライン アシスタント用の高速チャット モード。

- 安全性: 生成されたコードに対して CI パイプライン チェックとサンドボックス化されたテスト実行を使用します。

- ホスティング: 大規模なコンテキスト向けの API または vLLM + マルチ GPU クラスターでのセルフホスト。

2 — 法務/財務チーム向けの文書分析

- モード: DSA ロングコンテキスト最適化を備えた V3.2 により、長い契約を処理し、構造化された要約とアクション リストを生成します。

- 安全性: 下流の決定については人間の弁護士が承認し、ホストされたエンドポイントに送信する前に PII を編集します。

3 — 自律型データパイプラインオーケストレーター

- モード: 複数ステップの ETL タスクを計画し、ツールを呼び出してデータベースを照会し、検証テストを呼び出すための思考モード。

- 安全性: 取り返しのつかない操作 (破壊的な DB 書き込みなど) を実行する前に、アクションの確認と検証可能なチェックを実装します。

上記の各パターンは現在、V3.2 ファミリ モデルで実現可能ですが、モデルを検証ツールおよび保守的なガバナンスと組み合わせる必要があります。

v3.2 でコストとパフォーマンスを最適化するにはどうすればよいですか?

デュアルモードを意図的に使用する

- マイクロインタラクションの高速モード: 短い取得、形式の変換、またはレイテンシが重要となる直接 API 呼び出しには、非思考ツール モードを使用します。

- 計画と検証のための思考モード:複雑なタスク、複数のアクションを実行するエージェント、または安全性に配慮した意思決定を思考モードにルーティングします。中間ステップをキャプチャし、重要なアクションを実行する前に検証パス(自動または手動)を実行します。

どのモデルバリエーションを選択すればよいですか?

- deepseek-v3.2 — 一般的なエージェントタスク用のバランスの取れた生産モデル。

- deepseek-v3.2-Speciale — 高度な推論に特化したバリアント。最初は API のみで、可能な限り最高の推論/ベンチマーク パフォーマンスが必要な場合 (および潜在的に高いコストを受け入れる場合) に使用します。

実用的なコスト管理とヒント

- プロンプトエンジニアリング:システム指示は簡潔にし、冗長なコンテキストの送信を避けます。明示的なシステム指示:モードの意図を明示するシステムプロンプトを使用します。例:「THINKINGモードです。ツールを呼び出す前にプランをリストしてください。」ツールモードの場合は、「計算機APIとやり取りする際は、以下のフィールドを含むJSONのみを出力してください。」などの制約を追加します。

- チャンク化 + 検索拡張: 外部リトリーバーを使用して、各ユーザーの質問に最も関連性の高いセグメントのみを送信します。

- 温度とサンプリング: ツールのインタラクションの温度を低くして決定論性を高め、探索的タスクやアイデア創出タスクでは温度を上げます。

ベンチマークと測定

- 検証されるまで出力を信頼できないものとして扱う:推論出力であっても誤りが生じる可能性があります。不可逆的なアクションを実行する前に、確定的なチェック(ユニットテスト、型チェック)を追加してください。

- バリアントにコミットする前に、サンプルのワークロード (レイテンシ、トークンの使用、正確性) で A/B テストを実行します。v3.2 では推論ベンチマークで大きな向上が報告されましたが、実際のアプリの動作はプロンプトの設計と入力の分布によって異なります。

よくあるご質問

Q: モデルから CoT を取得する推奨方法は何ですか?

A: deepseek-reasoner モデルまたはセット thinking/thinking.type = enabled リクエストに含まれます。レスポンスには reasoning_content (CoT)そして最終 content.

Q: モデルは思考モード中に外部ツールを呼び出すことができますか?

A: はい。バージョン3.2では、思考モードと非思考モードの両方でツールを使用できる機能が導入されました。モデルは内部推論中に構造化されたツール呼び出しを発行できます。 strict モードを設定し、JSON スキーマをクリアして、不正な呼び出しを回避します。

Q: 思考モードを使用するとコストは増加しますか?

A: はい。思考モードでは中間CoTトークンが出力されるため、トークンの使用量が増加し、結果としてコストが増加します。必要な場合にのみ思考モードを有効にするようにシステムを設計してください。

Q:どのエンドポイントとベース URL を使用すればよいですか?

A: CometAPIはOpenAI互換のエンドポイントを提供します。デフォルトのベースURLは https://api.cometapi.com そして主要なチャットエンドポイントは /v1/chat/completions (または /chat/completions (選択したベース URL によって異なります)。

Q: ツール呼び出しを使用するには特別なツールが必要ですか?

A: いいえ。APIはJSONでの構造化関数宣言をサポートしています。 tools パラメータ、ツールスキーマ、そしてアプリケーションにおけるJSON関数のライフサイクルを処理します。関数呼び出しJSONを受け取り、関数を実行し、結果をモデルに返して継続または終了させます。思考モードでは、結果をモデルに渡すための要件が追加されます。 reasoning_content ツールの結果と並んで表示されます。

結論

DeepSeek V3.2とDeepSeek-V3.2-Specialeは、 オープンで推論中心 思考の連鎖を明示化し、エージェントツールのワークフローをサポートするLLM。トークンコスト、慎重な状態管理、運用制御を考慮すれば、信頼できるエージェントの構築を簡素化できる強力な新しいプリミティブ(DSA、思考モード、ツール使用トレーニング)を提供します。

開発者はアクセスできる ディープシーク v3.2 API CometAPI経由など、 最新モデルバージョン 公式ウェブサイトで常に更新されています。まずは、モデルの機能について調べてみましょう。 プレイグラウンド そして相談する APIガイド 詳細な手順についてはこちらをご覧ください。アクセスする前に、CometAPIにログインし、APIキーを取得していることを確認してください。 コメットAPI 統合を支援するために、公式価格よりもはるかに低い価格を提供します。

準備はいいですか?→ deepseek v3.2 の無料トライアル !