OpenAI、Anthropic、そしてGoogleは、最新の主力製品であるOpenAIのo3(およびその拡張版o3-pro)、AnthropicのClaude Opus 4、そしてGoogleのGemini 2.5 Proによって、大規模言語モデルの限界を押し広げ続けています。これらのモデルはそれぞれ、独自のアーキテクチャ革新、優れたパフォーマンス、そしてエコシステム統合をもたらし、エンタープライズグレードのコーディング支援から消費者向け検索機能の強化まで、様々なユースケースに対応します。この詳細な比較では、リリース履歴、技術的機能、ベンチマークパフォーマンス、そして推奨アプリケーションを検証し、組織がニーズに最適なモデルを選択できるよう支援します。

OpenAI の o3 とは何ですか? また、どのように進化してきましたか?

OpenAIは3年16月2025日にo10を初めて導入し、拡張コンテキストと信頼性の高い応答のために設計された「最もインテリジェントなモデル」と位置付けました。その後まもなく、2025年3月XNUMX日には、ChatGPTとAPI経由でProユーザーが利用できるパフォーマンス調整版であるoXNUMX-proをリリースしました。これは、高負荷時でもより高速な推論と高いスループットを実現します。

コンテキストウィンドウとスループット

OpenAI o3は 200万トークン 入出力の両方にコンテキストウィンドウを備え、大規模なドキュメント、コードベース、または複数ターンの会話を頻繁に切り捨てることなく処理できます。スループットは約 37.6トークン/秒は、トップクラスではないものの、持続的なワークロードに対して一貫した応答性を提供します。

高度な熟慮推論

- 「私的な思考の連鎖」: o3 は、最終出力を生成する前に中間ステップを計画および推論するように強化学習でトレーニングされ、論理的推論と問題分解の能力が大幅に向上しました。

- 審議的な調整: ステップバイステップの推論を通じてモデルがより確実にガイドラインに準拠するようにガイドする安全技術が組み込まれており、複雑な現実世界のタスクにおける重大なエラーが削減されます。

価格設定とエンタープライズ統合

OpenAIのo3の価格はおよそ 入力トークン2万個あたりXNUMXドル および 出力トークン8万個あたりXNUMXドルこれにより、本製品はミッドレンジに位置付けられます。高負荷ワークロードではClaude Opus 4などのプレミアムモデルよりも手頃な価格ですが、Gemini 2.5 Proなどの予算に優しい代替製品よりも高価です。重要なのは、企業がより広範なOpenAI APIエコシステム(埋め込み、微調整、特殊なエンドポイントを含む)とのシームレスな統合の恩恵を受け、統合オーバーヘッドを最小限に抑えられることです。

Claude Opus 4 は市場でどのように差別化を図っていますか?

アントロピックは4年22月2025日にClaude Opus XNUMXを発表し、複雑で長時間実行されるタスクやエージェントワークフローにおいて持続的なパフォーマンスを発揮する「世界最高のコーディングモデル」として売り出しました。Claude Opus XNUMXはアントロピック独自のAPIとAmazon Bedrockで同時にリリースされ、AWSの顧客はBedrockのLLM機能とREST APIを通じてアクセスできるようになりました。..

拡張された「思考」能力

Opus 4の特徴は、 「拡張思考」 ベータモードでは、モデル内推論とツール呼び出し(検索、取得、外部APIなど)の間で計算リソースを動的に割り当てます。「思考サマリー」と組み合わせることで、ユーザーはモデルの内部推論チェーンを可視化できます。これは、金融や医療におけるコンプライアンス重視のアプリケーションにとって非常に重要です。

価格とコンテキストのトレードオフ

At 入力トークン15万個あたりXNUMXドル および 出力トークン75万個あたりXNUMXドルクロード・オーパス4は価格帯の最高峰に位置します。 200万トークン 入力ウィンドウ( 32万トークン 出力上限はGemini 2.5 Proの1万トークンウィンドウよりも小さいですが、ほとんどのコードレビューと長文推論タスクには十分です。Anthropicは、内部計算の強度と思考連鎖の持続的な忠実性を重視し、このプレミアム価格を正当化しています。プロンプトキャッシュにより最大90%、バッチ処理により最大50%のコスト削減が可能です。拡張思考バジェットは有料プランに含まれており、無料ユーザーはSonnetバリアントのみにアクセスできます。

Gemini 2.5 Pro にはどのような独自の機能とパフォーマンスがありますか?

Googleの次世代「Pro」層としてリリースされた、 ジェミニ 2.5 プロ 膨大なコンテキスト、マルチモーダルな入力、そして費用対効果の高いスケーリングを必要とする組織を対象としています。特に、最大 1,048,576トークン 1回のプロンプトで(受信) 65,535トークン アウトバウンドで、数十万ページに及ぶエンドツーエンドのドキュメント ワークフローを実現します。

優れたコンテキストとマルチモダリティ

ジェミニ2.5 Proは、 1万トークン コンテキストウィンドウは、法的契約分析、特許マイニング、包括的なコードベースのリファクタリングなどのユースケースを容易にします。このモデルはネイティブに テキスト、コード、画像、音声、PDF、ビデオフレーム個別の前処理手順なしでマルチモーダル パイプラインを合理化します。

Gemini はマルチモーダルおよび会話型検索をどのように強化しますか?

Gemini 2.5 Proは、「クエリファンアウト」手法を特徴としています。複雑なクエリをサブクエリに分解し、並列検索を実行し、包括的で会話的な回答を即座に生成します。テキスト、音声、画像入力をサポートするAIモードは、Geminiのマルチモーダル機能を活用して、多様なユーザーインタラクションに対応します。ただし、まだ初期段階であるため、クエリを誤って解釈する場合があります。

競争価格の設定

入力レートが $1.25~$2.50 百万トークンあたり $10~$15 2.5万出力トークンあたり、Gemini XNUMX Proは最高の 価格対トークン 2.5つの比率は、特に高負荷でドキュメント集約型のアプリケーション(長いコンテキストがパフォーマンス指標よりもトークン消費量を増加させる)にとって魅力的です。プレミアムプランでは、「Deep Think」予算とより高いスループットが利用可能になります。Google AI ProおよびUltraサブスクリプションには、Gemini XNUMX Proに加えて、Veoビデオ生成やNotebookLMなどのツールへのアクセスがバンドルされています。

基盤となるアーキテクチャと機能

OpenAI o3: 大規模な反射的推論

OpenAIのo3は、段階的な論理的推論タスクに追加の熟考時間を費やすように設計された、反射的生成型事前学習済みTransformerです。アーキテクチャ的にはGPT-4のTransformerバックボーンを基盤としていますが、「思考予算」メカニズムを組み込んでいます。このモデルは複雑な問題に対してより多くの計算サイクルを動的に割り当て、出力を生成する前に内部的な思考連鎖を構築します。これにより、高度な数学、科学的探究、コード合成など、多段階の推論を必要とする分野において、パフォーマンスが大幅に向上します。

Claude Opus 4: 拡張ワークフローのためのハイブリッド推論

AnthropicのClaude Opus 4は、コーディングと持続的なエージェントワークフロー向けに最適化された、同社史上最も強力なモデルです。o3と同様に、Transformerコアを活用しつつ、ハイブリッドな推論モード(ほぼ瞬時の応答(「高速思考」)と長時間の熟考(「深層思考」))を導入することで、数千ステップ、数時間にも及ぶ計算においてもコンテキストを維持できます。このハイブリッドなアプローチにより、Opus 4は長期にわたるソフトウェアエンジニアリングパイプライン、多段階のリサーチタスク、自律エージェントオーケストレーションに特に適しています。

Gemini 2.5 Pro: 適応型予算によるマルチモーダル思考

Google DeepMindのGemini 2.5 Proは、Gemini本来のマルチモーダル性と推論能力を拡張します。「Deep Think」と呼ばれる適応型並列思考メカニズムを導入し、サブタスクを内部モジュール全体に展開し、結果を統合して一貫性のある応答を生成します。また、Gemini 2.5 Proは非常に長いコンテキストウィンドウを誇り、コードベース全体、大規模なデータセット(テキスト、音声、動画)、設計文書をXNUMX回のパスで取り込むことができます。同時に、パフォーマンスとコストのトレードオフを考慮し、思考予算をきめ細かく制御できます。

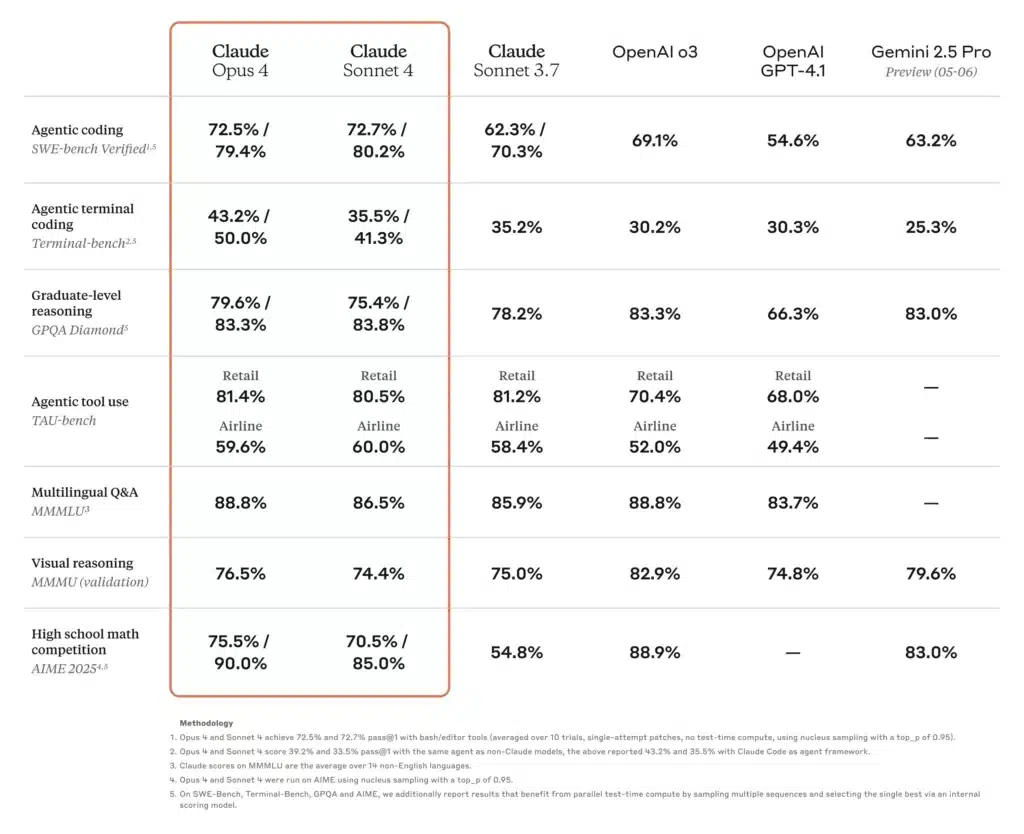

これらのモデル間でパフォーマンスベンチマークを比較するとどうなりますか?

学術的および科学的推論

最近のSciArenaのランキングでは、研究者による技術的推論問題においてo3が同業他社を圧倒し、その科学的正確性に対するコミュニティの強い信頼を反映しています。一方、Claude Opus 4は、長時間にわたる問題解決を必要とするエージェントベースベンチマークにおいて優れたパフォーマンスを発揮し、TAUベンチと予測推論タスクにおいてSonnetモデルを最大30%上回りました。Gemini 2.5 Proは多くの学術ベンチマークでもリードしており、LMArenaの人間の嗜好評価で1位を獲得し、数学と科学のテストでも大きな差をつけています。

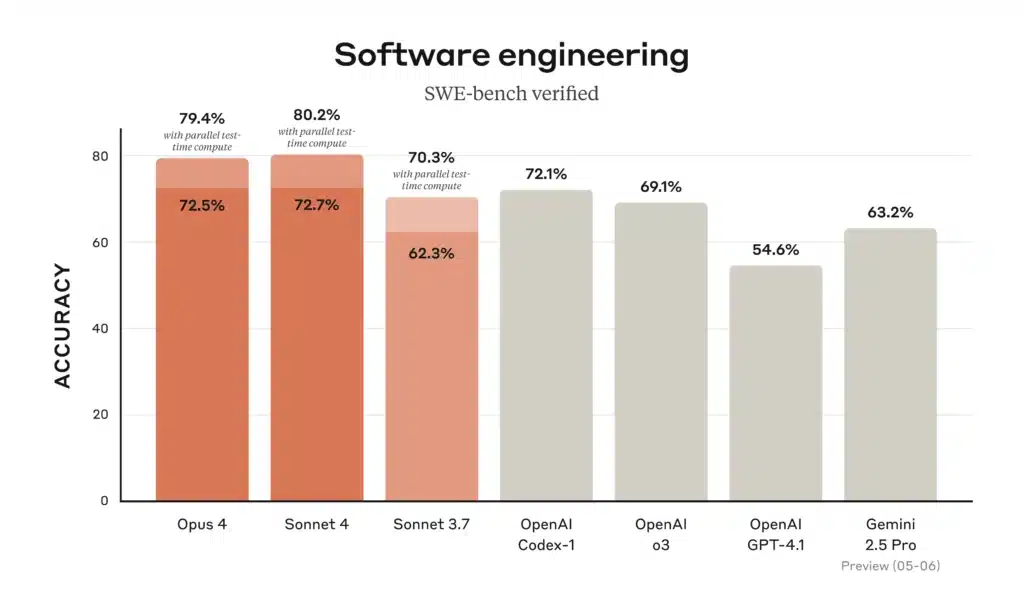

コーディングとソフトウェアエンジニアリング

コーディングのリーダーボードでは、Gemini 2.5 Pro は「人気の WebDev Arena でトップ」であり、リポジトリ全体をロードして推論する機能により、一般的なコーディング ベンチマークをリードしています。Claude Opus 4 は、複雑で長時間実行されるソフトウェア タスクに焦点を当てたベンチマークである SWE ベンチで 72.5%、Terminal ベンチで 43.2% を獲得し、「世界最高のコーディング モデル」の称号を獲得しています。o3 もコード合成とデバッグに優れていますが、複数ステップの大規模なエンジニアリング シナリオでは Opus 4 と Gemini に若干遅れをとります。とはいえ、その直感的な思考の連鎖により、個々のコーディング タスクに対する信頼性が非常に高くなります。

ツールの使用とマルチモーダル統合

Gemini 2.5 Pro のマルチモーダル設計(テキスト、画像、音声、動画の処理)により、インタラクティブなシミュレーション、ビジュアルデータ分析、動画ストーリーボード作成などのクリエイティブワークフローで優位性を発揮します。Claude Opus 4 のエージェントツール使用(Claude Code CLI や統合ファイルシステム操作など)は、API とデータベースをまたぐ自律パイプラインの構築に優れています。o3 はウェブブラウジング、ファイル分析、Python 実行、画像推論をサポートしており、Gemini 2.5 Pro よりもコンテキスト制限は短いものの、混合フォーマットのタスクに対応する万能の「スイスアーミーナイフ」となっています。

これらのモデルは、実際のコーディングシナリオではどのように比較されるのでしょうか?

コーディング支援に関して言えば、ベンチマークは全体像の一部しか示しません。開発者は、正確なコード生成、リファクタリング能力、そして複数のファイルにまたがるプロジェクトのコンテキストを理解する能力を求めています。

精度と幻覚率

- クロード・オーパス4 幻覚回避において、存在しないAPI参照や誤ったライブラリシグネチャのインスタンス数が少なく、ミッションクリティカルなコードベースにとって重要な点である。幻覚発生率は 〜12%で 広範なコード監査と 〜18%で ジェミニと 〜20%で o3の場合。

- ジェミニ 2.5 プロ 広大なコンテキスト ウィンドウのおかげで、一括変換 (数万行にわたるコード パターンの移行など) に優れていますが、大規模なコード ブロック内の微妙なロジック エラーに悩まされることがあります。

- OpenAI o3 安定したレイテンシと高い可用性により、クイック スニペット、定型文生成、インタラクティブ デバッグには依然として使用されていますが、開発者はエッジ ケースの間違いを見つけるために別のモデルで相互検証することがよくあります。

ツールとAPIエコシステム

- 両方 o3 および 双子座 広範なツール(それぞれ OpenAI の関数呼び出し API と Google の統合アクション フレームワーク)を活用して、データ取得、データベース クエリ、外部 API 呼び出しのシームレスなオーケストレーションを可能にします。

- クロード・オーパス4 Claude Code (Anthropic の CLI ツール) や Amazon Bedrock などのエージェント フレームワークに統合され、手動オーケストレーションなしで自律ワークフローを構築するための高レベルの抽象化を提供します。

どのモデルが最も優れた価格性能比を実現しますか?

生の機能、コンテキストの長さ、コストのバランスをとることで、ワークロードの特性に応じて異なる「最適な価値」の結論が得られます。

大量のドキュメント中心のユースケース

法的なリポジトリ、科学文献、企業のアーカイブなどの膨大なコーパスを処理する場合、ジェミニ 2.5 プロ 勝者として浮上することが多い。 1万トークン の窓口と価格帯 $ 1.25- $ 2.50 (入力)と $ 10- $ 15 (出力) トークンは、長いコンテキストのタスクに対して無敵のコスト構造を提供します。

深い推論と多段階のワークフロー

財務モデリング、法令遵守チェック、R&Dパイプラインなど、正確性、思考の連鎖の忠実性、長期にわたるエージェントの機能が重要となる場合、クロード・オーパス4は、価格が高いにもかかわらず、再実行と人間によるレビューサイクルを最小限に抑えることで、エラー処理のオーバーヘッドを削減し、エンドツーエンドのスループットを向上させることができます。

バランスの取れた企業導入

極端なスケールではなく、信頼性の高い汎用的なパフォーマンスを求めるチームにとって、 OpenAI o3 中間的な選択肢を提供します。幅広いAPIサポート、適度な価格設定、そして確かなベンチマーク結果により、データサイエンスプラットフォーム、顧客サポートの自動化、そして初期段階の製品統合において、依然として魅力的な選択肢となっています。

特定のニーズに合わせてどの AI モデルを選択すればよいでしょうか?

最終的に、理想的なモデルは次の 3 つの主な要素によって決まります。

- 文脈のスケール: 膨大な入力ウィンドウを必要とするワークロードの場合、Gemini 2.5 Pro が優位です。

- 推論の深さ: タスクに複数ステップのロジックが含まれており、エラーに対する許容度が低い場合、Claude Opus 4 は優れた一貫性を提供します。

- コスト感度とエコシステム適合性OpenAI スタック内の汎用タスク、特に既存のデータ パイプラインとの統合が重要な場合、o3 はバランスの取れたコスト効率の高いオプションを提供します。

アプリケーションのトークン プロファイル (入力と出力)、幻覚に対する許容度、ツール要件を評価することで、技術的なニーズと予算の制約の両方に最適なモデルを選択できます。

以下は、OpenAI o3、Anthropic Claude Opus 4、Google Gemini 2.5 Pro の主な仕様、パフォーマンス メトリック、価格、理想的な使用例をまとめた比較表です。

| 機能 / メトリック | OpenAI o3 | クロード・オーパス4 | ジェミニ 2.5 プロ |

|---|---|---|---|

| コンテキストウィンドウ(インバウンド/アウトバウンド) | 200万トークン / 200万トークン | 200万トークン / 32万トークン | 1 048 576トークン / 65 535トークン |

| スループット (トークン/秒) | 〜37.6 | 〜42.1 | 〜83.7 |

| 平均レイテンシー | 約2.8秒 | 約3.5秒 | 約2.52秒 |

| コーディングベンチマーク(SWE-bench) | 69.1% | 72.5% | 63.2% |

| 数学ベンチマーク(AIME-2025) | 78.4%¹ | 81.7%¹ | 83.0% |

| 幻覚率(コード監査) | 〜20% | 〜12% | 〜18% |

| マルチモーダル入力 | テキストとコード | テキストとコード | テキスト、コード、画像、音声、PDF、ビデオ |

| 「思考の連鎖」サポート | スタンダード | 要約による拡張思考 | スタンダード |

| 関数/ツール呼び出しAPI | はい(OpenAI Functions) | はい(AnthropicエージェントとBedrock経由) | はい(Google アクション) |

| 価格設定(入力トークン) | 2.00ドル / Mトークン | 15.00ドル / Mトークン | 1.25~2.50ドル / Mトークン |

| 価格設定(出力トークン) | 8.00ドル / Mトークン | 75.00ドル / Mトークン | 10~15ドル / Mトークン |

| 理想的な使用例 | 汎用チャットボット、顧客サポート、クイックコードスニペット | 深い推論、複雑なコードベース、自律エージェント | 大規模なドキュメント分析、マルチモーダルワークフロー |

AIME-2025 の o3 および Opus 4 の数学スコアは、報告されたベンチマークに基づくおおよその中間値です。

スタートガイド

CometAPIは、OpenAIのGPTシリーズ、GoogleのGemini、AnthropicのClaude、Midjourney、Sunoなど、主要プロバイダーの500以上のAIモデルを、開発者にとって使いやすい単一のインターフェースに統合する統合APIプラットフォームです。一貫した認証、リクエストフォーマット、レスポンス処理を提供することで、CometAPIはAI機能をアプリケーションに統合することを劇的に簡素化します。チャットボット、画像ジェネレーター、音楽作曲ツール、データドリブン分析パイプラインなど、どのようなアプリケーションを構築する場合でも、CometAPIを利用することで、反復処理を高速化し、コストを抑え、ベンダーに依存しない環境を実現できます。同時に、AIエコシステム全体の最新のブレークスルーを活用できます。

開発者はアクセスできる ジェミニ 2.5 プロ,クロード・オーパス4 および O3 API コメットAPI掲載されている最新モデルのバージョンは、記事の公開日時点のものです。まずは、モデルの機能をご確認ください。 プレイグラウンド そして相談する APIガイド 詳細な手順についてはこちらをご覧ください。アクセスする前に、CometAPIにログインし、APIキーを取得していることを確認してください。 コメットAPI 統合を支援するために、公式価格よりもはるかに低い価格を提供します。

結局のところ、OpenAIのo3シリーズ、AnthropicのClaude Opus 4、GoogleのGemini 2.5 Proのどれを選ぶかは、組織の具体的な優先事項(最高レベルの技術パフォーマンス、安全なエンタープライズ統合、シームレスなマルチモーダルな消費者体験など)によって決まります。各モデルの強みとエコシステムに合わせてユースケースを調整することで、最先端のAIを活用し、研究、開発、教育など、あらゆる分野でイノベーションを推進できます。

著者の注釈: 31年2025月XNUMX日現在、これらのモデルはそれぞれ、頻繁なマイナーアップデートとエコシステムの改善により進化を続けています。最終決定を下す前に、必ず最新のCometAPI APIドキュメントとパフォーマンスベンチマークを参照してください。