28年2025月3日、Alibaba Cloudは大規模言語モデル(LLM)ファミリーの最新版であるQwen 3を発表しました。このリリースはオープンソースAIの進化における重要なマイルストーンであり、多様なアプリケーションとユーザーニーズに対応するモデルスイートを提供します。開発者、研究者、そして企業にとって、Qwen XNUMXへのアクセス方法と活用方法を理解することで、自然言語処理をはじめとする様々な分野における新たな可能性を切り開くことができます。

Qwen 3 とは何ですか?

Qwen 3は、Alibaba CloudのオープンソースLLMの第28世代であり、先行モデルが築き上げた基盤の上に構築されています。2025年3月36日にリリースされたQwen 119は、密なアーキテクチャと疎なアーキテクチャの両方を含む、さまざまなパラメータサイズを持つ幅広いモデルを導入しています。これらのモデルは、3の言語と方言にわたるXNUMX兆トークンの広範なデータセットで学習されており、Qwen XNUMXはグローバルアプリケーション向けの多用途ツールとして位置付けられています。

Qwen 3 の主な機能

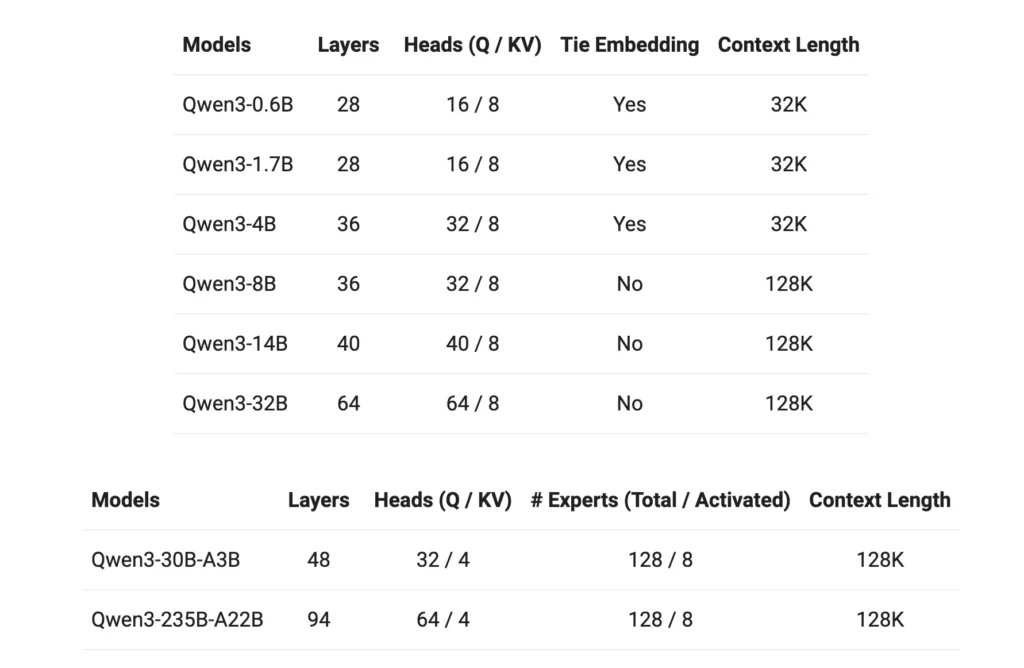

- モデルバリアントQwen 3 は、0.6B、1.7B、4B、8B、14B、32B のパラメータを持つ密なモデルと、30B (3B のアクティブ化パラメータ) および 235B (22B のアクティブ化パラメータ) のスパース モデルを提供します。

- 拡張コンテキストウィンドウほとんどのモデルは 128K トークン コンテキスト ウィンドウをサポートしており、長い形式のコンテンツの処理が容易になります。

- 推論能力: 強化された推論機能はトークナイザーを介して切り替えることができ、特定のタスクに基づいて適応可能なパフォーマンスを実現します。

- 多言語・多文化に対応 119 の言語と方言を網羅したトレーニング データを備えた Qwen 3 は、多様な言語アプリケーションに対応します。

- ライセンシングすべてのモデルは Apache 2.0 ライセンスの下でリリースされ、オープンソースのコラボレーションとイノベーションを促進します。

Qwen3 にアクセスするにはどうすればいいですか?

Alibaba Cloudの最新大規模言語モデル(LLM)スイートであるQwen 3へのアクセスは簡単で多用途です。高度なAI機能をアプリケーションに統合することを目指す開発者から、最先端のモデルを研究する研究者まで、Qwen 3は様々なニーズに対応する複数のアクセスポイントを提供します。

1. QwenChatウェブインターフェース経由

QwenChat は、セットアップなしですぐにやり取りできるように、ユーザーフレンドリーな Web インターフェイスを提供します。

- QwenChatを訪問:に移動します QwenChatプラットフォーム。

- モデルを選択: 要件に応じて、Qwen3-8B、Qwen3-14B、Qwen3-32B などのモデルから選択します。

- チャットを開始する: Q&A、コンテンツ生成、コーディング支援などのタスクについては、チャット インターフェースを通じてモデルと直接やり取りします。

2. Alibaba Cloud経由のAPIアクセス

Alibaba Cloud の API サービスを使用して、Qwen 3 をアプリケーションに統合します。

API認証情報を取得する: Alibaba Cloud にサインアップして API キーを取得します。

アクセス方法を選択:

- OpenAI互換API: OpenAI 互換エンドポイントを活用してシームレスな統合を実現します。

bashPOST https://dashscope-intl.aliyuncs.com/compatible-mode/v1/chat/completions

- ダッシュスコープ SDK: あるいは、よりカスタマイズされたインタラクションのために DashScope SDK を使用します。

- 環境の設定: API キーを環境変数として設定し、必要な SDK をインストールして開発環境を構成します。

3. Hugging FaceとModelScope経由でアクセス

オープンソース プラットフォームを好む開発者向け:

- ハグ顔: Hugging Face の Qwen 組織を通じて Qwen 3 モデルにアクセスします。

pythonfrom transformers import AutoTokenizer, AutoModelForCausalLM tokenizer = AutoTokenizer.from_pretrained("Qwen/Qwen3-14B") model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen3-14B")

- モデルスコープ: ModelScope でさまざまな Qwen 3 バリアントのモデルを探索します。

4. ローカル展開オプション

制御とカスタマイズを強化するために、Qwen 3 モデルをローカルに展開します。

オラマ: ローカルモデル管理を簡素化するプラットフォーム。

- インストール: Ollamaをダウンロードしてインストールする オラマ.com。

- モデル展開: Ollama の CLI を使用して Qwen 3 モデルをローカルで実行します。

bashollama run qwen3-14b

vLLM: 高スループットと低レイテンシのサービス提供に最適化されています。

- インストール: pip を使用して vLLM をインストールします。

bashpip install -U vllm

- モデルの提供: 推論能力を持つQwen 3モデルにサービスを提供します。

bashvllm serve Qwen/Qwen3-30B-A3B \ --enable-reasoning \ --reasoning-parser deepseek_r1

相互作用: デフォルトのAPIサーバー経由でモデルにアクセスします。 http://localhost:8000。

5. サードパーティプラットフォーム: CometAPI

Qwen3を活用 コメットAPI 無料アクセスを提供:

- コメットAPI: 登録して無料の API キーを取得し、Qwen3-8B、Qwen3-30B、Qwen3-235B などのモデルから選択してプロジェクトに統合します。

Qwen 3の始め方

Qwen 3の使用を開始するには:

- ユースケースを決定する: Web インターフェース、API 統合、またはローカル展開が必要かどうかを識別します。

- 適切なモデルを選択する: 計算リソースとタスクの複雑さに合ったモデルバリアントを選択します。

- 環境をセットアップする: 選択したアクセス方法に基づいて、インストールおよび構成の手順に従います。

- 統合とテスト: Qwen 3 をアプリケーションに組み込み、テストを実行して最適なパフォーマンスを確保します。

これらの手順に従うことで、Qwen 3 の機能を効果的に活用し、プロジェクトや研究活動を強化できます。

Qwen 3の実装:実践的な考慮事項

システム要件

Qwen 3モデル、特に大規模なバリアントの導入には、膨大な計算リソースが必要です。ユーザーは、モデルのサイズと処理能力に対応できる十分なGPU性能とメモリを確保する必要があります。

統合とカスタマイズ

Qwen 3はオープンソースであるため、幅広いカスタマイズが可能です。開発者は、ドメイン固有のデータに基づいてモデルを微調整したり、パラメータを調整してパフォーマンスを最適化したり、既存のシステムにモデルを統合して機能を強化したりできます。

コミュニティとサポート

フォーラム、GitHub のディスカッション、その他のコラボレーションプラットフォームを通じて Qwen 3 コミュニティと交流することで、貴重な洞察とサポートを得ることができます。経験や解決策を共有することで、技術の共同発展に貢献します。

結論

Qwen 3は、オープンソースの大規模言語モデルの分野における大きな進歩です。多様なモデル、広範な言語サポート、そしてアクセス可能なプラットフォームを備え、幅広いアプリケーションに対応する堅牢なツールセットを提供します。Qwen 3のアクセス方法と実装方法を理解することで、ユーザーはその機能を最大限に活用し、それぞれの分野におけるイノベーションと効率性を推進することができます。

スタートガイド

開発者はアクセスできる クウェン 3 API経由 コメットAPIまず、プレイグラウンドでモデルの機能を調べ、 APIガイド 詳細な手順については、こちらをご覧ください。開発者によっては、モデルを使用する前に組織の確認が必要となる場合がありますのでご注意ください。