이번 주 중국 Zhipu AI가 공개한 GLM-5(개발자 채널에서 공개 브랜드명은 Z.AI / zai-org)는 대규모 모델 릴리스의 가속화된 흐름 속에서 또 하나의 이정표를 의미한다. 새 모델은 Zhipu의 플래그십으로 포지셔닝되며: 더 큰 규모, 장기 지향 agentic 과업에 맞춘 튜닝, 긴 컨텍스트를 보존하면서 추론 비용을 줄이려는 엔지니어링 선택을 바탕으로 구축되었다. 초기 업계 보도와 개발자 실사용 노트에 따르면 이전 GLM 버전에 비해 코딩, 다단계 추론, 에이전트 오케스트레이션에서 의미 있는 향상이 관찰되며 — 일부 테스트에서는 Claude 4.5에 도전하기도 한다.

GLM-5란 무엇이며 누가 만들었나요?

GLM-5는 GLM 계열의 최신 대형 릴리스로, Z.ai(GLM 시리즈의 개발팀)가 개발·공개한 대규모 오픈소스 기초 모델이다. 2026년 2월 초에 발표된 GLM-5는 특히 "agentic" 과업 — 즉, 모델이 계획을 수립하고 도구를 호출하며 실행하고, 장시간의 대화나 자동화 에이전트에 대해 컨텍스트를 유지해야 하는 다단계·장기 워크플로우 — 에 맞춰 튜닝된 차세대 모델로 소개됐다. 이번 릴리스는 모델 설계뿐 아니라 학습 방식과 환경에서도 주목할 만하다: Z.ai는 자급자족을 목표로 중국 국내 하드웨어와 툴체인을 혼합해 사용했다.

보고된 아키텍처와 학습 지표는 다음과 같다:

- 파라미터 스케일링: GLM-5는 대략 744B 파라미터까지 확장되며(일부 기술 노트에서는 더 작은 "활성" 전문가 수를 인용, 예: 40B 활성), 이전 GLM-4 계열의 약 355B/32B 활성 대비 크게 증가했다.

- 사전학습 데이터: 학습 코퍼스 규모가 GLM-4 세대의 약 23조 토큰에서 GLM-5에서는 약 28.5조 토큰으로 증가한 것으로 보고됐다.

- 스파스 어텐션 / DeepSeek Sparse Attention (DSA): 추론 시 계산 비용을 줄이면서도 긴 컨텍스트를 유지하기 위한 스파스 어텐션 스키마.

- 설계 중점: 에이전트 오케스트레이션, 장문맥 추론, 비용 효율적 추론에 초점을 맞춘 엔지니어링 선택.

기원과 포지셔닝

GLM-5는 2025년 중반에 출시된 GLM-4.5와 4.7 등 몇 차례의 반복 업데이트를 바탕으로 구축되었다. Z.ai는 GLM-5를 "vibe coding"(빠른 단일 단계 코드 출력)에서 “agentic engineering”으로의 도약으로 포지셔닝한다: 지속적 추론, 다중 도구 오케스트레이션, 긴 컨텍스트 윈도우에서의 시스템 합성. 공개 자료는 GLM-5가 복잡한 시스템 엔지니어링 과업을 처리하도록 설계되었다는 점을 강조한다 — 고립된 질의에 답하는 것을 넘어 다단계 에이전트 행동을 구축·조정·유지하는 것이다.

GLM-5의 새로운 기능은 무엇인가요?

주요 아키텍처 변화

- 대규모 스파스 스케일링(MoE): GLM-5는 훨씬 더 큰 스파스 Mixture-of-Experts 아키텍처로 전환했다. 개발자 페이지와 독립적 분석 자료에 따르면 이 모델은 대략 총 744B 파라미터, 토큰당 약 40B 활성으로 소개되며 — GLM-4.5의 약 355B / 32B 활성 구성 대비 큰 도약이다. 이러한 스파스 스케일링은 토큰당 계산을 감당 가능한 수준으로 유지하면서 매우 큰 총 용량을 제공한다.

- DeepSeek Sparse Attention(DSA): 추론 비용을 선형으로 늘리지 않고 장문맥 능력을 유지하기 위해, GLM-5는 스파스 어텐션 메커니즘(DeepSeek 브랜드)을 통합하여 초장길이 컨텍스트에서의 어텐션 비용을 줄이는 동시에 중요한 장거리 종속성을 규모 있게 유지한다.

근본적 설계 목표로서의 agentic engineering

GLM-5의 대표적 특징 중 하나는 agentic engineering을 명시적으로 지향해 설계되었다는 점이다 — 즉, 단일 턴 채팅이나 요약 작업에만 쓰이는 것이 아니라, 계획을 세우고 도구 호출을 발행하고 상태를 관리하며 긴 컨텍스트 전반에서 추론할 수 있는 다단계 에이전트의 “두뇌”로 사용되도록 의도되었다. Z.ai는 GLM-5를 오케스트레이션 루프에서 활용하도록 포지셔닝한다: 복잡한 문제를 분해하고, 외부 도구/API를 호출하며, 여러 턴에 걸친 긴 작업을 추적한다.

agentic 설계가 중요한 이유

Agentic 워크플로우는 실제 자동화의 핵심이다: 자동화 연구 보조, 자율 소프트웨어 엔지니어, 운영 오케스트레이션, 시뮬레이션 제어. 이러한 환경을 위해 구축된 모델은 강력한 계획 능력, 안정적인 도구 호출 동작, 수천 토큰 규모의 컨텍스트에서의 견고함이 필요하다.

개선된 코딩, 추론 및 “장기 지향” 동작

GLM-5는 향상된 코드 생성과 추론을 강조한다. Z.ai는 코드 작성·리팩터링·디버깅 능력의 표적 개선과, 장시간 상호작용에서 보다 일관된 다단계 추론을 주장한다. 독립적 얼리 액세스 보고와 파트너 평가에서는 이전 GLM 세대보다 개발자 지향 작업에서 모델이 눈에 띄게 강력하다고 확인했다.

실용적인 개발자 기능

- 문서, 코드베이스, 대화 상태를 담을 수 있는 더 큰 컨텍스트 윈도우

- 안전한 도구 호출 및 결과 처리를 위한 툴링 프리미티브

- 복잡한 작업을 분해·실행하기 위한 향상된 퓨샷 및 chain-of-thought 성능

- Agentic 기능과 도구 호출: GLM-5는 에이전트에 대한 네이티브 지원을 강조한다: 함수/도구 호출, 상태 유지 세션, 장시간 대화와 도구 사용 시퀀스의 더 나은 관리. 이를 통해 웹 검색, 데이터베이스, 작업 자동화를 통합하는 에이전트를 더 쉽게 구축할 수 있다.

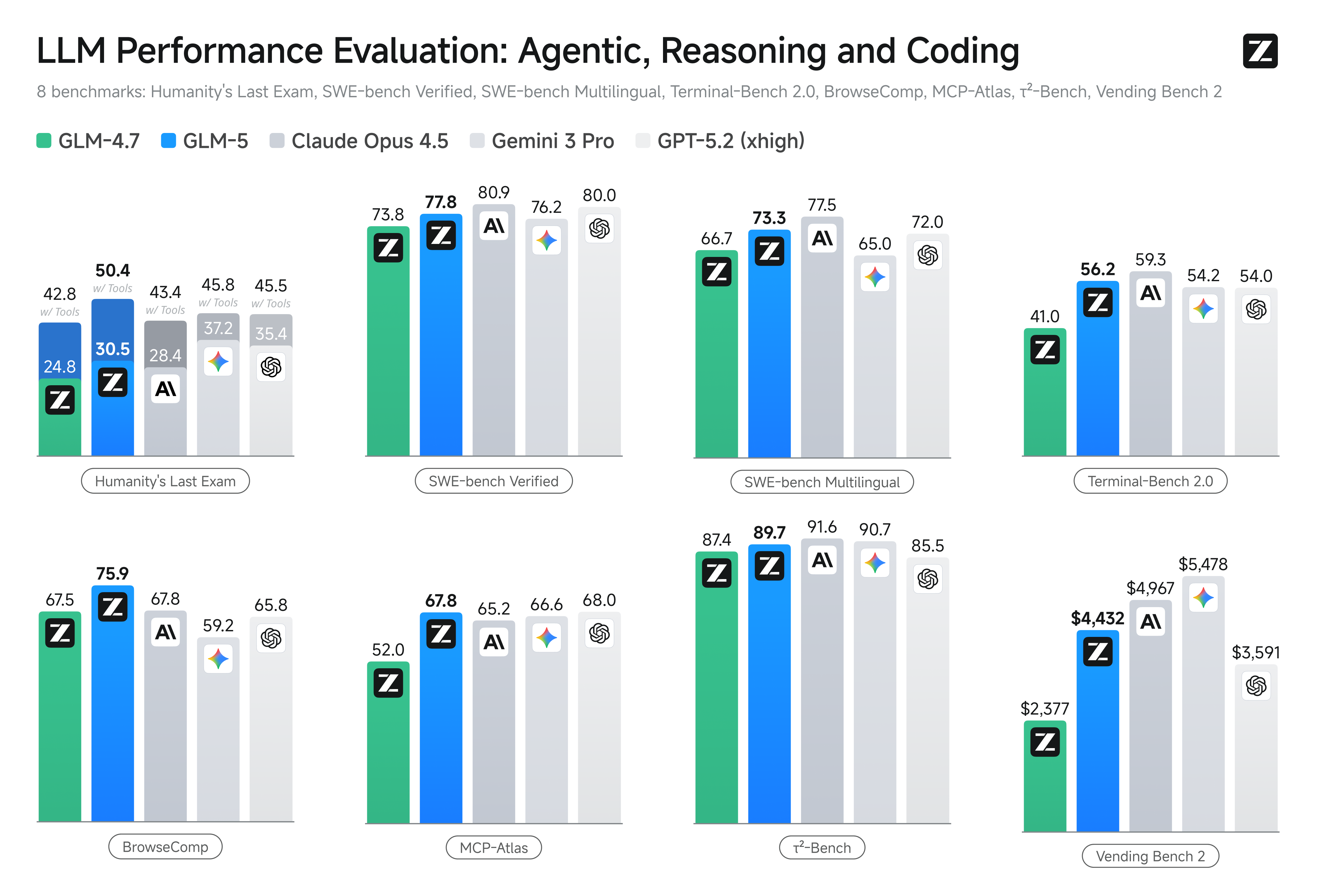

GLM-5의 벤치마크 성능은 어떠한가요?

주요 벤치마크 하이라이트

- 코딩 벤치마크: 특정 코딩 과제에서 GLM-5가 Anthropic의 Claude Opus 4.5와 같은 고도로 최적화된 상용 모델의 코딩 성능에 근접하거나(일부 경우에는 동등)하는 모습을 보인다. 이러한 결과는 과제 유형(유닛 테스트, 알고리즘 코딩, API 사용)에 따라 달라지지만, GLM-4.5 대비 뚜렷한 개선을 의미한다.

- 추론 및 agentic 테스트: 다단계 추론과 agentic 평가 세트(예: 다중 턴 계획, 작업 분해 벤치마크)에서 GLM-5는 오픈소스 모델 중 최고 수준의 결과를 달성했으며, 일부 지표에서는 특정 과제에서 경쟁하는 폐쇄형 모델을 능가했다.

GLM-5는 어떻게 액세스하고 사용해 볼 수 있나요?

GLM-5는 Zhipu AI(Z.ai)의 5세대 대규모 언어 모델로, **Mixture-of-Experts 아키텍처(총 약 745 B, 활성 약 44 B)**로 구축되었으며 강력한 추론, 코딩, agentic 워크플로우를 목표로 한다. 공식 출시 시점은 2026년 2월 12일 전후이다.

현재로서는 두 가지 주요 방식으로 액세스할 수 있다:

A) 공식 API 액세스(Z.ai 또는 애그리게이터)

Zhipu AI는 자체 모델에 대한 API를 제공하며, 해당 API를 통해 GLM-5를 호출할 수 있다.

일반적인 단계:

- Z.ai/Open BigModel API 계정을 등록한다.

- 대시보드에서 API 키를 발급받는다.

- 모델 이름(예:

glm-5)을 사용해 OpenAPI 스타일 또는 REST API 엔드포인트를 호출한다.

(OpenAI의 GPT 모델을 호출하는 방식과 유사하다). - 프롬프트를 설정하고 HTTP 요청을 전송한다.

👉 Z.ai의 가격 페이지에는 공식 GLM-5 토큰 가격이 다음과 같이 표시되어 있다:

- 입력 토큰 100만개당 약 $1.0

- 출력 토큰 100만개당 약 $3.2

B) 서드파티 API 래퍼 —— CometAPI

CometAPI나 WaveSpeed 같은 API는 여러 AI 모델(OpenAI, Claude, Z.ai 등)을 통합된 인터페이스로 래핑한다.

- CometAPI 같은 서비스를 사용하면 모델 ID를 변경하여 GLM 모델을 호출할 수 있다.

(CometAPI는 현재 GLM-5/GLM-4.7를 지원한다.) - CometAPI의 glm-5는 공식 가격의 20%로 책정되어 있다.

| 사용 유형 | 가격 |

|---|---|

| 입력 토큰 | ~$0.8 / 1M 토큰 |

| 출력 토큰 | ~$2.56 / 1M 토큰 |

왜 중요한가: 기존 OpenAI 호환 클라이언트 코드를 유지한 채 베이스 URL/모델 ID만 변경하면 된다.

C) Hugging Face / 가중치 기반 셀프 호스팅

Hugging Face 모델 목록에는 glm-5/glm-5-fp8 등으로 명명된 GLM-5 가중치 리포지토리가 비공식적으로 공개되어 있다.

이를 통해 다음을 수행할 수 있다:

- 모델 가중치를 다운로드한다.

- vLLM, SGLang, xLLM, Transformers 등의 도구를 사용해 로컬 또는 클라우드 GPU 플릿에서 서빙한다.

장점: 최대한의 제어, 지속적 API 비용 없음.

단점: 매우 큰 연산 리소스 요구 — 고급 GPU 여러 장과 메모리(수백 GB)가 필요할 가능성이 높아, 소형 시스템에서는 실용적이지 않음.

그렇다면 — GLM-5는 가치가 있을까, 그리고 GLM-4.7을 유지해야 할까?

짧은 답변(요약)

- 강건한 다단계 agentic 동작, 프로덕션급 코드 생성, 시스템 수준 자동화가 필요하다면: GLM-5는 즉시 평가할 가치가 있다. 그 아키텍처, 규모, 튜닝은 바로 이러한 결과를 우선시한다.

- 비용 효율적이고 고처리량의 마이크로서비스(짧은 채팅, 분류, 경량 프롬프트)가 필요하다면: GLM-4.7이 가장 경제적 선택일 가능성이 높다. GLM-4.7은 많은 제공업체 목록에서 토큰당 비용이 크게 낮은 수준에서 강력한 기능 세트를 유지하며 이미 실전 검증을 거쳤다.

긴 답변(실무 권장사항)

계층형 모델 전략을 채택하라: 일상적이고 대량의 상호작용에는 GLM-4.7을 사용하고, 고가치 엔지니어링 문제와 agentic 오케스트레이션에는 GLM-5를 예약하라. 긴 컨텍스트, 도구 통합, 코드 정확성을 시험하는 작은 제품 범위에서 GLM-5를 파일럿하고; 절감된 엔지니어링 시간과 증가하는 모델 비용을 모두 측정하라. 시간이 지나면 GLM-5의 능력 향상이 더 넓은 마이그레이션을 정당화하는지 판단할 수 있다.

CometAPI를 사용하면 GLM-4.7과 GLM-5 사이를 언제든 전환할 수 있다.

GLM-5가 빛나는 실제 활용 사례

1. 복잡한 에이전트 오케스트레이션

GLM-5는 다단계 계획과 도구 호출에 설계 초점을 두었기 때문에 검색, API 호출, 프로그램 실행을 조정해야 하는 시스템에 적합하다(예: 자동화 연구 보조, 반복적 코드 생성기, 데이터베이스와 외부 API를 조회해야 하는 다단계 고객 서비스 에이전트).

2. 장문 엔지니어링 및 코드베이스 추론

여러 파일이나 대규모 코드베이스 전반을 분석·리팩터링·합성해야 할 때, GLM-5의 확장된 컨텍스트와 스파스 어텐션은 직접적인 이점이 된다 — 잘린 컨텍스트로 인한 실패 모드가 줄고 장거리 일관성이 향상된다.

3. 지식 집약적 합성

복잡한 보고서(다중 섹션 연구 브리프, 법률 요약, 규제 제출물)를 생성하는 애널리스트와 제품 팀은 벤더 보고 테스트에서 확인된 안정적 다단계 추론 개선과 환각 감소로부터 혜택을 받을 수 있다.

4. 워크플로우를 위한 agentic 자동화

여러 시스템(예: 계획 + 티켓팅 + 배포 파이프라인)을 오케스트레이션해야 하는 자동화를 구축하는 팀은 도구 호출 프레임워크와 안전 래퍼를 기반으로 GLM-5를 중앙 계획자이자 실행자로 사용할 수 있다.

결론

GLM-5는 빠르게 진화하는 프런티어 모델 환경에서 중요한 릴리스다. agentic engineering에 대한 강조, 개선된 코딩과 추론, 오픈 웨이트 제공은 장기 지향·도구 지원 AI 시스템을 구축하는 팀에게 매력적이다. 특정 과제에서의 실제 향상과 고무적인 비용/성능 트레이드오프가 있지만 — 프로덕션에 도입하기 전에 각자의 과제에 맞춰 GLM-5를 평가하고 자체 통제된 벤치마크를 수행해야 한다.

개발자는 지금 CometAPI를 통해 GLM-5에 액세스할 수 있다. 시작하려면 Playground에서 모델의 기능을 탐색하고 자세한 지침은 API 가이드를 참고하라. 액세스하기 전에 CometAPI에 로그인하고 API 키를 발급받았는지 확인하라. CometAPI는 통합을 돕기 위해 공식 가격보다 훨씬 낮은 가격을 제공한다.

Ready to Go?→ 오늘 glm-5 가입하기 !