OpenAI baru-baru ini mengumumkan beberapa kemas kini, termasuk keluaran model GPT-5-Codex-Mini, penambahbaikan kepada had kadar untuk hierarki berbilang pengguna dan pengoptimuman kepada kecekapan pemprosesan model.

OpenAI GPT-5-Codex-Mini ialah varian GPT-5-Codex yang baru diumumkan dan memfokuskan pembangun: model yang dioptimumkan kos dan throughput yang lebih kecil bertujuan untuk menyampaikan kebanyakan bantuan pengekodan GPT-5-Codex tetapi pada kos yang jauh lebih rendah dan volum boleh guna yang lebih tinggi. Varian "Mini" diletakkan sebagai pilihan pragmatik untuk sesi pengekodan yang panjang, automasi latar belakang dan aliran kerja pembangun frekuensi tinggi di mana keupayaan puncak mentah adalah kurang penting daripada mendapatkan lebih banyak token/permintaan untuk pelan yang sama.

Apakah GPT-5-Codex-Mini dan cirinya?

GPT-5-Codex-Mini ialah varian padat, menjimatkan kos bagi keluarga GPT-5-Codex OpenAI yang dibungkus khusus untuk permukaan produk Codex (penyepaduan CLI dan IDE). Ia diletakkan sebagai model "lebih kecil, lebih cekap kos" yang memperdagangkan sejumlah kecil keupayaan puncak untuk penggunaan sumber yang lebih rendah secara material dan kuota boleh guna yang lebih tinggi untuk aliran kerja pembangun interaktif. Model mini bertujuan untuk membolehkan pembangun menjalankan lebih banyak pusingan pengekodan (OpenAI menerangkan secara kasar 4x lebih penggunaan untuk peringkat langganan ChatGPT yang sama) sambil mengekalkan kependaman dan kos untuk tugas kejuruteraan biasa yang jelas.

Dari segi keupayaan, GPT-5-Codex-Mini mewarisi ciri teras barisan produk Codex: pemahaman mendalam tentang pangkalan kod dan pelaksanaan tugas berbilang langkah dalam cara "ejen". Berdasarkan ciri Codex CLI, pembangun boleh menyerahkan arahan bahasa semula jadi, coretan kod, tangkapan skrin atau gambar rajah reka bentuk antara muka kepada Codex dalam terminal interaktif. Model ini mula-mula akan menyediakan pelan, dan kemudian menyemak imbas fail, mengedit kod, menjalankan arahan dan ujian secara automatik selepas mendapat kelulusan pengguna.

Dari perspektif modal, produk Codex membenarkan melampirkan imej (seperti tangkapan skrin UI, draf reka bentuk atau tangkapan skrin mesej ralat) pada sesi dalam terminal atau IDE. Model boleh memahami kedua-dua kandungan teks dan imej, tetapi output masih terutamanya kod teks dan penjelasan. Oleh itu, GPT-5-Codex-Mini boleh dianggap sebagai model proksi kod yang terutamanya "input teks + imej, output teks", dan tidak menjalankan tugas seperti penjanaan imej, penjanaan audio atau penjanaan video.

Bagaimanakah GPT-5-Codex-Mini dibandingkan dengan GPT-5-Codex?

Apa yang baharu dalam Codex?

Sebagai tambahan kepada GPT-5-Codex-Mini realsed, OpenAI telah meningkatkan secara seragam had kadar Codex sebanyak 50% untuk tahap pengguna ChatGPT Plus, Business dan Edu, dengan ketara meningkatkan had permintaan yang tersedia. Sementara itu, pengguna ChatGPT Pro akan mendapat kebenaran pemprosesan keutamaan untuk meningkatkan kelajuan tindak balas dan pengalaman pelaksanaan tugas.

Tambahan pula, OpenAI telah membuat peningkatan kecil kepada model GPT-5-Codex, mengoptimumkan prestasinya dalam senario kolaboratif. Model yang dikemas kini menunjukkan peningkatan beberapa mata peratusan pada metrik penilaian utama, peningkatan kira-kira 3% dalam kecekapan penggunaan token dan keteguhan yang lebih besar dalam mengendalikan kes-kes tepi, sekali gus mengurangkan keperluan untuk panduan pengguna.

| tahap pengguna | GPT-5-Codex | GPT-5-Codex-Mini |

|---|---|---|

| Plus/Biz/Edu | meningkatkan kelantangan mesej sebanyak 1.5x masing-masing. | meningkatkan kelantangan mesej sebanyak 6x masing-masing. |

GPT-5-Codex-Mini vs GPT-5-Codex:perbezaan penanda aras

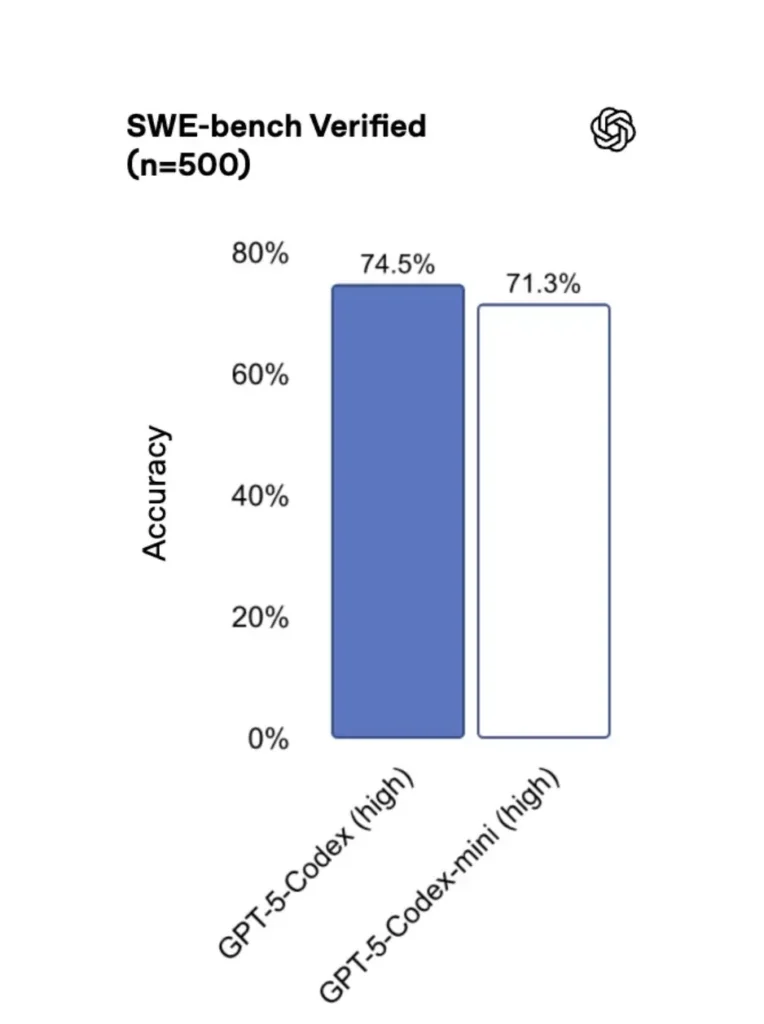

GPT-5-Codex-Mini berbanding versi asal, prestasinya berkurangan sedikit, tetapi pembangun menerima kira-kira empat kali kredit penggunaan. Dalam ujian SWE-bench Verified, GPT-5 High mendapat 72.8%, GPT-5-Codex mendapat 74.5% dan GPT-5-Codex-Mini mendapat 71.3%.

Codex (dan varian mininya) menggunakan token yang lebih sedikit secara mendadak untuk interaksi ringan—bahan OpenAI menuntut pengurangan mengikut urutan berpuluh-puluh mata peratusan untuk gesaan mudah (cth, angka yang disebut ≈93.7% lebih sedikit token pada interaksi ringan untuk keluarga Codex lwn. GPT-5 dalam beberapa senario).

GPT-5-Codex-Mini vs GPT-5-Codex:perbezaan ciri

- Saiz & kos: Mini jelas lebih kecil dan lebih cekap kos; OpenAI membingkaikannya sebagai membolehkan lebih kurang 4× penggunaan di bawah kekangan langganan yang sama. Ini ialah pengoptimuman kuota/kecekapan untuk tugas pembangun rutin.

- Sampul surat keupayaan: GPT-5-Codex kekal sebagai pilihan berkeupayaan lebih tinggi untuk tugas agen yang panjang dan kompleks (refactor besar, ulasan kod mendalam, kitaran ujian lanjutan). Mini ditala untuk menjadi lebih pantas dan kurang intensif sumber untuk interaksi singkat yang kerap.

- Had kependaman dan kadar: Mini biasanya memberikan kependaman yang lebih rendah dan membenarkan had kadar yang lebih tinggi bagi setiap pelan — menjadikannya sesuai untuk aliran kerja interaktif yang padat.

- Permukaan lalai: Mini tersedia sebagai model yang boleh dipilih dalam Codex CLI dan IDE Extension; GPT-5-Codex ialah lalai untuk tugas awan dan aliran semakan kod dalam dalam Codex.

Bila hendak menggunakan Mini vs. Full Codex

- Penggunaan Mini untuk: perancah, penjanaan kod berulang, refactor kecil, penyiapan interaktif semasa penyuntingan dan apabila bekerja di bawah kuota atau kekangan kos.

- Penggunaan GPT-5-Codex untuk: semakan kod komprehensif, tugas autonomi berbilang jam, refaktor kompleks dan tugasan yang memerlukan penaakulan terkuat model dan pelaksanaan dipacu ujian.

Bagaimanakah saya boleh mengakses GPT-5-Codex-Mini (CLI, IDE, API)?

Codex CLI (terminal-first)

OpenAI diperkenalkan gpt-5-codex-mini sebagai pilihan model dalam Codex CLI. Corak penggunaan biasa mengikut aliran kerja Codex CLI: mulakan sesi interaktif, nyatakan model, lampirkan fail atau tangkapan skrin, jalankan "tugas Codex Cloud" dan banyak lagi. CLI juga menyokong cepat /model bertukar antara penuh gpt-5-codex and gpt-5-codex-mini. Semasa pertama kali dijalankan, anda perlu mengesahkan menggunakan akaun ChatGPT/Pro/Enterprise anda (atau menyediakan kunci API). CLI menyediakan pelbagai arahan yang membolehkan Codex mengimbas pangkalan kod, menjalankan ujian, membuka REPL atau menggunakan pengesyoran tampalan.

Contoh (sesi interaktif Codex CLI):

# Install Codex CLI (npm)

npm i -g @openai/codex

# or Homebrew on macOS

brew install --cask codex

# Launch in a repo

cd myproject

# Open a codex interactive session

codex

# In the session you can switch the model:

# (this is typed in the Codex TUI)

> /model gpt-5-codex-mini

# Ask Codex to generate a unit test

> Write pytest tests for function `calculate_discount` in discounts.py

Aliran itu mencerminkan lalai Codex CLI baharu di mana alat akan mencadangkan Mini menghampiri had penggunaan.

Kod VS / Sambungan IDE

Ya — sambungan IDE Codex (Kod VS) sudah disertakan gpt-5-codex-mini sebagai pilihan. Pasang sambungan Codex dalam Kod Visual Studio untuk mendapatkan pelengkapan kod sebaris, cadangan pemfaktoran semula dan pembetulan pantas dipacu AI. Sambungan juga mendedahkan tindakan pantas (jana kod, terangkan kod yang dipilih, refactor) dan boleh menjalankan tugas Codex Cloud daripada editor, langkah VS Code:

- Pasang sambungan OpenAI Codex / ChatGPT untuk Kod VS.

- Log masuk dengan akaun ChatGPT anda (Plus/Pro/Business).

- Buka palet arahan:

Cmd/Ctrl+Shift+P → Codex: Set Model→ pilihgpt-5-codex-mini. - Gunakan arahan sebaris (pilih kod → klik kanan → "Jelaskan dengan Codex" atau tekan kekunci panas yang dikonfigurasikan).

Contoh: Perintah sebaris Kod VS (langkah semu)

- Pilih fungsi dalam

user_service.py. - Keratan Akhbar

Cmd/Ctrl+Shift+P → Codex: Explain Selectionatau gunakan klik kanan → "Jelaskan dengan Codex." - Sambungan membuka panel sisi dengan penjelasan Mini, ujian yang dicadangkan dan butang "Buat PR" sekali klik yang menggunakan tugas Awan Codex untuk menolak cawangan untuk semakan.

Bagaimana pula dengan API — bolehkah saya memanggilnya daripada apl saya?

Pengumuman OpenAI menunjukkan Sokongan API akan datang tidak lama lagi untuk GPT-5-Codex-Mini; semasa penulisan model itu tersedia dalam rantaian alat Codex dahulu (CLI/IDE). Ini bermakna pelanggan API pengeluaran harus bersedia untuk nama model gpt-5-codex-mini dalam API Permintaan/Respons sebaik sahaja ia diterbitkan. Sementara itu, anda boleh membuat prototaip dengan aliran Codex CLI dan IDE.

Apabila akses API didayakan, panggilan biasa (gaya Respons) mungkin kelihatan seperti:

# illustrative — check OpenAI docs for final param names

from openai import OpenAI

client = OpenAI(api_key="sk-...")

resp = client.responses.create(

model="gpt-5-codex-mini",

input="Write a Python function that validates an email address and includes unit tests.",

max_tokens=512,

temperature=0.2

)

print(resp.output_text)

Apakah amalan terbaik untuk kejuruteraan pantas dengan Codex Mini?

Di bawah ialah amalan terbaik dan corak konkrit yang diuji medan untuk mendapatkan nilai maksimum daripada Codex Mini dalam aliran kerja kejuruteraan pengeluaran.

1) Strategi pemilihan model — campur dan padan

Gunakan Mini untuk tugasan berfrekuensi tinggi, kerumitan yang lebih rendah (pemformatan, refaktor kecil, ujian automatik) dan kembali kepada Codex penuh untuk reka bentuk yang kompleks, penyahpepijatan mendalam atau transformasi luas repo yang besar. Automatikkan suis: Codex CLI sudah mencadangkan Mini pada penggunaan 90%, dan anda boleh skrip /model menukar perkakas anda untuk memilih model berdasarkan kerumitan tugas.

2) Templat kejuruteraan segera

Buat templat segera yang kecil dan menentukan untuk tugasan yang boleh diulang: penjanaan ujian, draf log perubahan, penjanaan mesej komit dan huraian PR. Simpan ini sebagai coretan boleh guna semula dalam repo anda atau sebagai pratetap gesaan Codex.

Contoh templat gesaan untuk ujian unit:

# Template: generate_pytests

System: You are a precise Python developer. Produce pytest tests.

User: Given the function below, produce parametrized pytest functions that cover typical edge cases.

--- file: discounts.py

<insert function>

---

Return only valid Python test code with imports and fixtures.

3) Automasi jaring keselamatan — kelulusan & gerbang CI

Jangan sekali-kali benarkan model menolak kod terus tanpa kebenaran manusia. Gunakan mod kelulusan Codex dan tugas Codex Cloud untuk mencipta perbezaan dan memerlukan log keluar manusia dalam CI. Codex CLI menyokong "mod kelulusan" jadi suntingan mesti diluluskan sebelum digunakan.

4) Cache dan nyahduplikasi panggilan model

Untuk gesaan berulang (cth, menerangkan fungsi), cache respons yang dikunci oleh gesaan + cincang fail. Ini mengurangkan panggilan berlebihan dan memastikan profil kos boleh diramal.

5) Gunakan penstriman + perbezaan tambahan

Apabila boleh, minta output penstriman dan perbezaan tambahan daripada penulisan semula keseluruhan fail. Ini mengurangkan penggunaan token dan membantu pengulas melihat perubahan yang disasarkan.

6) Aliran penjana pertama ujian unit

Hasilkan ujian dan jalankannya secara tempatan dalam persekitaran yang tidak lama. Jika ujian gagal, ulangi dengan model yang membekalkan pembetulan ujian gagal. Bingkai setiap lelaran sebagai gesaan diskret dengan output ujian disertakan.

Contoh coretan automasi Codex CLI (bash):

# Generate tests

codex --model gpt-5-codex-mini request "Generate pytest tests for discounts.py" > generated_tests.py

# Run tests locally

pytest generated_tests.py -q || {

echo "Tests failed. Opening Codex for debugging..."

codex --model gpt-5-codex-mini request "Tests failed. Here's pytest output: $(tail -n 50 pytest_output.txt). Propose a fix for discounts.py."

}

Kesimpulan

GPT-5-Codex-Mini ialah langkah produk yang pragmatik: ia mengakui bahawa aliran kerja pembangun selalunya dikuasai oleh banyak interaksi pendek yang memerlukan kependaman, kos dan aliran tanpa gangguan. Dengan menyediakan peringkat mini yang bertujuan untuk penggunaan IDE dan CLI, OpenAI memberikan pasukan keupayaan untuk menskalakan bantuan pengekodan harian tanpa menggunakan model kos tertinggi untuk setiap interaksi dengan segera.

Pembangun boleh mengakses API GPT-5-Codex ,API GPT-5 Pro melalui CometAPI, model terbaru cometAPI yang disenaraikan adalah pada tarikh penerbitan artikel. Sebelum mengakses, sila pastikan anda telah log masuk ke CometAPI dan memperoleh kunci API.CometAPI menawarkan harga yang jauh lebih rendah daripada harga rasmi untuk membantu anda menyepadukan.

Bersedia untuk Pergi?→ Daftar untuk CometAPI hari ini !

Jika anda ingin mengetahui lebih banyak petua, panduan dan berita tentang AI, ikuti kami VK, X and Perpecahan!