De release van GLM-5, deze week onthuld door het Chinese Zhipu AI (publiekelijk gebrand als Z.AI / zai-org in veel ontwikkelaarskanalen), markeert opnieuw een stap in het versnellende tempo van grote-modelreleases. Het nieuwe model wordt gepositioneerd als Zhipu’s vlaggenschip: groter in schaal, afgestemd op langetermijn agentische taken, en gebouwd met engineeringskeuzes die bedoeld zijn om de inferentiekosten te verlagen terwijl lange context behouden blijft. Vroege rapporten uit de sector en hands-on notities van ontwikkelaars suggereren betekenisvolle verbeteringen in codering, meerstapsredenering en orkestratie van agents ten opzichte van eerdere GLM-iteraties — en in sommige tests daagt het zelfs Claude 4.5 uit.

Wat is GLM-5 en wie heeft het gebouwd?

GLM-5 is de nieuwste grote release in de GLM-familie: een groot, open-source foundation model ontwikkeld en gepubliceerd door Z.ai (het team achter de GLM-serie). Aangekondigd begin februari 2026, wordt GLM-5 gepresenteerd als een next-gen model dat specifiek is afgestemd op “agentische” taken — d.w.z. meerstaps, langetermijnwerkstromen waarin een model moet plannen, tools aanroepen, uitvoeren en context behouden voor uitgebreide gesprekken of geautomatiseerde agents. De release is opvallend niet alleen vanwege het modelontwerp maar ook vanwege hoe en waar het is getraind: Z.ai gebruikte een mix van binnenlandse Chinese hardware en toolchains als onderdeel van een streven naar zelfvoorziening.

Gerapporteerde architectuur- en trainingscijfers omvatten:

- Parameterschaal: GLM-5 schaalt op tot ongeveer 744B parameters (met een kleinere “actieve” experttelling vermeld in sommige technische notities, bijv. 40B actief), versus eerdere GLM-4-familiegroottes rond 355B/32B actief.

- Pretrainingdata: De trainingscorpusgrootte is naar verluidt toegenomen van ~23 biljoen tokens (GLM-4-generatie) naar ~28,5 biljoen tokens voor GLM-5.

- Sparse attention / DeepSeek Sparse Attention (DSA): Een sparse attention-schema om lange context te behouden en tegelijkertijd de rekenkosten tijdens inferentie te verlagen.

- Ontwerpaccent: engineeringskeuzes gericht op agent-orkestratie, lang-contextredenering en kosteneffectieve inferentie.

Oorsprong en positionering

GLM-5 bouwt voort op een lijn die GLM-4.5 (uitgebracht medio 2025) omvatte en enkele iteratieve updates zoals 4.7. Z.ai positioneert GLM-5 als een sprong van “vibe coding” (snel eenstaps code-uitvoer) naar “agentic engineering”: volgehouden redenering, multi-tool orkestratie en systeemsynthese over lange contextvensters. De publieke materialen benadrukken dat GLM-5 is ontworpen om complexe systeemengineeringstaken aan te pakken — het bouwen, coördineren en onderhouden van meerstapse agentgedragingen in plaats van alleen geïsoleerde vragen te beantwoorden.

Wat zijn de nieuwe functies in GLM-5?

Belangrijke architecturale veranderingen

- Massieve sparse schaal (MoE): GLM-5 stapt over op een veel grotere sparse Mixture-of-Experts-architectuur. Publieke cijfers uit ontwikkelaarspagina’s en onafhankelijke artikelen noemen het model ongeveer 744B totale parameters met ~40B actief per token — een aanzienlijke stap omhoog vanaf GLM-4.5’s ~355B / 32B actieve configuratie. Deze sparse schaal maakt zeer grote totale capaciteit mogelijk terwijl de per-tokenberekening beheersbaar blijft.

- DeepSeek Sparse Attention (DSA): Om lang-contextcapaciteit te behouden zonder de inferentiekosten lineair te laten schalen, integreert GLM-5 een sparse attention-mechanisme (gebrand als DeepSeek) om belangrijke langetermijnafhankelijkheden op schaal te behouden terwijl de kosten van aandacht over contexten met mega-lengte worden teruggebracht.

Agentic engineering als een fundamenteel ontwerpdoel

Een van GLM-5’s headlinefuncties is dat het expliciet is ontworpen voor agentic engineering — wat betekent dat het model bedoeld is om niet alleen gebruikt te worden voor single-turn chat of samenvattingstaken, maar als het “brein” van meerstapsagents die kunnen plannen, hulpmiddelen aanroepen, status beheren en redeneren over lange contexten. Z.ai positioneert GLM-5 om te dienen in orkestratielussen: complexe problemen opsplitsen, externe tools/API’s aanroepen en lange taken volgen over vele beurten.

Waarom agentisch ontwerp ertoe doet

Agentische werkstromen staan centraal in echte automatisering: geautomatiseerde onderzoeksassistenten, autonome software-engineers, operatie-orkestratie en simulatiecontrole. Een model dat voor deze wereld is gebouwd, heeft sterke planningsvaardigheden nodig, stabiel tool-aanroepgedrag en robuustheid over duizenden tokens aan context.

Verbeterde codering, redenering en “langetermijngedrag”

GLM-5 benadrukt verbeterde codegeneratie en redenering. Z.ai claimt gerichte verbeteringen in het vermogen van het model om code te schrijven, refactoren en debuggen, plus consistentere meerstapsredenering over lange interacties. Onafhankelijke early-accessrapporten en evaluaties van partners vonden het model merkbaar sterker bij ontwikkelaarsgerichte taken dan eerdere GLM-generaties.

Praktische ontwikkelaarsfuncties

- Grotere contextvensters om documentatie, codebases en gespreksstatus vast te houden.

- Toolingprimitieven voor veilige tool-aanroep en resultaatverwerking.

- Betere few-shot- en chain-of-thought-prestaties om complexe taken te decomponeren en uit te voeren.

- Agentische functies en tool-aanroepen: GLM-5 benadrukt native ondersteuning voor agents: functie-/toolaanroepen, stateful sessies en betere beheersing van lange dialogen en reeksen van toolgebruik. Dit maakt het eenvoudiger om agents te bouwen die websearch, databases of taakautomatisering integreren.

Hoe presteert GLM-5 op benchmarks?

Specifieke benchmarkhoogtepunten

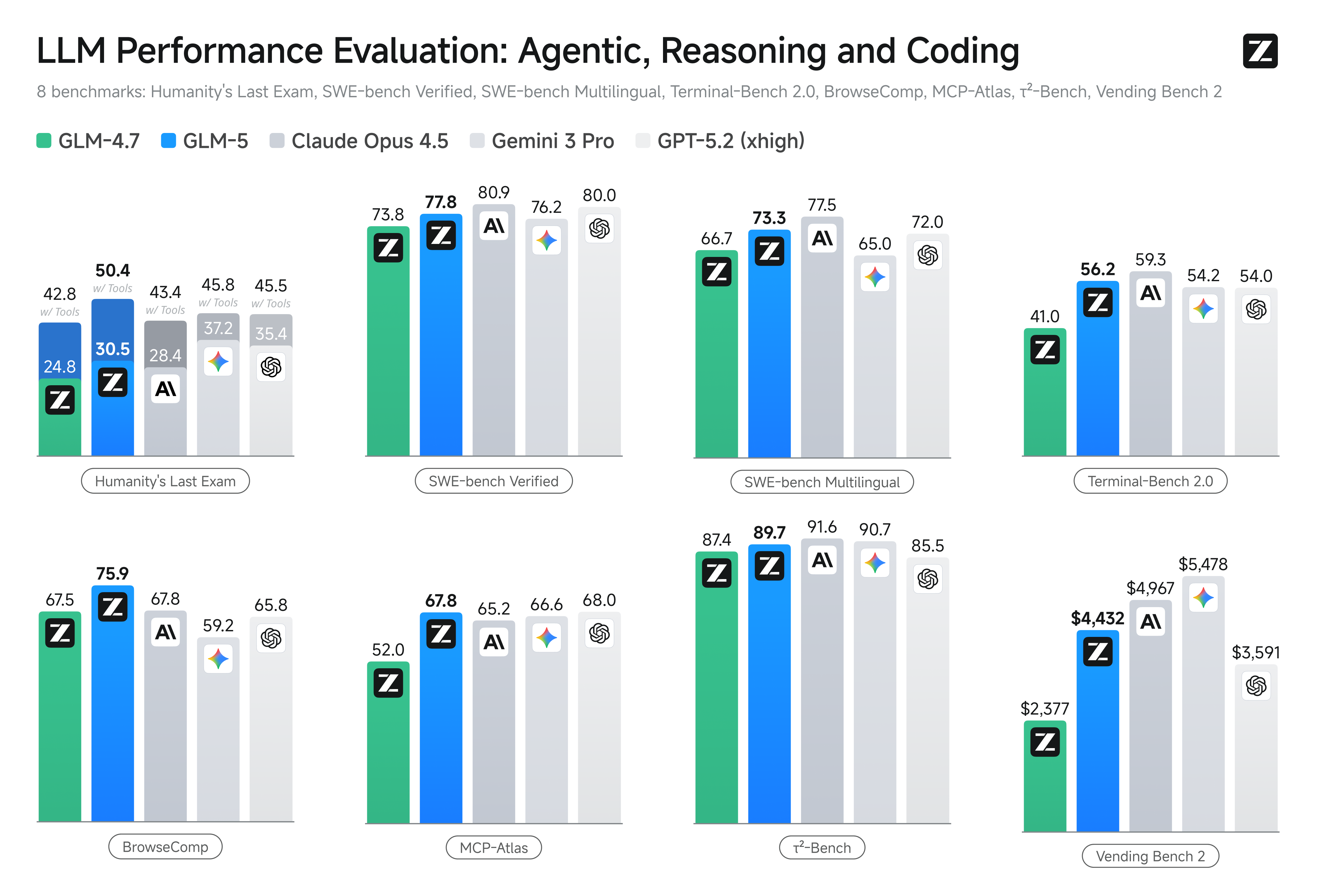

- Coding-benchmarks: GLM-5 nadert (en in sommige gevallen evenaart) de codeerprestaties van sterk geoptimaliseerde propriëtaire modellen zoals Anthropic’s Claude Opus 4.5 op specifieke codingtaken. Deze resultaten zijn taakafhankelijk (unittests, algoritmische codering, API-gebruik), maar ze markeren een duidelijke verbetering ten opzichte van GLM-4.5.

- Redenering en agentische tests: Op meerstapsredenering en agentische evaluatiesuites (bijv. multi-turn planning, taakdecompositiebenchmarks) bereikte GLM-5 best-in-class resultaten voor open-source modellen en overtrof het in sommige metrieken concurrerende gesloten modellen op gerichte taken.

Hoe krijg ik toegang tot en probeer ik GLM-5?

GLM-5 is de vijfde-generatie large language model van Zhipu AI (Z.ai), gebouwd met een Mixture-of-Experts-architectuur (~745 B totaal, ~44 B actief) en gericht op sterke redenering, codering en agentische werkstromen. Het is officieel gelanceerd rond 12 feb. 2026.

Er zijn momenteel twee hoofdmanieren waarop mensen er toegang toe krijgen:

A) Officiële API-toegang (Z.ai of Aggregators)

Zhipu AI biedt zelf API’s voor zijn modellen, en je kunt GLM-5 via die API’s aanroepen.

Typische stappen:

- Meld je aan voor een Z.ai/Open BigModel API-account.

- Haal een API-sleutel op via het dashboard.

- Gebruik een OpenAPI-stijl of REST-API-endpoint met de modelnaam (bijv.

glm-5).

(Vergelijkbaar met hoe je GPT-modellen van OpenAI aanroept). - Stel prompts in en stuur HTTP-verzoeken.

👉 De prijspagina van Z.ai toont officiële GLM-5-tokenprijzen zoals:

- ~$1,0 per miljoen inputtokens

- ~$3,2 per miljoen outputtokens

B) API-wrappers van derden ——CometAPI

API’s zoals CometAPI of WaveSpeed verpakken meerdere AI-modellen (OpenAI, Claude, Z.ai etc.) achter één uniforme interface.

- Met diensten zoals CometAPI kun je GLM-modellen aanroepen door de model-ID te wisselen.

(CometAPI ondersteunt momenteel GLM-5/GLM-4.7.) - CometAPI’s glm-5 is geprijsd op 20% van de officiële prijs.

| Gebruikstype | Prijs |

|---|---|

| Inputtokens | ~$0,8 per 1M tokens |

| Outputtokens | ~$2,56 per 1M tokens |

Waarom dit belangrijk is: Je behoudt je bestaande OpenAI-compatibele clientcode en verandert alleen de basis-URL/model-ID.

C) Zelf-hosting via Hugging Face / weights

Er zijn niet-officiële GLM-5-gewichtenrepositories (bijv. versies met de naam glm-5/glm-5-fp8) zichtbaar in de modellijsten van Hugging Face.

Daarmee kun je:

- De modelgewichten downloaden.

- Tools zoals vLLM, SGLang, xLLM, of Transformers gebruiken om lokaal of op je cloud-GPU-vloot te dienen.

Voordelen: maximale controle, geen doorlopende API-kosten.

Nadelen: enorme rekenvereisten — waarschijnlijk meerdere high-end GPU’s en geheugen (enkele honderden GB), waardoor het onpraktisch is op kleine systemen.

Dus — is GLM-5 de moeite waard, en moet je GLM-4.7 behouden?

Kort antwoord (executive summary)

- Als je werk robuust, meerstaps agentisch gedrag, productieklare codegeneratie of systeemniveau-automatisering vereist: GLM-5 is direct het evalueren waard. De architectuur, schaal en tuning prioriteren precies deze uitkomsten.

- Als je kostenefficiënte, high-throughput microservices nodig hebt (korte chat, classificatie, lichtgewicht prompts): GLM-4.7 blijft waarschijnlijk de meest economische keuze. GLM-4.7 behoudt een sterke capaciteiten set tegen aanzienlijk lagere per-tokenkosten in veel aanbiederslijsten en is al beproefd.

Langer antwoord (praktische aanbeveling)

Hanteer een gelaagde modelstrategie: gebruik GLM-4.7 voor alledaagse, hoogvolume-interacties en reserveer GLM-5 voor hoogwaardige engineeringproblemen en agentische orkestratie. Piloteer GLM-5 op een klein productsegment dat lange context, toolingintegratie en codecorrectheid test; meet zowel bespaarde engineeringtijd als incrementele modelkosten. Na verloop van tijd weet je of GLM-5’s capaciteitswinst een bredere migratie rechtvaardigt.

Met CometAPI kun je op elk moment schakelen tussen GLM-4.7 en GLM-5.

Use-cases uit de praktijk waarin GLM-5 uitblinkt

1. Complexe agent-orkestratie

GLM-5’s ontwerpfocus op meerstapsplanning en toolaanroepen maakt het bij uitstek geschikt voor systemen die zoekopdrachten, API-calls en program execution moeten coördineren (bijvoorbeeld: geautomatiseerde onderzoeksassistenten, iteratieve codegeneratoren, of meerstapsklantenserviceagents die databases en externe API’s moeten raadplegen).

2. Langvormige engineering & redeneren over codebases

Wanneer je het model nodig hebt om te analyseren, refactoren of synthese uit te voeren over veel bestanden of een grote codebase, zijn GLM-5’s uitgebreide context en sparse attention directe voordelen — minder faalmodi door afgekorte context en betere consistentie over lange spanwijdtes.

3. Kennisintensieve synthese

Analisten en productteams die complexe rapporten genereren — meersectie onderzoeksbriefings, juridische samenvattingen of regelgevende indieningen — kunnen profiteren van de verbeteringen van het model in stabiele meerstapsredenering en verminderde hallucinaties in door leveranciers gerapporteerde tests.

4. Agentische automatisering voor werkstromen

Teams die automatisering bouwen die meerdere systemen moet orkestreren (bijv. planning + ticketing + deployment-pijplijnen) kunnen GLM-5 gebruiken als centrale planner en uitvoerder, ondersteund door tool-calling-frameworks en veiligheidswrappers.

Conclusie

GLM-5 is een belangrijke release in het snel evoluerende frontier-model-landschap. De nadruk op agentic engineering, verbeterde codering en redenering, en open-weights beschikbaarheid maken het aantrekkelijk voor teams die langetermijn, tool-enabled AI-systemen bouwen. Reële winst in geselecteerde taken en bemoedigende kosten/prestatie-afwegingen — maar kopers moeten GLM-5 evalueren tegen hun specifieke taken en hun eigen gecontroleerde benchmarks uitvoeren voordat ze zich committeren aan productie.

Ontwikkelaars kunnen GLM-5 nu benaderen via CometAPI. Begin met het verkennen van de mogelijkheden van het model in de Playground en raadpleeg de API-guide voor gedetailleerde instructies. Zorg ervoor dat je bent ingelogd bij CometAPI en een API-sleutel hebt verkregen voordat je toegang krijgt. CometAPI biedt een prijs die veel lager ligt dan de officiële prijs om je integratie te vergemakkelijken.

Ready to Go?→ Meld je vandaag nog aan voor glm-5!

Als je meer tips, gidsen en nieuws over AI wilt weten, volg ons op VK, X en Discord!