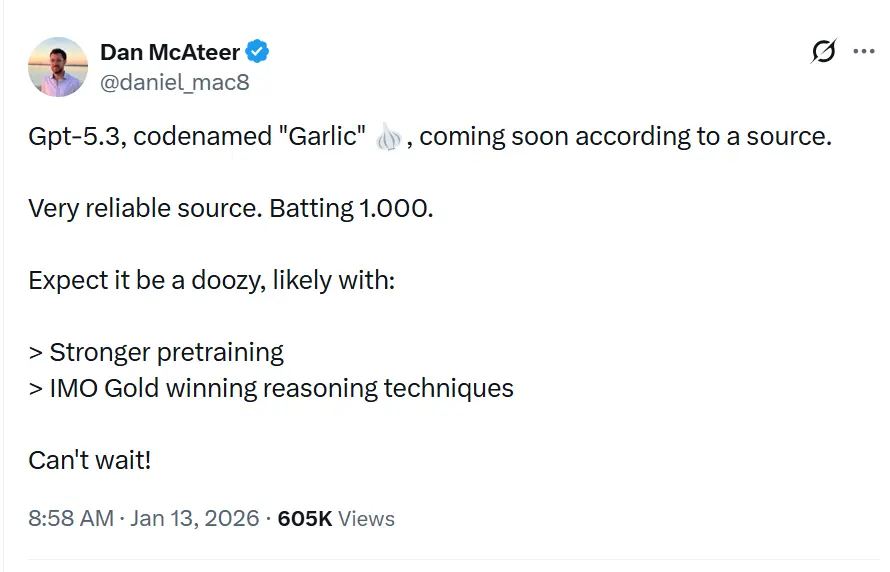

De codenaam GPT-5.3“Garlic” wordt in lekken en rapportages beschreven als een volgende incrementele/iteratieve GPT-5.x-release die bedoeld is om gaten in redeneren, coderen en productprestaties voor OpenAI te dichten als reactie op de concurrentiedruk van Google’s Gemini en Anthropic’s Claude.

OpenAI experimenteert met een dichtere, efficiëntere GPT-5.x-iteratie gericht op sterkere redenering, snellere inferentie en workflows met langere context, in plaats van puur steeds grotere aantallen parameters. Dit is niet zomaar weer een iteratie van de Generative Pre-trained Transformer-serie; het is een strategische tegenaanval. Geboren uit een interne "Code Red" die in december 2025 door CEO Sam Altman werd uitgeroepen, vertegenwoordigt "Garlic" een afwijzing van het "groter is beter"-dogma dat de ontwikkeling van LLM’s een halve decade heeft beheerst. In plaats daarvan zet het alles in op een nieuwe maatstaf: cognitieve dichtheid.

Wat is GPT-5.3 “Garlic”?

GPT-5.3 — codenaam “Garlic” — wordt beschreven als de volgende iteratieve stap in OpenAI’s GPT-5-familie. Bronnen kaderen de leak zo dat Garlic niet een eenvoudige checkpoint of token-aanpassing is, maar een gerichte verfijning van architectuur en training: het doel is om hogere redeneerprestaties, betere meerstappenplanning en verbeterd lang-contextgedrag te extraheren uit een compacter, inferentie-efficiënt model, in plaats van uitsluitend te vertrouwen op ruwe schaal. Dat past bij bredere industrietrends richting “dichte” of “hoog-efficiënte” modelontwerpen.

De naam "Garlic"—een opvallende breuk met de hemelse (Orion) of botanisch-zoete (Strawberry) codenamen uit het verleden—is naar verluidt een bewuste interne metafoor. Net zoals één teentje knoflook een hele schotel krachtiger kan kruiden dan grotere, flauwere ingrediënten, is dit model ontworpen om geconcentreerde intelligentie te leveren zonder de enorme computationele overhead van de reuzen in de industrie.

De "Code Red"-oorsprong

Het bestaan van Garlic kan niet los worden gezien van de existentiële crisis die het heeft doen ontstaan. Eind 2025 bevond OpenAI zich voor het eerst sinds de lancering van ChatGPT in een "defensieve positie". Google’s Gemini 3 had de kroon veroverd voor multimodale benchmarks, en Anthropic’s Claude Opus 4.5 was de facto standaard geworden voor complexe coding en agentische workflows. Als reactie pauzeerde de leiding van OpenAI perifere projecten—waaronder experimenten met advertentieplatforms en uitbreidingen van consumentenagenten—om zich volledig te richten op een model dat een "tactische aanval" op deze concurrenten kon uitvoeren.

Garlic is die aanval. Het is niet ontworpen om het grootste model ter wereld te zijn; het is ontworpen om het slimste te zijn per parameter. Het verenigt de onderzoekslijnen van eerdere interne projecten, met name "Shallotpeat", en integreert bugfixes en pre-trainingsefficiënties die het in staat stellen ver boven zijn gewichtsklasse te presteren.

Wat is de huidige status van de waargenomen iteraties van het GPT-5.3-model?

Midden januari 2026 bevindt GPT-5.3 zich in de laatste fase van interne validatie, een fase die in Silicon Valley vaak wordt omschreven als "hardening". Het model is momenteel zichtbaar in interne logs en is steekproefsgewijs getest door geselecteerde enterprise-partners onder strikte geheimhoudingsverklaringen.

Waargenomen iteraties en integratie van "Shallotpeat"

De weg naar Garlic was niet lineair. Gelekte interne memo’s van Chief Research Officer Mark Chen suggereren dat Garlic eigenlijk een composiet is van twee verschillende onderzoekstrajecten. Aanvankelijk ontwikkelde OpenAI een model met de codenaam "Shallotpeat", bedoeld als directe incrementele update. Tijdens de pre-training van Shallotpeat ontdekten onderzoekers echter een nieuwe methode voor het "comprimeren" van redeneerpatronen—feitelijk het model aanleren om overbodige neurale paden eerder in het trainingsproces af te werpen.

Deze ontdekking leidde tot het schrappen van de standalone Shallotpeat-release. De architectuur werd samengevoegd met de meer experimentele "Garlic"-branch. Het resultaat is een hybride iteratie die de stabiliteit bezit van een volwassen GPT-5-variant, maar de explosieve redeneerefficiëntie van een nieuwe architectuur.

Wanneer kunnen we het releasemoment afleiden?

Het voorspellen van OpenAI-releasedata is berucht moeilijk, maar de "Code Red"-status versnelt de standaardtijdlijnen. Op basis van de convergentie van lekken, vendor-updates en concurrentcycli kunnen we een releasevenster trianguleren.

Primair venster: Q1 2026 (januari - maart)

De consensus onder insiders is een Q1 2026-lancering. De "Code Red" werd in december 2025 uitgeroepen, met de instructie om "zo snel mogelijk" te releasen. Gezien het feit dat het model zich al in check/validatie bevindt (waarbij de "Shallotpeat"-samensmelting de tijdlijn heeft versneld), lijkt een release eind januari of begin februari het meest plausibel.

De "Beta"-uitrol

We kunnen een gefaseerde release zien:

- Eind januari 2026: Een "preview"-release voor geselecteerde partners en ChatGPT Pro-gebruikers (mogelijk onder het label "GPT-5.3 (Preview)").

- Februari 2026: Volledige API-beschikbaarheid.

- Maart 2026: Integratie in de gratis laag van ChatGPT (beperkte aanvragen) om de gratis toegankelijkheid van Gemini te counteren.

3 bepalende functies van GPT-5.3?

Als de geruchten kloppen, zal GPT-5.3 een reeks functies introduceren die bruikbaarheid en integratie prioriteren boven pure generatieve creativiteit. De functieset leest als een wensenlijst voor systeemarchitecten en enterprise-ontwikkelaars.

1. High-Density Pre-Training (EPTE)

Het kroonjuweel van Garlic is zijn Enhanced Pre-Training Efficiency (EPTE).

Traditionele modellen leren door enorme hoeveelheden data te zien en een uitgestrekt netwerk van associaties te creëren. Naar verluidt omvat het trainingsproces van Garlic een "pruning"-fase waarin het model actief informatie condenseert.

- Het resultaat: Een model dat fysiek kleiner is (in termen van VRAM-vereisten) maar de "Wereldkennis" behoudt van een veel groter systeem.

- Het voordeel: Snellere inferentiesnelheden en aanzienlijk lagere API-kosten, waarmee de "intelligentie-naar-kostenverhouding" wordt aangepakt die massale adoptie van modellen als Claude Opus heeft belemmerd.

2. Native agentische redenering

In tegenstelling tot eerdere modellen die "wrappers" of complexe prompt-engineering vereisten om als agenten te functioneren, heeft Garlic native mogelijkheden voor tool-aanroepen.

Het model behandelt API-calls, code-executie en databasequeries als "first-class citizens" in zijn vocabulaire.

- Diepe integratie: Het "kan niet alleen programmeren"; het begrijpt de omgeving van code. Het kan naar verluidt door een mapstructuur navigeren, meerdere bestanden tegelijk bewerken en zijn eigen unittests uitvoeren zonder externe orkestratiescripts.

3. Massieve context- en uitvoervensters

Om te concurreren met het miljoen-tokenvenster van Gemini, zou Garlic worden geleverd met een contextvenster van 400.000 tokens. Hoewel kleiner dan het aanbod van Google, is de cruciale differentiator "Perfecte recall" over dat venster, met gebruik van een nieuw aandachtmechanisme dat het "verlies midden in de context" voorkomt dat gebruikelijk was in modellen uit 2025.

- 128k-uitvoerlimiet: Misschien nog spannender voor ontwikkelaars is de naar verluidt uitgebreide uitvoerlimiet tot 128.000 tokens. Dit zou het model in staat stellen om hele softwarebibliotheken, uitgebreide juridische stukken of volledige novelles in één keer te genereren, waardoor "chunking" overbodig wordt.

4. Drastisch verminderde hallucinaties

Garlic gebruikt een post-trainingsversterkingstechniek die gericht is op "epistemische bescheidenheid"—het model wordt rigoureus getraind om te weten wat het niet weet. Interne tests tonen een hallucinatiegraad die aanzienlijk lager ligt dan GPT-5.0, waardoor het geschikt is voor sectoren met hoge inzet, zoals biomedische wetenschap en recht.

Hoe verhoudt het zich tot concurrenten zoals Gemini en Claude 4.5?

Het succes van Garlic zal niet in isolatie worden gemeten, maar in directe vergelijking met de twee titanen die momenteel de arena domineren: Google’s Gemini 3 en Anthropic’s Claude Opus 4.5.

GPT-5.3 “Garlic” vs. Google Gemini 3

De strijd tussen schaal en dichtheid.

- Gemini 3: Momenteel het "alles-in-één" model. Het domineert in multimodale begrip (video, audio, native beeldgeneratie) en heeft een effectief oneindig contextvenster. Het is het beste model voor "rommelige" data uit de echte wereld.

- GPT-5.3 Garlic: Kan niet concurreren met de ruwe multimodale breedte van Gemini. In plaats daarvan valt het Gemini aan op Redeneringszuiverheid. Voor pure tekstgeneratie, codelogica en complexe instructieopvolging wil Garlic scherper zijn en minder geneigd tot "weigering" of afdwalen.

- Het oordeel: Als je een video van 3 uur moet analyseren, gebruik je Gemini. Als je de backend voor een bankapp moet schrijven, gebruik je Garlic.

GPT-5.3 “Garlic” vs. Claude Opus 4.5

De strijd om de ziel van de ontwikkelaar.

- Claude Opus 4.5: Gelanceerd eind 2025, dit model won ontwikkelaars voor zich met zijn "warmte" en "vibes." Het staat bekend om het schrijven van schone, menselijk leesbare code en het volgen van systeeminstructies met militaire precisie. Het is echter duur en traag.

- GPT-5.3 Garlic: Dit is het directe doelwit. Garlic wil de codeervaardigheid van Opus 4.5 evenaren, maar met 2x de snelheid en 0,5x de kosten. Door "High-Density Pre-Training" wil OpenAI intelligentie op Opus-niveau bieden tegen een budget op Sonnet-niveau.

- Het oordeel: De "Code Red" werd specifiek getriggerd door de dominantie van Opus 4.5 in coderen. Het succes van Garlic hangt volledig af van de vraag of het ontwikkelaars kan overtuigen hun API-sleutels terug te switchen naar OpenAI. Als Garlic net zo goed kan coderen als Opus maar sneller draait, verschuift de markt van de ene op de andere dag.

Takeway

Vroege interne builds van Garlic overtreffen Google’s Gemini 3 en Anthropic’s Opus 4.5 al in specifieke, waardevolle domeinen:

- Coderingsvaardigheid: In interne "harde" benchmarks (buiten de standaard HumanEval) vertoont Garlic een lagere neiging om vast te lopen in "logische lussen" vergeleken met GPT-4.5.

- Redeneringsdichtheid: Het model heeft minder tokens aan "denken" nodig om tot correcte conclusies te komen, een directe tegenstelling tot de "chain-of-thought"-zwaarte van de o1 (Strawberry)-serie.

| Metric | GPT-5.3 (Garlic) | Google Gemini 3 | Claude 4.5 |

|---|---|---|---|

| Reasoning (GDP-Val) | 70.9% | 53.3% | 59.6% |

| Coderen (HumanEval+) | 94.2% | 89.1% | 91.5% |

| Contextvenster | 400K Tokens | 2M Tokens | 200K Tokens |

| Inferentiesnelheid | Ultrasnel | Gemiddeld | Snel |

Conclusie

“Garlic” is een actieve en plausibele geruchtenstroom: een gerichte OpenAI-engineeringtrack die redeneringsdichtheid, efficiëntie en tooling in de echte wereld prioriteert. De opkomst ervan moet worden gezien in de context van een versnellende wapenwedloop tussen modelproviders (OpenAI, Google, Anthropic) — een waarin de strategische prijs niet alleen ruwe capaciteit is, maar bruikbare capaciteit per dollar en per milliseconde latentie.

Als je geïnteresseerd bent in dit nieuwe model, volg dan CometAPI. Het biedt altijd de nieuwste en beste AI-modellen tegen een betaalbare prijs.

Ontwikkelaars hebben nu toegang tot GPT-5.2, Gemini 3, Claude 4.5 via CometAPI. Om te beginnen, verken de modelmogelijkheden van CometAPI in de Playground en raadpleeg de API-gids voor gedetailleerde instructies. Zorg er vóór toegang voor dat je bent ingelogd bij CometAPI en de API-sleutel hebt verkregen. CometAPI biedt een prijs die veel lager is dan de officiële prijs om je te helpen integreren.

Klaar om te beginnen?→ Meld je vandaag nog aan voor CometAPI!

Als je meer tips, gidsen en nieuws over AI wilt weten, volg ons dan op VK, X en Discord!