DeepSeek heeft een experimenteel model genoemd DeepSeek-V3.2-Exp on 29 september 2025, waarbij een nieuw sparse-attentionmechanisme (DeepSeek Sparse Attention, of DSA) werd geïntroduceerd dat mikt op veel lagere inferentiekosten voor workloads met een lange context. Tegelijkertijd verlaagde het bedrijf de API-prijzen met ongeveer de helft. Deze handleiding legt uit wat het model is, de architectuur en functies, hoe u toegang krijgt tot de API en deze kunt gebruiken (met codevoorbeelden), hoe deze zich verhoudt tot eerdere DeepSeek-modellen en hoe u de reacties in productie kunt parseren en verwerken.

Wat is DeepSeek-V3.2-Exp?

DeepSeek-V3.2-Exp is een experimentele iteratie in DeepSeeks V3-traject. De release – aangekondigd eind september 2025 – wordt gepositioneerd als een tussenstap die architectuuroptimalisaties valideert voor langere contextlengtes, in plaats van als een grote sprong voorwaarts in pure nauwkeurigheid. De belangrijkste innovatie is DeepSeek Sparse Attention (DSA), een aandachtspatroon dat selectief aandacht besteedt aan delen van een lange invoer om de reken- en geheugenkosten te verlagen en tegelijkertijd de uitvoerkwaliteit vergelijkbaar te houden met die van V3.1-Terminus.

Waarom het in de praktijk belangrijk is:

- Kosten voor taken met een lange context: DSA richt zich op de kwadratische kosten van aandacht, waardoor de rekenkracht voor zeer lange invoer (denk aan het ophalen van meerdere documenten, lange transcripten en grote spelwerelden) wordt verminderd. De kosten voor API-gebruik zijn aanzienlijk lager voor typische use cases met lange contexten.

- Compatibiliteit en toegankelijkheid: De DeepSeek API maakt gebruik van een OpenAI-compatibel aanvraagformaat, waardoor veel bestaande OpenAI SDK-workflows snel kunnen worden aangepast.

Wat zijn de belangrijkste kenmerken en architectuur van DeepSeek V3.2-Exp?

Wat is DeepSeek Sparse Attention (DSA) en hoe werkt het?

DSA is een fijnmazige, spaarzame aandacht Schema ontworpen om selectief aandacht te besteden aan tokens in plaats van dichte aandacht te berekenen over de volledige context. Kortom:

- Het model selecteert dynamisch subsets van tokens die op elke laag of elk blok moeten worden behandeld, waardoor FLOP's bij lange invoerlengtes worden verminderd.

- De selectie is ontworpen om de ‘belangrijke’ context voor redeneertaken te behouden, door gebruik te maken van een combinatie van geleerde selectiebeleidsregels en routeringsheuristiek.

DSA is de belangrijkste innovatie in V3.2-Exp, bedoeld om de outputkwaliteit dicht bij die van dense-attention-modellen te houden en tegelijkertijd de inferentiekosten te verlagen, vooral wanneer de contextlengte toeneemt. De release notes en de modelpagina benadrukken dat de trainingsconfiguraties zijn afgestemd op V3.1-Terminus, zodat verschillen in benchmarkstatistieken het mechanisme van de sparse-attention weerspiegelen in plaats van een algehele trainingswijziging.

Welke andere architectuur/functies worden meegeleverd met V3.2-Exp?

- Hybride modi (denken vs. niet-denken): DeepSeek maakt twee model-ID's beschikbaar:

deepseek-chat(niet-denkende / snellere antwoorden) endeepseek-reasoner(denkmodus die de inhoud van de denkketen of tussenliggende redeneringen kan blootleggen). Met deze modi kunnen ontwikkelaars kiezen tussen snelheid en transparantie van expliciete redeneringen. - Zeer grote contextvensters: De V3.x-familie ondersteunt zeer grote contexten (de V3-lijn biedt DeepSeek 128K-contextopties in huidige updates), waardoor deze geschikt is voor workflows met meerdere documenten, lange logboeken en agenten met een hoge kennisbehoefte.

- JSON-uitvoer en strikte functieaanroep (bèta): De API ondersteunt een

response_formatobject dat JSON-uitvoer kan forceren (en een strikte bèta voor functieaanroepen). Dit is handig wanneer u voorspelbare, door machines te parseren uitvoer nodig hebt voor toolintegratie. - Streaming- en redeneringstokens: De API ondersteunt streamingreacties en – voor redeneermodellen – afzonderlijke tokens voor redeneerinhoud (vaak blootgesteld onder

reasoning_content), waarmee u de tussenstappen van het model kunt weergeven of controleren.

Hoe krijg ik toegang tot de DeepSeek-V3.2-Exp API en hoe gebruik ik deze via CometAPI?

DeepSeek behoudt opzettelijk een API-formaat in OpenAI-stijl, zodat bestaande OpenAI SDK's of compatibele tools opnieuw kunnen worden getarget met een andere basis-URL. Ik raad aan om CometAPI te gebruiken voor toegang tot DeepSeek-V3.2-Exp, omdat het een lage prijs heeft en een multimodale aggregatiegateway is. DeepSeek maakt modelnamen beschikbaar die overeenkomen met het V3.2-Exp-gedrag. Voorbeelden:

DeepSeek-V3.2-Exp-thinking — redeneer-/denkmodus toegewezen aan V3.2-Exp.

DeepSeek-V3.2-Exp-thinking — niet-redenerende/chat-modus toegewezen aan V3.2-Exp.

Hoe kan ik mij authenticeren en wat is de basis-URL?

- Krijg een API-sleutel via de CometAPI-ontwikkelaarsconsole (door u aan te melden op hun site).

- Basis-URL: (

https://api.cometapi.comorhttps://api.cometapi.com/v1voor OpenAI-compatibele paden). Dankzij de OpenAI-compatibiliteit kunnen veel OpenAI SDK's met kleine wijzigingen naar DeepSeek worden verwezen.

Welke model-ID's moet ik gebruiken?

DeepSeek-V3.2-Exp-thinking— denkmodus, legt de inhoud van de gedachteketen/redenering bloot. Beide zijn in de laatste release notes geüpgraded naar V3.2-Exp.DeepSeek-V3.2-Exp-nothinking— niet-nadenkend, snellere reacties, typisch chat-/aanvullingsgebruik.

Voorbeeld: eenvoudig curl-verzoek (chatvoltooiing)

curl -s https://api.cometapi.com/v1/chat/completions \

-H "Authorization: Bearer $cometapi_API_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "deepseek-v3.2-exp",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Summarize the attached meeting transcript in 3 bullet points."}

],

"max_tokens": 512,

"stream": false

}'

Voorbeeld: Python (OpenAI-compatibel clientpatroon)

Dit patroon werkt nadat een OpenAI-client is doorverwezen naar de basis-URL van CometAPI (of via de SDK van CometAPI). Het onderstaande voorbeeld volgt de stijl van DeepSeek:

import os

import requests

API_KEY = os.environ

url = "https://api.deepseek.com/v1/chat/completions"

headers = {

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

}

payload = {

"model": "deepseek-v3.2-exp",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Extract action items from the following notes..."}

],

"max_tokens": 800

}

r = requests.post(url, headers=headers, json=payload)

r.raise_for_status()

print(r.json())

Er is geen speciale SDK vereist — maar als u de SDK van OpenAI al gebruikt, kunt u deze vaak opnieuw configureren base_url en api_key en behoud dezelfde oproeppatronen.

Geavanceerd gebruik: redeneren mogelijk maken of reasoning_content

Als u de interne gedachteketen van het model nodig hebt (voor auditing, distillatie of het extraheren van tussenstappen), schakel dan over naar DeepSeek-V3.2-Exp-thinking. De reasoning_content veld (en gerelateerde stroom of tokens) is beschikbaar in het antwoord voor de redeneermodus; de API-documentatie biedt reasoning_content Als antwoordveld om de gegenereerde CoT te inspecteren vóór het definitieve antwoord. Let op: het blootstellen van deze tokens kan de facturering beïnvloeden, aangezien ze deel uitmaken van de modeluitvoer.

Streaming en gedeeltelijke updates

- Gebruik

"stream": truebij verzoeken om tokendelta's te ontvangen via SSE (server-sent events). stream_optionseninclude_usageHiermee kunt u instellen hoe en wanneer gebruiksmetadata wordt weergegeven tijdens een stream (handig voor incrementele gebruikersinterfaces).

Hoe verhoudt DeepSeek-V3.2-Exp zich tot eerdere DeepSeek-modellen?

V3.2-Exp versus V3.1-Terminus

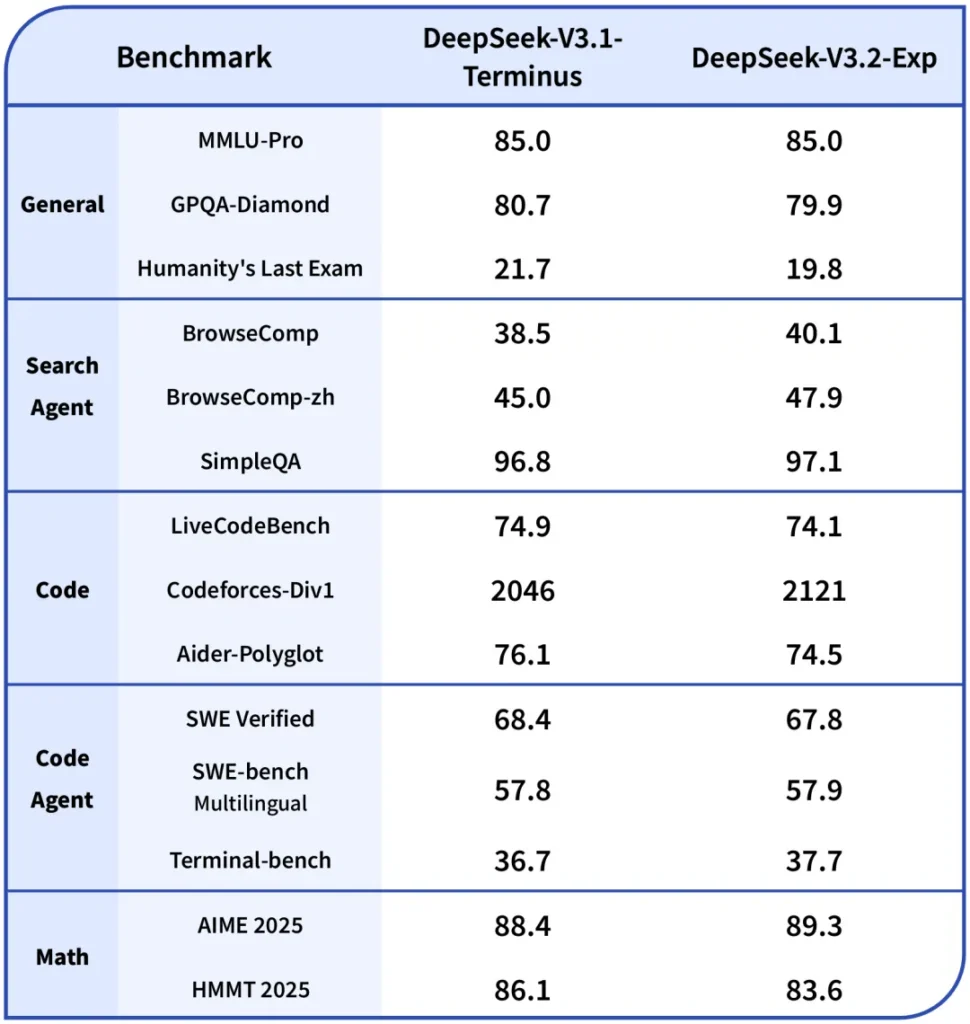

- Primair verschil: V3.2-Exp introduceert het sparse-attentionmechanisme om de rekenkracht voor lange contexten te verminderen, terwijl de rest van het trainingsrecept afgestemd blijft op V3.1. Dit stelde DeepSeek in staat om een duidelijkere vergelijking te maken van de efficiëntiewinsten. ()

- benchmarks: Uit openbare notities blijkt dat V3.2-Exp ongeveer gelijkwaardig presteert als V3.1 bij veel redeneer-/coderingstaken, terwijl het aanzienlijk goedkoper is bij lange contexten. Houd er rekening mee dat specifieke taken nog steeds kleine regressies kunnen hebben, afhankelijk van hoe aandachtsspaarzaamheid samengaat met de vereiste tokeninteracties.

V3.2-Exp vs R1 / Oudere releases

- R1- en V3-lijnen volgen verschillende ontwerpdoelen (R1 richtte zich historisch gezien op verschillende architecturale afwegingen en multimodale capaciteiten in sommige branches). V3.2-Exp is een verfijning in de V3-familie, gericht op lange contexten en doorvoer. Als uw werklast zwaar ligt bij benchmarks voor ruwe nauwkeurigheid in één draai, kunnen de verschillen bescheiden zijn; als u met pipelines met meerdere documenten werkt, is het kostenprofiel van V3.2-Exp waarschijnlijk aantrekkelijker.

Waar is Claude Sonnet 4.5 te vinden?

CometAPI is een uniform API-platform dat meer dan 500 AI-modellen van toonaangevende aanbieders – zoals de GPT-serie van OpenAI, Gemini van Google, Claude, Midjourney en Suno van Anthropic – samenvoegt in één, gebruiksvriendelijke interface voor ontwikkelaars. Door consistente authenticatie, aanvraagopmaak en responsverwerking te bieden, vereenvoudigt CometAPI de integratie van AI-mogelijkheden in uw applicaties aanzienlijk. Of u nu chatbots, beeldgenerators, muziekcomponisten of datagestuurde analysepipelines bouwt, met CometAPI kunt u sneller itereren, kosten beheersen en leveranciersonafhankelijk blijven – en tegelijkertijd profiteren van de nieuwste doorbraken in het AI-ecosysteem.

Ontwikkelaars hebben toegang tot DeepSeek V3.2 Exp via CometAPI, de nieuwste modelversie wordt altijd bijgewerkt met de officiële website. Om te beginnen, verken de mogelijkheden van het model in de Speeltuin en raadpleeg de API-gids voor gedetailleerde instructies. Zorg ervoor dat u bent ingelogd op CometAPI en de API-sleutel hebt verkregen voordat u toegang krijgt. KomeetAPI bieden een prijs die veel lager is dan de officiële prijs om u te helpen integreren.

Klaar om te gaan?→ Meld u vandaag nog aan voor CometAPI !

Conclusie

DeepSeek-V3.2-Exp is een pragmatische experimentele release die gericht is op het goedkoper en haalbaarder maken van werk met lange contexten, met behoud van de outputkwaliteit van V3-klasse. Voor teams die werken met lange documenten, transcripties of redeneringen met meerdere documenten is het de moeite waard om te testen: de API volgt een interface in OpenAI-stijl die integratie eenvoudig maakt, en benadrukt zowel het DSA-mechanisme als zinvolle prijsverlagingen die de economische berekening van bouwen op schaal veranderen. Zoals bij elk experimenteel model zijn uitgebreide evaluatie, instrumentatie en gefaseerde uitrol essentieel.