DeepSeek-V3.1 is het nieuwste hybride redeneermodel van DeepSeek dat zowel een snelle "niet-denkende" chatmodus als een meer doelbewuste "denkende/redenerende" modus ondersteunt, lange (tot 128K) context, gestructureerde outputs en functieaanroepen biedt, en direct toegankelijk is via DeepSeeks OpenAI-compatibele API, via een Anthropic-compatibel eindpunt of via CometAPI. Hieronder leg ik uit wat het model inhoudt, wat de benchmark en kosten zijn, geavanceerde functies (functieaanroepen, JSON-outputs, redeneermodus) en geef ik concrete end-to-end codevoorbeelden: directe DeepSeek REST-aanroepen (curl / Node / Python), gebruik van Anthropic-clients en aanroepen via CometAPI.

Wat is DeepSeek-V3.1 en wat is er nieuw in deze release?

DeepSeek-V3.1 is de meest recente release in de DeepSeek V3-familie: een reeks van grote taalmodellen met een hoge capaciteit en een mix van experts die een hybride inferentieontwerp met twee operationele “modi” — een snelle niet-denkende chat modus en een denkend / redenerend Modus die sporen van gedachteketens kan blootleggen voor moeilijkere redeneertaken en het gebruik van agents/tools. De release legt de nadruk op snellere "denk"-latentie, verbeterde tool/agent-mogelijkheden en langere contextverwerking voor workflows op documentschaal.

Belangrijkste praktische tips:

- Twee werkingsmodi:

deepseek-chatvoor doorvoer en kosten,deepseek-reasoner(een redeneermodel) als u een gedachteketen wilt of een hogere redeneerbetrouwbaarheid. - Verbeterde agent-/toolverwerking en tokenizer-/contextverbeteringen voor lange documenten.

- Contextlengte: tot ~128K tokens (maakt lange documenten, codebases en logs mogelijk).

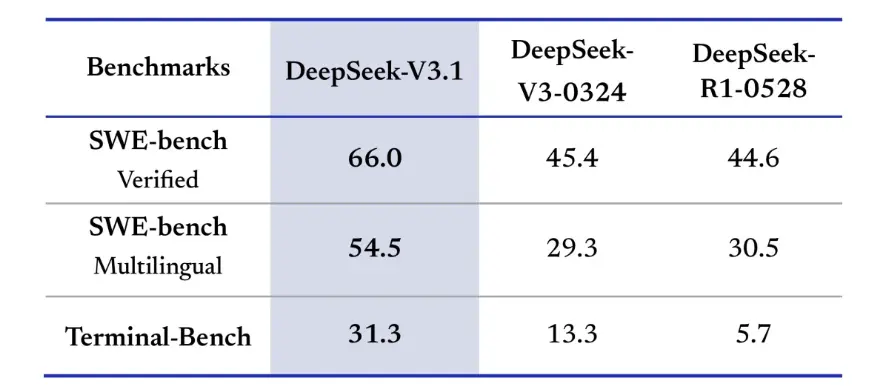

Benchmark Doorbraak

DeepSeek-V3.1 liet significante verbeteringen zien in real-world codeeruitdagingen. In de SWE-bench Verified-evaluatie, die meet hoe vaak het model GitHub-problemen oplost om ervoor te zorgen dat unit tests slagen, behaalde V3.1 een succespercentage van 66%, vergeleken met 45% voor zowel V3-0324 als R1. In de meertalige versie loste V3.1 54.5% van de problemen op, bijna het dubbele van het succespercentage van ongeveer 30% van de andere versies. In de Terminal-Bench-evaluatie, die test of het model taken succesvol kan voltooien in een live Linux-omgeving, slaagde DeepSeek-V3.1 in 31% van de taken, vergeleken met respectievelijk 13% en 6% voor de andere versies. Deze verbeteringen tonen aan dat DeepSeek-V3.1 betrouwbaarder is in het uitvoeren van code en het werken in real-world toolomgevingen.

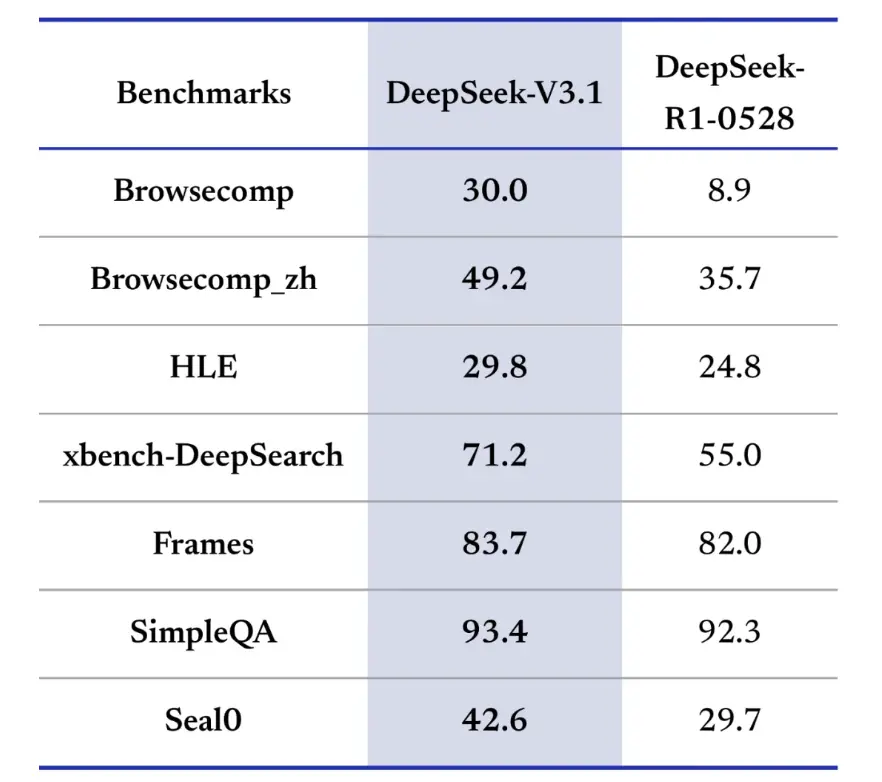

Benchmarks voor informatieopvraging geven DeepSeek-V3.1 ook een voorsprong bij browsen, zoeken en het beantwoorden van vragen. In de BrowseComp-evaluatie, waarbij navigeren en het ophalen van antwoorden van een webpagina vereist is, beantwoordde V3.1 30% van de vragen correct, vergeleken met 9% voor R1. In de Chinese versie behaalde DeepSeek-V3.1 een nauwkeurigheid van 49%, vergeleken met 36% voor R1. Op het Hard Language Examen (HLE) presteerde V3.1 licht beter dan R1, met een nauwkeurigheid van respectievelijk 30% en 25%. Bij diepgaande zoektaken zoals xbench-DeepSearch, waarbij informatie uit verschillende bronnen moet worden gesynthetiseerd, scoorde V3.1 71%, tegenover 1% voor R55. DeepSeek-V3.1 liet ook een kleine maar consistente voorsprong zien op benchmarks zoals (gestructureerd redeneren), SimpleQA (feitelijke vraagbeantwoording) en Seal0 (domeinspecifieke vraagbeantwoording). Over het geheel genomen presteerde V3.1 aanzienlijk beter dan R1 op het gebied van informatieopvraging en eenvoudige vraagbeantwoording.

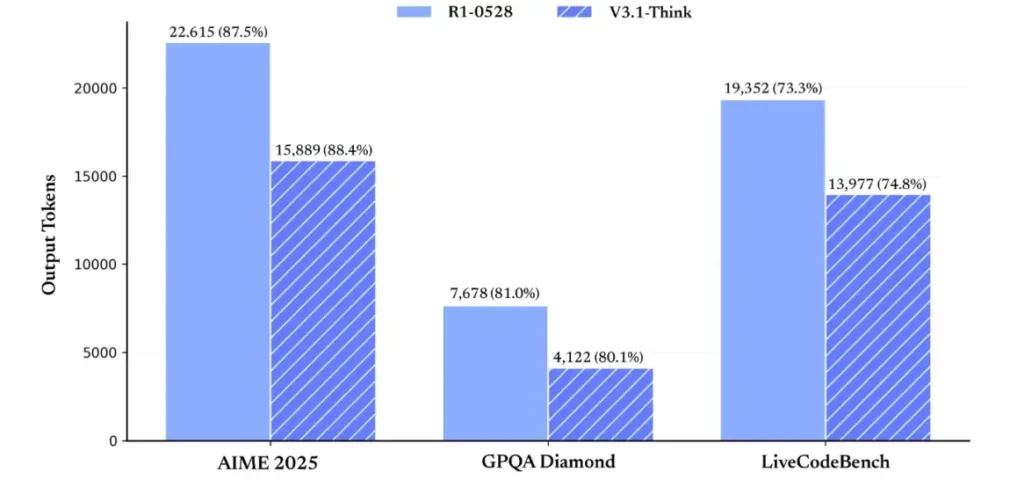

Wat betreft de efficiëntie van redeneren, tonen de resultaten van het tokengebruik de effectiviteit ervan aan. Op AIME 2025 (een moeilijk wiskunde-examen) behaalde V3.1-Think een nauwkeurigheid die vergelijkbaar was met of iets hoger was dan R1 (88.4% versus 87.5%), maar gebruikte ongeveer 30% minder tokens. Op GPQA Diamond (een multidomein-examen voor masterstudenten) waren de twee modellen bijna gelijk (80.1% versus 81.0%), maar gebruikte V3.1 bijna de helft van de tokens als R1. Op de LiveCodeBench-benchmark, die coderedenering beoordeelt, was V3.1 niet alleen nauwkeuriger (74.8% versus 73.3%), maar ook beknopter. Dit toont aan dat V3.1-Think gedetailleerde redeneringen kan leveren zonder omslachtigheid.

Al met al vertegenwoordigt V3.1 een aanzienlijke generatiesprong ten opzichte van V3-0324. Vergeleken met R1 behaalde V3.1 een hogere nauwkeurigheid in bijna elke benchmark en was het effectiever bij zware redeneertaken. De enige benchmark waar R1 een vergelijkbare prestatie leverde, was GPQA, maar dan tegen bijna het dubbele van de kosten.

Hoe krijg ik een API-sleutel en maak ik een ontwikkelingsaccount aan?

Stap 1: Meld u aan en maak een account aan

- Ga naar de ontwikkelaarsportal van DeepSeek (DeepSeek-documentatie/console). Maak een account aan met uw e-mail- of SSO-provider.

- Voer alle identiteitscontroles uit en stel de facturering in die het portaal vereist.

Stap 2: Maak een API-sleutel

- Ga in het dashboard naar API Keys → Sleutel makenGeef uw sleutel een naam (bijv.

dev-local-01). - Kopieer de sleutel en bewaar deze in een veilige geheimbeheerder (zie onderstaande aanbevolen productiepraktijken).

Tip: Sommige gateways en routers van derden (bijvoorbeeld CometAPI) laten u één gatewaysleutel gebruiken om via hen toegang te krijgen tot DeepSeek-modellen. Dit is handig voor redundantie met meerdere providers (zie de DeepSeek V3.1-API sectie).

Hoe stel ik mijn ontwikkelomgeving in (Linux/macOS/Windows)?

Dit is een eenvoudige, reproduceerbare opstelling voor Python en Node.js die werkt voor DeepSeek (OpenAI-compatibele eindpunten), CometAPI en Anthropic.

Voorwaarden

- Python 3.10+ (aanbevolen), pip, virtualenv.

- Node.js 18+ en npm/yarn.

- krul (voor snelle tests).

Python-omgeving (stap voor stap)

- Maak een projectmap:

mkdir deepseek-demo && cd deepseek-demo

python -m venv .venv

source .venv/bin/activate # macOS / Linux

# .venv\Scripts\activate # Windows PowerShell

- Minimale pakketten installeren:

pip install --upgrade pip

pip install requests

# Optional: install an OpenAI-compatible client if you prefer one:

pip install openai

- Sla uw API-sleutel op in omgevingsvariabelen (nooit vastleggen):

export DEEPSEEK_KEY="sk_live_xxx"

export CometAPI_KEY="or_xxx"

export ANTHROPIC_KEY="anthropic_xxx"

(Windows PowerShell gebruikt $env:DEEPSEEK_KEY = "…")

Node-omgeving (stap voor stap)

- Initialiseren:

mkdir deepseek-node && cd deepseek-node

npm init -y

npm install node-fetch dotenv

- Maak een

.envfile:

DEEPSEEK_KEY=sk_live_xxx

CometAPI_KEY=or_xxx

ANTHROPIC_KEY=anthropic_xxx

Hoe roep ik DeepSeek-V3.1 rechtstreeks aan? Stapsgewijze codevoorbeelden.

De API van DeepSeek is OpenAI-compatibel. Hieronder vindt u: copy-paste voorbeelden: curl, Python (aanvragen en openai SDK-stijl) en Node.

Stap 1: Eenvoudig krulvoorbeeld

curl https://api.deepseek.com/v1/chat/completions \

-H "Authorization: Bearer $DEEPSEEK_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "deepseek-chat-v3.1",

"messages": [

{"role":"system","content":"You are a concise engineering assistant."},

{"role":"user","content":"Give a 5-step secure deployment checklist for a Django app."}

],

"max_tokens": 400,

"temperature": 0.0,

"reasoning_enabled": true

}'

Opmerkingen: reasoning_enabled Schakelt de Think-modus in (leveranciersvlag). De exacte vlagnaam kan per provider verschillen; raadpleeg de modeldocumentatie.

Stap 2: Python (aanvragen) met eenvoudige telemetrie

import os, requests, time, json

API_KEY = os.environ

URL = "https://api.deepseek.com/v1/chat/completions"

payload = {

"model": "deepseek-chat-v3.1",

"messages": [

{"role": "system", "content": "You are a helpful coding assistant."},

{"role": "user", "content": "Refactor this Flask function to be testable: ..."}

],

"max_tokens": 600,

"temperature": 0.1,

"reasoning_enabled": True

}

start = time.time()

r = requests.post(URL, headers={

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

}, json=payload, timeout=60)

elapsed = time.time() - start

print("Status:", r.status_code, "Elapsed:", elapsed)

data = r.json()

print(json.dumps(data, indent=2))

CometAPI: volledig gratis toegang tot DeepSeek V3.1

Voor ontwikkelaars die direct toegang willen zonder registratie, biedt CometAPI een aantrekkelijk alternatief voor DeepSeek V3.1 (modelnaam: deepseek-v3-1-250821; deepseek-v3.1). Deze gateway-service aggregeert meerdere AI-modellen via een uniforme API, biedt toegang tot DeepSeek en andere voordelen, zoals automatische failover, gebruiksanalyses en vereenvoudigde facturering tussen providers.

Maak eerst een CometAPI-account aan op https://www.cometapi.com/—Het hele proces duurt slechts twee minuten en vereist alleen verificatie van uw e-mailadres. Nadat u bent ingelogd, genereert u een nieuwe sleutel in het gedeelte 'API-sleutel'. https://www.cometapi.com/ biedt gratis credits voor nieuwe accounts en 20% korting op de officiële API-prijs.

Technische implementatie vereist minimale codewijzigingen. Wijzig uw API-eindpunt eenvoudig van een directe DeepSeek-URL naar de CometAPI-gateway.

Let op: De API ondersteunt streaming (

stream: true),max_tokens, temperatuur, stopsequenties en functies voor het aanroepen van functies die vergelijkbaar zijn met andere OpenAI-compatibele API's.

Hoe kan ik DeepSeek aanroepen met Anthropic SDK's?

DeepSeek biedt een Anthropic-compatibel eindpunt, zodat u Anthropc SDK's of Claude Code-tools opnieuw kunt gebruiken door de SDK naar https://api.deepseek.com/anthropic en de modelnaam instellen op deepseek-chat (of deepseek-reasoner (waar ondersteund).

DeepSeek-model aanroepen via Anthropic API

Installeer de Anthropic SDK: pip install anthropic. Configureer uw omgeving:

export ANTHROPIC_BASE_URL=https://api.deepseek.com/anthropic

export ANTHROPIC_API_KEY=YOUR_DEEPSEEK_KEY

Maak een bericht:

import anthropic

client = anthropic.Anthropic()

message = client.messages.create(

model="deepseek-chat",

max_tokens=1000,

system="You are a helpful assistant.",

messages=[

{

"role": "user",

"content": [

{

"type": "text",

"text": "Hi, how are you?"

}

]

}

]

)

print(message.content)

DeepSeek gebruiken in Claude Code

Installatie: npm install -g @anthropic-ai/claude-code. Configureer uw omgeving:

export ANTHROPIC_BASE_URL=https://api.deepseek.com/anthropic

export ANTHROPIC_AUTH_TOKEN=${YOUR_API_KEY}

export ANTHROPIC_MODEL=deepseek-chat

export ANTHROPIC_SMALL_FAST_MODEL=deepseek-chat

Ga naar de projectmap en voer Claude-code uit:

cd my-project

claude

Gebruik DeepSeek in Claude Code via CometAPI

CometAPI ondersteunt Claude Code. Vervang na de installatie, bij het configureren van de omgeving, eenvoudig de basis-URL door https://www.cometapi.com/console/ en de sleutel door de sleutel van CometAPI om het DeepSeek-model van CometAPI in Claude Code te gebruiken.

# Navigate to your project folder cd your-project-folder

# Set environment variables (replace sk-... with your actual token)

export ANTHROPIC_AUTH_TOKEN=sk-...

export ANTHROPIC_BASE_URL=https://www.cometapi.com/console/

# Start Claude Code

claude

Opmerkingen:

- DeepSeek brengt niet-ondersteunde antropische modelnamen in kaart

deepseek-chat. - De antropische compatibiliteitslaag ondersteunt

system,messages,temperature, streaming, stopsequenties en denkarrays.

Wat zijn concrete, beste productiepraktijken (beveiliging, kosten, betrouwbaarheid)?

Hieronder vindt u aanbevolen productiepatronen die van toepassing zijn op DeepSeek of ander LLM-gebruik met een hoog volume.

Geheimen en identiteit

- Bewaar API-sleutels in een geheime manager (gebruik geen

.env(in prod). Roteer de sleutels regelmatig en maak sleutels per service met de minste rechten. - Gebruik aparte projecten/accounts voor dev/staging/prod.

Snelheidslimieten en nieuwe pogingen

- Implementeren exponentiële uitstel op HTTP 429/5xx met jitter. Beperk het aantal nieuwe pogingen (bijv. 3).

- Gebruik idempotentiesleutels voor aanvragen die mogelijk herhaald worden.

Python-voorbeeld — opnieuw proberen met backoff

import time, random, requests

def post_with_retries(url, headers, payload, attempts=3):

for i in range(attempts):

r = requests.post(url, json=payload, headers=headers, timeout=60)

if r.status_code == 200:

return r.json()

if r.status_code in (429, 502, 503, 504):

backoff = (2 ** i) + random.random()

time.sleep(backoff)

continue

r.raise_for_status()

raise RuntimeError("Retries exhausted")

Kostenbeheer

- Beperken

max_tokensen voorkom dat u per ongeluk enorme uitvoerhoeveelheden opvraagt. - Cachemodelreacties waar van toepassing (vooral bij herhaalde prompts). DeepSeek maakt expliciet onderscheid tussen cache hit en miss in de prijsstelling — caching bespaart geld.

- Gebruik

deepseek-chatvoor routinematige kleine antwoorden; reserveerdeepseek-reasonervoor gevallen waarbij CoT echt nodig is (duurder).

Observeerbaarheid en logging

- Registreer alleen metadata over verzoeken in platte tekst (prompt hashes, tokenaantallen, latenties). Vermijd het registreren van volledige gebruikersgegevens of gevoelige content. Sla verzoek-/antwoord-ID's op voor ondersteuning en afstemming van facturering.

- Houd het tokengebruik per aanvraag bij en maak budgettering/waarschuwingen over kosten zichtbaar.

Veiligheid en hallucinatiecontroles

- Gebruik tool-uitvoer en deterministische validatoren voor alles wat met de veiligheid te maken heeft (financieel, juridisch, medisch).

- Gebruik voor gestructureerde uitkomsten

response_format+JSON-schema en valideer uitvoer voordat u onomkeerbare acties onderneemt.

Implementatiepatronen

- Voer modelaanroepen uit vanuit een speciaal werkproces om gelijktijdigheid en wachtrijen te beheren.

- Besteed zware taken uit aan asynchrone werknemers (Celery-, Fargate-taken, Cloud Run-taken) en reageer op gebruikers met voortgangsindicatoren.

- Bij extreme latentie-/doorvoerbehoeften moet u rekening houden met SLA's van providers en met de vraag of u zelf hosting kiest of gebruikmaakt van versnellers van providers.

Slotnota

DeepSeek-V3.1 is een pragmatisch, hybride model, ontworpen voor zowel snelle chat als complexe agenttaken. De OpenAI-compatibele API-vorm maakt migratie voor veel projecten eenvoudig, terwijl de Anthropic- en CometAPI-compatibiliteitslagen het flexibel maken voor bestaande ecosystemen. Benchmarks en communityrapporten laten veelbelovende kosten-prestatieverhoudingen zien. Maar valideer het, net als bij elk nieuw model, op uw echte workloads (prompting, functieaanroepen, veiligheidscontroles, latentie) voordat u het volledig in productie neemt.

Op CometAPI kunt u het veilig uitvoeren en ermee communiceren via een OpenAI-compatibele API of gebruiksvriendelijke speelplaats, zonder snelheidslimieten.

👉 Implementeer nu DeepSeek-V3.1 op CometAPI!

Waarom CometAPI gebruiken?

- Provider-multiplexing: van provider wisselen zonder dat de code herschreven hoeft te worden.

- Geünificeerde facturering/statistieken: als je meerdere modellen via CometAPI routeert, krijg je één integratieoppervlak.

- Modelmetagegevens: bekijk contextlengte en actieve parameters per modelvariant.