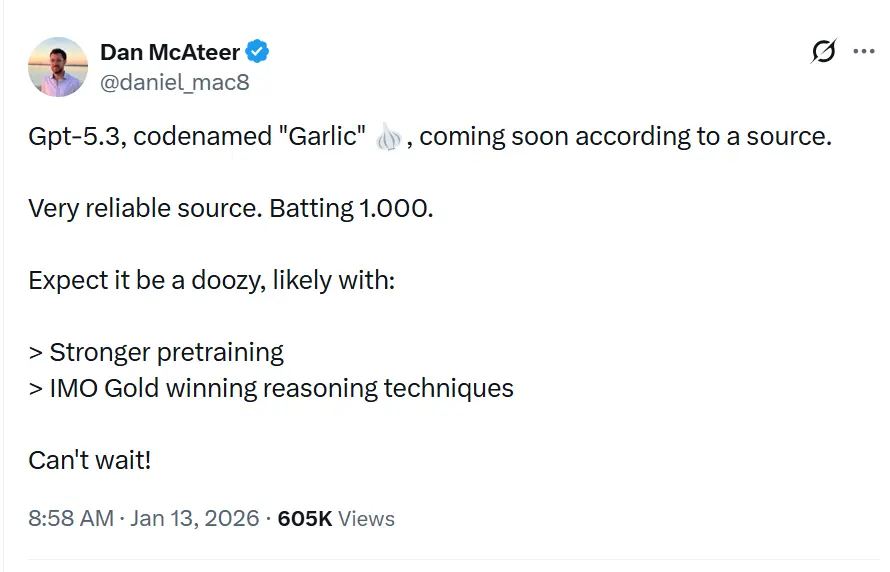

Kodenavnet GPT-5.3«Garlic» beskrives i lekkasjer og rapportering som en neste inkrementell/iterativ GPT-5.x‑utgivelse, ment å tette gap i resonnering, koding og produktytelse for OpenAI, som et svar på konkurransepress fra Googles Gemini og Anthropics Claude.

OpenAI eksperimenterer med en tettere, mer effektiv GPT-5.x‑iterasjon som fokuserer på sterkere resonnering, raskere inferens og arbeidsflyter med lengre kontekst, snarere enn stadig større antall parametere. Dette er ikke bare enda en iterasjon av Generative Pre-trained Transformer‑serien; det er et strategisk motangrep. Født ut av en intern «Code Red» erklært av CEO Sam Altman i desember 2025, markerer «Garlic» et brudd med dogmet om at «større er bedre» som har styrt LLM‑utvikling i et halvt tiår. I stedet satser den alt på en ny metrikk: kognitiv tetthet.

Hva er GPT-5.3 «Garlic»?

GPT-5.3 — med kodenavn «Garlic» — beskrives som neste iterative steg i OpenAIs GPT-5‑familie. Kildene som rammer inn lekkasjen, fremstiller Garlic ikke som bare et enkelt kontrollpunkt eller en token‑justering, men som en målrettet forbedring av arkitektur og trening: målet er å hente ut høyere resonneringsytelse, bedre flertrinns planlegging og forbedret atferd i lange kontekster fra en mer kompakt, inferens‑effektiv modell, snarere enn å basere seg utelukkende på rå skala. Denne innrammingen samsvarer med bredere bransjetrender mot «tette» eller «høyeffektivitet»‑modellutforminger.

Navnet «Garlic»—et markant brudd med de himmelske (Orion) eller botanisk‑søte (Strawberry) kodenavnene fra tidligere—skal være en bevisst intern metafor. Akkurat som et enkelt hvitløksfedd kan sette kraftig smak på en hel rett mer potent enn større, blassere ingredienser, er denne modellen designet for å levere konsentrert intelligens uten det massive beregningsoverhenget fra industriens giganter.

«Code Red»-opprinnelsen

Garlics eksistens kan ikke skilles fra den eksistensielle krisen som ga den opphav. I slutten av 2025 befant OpenAI seg for første gang siden lanseringen av ChatGPT i en «defensiv posisjon». Googles Gemini 3 hadde tatt kronen på multimodale benchmarker, og Anthropics Claude Opus 4.5 var blitt de facto‑standarden for kompleks koding og agentiske arbeidsflyter. Som svar satte OpenAI‑ledelsen perifere prosjekter på pause—inkludert annonseplattform‑eksperimenter og utvidelser av forbrukeragenter—for å fokusere fullt og helt på en modell som kunne gjennomføre et «taktisk slag» mot disse konkurrentene.

Garlic er det slaget. Den er ikke designet for å være verdens største modell; den er designet for å være den smarteste per parameter. Den samler forskningslinjene fra tidligere interne prosjekter, særlig «Shallotpeat», og inkorporerer feilrettinger og effektiviseringer i forhåndstreningen som gjør at den slår langt over sin vektklasse.

Hva er status for de observerte iterasjonene av GPT-5.3‑modellen?

Per midten av januar 2026 er GPT-5.3 i de siste fasene av intern validering, en fase i Silicon Valley ofte beskrevet som «herding». Modellen er for tiden synlig i interne logger og er blitt spot‑testet av utvalgte bedriftskunder under strenge konfidensialitetsavtaler.

Observerte iterasjoner og integrering av «Shallotpeat»

Veien til Garlic var ikke lineær. Lekkede interne notater fra Chief Research Officer Mark Chen antyder at Garlic faktisk er en sammensetning av to distinkte forskningsspor. Opprinnelig utviklet OpenAI en modell med kodenavn «Shallotpeat», ment som en direkte inkrementell oppdatering. Under forhåndstreningen av Shallotpeat oppdaget imidlertid forskerne en ny metode for å «komprimere» resonneringsmønstre—i praksis å lære modellen å forkaste redundante nevrale baner tidligere i treningsprosessen.

Denne oppdagelsen førte til at den frittstående Shallotpeat‑utgivelsen ble skrinlagt. Dens arkitektur ble slått sammen med den mer eksperimentelle «Garlic»‑grenen. Resultatet er en hybriditerasjon som har stabiliteten til en moden GPT‑5‑variant, men den eksplosive resonneringseffektiviteten til en ny arkitektur.

Når kan vi anta at lanseringen vil finne sted?

Å forutsi lanseringsdatoer for OpenAI er notorisk vanskelig, men «Code Red»‑statusen akselererer standard tidslinjer. Basert på konvergensen av lekkasjer, leverandøroppdateringer og konkurrenters sykluser kan vi triangulere et lanseringsvindu.

Primærvindu: Q1 2026 (januar - mars)

Konsensus blant innsidere er en lansering i Q1 2026. «Code Red» ble erklært i desember 2025, med en instruks om å lansere «så snart som mulig». Gitt at modellen allerede er i kontroll/validering (sammenslåingen med «Shallotpeat» har akselerert tidslinjen), virker sen januar eller tidlig februar mest plausibelt.

«Beta»-utrullingen

Vi kan få en trinnvis utrulling:

- Slutten av januar 2026: En «preview»‑lansering til utvalgte partnere og ChatGPT Pro‑brukere (muligens merket «GPT‑5.3 (Preview)»).

- Februar 2026: Full API‑tilgjengelighet.

- Mars 2026: Integrering i gratisnivået av ChatGPT (begrensede forespørsler) for å møte Geminis gratis tilgjengelighet.

3 definerende funksjoner ved GPT‑5.3?

Hvis ryktene stemmer, vil GPT‑5.3 introdusere en pakke med funksjoner som prioriterer nytte og integrasjon fremfor ren generativ kreativitet. Funksjonssettet leser som en ønskeliste for systemarkitekter og bedriftsutviklere.

1. Forhåndstrening med høy tetthet (EPTE)

Kronjuvelen i Garlic er dens Enhanced Pre-Training Efficiency (EPTE).

Tradisjonelle modeller lærer ved å se enorme datamengder og skape et vidstrakt nett av assosiasjoner. Garlics treningsprosess innebærer angivelig en «beskjæringsfase» der modellen aktivt kondenserer informasjon.

- Resultatet: En modell som fysisk er mindre (målt i VRAM‑krav) men som beholder «verdenskunnskapen» til et langt større system.

- Fordelen: Raskere inferenshastigheter og betydelig lavere API‑kostnader, som adresserer «intelligens‑til‑kostnad»‑forholdet som har hindret masseadopsjon av modeller som Claude Opus.

2. Innebygd agentisk resonnering

I motsetning til tidligere modeller som krevde «wrappere» eller kompleks prompt‑engineering for å fungere som agenter, har Garlic innebygde verktøykall‑kapabiliteter.

Modellen behandler API‑kall, kodekjøring og databaseforespørsler som «førsteklasses objekter» i sitt vokabular.

- Dyp integrering: Den «kan» ikke bare kode; den forstår også kode‑miljøet. Angivelig kan den navigere i en filkatalog, redigere flere filer samtidig og kjøre egne enhetstester uten eksterne orkestreringsskript.

3. Massive kontekst- og utdata‑vinduer

For å konkurrere med Geminis million‑token‑vindu ryktes det at Garlic leveres med et kontekstvindu på 400,000 token. Selv om det er mindre enn Googles tilbud, er nøkkeldifferensiatoren «Perfect Recall» over det vinduet, ved å bruke en ny oppmerksomhetsmekanisme som forhindrer det vanlige «midt‑i‑kontekst»‑tapet i 2025‑modellene.

- 128k utdata‑grense: Kanskje enda mer spennende for utviklere er den ryktede utvidelsen av utdata‑grensen til 128,000 token. Dette vil gjøre det mulig for modellen å generere hele programvarebiblioteker, omfattende juridiske dokumenter eller romanlengde‑tekster i én operasjon, uten behov for «chunking».

4. Dramatisk redusert hallusinasjon

Garlic benytter en ettertrenings‑forsterkningsteknikk med fokus på «epistemisk ydmykhet»—modellen trenes grundig i å vite hva den ikke vet. Interne tester viser en hallusinasjonsrate som er betydelig lavere enn GPT‑5.0, noe som gjør den egnet for høyrisiko‑bransjer som biomedisin og jus.

Hvordan står den seg mot konkurrenter som Gemini og Claude 4.5?

GPT‑5.3 «Garlic» vs. Google Gemini 3

Kampen mellom skala og tetthet.

- Gemini 3: For øyeblikket «kjøkkenvask»‑modellen. Den dominerer i multimodal forståelse (video, lyd, innebygd bildegenerering) og har et praktisk talt uendelig kontekstvindu. Den er den beste modellen for «rotete» data fra virkeligheten.

- GPT‑5.3 Garlic: Kan ikke konkurrere med Geminis rå multimodale bredde. I stedet angriper den Gemini på resonneringsrenhet. For ren tekstgenerering, kodelogikk og kompleks instruksjonsfølgning sikter Garlic på å være skarpere og mindre tilbøyelig til «nektelser» eller avsporing.

- Konklusjon: Hvis du må analysere en 3‑timers video, bruker du Gemini. Hvis du skal skrive backend for en bankapp, bruker du Garlic.

GPT‑5.3 «Garlic» vs. Claude Opus 4.5

Kampen om utviklerens sjel.

- Claude Opus 4.5: Lansert mot slutten av 2025, vant denne modellen utviklere med sin «varme» og «vibes». Den er kjent for å skrive ren, menneskelig lesbar kode og følge systeminstruksjoner med militær presisjon. Den er imidlertid dyr og treg.

- GPT‑5.3 Garlic: Dette er det direkte målet. Garlic tar sikte på å matche Opus 4.5s kodeferdigheter, men til 2x hastighet og 0.5x kostnad. Ved å bruke «High‑Density Pre‑Training» vil OpenAI tilby Opus‑nivå intelligens på et Sonnet‑nivå budsjett.

- Konklusjon: «Code Red» ble spesifikt trigget av Opus 4.5s dominans i koding. Garlics suksess avhenger helt av om den kan overbevise utviklere om å bytte API‑nøkler tilbake til OpenAI. Hvis Garlic kan kode like godt som Opus men kjøre raskere, vil markedet skifte over natten.

Hovedpoeng

Tidlige interne bygg av Garlic overgår allerede Googles Gemini 3 og Anthropics Opus 4.5 i spesifikke, høyverdige domener:

- Kodingsdyktighet: I interne «harde» benchmarker (utover standard HumanEval) viser Garlic mindre tendens til å kjøre seg fast i «logikksløyfer» sammenlignet med GPT‑4.5.

- Resonneringstetthet: Modellen trenger færre token med «tenkning» for å komme frem til korrekte konklusjoner, i klar kontrast til «chain‑of‑thought»‑tyngden i o1‑serien (Strawberry).

| Metrikk | GPT-5.3 (Garlic) | Google Gemini 3 | Claude 4.5 |

|---|---|---|---|

| Resonnering (GDP-Val) | 70.9% | 53.3% | 59.6% |

| Koding (HumanEval+) | 94.2% | 89.1% | 91.5% |

| Kontekstvindu | 400K Tokens | 2M Tokens | 200K Tokens |

| Inferenshastighet | Ultrarask | Moderat | Rask |

Konklusjon

«Garlic» er et aktivt og plausibelt rykte: et målrettet OpenAI‑ingeniørspor som prioriterer resonneringstetthet, effektivitet og verktøy for den virkelige verden. Fremveksten bør ses i konteksten av et akselererende våpenkappløp mellom modellleverandører (OpenAI, Google, Anthropic) — der den strategiske gevinsten ikke bare er rå kapasitet, men brukbar kapasitet per dollar og per millisekund ventetid.

Hvis du er interessert i denne nye modellen, følg CometAPI. Det oppdaterer alltid med de nyeste og beste KI‑modellene til en overkommelig pris.

Utviklere kan få tilgang til GPT-5.2 ,Gemini 3, Claude 4.5 via CometAPI nå. For å komme i gang, utforsk modellkapabilitetene til CometAPI i Playground og se API‑veiledning for detaljerte instruksjoner. Før du får tilgang, må du forsikre deg om at du har logget inn på CometAPI og innhentet API‑nøkkelen. CometAPI tilbyr en pris som er langt lavere enn den offisielle prisen for å hjelpe deg å integrere.

Klar til å starte?→ Registrer deg for CometAPI i dag!

Hvis du vil ha flere tips, guider og nyheter om KI, følg oss på VK, X og Discord!