Hva er GPT-5.2 API

GPT-5.2 API er det samme som GPT-5.2 Thinking i ChatGPT. GPT-5.2 Thinking er en mellomklasse-variant i OpenAIs GPT-5.2-familie designet for dypere arbeid: flertrinns resonnement, oppsummering av lange dokumenter, kodegenerering av høy kvalitet og profesjonelt kunnskapsarbeid der nøyaktighet og brukbar struktur betyr mer enn rå gjennomstrømning. I API-et eksponeres den som modellen gpt-5.2 (Responses API / Chat Completions), og den plasserer seg mellom lav-latens-varianten Instant og den høyere kvaliteten men dyrere varianten Pro.

Hovedfunksjoner

- Svært lang kontekst og komprimering: 400K kontekstvindu og komprimeringsverktøy for å håndtere relevans på tvers av lange samtaler og dokumenter.

- Konfigurerbar resonneringsinnsats:

none | medium | high | xhigh(xhigh aktiverer maksimal intern beregning for krevende resonnement).xhigher tilgjengelig i Thinking/Pro-variantene. - Sterkere verktøy- og funksjonsstøtte: førsteklasses verktøykalling, grammatikk (CFG/Lark) for å begrense strukturerte utdata, og forbedrede agentbaserte atferder som forenkler kompleks flertrinns automatisering.

- Multimodal forståelse: rikere bilde- og tekstforståelse samt integrering i flertrinns oppgaver.

- Forbedret sikkerhet / håndtering av sensitivt innhold: målrettede tiltak for å redusere uønskede svar i områder som selvskading og andre sensitive kontekster.

Tekniske funksjoner og spesifikasjoner (utviklerperspektiv)

- API-endepunkter og modell-ID-er:

gpt-5.2for Thinking (Responses API),gpt-5.2-chat-latestfor chat/instant-arbeidsflyter, oggpt-5.2-profor Pro-nivået; tilgjengelig via Responses API og Chat Completions der angitt. - Resonnerings-tokens og innsatsstyring: API-et støtter eksplisitte parametere for å allokere beregning (resonneringsinnsats) per forespørsel; høyere innsats øker latens og kostnad, men forbedrer utdatakvalitet for komplekse oppgaver.

- Verktøy for strukturerte utdata: støtte for grammatikk (Lark / CFG) for å begrense modellutdata til en DSL eller eksakt syntaks (nyttig for SQL, JSON, DSL-generering).

- Parallell verktøykalling og agentbasert koordinering: forbedret parallellisme og ryddigere verktøyorkestrering reduserer behovet for omfattende systemprompter og multi-agent-stillas.

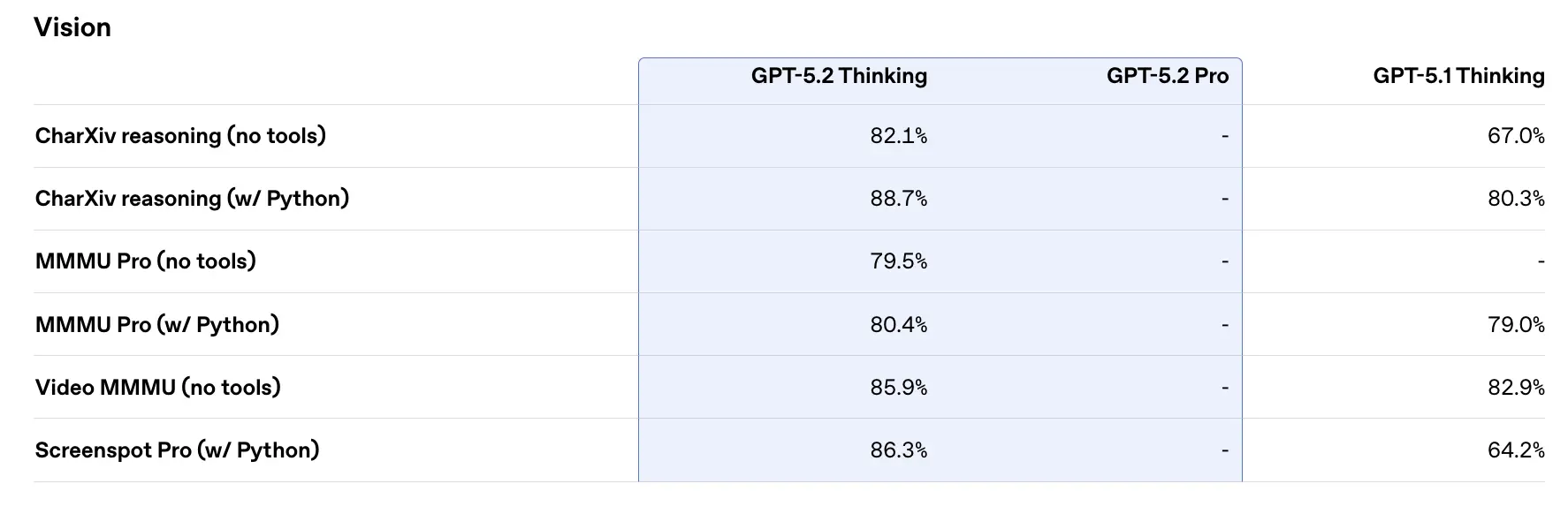

Ytelse på benchmarker og støttedata

OpenAI har publisert en rekke interne og eksterne benchmark-resultater for GPT-5.2. Utvalgte høydepunkter (OpenAIs rapporterte tall):

- GDPval (44 occupations, knowledge work) — GPT-5.2 Thinking “beats or ties top industry professionals on 70.9% of comparisons”; OpenAI rapporterer at utdata ble produsert med >11× the speed og <1% the cost av ekspertprofesjonelle på deres GDPval-oppgaver (hastighets- og kostnadsanslagene er historisk baserte). Disse oppgavene inkluderer regnearkmodeller, presentasjoner og korte videoer.

- SWE-Bench Pro (coding) — GPT-5.2 Thinking oppnår ≈55.6% på SWE-Bench Pro og ~80% på SWE-Bench Verified (kun Python) ifølge OpenAI, og etablerer en ny state-of-the-art for kodegenerering / ingeniørevaluering i deres tester. Dette gir mer pålitelig feilsøking og end-to-end-rettinger i praksis, ifølge OpenAIs eksempler.

- GPQA Diamond (graduate-level science Q&A) — GPT-5.2 Pro: 93.2%, GPT-5.2 Thinking: 92.4% på GPQA Diamond (ingen verktøy, maksimalt resonnement).

- ARC-AGI series — På ARC-AGI-2 (en vanskeligere benchmark for flytende resonnement), fikk GPT-5.2 Thinking 52.9% og GPT-5.2 Pro 54.2% (OpenAI sier dette er nye state-of-the-art-resultater for modeller med chain-of-thought-stil).

- Lang kontekst (OpenAI MRCRv2) — GPT-5.2 Thinking viser nær 100% nøyaktighet på 4-needle MRCR-varianten ut til 256k tokens og vesentlig forbedrede resultater sammenlignet med GPT-5.1 i langkontekst-innstillinger. (OpenAI publiserte MRCRv2-diagrammer og tabeller.)

Sammenligning med samtidige

- vs Google Gemini 3 (Gemini 3 Pro / Deep Think): Gemini 3 Pro har blitt offentliggjort med et ~1,048,576 (≈1M) token kontekstvindu og brede multimodale input (tekst, bilde, lyd, video, PDF-er) samt sterke agentbaserte integrasjoner via Vertex AI / AI Studio. På papiret er Gemini 3s større kontekstvindu en differensiator for ekstremt store enkeltsesjonsarbeidsbelastninger; avveininger inkluderer verktøyoverflate og økosystemtilpasning.

- vs Anthropic Claude Opus 4.5: Anthropics Opus 4.5 vektlegger bedriftsrettet koding/agent-arbeidsflyter og rapporterer sterke SWE-bench-resultater og robusthet for lange agentbaserte økter; Anthropic posisjonerer Opus for automatisering og kodegenerering med et 200k kontekstvindu og spesialiserte agent-/Excel-integrasjoner. Opus 4.5 er en sterk konkurrent i bedriftsautomatisering og kodeoppgaver.

Praktisk konklusjon: GPT-5.2 retter seg mot et balansert sett med forbedringer (400k kontekst, høy token-utdata, forbedret resonnement/koding). Gemini 3 retter seg mot de absolutt største enkeltsesjonskontekstene (≈1M), mens Claude Opus fokuserer på bedriftsingeniørarbeid og agentisk robusthet. Velg ved å matche kontekststørrelse, modalitetsbehov, funksjon-/verktøytilpasning og kostnads-/latensavveininger.

Slik får du tilgang til og bruker GPT-5.2 API

Trinn 1: Registrer deg for API-nøkkel

Logg inn på cometapi.com. Hvis du ikke er bruker hos oss ennå, vennligst registrer deg først. Logg inn i din CometAPI-konsoll. Hent tilgangslegitimasjonen API-nøkkel for grensesnittet. Klikk “Add Token” ved API-tokenet i personlig senter, hent token-nøkkelen: sk-xxxxx og send inn.

Trinn 2: Send forespørsler til GPT-5.2 API

Velg endepunktet “gpt-5.2” for å sende API-forespørselen og sett forespørselskroppen. Forespørselsmetoden og forespørselskroppen hentes fra vår nettsides API-dokumentasjon. Vår nettside tilbyr også Apifox-test for din bekvemmelighet. Erstatt <YOUR_API_KEY> med din faktiske CometAPI-nøkkel fra kontoen din. Utviklere kaller disse via Responses API / Chat endepunkter.

Sett inn spørsmålet eller forespørselen din i innholdsfeltet—det er dette modellen vil svare på . Behandle API-responsen for å hente det genererte svaret.

Trinn 3: Hent og verifiser resultater

Behandle API-responsen for å hente det genererte svaret. Etter behandling svarer API-et med oppgavestatus og utdata.

Se også Gemini 3 Pro Preview API