OpenAI, Anthropic og Google fortsetter å flytte grensene for store språkmodeller med sine nyeste flaggskipprodukter – OpenAIs o3 (og den forbedrede o3-pro-varianten), Anthropics Claude Opus 4 og Googles Gemini 2.5 Pro. Hver av disse modellene bringer unike arkitektoniske innovasjoner, ytelsesstyrker og økosystemintegrasjoner som passer for ulike brukstilfeller, fra kodehjelp i bedriftsklassen til forbedrede søkeresultater rettet mot forbrukere. Denne grundige sammenligningen undersøker utgivelseshistorikken, tekniske funksjoner, ytelsesstandard og anbefalte applikasjoner for å hjelpe organisasjoner med å velge riktig modell for sine behov.

Hva er OpenAIs o3, og hvordan har det utviklet seg?

OpenAI introduserte først o3 16. april 2025, og posisjonerte den som «vår mest intelligente modell» designet for utvidet kontekst og svært pålitelige responser. Kort tid etter, 10. juni 2025, lanserte OpenAI o3-pro – en ytelsesjustert variant tilgjengelig for Pro-brukere i ChatGPT så vel som via API-et – som leverer raskere inferens og høyere gjennomstrømning under tunge belastninger.

Kontekstvindu og gjennomstrømning

OpenAI o3 tilbyr en 200 XNUMX-token kontekstvindu for både input og output, noe som muliggjør håndtering av omfattende dokumenter, kodebaser eller flerturn-samtaler uten hyppig avkorting. Gjennomstrømningen måler rundt 37.6 tokens/sek, som – selv om den ikke er ledende – gir konsistent responstid for vedvarende arbeidsbelastninger.

Avansert deliberativ resonnering

- **«Privat tankekjede»**o3 ble trent med forsterkningslæring til å planlegge og resonnere gjennom mellomtrinn før den produserte det endelige resultatet, noe som markant forbedret evnen til logisk deduksjon og problemdekomposisjon.

- Bevisst justeringDen inneholder sikkerhetsteknikker som veileder modellen til å overholde retningslinjene mer pålitelig gjennom trinnvis resonnement, noe som reduserer store feil i komplekse oppgaver i den virkelige verden.

Prissetting og bedriftsintegrasjon

OpenAIs priser for o3 ligger på omtrent 2 dollar per million inndatatokener og 8 dollar per million utgangstokenerDette plasserer den i mellomklassen: rimeligere enn premiummodeller som Claude Opus 4 for tunge arbeidsbelastninger, men dyrere enn budsjettvennlige alternativer som Gemini 2.5 Pro. Avgjørende er at bedrifter drar nytte av sømløs integrasjon med det bredere OpenAI API-økosystemet – som dekker innebygging, finjustering og spesialiserte endepunkter – noe som minimerer integrasjonskostnader.

Hvordan skiller Claude Opus 4 seg ut i markedet?

Anthropic annonserte Claude Opus 4 22. mai 2025, og markedsførte den som «verdens beste kodemodell» med vedvarende ytelse på komplekse, langvarige oppgaver og agentarbeidsflyter. Den ble lansert samtidig i Anthropics eget API og via Amazon Bedrock, noe som gjorde den tilgjengelig for AWS-kunder gjennom Bedrocks LLM-funksjoner og REST API...

Utvidede «tenkeevner»

Et særegent trekk ved Opus 4 er dens «utvidet tenkning» Betamodus, som dynamisk fordeler beregning mellom resonnement på modellen og verktøyanrop (f.eks. søk, henting, eksterne API-er). Kombinert med «tenkesammendrag» får brukerne innsikt i modellens interne resonnementskjede – avgjørende for samsvarssensitive applikasjoner innen finans og helsevesen.

Avveininger mellom prissetting og kontekst

At 15 dollar per million inndatatokener og 75 dollar per million utgangstokenerClaude Opus 4 ligger øverst i prisklassen. Dens 200 XNUMX-token inndatavindu (med et 32 XNUMX-token (utgangsgrense) er mindre enn Gemini 2.5 Pros vindu på 1 millioner token, men er tilstrekkelig for de fleste kodegjennomganger og langformede resonneringsoppgaver. Anthropic rettferdiggjør premien ved å legge vekt på intern beregningsintensitet og vedvarende tankekjedegjengivelse, med opptil 90 % besparelser via rask mellomlagring og 50 % via batchbehandling. Utvidede tankebudsjetter er inkludert for betalte nivåer; gratisbrukere har bare tilgang til Sonnet-varianten.

Hvilke unike funksjoner og ytelse har Gemini 2.5 Pro?

Lansert som Googles neste generasjons «Pro»-nivå, Gemini 2.5 Pro retter seg mot organisasjoner som trenger massiv kontekst, multimodale innspill og kostnadseffektiv skalering. Det er verdt å merke seg at den støtter opptil 1,048,576-symboler i én enkelt ledetekst – innkommende – og 65,535-symboler utgående, noe som muliggjør komplette dokumentarbeidsflyter som strekker seg over hundretusenvis av sider.

Overlegen kontekst og multimodalitet

Gemini 2.5 Pro skinner med sin 1M-token kontekstvindu, som forenkler brukstilfeller som juridisk kontraktsanalyse, patentutvinning og omfattende refaktorering av kodebase. Modellen aksepterer innebygd tekst, kode, bilder, lyd, PDF-er og videorammer, effektivisering av multimodale rørledninger uten separate forbehandlingstrinn.

Hvordan forbedrer Gemini multimodal og konversasjonsbasert søk?

Gemini 2.5 Pro skiller seg ut med sin «spørreutvikling»-metodikk: den deler opp komplekse spørringer i underspørsmål, kjører parallelle søk og syntetiserer omfattende, samtalebaserte svar underveis. Med støtte for tekst-, tale- og bildeinndata utnytter AI-modus Geminis multimodale funksjoner for å imøtekomme ulike brukerinteraksjoner – selv om den fortsatt er i en tidlig fase og av og til kan misforstå spørringer.

Konkurransedyktige priser

Med en inngangshastighet på $1.25–$2.50 per million tokens og $10–$15 per million utgangstokener leverer Gemini 2.5 Pro det beste pris-til-token forholdet mellom de tre. Dette gjør det spesielt attraktivt for applikasjoner med høyt volum og dokumentintensive behov – der lange kontekster driver tokenforbruk mer enn rå ytelsesmålinger, med premium-abonnementer som låser opp «Deep Think»-budsjetter og høyere gjennomstrømning. Google AI Pro- og Ultra-abonnementer gir tilgang til Gemini 2.5 Pro sammen med andre verktøy som Veo-videogenerering og NotebookLM.

Underliggende arkitekturer og funksjoner

OpenAI o3: Reflekterende resonnering i stor skala

OpenAIs o3 er en reflekterende generativ forhåndstrent transformator designet for å bruke ekstra overveielsestid på trinnvise logiske resonneringsoppgaver. Arkitektonisk bygger den på transformatorryggraden i GPT-4, men inkluderer en "tenkebudsjett"-mekanisme: modellen tildeler dynamisk flere beregningssykluser til komplekse problemer, og skaper interne tankekjeder før den genererer resultater. Dette resulterer i markant forbedret ytelse i domener som krever flertrinnsresonnement, for eksempel avansert matematikk, vitenskapelig undersøkelse og kodesyntese.

Claude Opus 4: Hybrid resonnement for utvidede arbeidsflyter

Anthropics Claude Opus 4 er den kraftigste modellen hittil, optimalisert for koding og vedvarende agentiske arbeidsflyter. I likhet med o3 utnytter den en transformerkjerne, men introduserer hybride resonneringsmoduser – nesten umiddelbare responser («rask tenkning») kontra utvidet overveielse («dyp tenkning») – som gjør det mulig å opprettholde kontekst over tusenvis av trinn og timer med beregning. Denne hybride tilnærmingen gjør Opus 4 unikt egnet for langvarige programvareutviklingsprosesser, flertrinns forskningsoppgaver og autonom agentorkestrering.

Gemini 2.5 Pro: Multimodal tenkning med adaptive budsjetter

Google DeepMinds Gemini 2.5 Pro utvider Gemini sin innebygde multimodalitet og resonneringsevner. Den introduserer «Deep Think», en adaptiv parallelltenkningsmekanisme som sprer ut deloppgaver på tvers av interne moduler og syntetiserer resultater til sammenhengende svar. Gemini 2.5 Pro har også et usedvanlig langt kontekstvindu – som gjør det mulig å innta hele kodebaser, store datasett (tekst, lyd, video) og designdokumenter i én omgang – samtidig som den gir finjusterte kontroller over tankebudsjetter for avveininger mellom ytelse og kostnad.

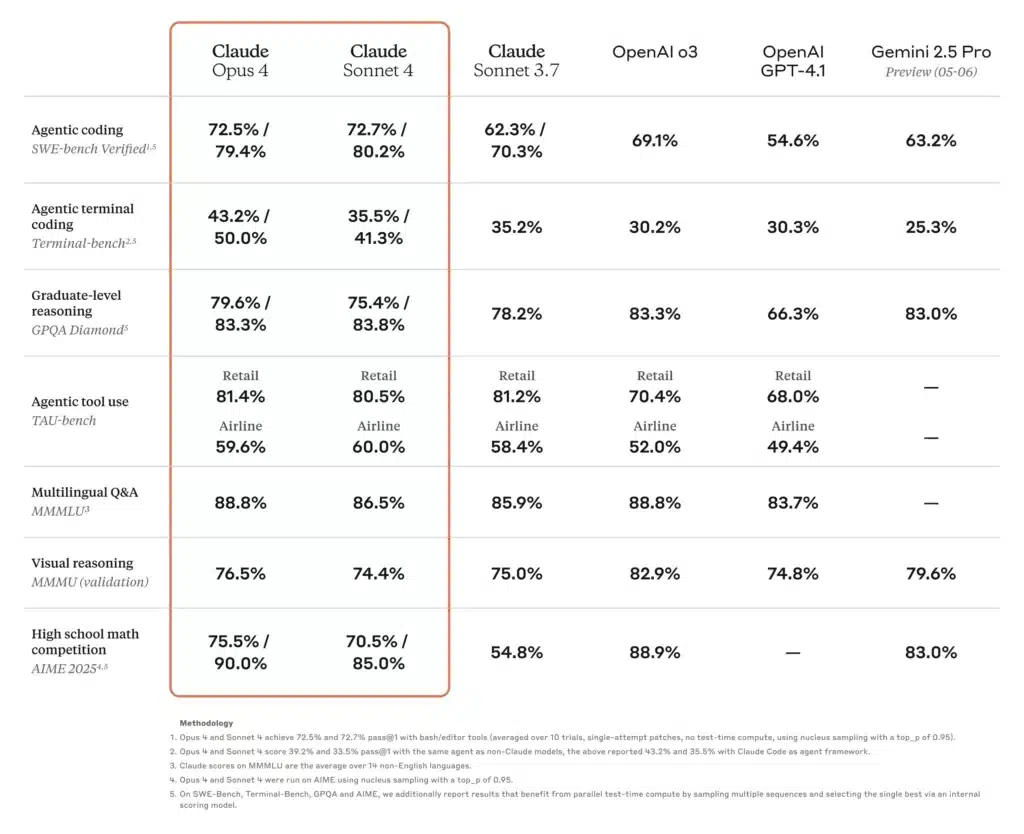

Hvordan er ytelsesstandardene sammenlignet med disse modellene?

Akademisk og vitenskapelig resonnement

I en fersk SciArena-ligatabell slo o3 konkurrentene sine på tekniske resonnementsspørsmål evaluert av forskere, noe som gjenspeiler sterk tillit i samfunnet til den vitenskapelige nøyaktigheten. Samtidig viste Claude Opus 4 overlegen ytelse i agentbaserte benchmarks som krever vedvarende problemløsning over flere timer, og overgikk Sonnet-modeller med opptil 30 % på TAU-bench og prediktive resonnementsoppgaver. Gemini 2.5 Pro leder også mange akademiske benchmarks, og oppnådde førsteplass på LMArena for menneskelige preferansemålinger og viste betydelige marginer på matematikk- og naturfagprøver.

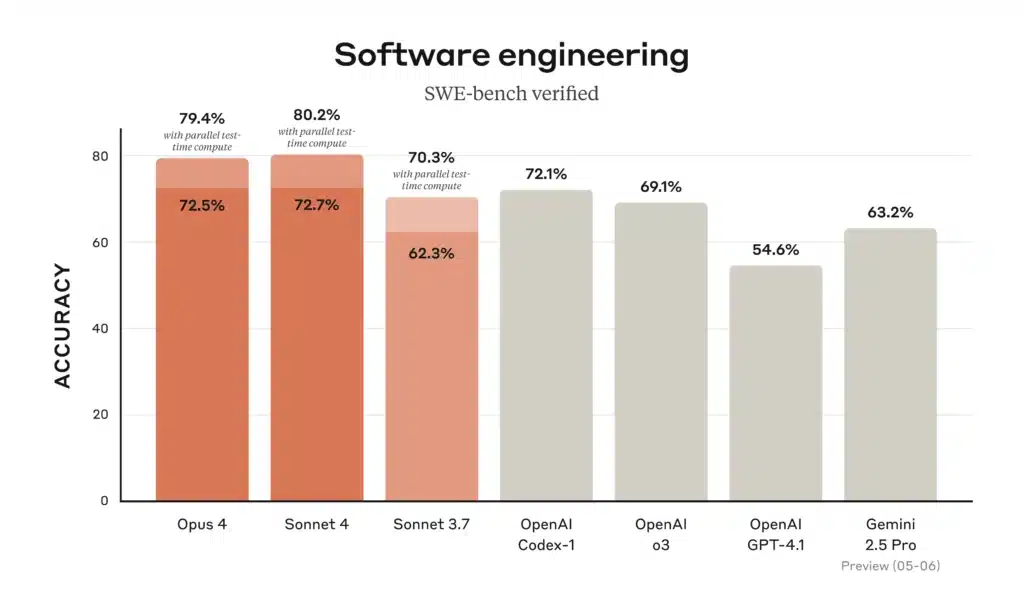

Koding og programvareutvikling

På kodingsledertavler «topper Gemini 2.5 Pro den populære WebDev Arena» og leder an blant vanlige kodingsbenchmarks, takket være dens evne til å laste og resonnere over hele repositorier. Claude Opus 4 har tittelen «verdens beste kodingsmodell», med 72.5 % på SWE-bench og 43.2 % på Terminal-bench – benchmarks fokusert på komplekse, langvarige programvareoppgaver. o3 utmerker seg også i kodesyntese og feilsøking, men faller litt bak Opus 4 og Gemini i flertrinns, storskala ingeniørscenarier. Likevel gjør den intuitive tankekjeden den svært pålitelig for individuelle kodingsoppgaver.

Verktøybruk og multimodal integrering

Gemini 2.5 Pros multimodale design – behandling av tekst, bilder, lyd og video – gir den et fortrinn i kreative arbeidsflyter som interaktive simuleringer, visuell dataanalyse og videostoryboarding. Claude Opus 4s agentiske verktøybruk, inkludert Claude Code CLI og integrerte filsystemoperasjoner, utmerker seg i å bygge autonome pipelines på tvers av API-er og databaser. o3 støtter nettlesing, filanalyse, Python-kjøring og bilderesonnering, noe som gjør den til en allsidig «sveitserkniv» for oppgaver i blandede formater, om enn med kortere kontekstgrenser enn Gemini 2.5 Pro.

Hvordan er disse modellene sammenlignet med virkelige kodescenarioer?

Når det gjelder kodingshjelp, forteller benchmarks bare deler av historien. Utviklere ser etter nøyaktig kodegenerering, ferdigheter i refaktorering og evnen til å forstå prosjektkontekst spredt på tvers av flere filer.

Nøyaktighet og hallusinasjonsrater

- Claude Opus 4 fører an i å unngå hallusinasjoner, med færre tilfeller av ikke-eksisterende API-referanser eller feil biblioteksignaturer – nøkkelen til forretningskritiske kodebaser. Hallusinasjonsraten er rapportert til ~ 12% på omfattende koderevisjoner versus ~ 18% for Tvillingene og ~ 20% for o3.

- Gemini 2.5 Pro utmerker seg ved massetransformasjoner (f.eks. migrering av kodemønstre over titusenvis av linjer), takket være det store kontekstvinduet, men sliter av og til med subtile logiske feil i store kodeblokker.

- ÅpenAI o3 er fortsatt det foretrukne alternativet for raske snippets, generering av standardtekster og interaktiv feilsøking på grunn av stabil latens og høy tilgjengelighet – men utviklere kryssvaliderer ofte med en annen modell for å fange opp feil i kanttilfellene.

Verktøy og API-økosystem

- Begge o3 og Gemini utnytte omfattende verktøy – henholdsvis OpenAIs funksjonskall-API og Googles integrerte handlingsrammeverk – som muliggjør sømløs orkestrering av datainnhenting, databasespørringer og eksterne API-kall.

- Claude Opus 4 integreres i agentiske rammeverk som Claude Code (Anthropics CLI-verktøy) og Amazon Bedrock, og tilbyr abstraksjoner på høyt nivå for å bygge autonome arbeidsflyter uten manuell orkestrering.

Hvilken modell gir det beste forholdet mellom pris og ytelse?

Å balansere råfunksjoner, kontekstlengde og kostnad gir forskjellige konklusjoner om «beste verdi» avhengig av arbeidsmengdens egenskaper.

Dokumentfokuserte brukstilfeller for store volumer

Hvis man behandler store korpora – som juridiske arkiver, vitenskapelig litteratur eller bedriftsarkiver –Gemini 2.5 Pro ofte ut som vinneren. Dens 1M-token vindu og prispunkt for $ $ 1.25 2.50- (inndata) og $ $ 10 15- (utdata)tokener gir en uslåelig kostnadsstruktur for oppgaver med lang kontekst.

Dyp resonnering og arbeidsflyter i flere trinn

Når nøyaktighet, troverdighet i tankekjeden og agenters langvarige evner er viktige – for eksempel i økonomisk modellering, samsvarskontroller av juridiske krav eller FoU-prosjekter –Claude Opus 4Til tross for den høyere prisen kan den redusere kostnader for feilhåndtering og forbedre gjennomstrømningen fra ende til ende ved å minimere antall kjøringer og menneskelige gjennomgangssykluser.

Balansert bedriftsadopsjon

For team som søker pålitelig ytelse for generell bruk uten ekstrem skalering, ÅpenAI o3 tilbyr en mellomting. Med bred API-støtte, moderate priser og solide referanseresultater er det fortsatt et overbevisende valg for datavitenskapsplattformer, automatisering av kundestøtte og produktintegrasjoner i tidlig fase.

Hvilken AI-modell bør du velge for dine spesifikke behov?

Til syvende og sist avhenger din ideelle modell av tre hovedfaktorer:

- Kontekstens skalaFor arbeidsmengder som krever massive inndatavinduer, dominerer Gemini 2.5 Pro.

- Dybde i resonnementetHvis oppgavene dine involverer flertrinnslogikk og lav toleranse for feil, tilbyr Claude Opus 4 overlegen konsistens.

- Kostnadsfølsomhet og økosystemtilpasningFor generelle oppgaver innenfor OpenAI-stakken – spesielt der integrasjon med eksisterende datakanaler er viktig – presenterer o3 et balansert og kostnadseffektivt alternativ.

Ved å evaluere applikasjonens tokenprofil (input vs. output), toleranse for hallusinasjoner og verktøykrav, kan du velge modellen som optimalt samsvarer med både tekniske behov og budsjettbegrensninger.

Her er en sammenligningstabell som oppsummerer de viktigste spesifikasjonene, ytelsesmålingene, prisene og ideelle brukstilfeller for OpenAI o3, Anthropic Claude Opus 4 og Google Gemini 2.5 Pro:

| Funksjon / Metrisk | ÅpenAI o3 | Claude Opus 4 | Gemini 2.5 Pro |

|---|---|---|---|

| Kontekstvindu (innkommende / utgående) | 200 200 tokens / XNUMX XNUMX tokens | 200 32 tokens / XNUMX XNUMX tokens | 1 048 576 tokens / 65 535 tokens |

| Gjennomstrømning (tokens/sek.) | ~ 37.6 | ~ 42.1 | ~ 83.7 |

| Gj.sn. Latens | ~2.8 sek | ~3.5 sek | ~2.52 sek |

| Kodingsbenchmark (SWE-benchmark) | 69.1% | 72.5% | 63.2% |

| Matematikkbenchmark (AIME-2025) | 78.4 %¹ | 81.7 %¹ | 83.0% |

| Hallusinasjonsrate (koderevisjoner) | ~20 % | ~12 % | ~18 % |

| Multimodale innganger | Tekst og kode | Tekst og kode | Tekst, kode, bilder, lyd, PDF-er, video |

| Støtte for «tankekjede» | standard | Utvidet tenkning med sammendrag | standard |

| Funksjons-/verktøykallende API | Ja (OpenAI-funksjoner) | Ja (via antropiske agenter og berggrunn) | Ja (Google-handlinger) |

| Prissetting (inndatatokener) | 2.00 USD / M tokens | 15.00 USD / M tokens | 1.25–2.50 dollar / millioner tokens |

| Prissetting (utdatatokener) | 8.00 USD / M tokens | 75.00 USD / M tokens | 10–15 dollar / millioner tokens |

| Ideelle brukstilfeller | Generelle chatboter, kundestøtte, raske kodebiter | Dyp resonnering, komplekse kodebaser, autonome agenter | Dokumentanalyse i stor skala, multimodale arbeidsflyter |

AIME-2025 matematikkresultater for o3 og Opus 4 er omtrentlige mellomnivåverdier basert på rapporterte referansetester.

Komme i gang

CometAPI er en enhetlig API-plattform som samler over 500 AI-modeller fra ledende leverandører – som OpenAIs GPT-serie, Googles Gemini, Anthropics Claude, Midjourney, Suno og flere – i ett enkelt, utviklervennlig grensesnitt. Ved å tilby konsistent autentisering, forespørselsformatering og svarhåndtering, forenkler CometAPI dramatisk integreringen av AI-funksjoner i applikasjonene dine. Enten du bygger chatboter, bildegeneratorer, musikkomponister eller datadrevne analysepipeliner, lar CometAPI deg iterere raskere, kontrollere kostnader og forbli leverandøruavhengig – alt samtidig som du utnytter de nyeste gjennombruddene på tvers av AI-økosystemet.

Utviklere har tilgang Gemini 2.5 Pro,Claude Opus 4 og O3 API gjennom CometAPI, de nyeste modellversjonene som er oppført er per artikkelens publiseringsdato. For å begynne, utforsk modellens muligheter i lekeplass og konsulter API-veiledning for detaljerte instruksjoner. Før du får tilgang, må du sørge for at du har logget inn på CometAPI og fått API-nøkkelen. CometAPI tilby en pris som er langt lavere enn den offisielle prisen for å hjelpe deg med å integrere.

Til syvende og sist avhenger valget mellom OpenAIs o3-serie, Anthropics Claude Opus 4 og Googles Gemini 2.5 Pro av spesifikke organisatoriske prioriteringer – det være seg teknisk ytelse på toppnivå, sikker bedriftsintegrasjon eller sømløse multimodale forbrukeropplevelser. Ved å tilpasse brukstilfellene dine til hver modells styrker og økosystem, kan du utnytte den banebrytende teknologien innen kunstig intelligens til å drive innovasjon på tvers av forskning, utvikling, utdanning og mer.

Forfatterens notat: Per 31. juli 2025 fortsetter hver av disse modellene å utvikle seg, med hyppige mindre oppdateringer og forbedringer av økosystemet. Se alltid den nyeste CometAPI API-dokumentasjonen og ytelsesstandardene før du tar en endelig avgjørelse.