Gemini 3 Pro (wersja zapoznawcza) to najnowszy flagowy multimodalny model rozumowania firmy Google/DeepMind w rodzinie Gemini 3. Jest pozycjonowany jako „najbardziej inteligentny model jak dotąd”, zaprojektowany do głębokiego rozumowania, agentowych przepływów pracy, zaawansowanego kodowania i wielomodalnego rozumienia w długim kontekście (tekst, obrazy, dźwięk, wideo, kod i integracja narzędzi).

Główne cechy

- Modalność: Tekst, obrazy, wideo, audio, pliki PDF (oraz ustrukturyzowane wyniki narzędzi).

- Agenty/narzędzia: Wbudowane wywoływanie funkcji, wyszukiwanie jako narzędzie, wykonywanie kodu, kontekst URL i obsługa koordynacji agentów wieloetapowych. Mechanizm sygnatury myśli zachowuje wieloetapowe rozumowanie w różnych wywołaniach.

- **Kodowanie i „kodowanie wibracji”**Zoptymalizowany pod kątem generowania front-endu, interaktywnego interfejsu użytkownika i kodowania agentowego (zajmuje pierwsze miejsce w rankingach Google). Jest reklamowany jako ich najmocniejszy jak dotąd model „vibe-coding”.

- Nowe kontrolki dla programistów:

thinking_level(niski|wysoki) w celu kompromisu między kosztami/opóźnieniem a głębokością rozumowania imedia_resolutionKontroluje wierność multimodalną dla każdego obrazu lub klatki wideo. Pomaga to zrównoważyć wydajność, opóźnienie i koszty.

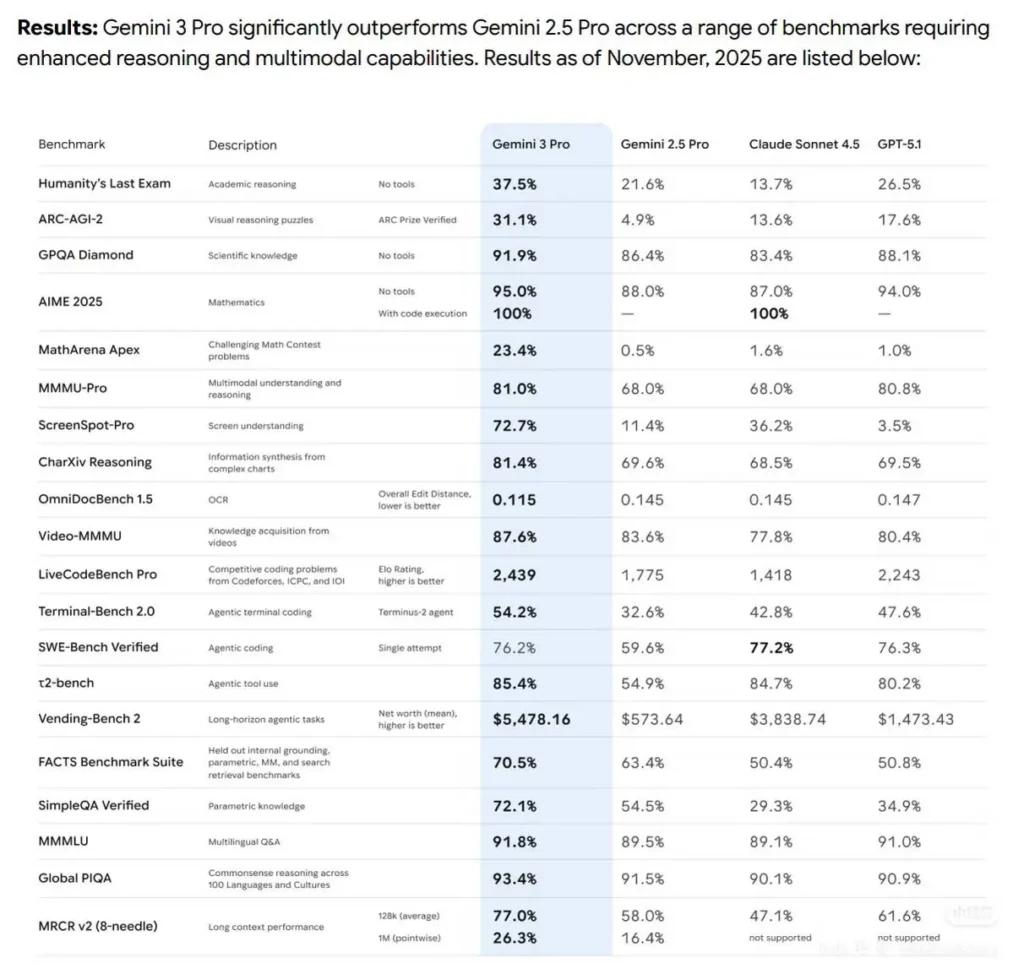

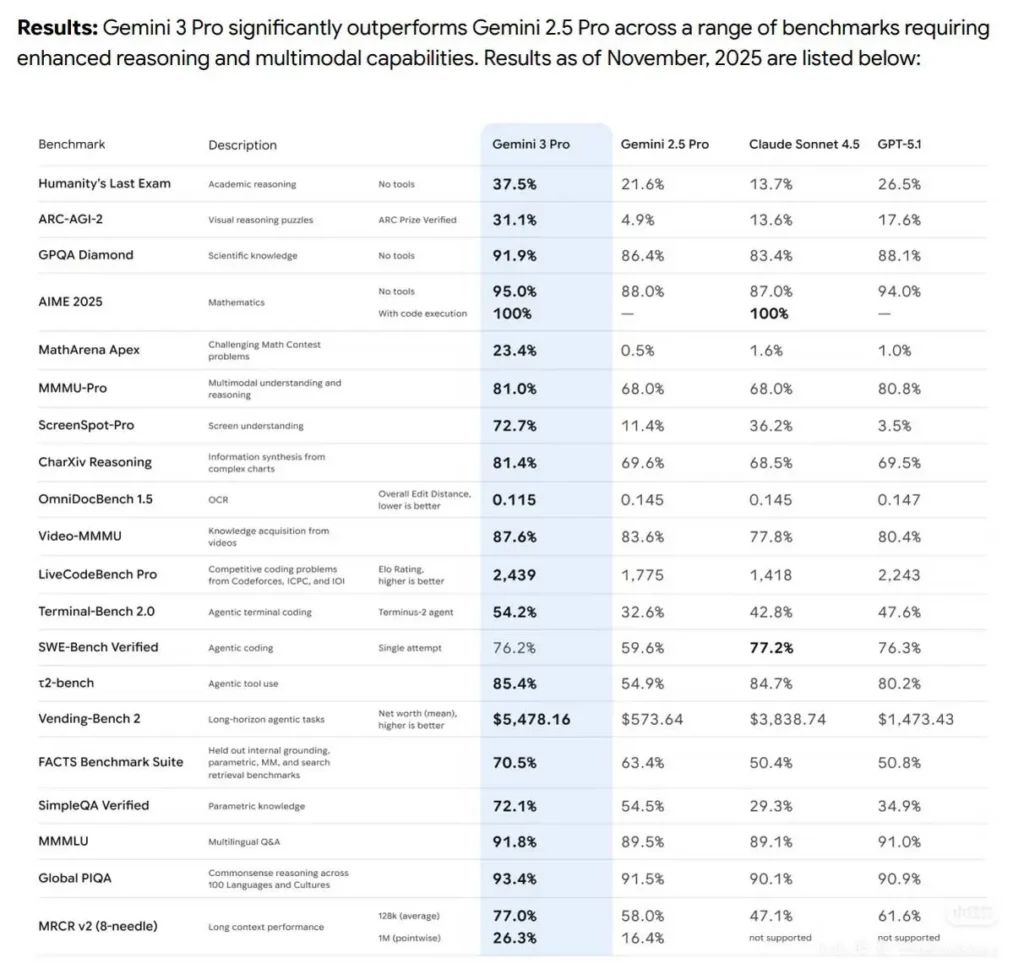

Wydajność wzorcowa

- Gemini3Pro zajął pierwsze miejsce w teście LMARE z wynikiem 1501, przewyższając 1484 punkty Grok-4.1-thinking i wyprzedzając Claude Sonnet 4.5 i Opus 4.1.

- Zdobył także pierwsze miejsce w kategorii programistycznej WebDevArena z wynikiem 1487.

- W części rozumowania akademickiego Humanity's Last Exam osiągnęło wynik 37.5% (bez użycia narzędzi), w części naukowej GPQA Diamond 91.9%, a w konkursie matematycznym MathArena Apex 23.4%, ustanawiając tym samym nowy rekord.

- W zakresie możliwości multimodalnych MMMU-Pro osiągnął wynik 81%, a w zakresie rozumienia obrazu wideo Video-MMMU — 87.6%.

Szczegóły techniczne i architektura

- Parametr „Poziom myślenia”: Gemini 3 ujawnia

thinking_levelkontrola, która pozwala programistom na kompromis między głębokością wewnętrznego rozumowania a opóźnieniem/kosztem. Model traktujethinking_leveljako względne przyzwolenie na wewnętrzne rozumowanie wieloetapowe, a nie ścisła gwarancja tokena. Domyślnie jest to zazwyczajhighdla wersji Pro. To nowa, wyraźna funkcja kontrolna dla programistów, która pozwala im dostroić wieloetapowe planowanie i głębokość łańcucha myślowego. - Ustrukturyzowane wyniki i narzędzia: Model obsługuje ustrukturyzowane dane wyjściowe JSON i można je łączyć z wbudowanymi narzędziami (uziemienie wyszukiwarki Google, kontekst URL, wykonywanie kodu itp.). Niektóre funkcje narzędzi do tworzenia ustrukturyzowanego wyniku są dostępne tylko w wersji zapoznawczej.

gemini-3-pro-preview. - Integracje multimodalne i agentowe: Gemini 3 Pro został stworzony specjalnie z myślą o przepływach pracy opartych na agentach (narzędzia + wielu agentów działających w kodzie/terminalach/przeglądarce).

- Akceptuje dane wejściowe w postaci tekstu, obrazów, wideo, audio i PDF; dane wyjściowe w postaci tekstu.

Ograniczenia i znane zastrzeżenia

- Fakty nie są idealne — halucynacje nadal są możliwe. Mimo zapewnień Google o znacznej poprawie wiarygodności danych, w sytuacjach o wysokim ryzyku (prawnych, medycznych, finansowych) nadal konieczna jest weryfikacja i przegląd przez człowieka.

- Wydajność w kontekście długim różni się w zależności od zadania. Obsługa okna wejściowego o rozmiarze 1M jest trudna do zrealizowania, ale empiryczna skuteczność może spaść w niektórych testach porównawczych przy ekstremalnych odległościach (obserwowano punktowe spadki przy 1M w niektórych testach długoterminowego kontekstu).

- Kompromisy dotyczące kosztów i opóźnień. Duże konteksty i wyższe

thinking_levelUstawienia zwiększają moc obliczeniową, opóźnienia i koszty; poziomy cenowe obowiązują w oparciu o wolumen tokenów.thinking_leveli strategie dzielenia kosztów na mniejsze części. - Bezpieczeństwo i filtry treści. Google nadal stosuje zasady bezpieczeństwa i poziomy moderacji; niektóre treści i działania pozostają ograniczone lub będą aktywować tryby odmowy.

Porównanie wersji zapoznawczej Gemini 3 Pro z innymi wiodącymi modelami

Porównanie na wysokim poziomie (podgląd → jakościowe):

W porównaniu z Gemini 2.5 Pro: Znacząca poprawa w rozumowaniu, wykorzystaniu narzędzi agentowych i integracji multimodalnej; znacznie szersze przetwarzanie kontekstu i lepsze rozumienie długich form. DeepMind wykazuje stałe postępy w zakresie rozumowania akademickiego, kodowania i zadań multimodalnych.

W porównaniu z GPT-5.1 i Claude Sonnet 4.5 (zgodnie z raportem): W zestawieniu benchmarków Google/DeepMind Gemini 3 Pro jest przedstawiany jako lider w kilku metrykach agentowych, multimodalnych i długokontekstowych (patrz Terminal-Bench, MMMU-Pro, AIME). Wyniki porównawcze różnią się w zależności od zadania.

Typowe i wartościowe przypadki użycia

- Podsumowanie dużego dokumentu/książki oraz pytania i odpowiedzi: obsługa długiego kontekstu sprawia, że rozwiązanie to jest atrakcyjne dla zespołów prawnych, badawczych i zajmujących się zgodnością z przepisami.

- Zrozumienie kodu i jego generowanie na skalę repozytorium: integracja z łańcuchami narzędzi kodowania i udoskonalone wnioskowanie ułatwiają refaktoryzację dużych baz kodu i automatyzację przepływów pracy związanych z przeglądem kodu.

- Asystenci produktów multimodalnych: przepływy pracy obejmujące obraz + tekst + dźwięk (obsługa klienta obejmująca zrzuty ekranu, fragmenty połączeń i dokumenty).

- Generowanie i edycja multimediów (zdjęcia → wideo): Wcześniejsze funkcje rodziny Gemini obejmują teraz możliwości przetwarzania zdjęć i wideo w stylu Veo/Flow; wersja zapoznawcza sugeruje bardziej zaawansowane generowanie multimediów na potrzeby prototypów i przepływów pracy nad mediami.

Jak wywołać API gemini-3-pro-preview z CometAPI

Cena podglądowa Gemini 3 Pro w CometAPI, 20% zniżki od ceny oficjalnej:

| Tokeny wejściowe | $1.60 |

| Tokeny wyjściowe | $9.60 |

Wymagane kroki

- Zaloguj się do pl.com. Jeżeli jeszcze nie jesteś naszym użytkownikiem, najpierw się zarejestruj.

- Zaloguj się na swoje Konsola CometAPI.

- Pobierz klucz API uwierzytelniania dostępu do interfejsu. Kliknij „Dodaj token” przy tokenie API w centrum osobistym, pobierz klucz tokena: sk-xxxxx i prześlij.

Użyj metody

- Wybierz "

gemini-3-pro-preview” punkt końcowy do wysłania żądania API i ustawienia treści żądania. Metoda żądania i treść żądania są pobierane z naszej witryny internetowej API doc. Nasza witryna internetowa udostępnia również test Apifox dla Twojej wygody. - Zastępować za pomocą aktualnego klucza CometAPI ze swojego konta.

- Wpisz swoje pytanie lub prośbę w polu treści — model odpowie właśnie na tę wiadomość.

- . Przetwórz odpowiedź API, aby uzyskać wygenerowaną odpowiedź.

CometAPI zapewnia w pełni kompatybilne API REST, co umożliwia bezproblemową migrację. Najważniejsze informacje o czacie:

- Adres URL bazowy: https://api.cometapi.com/v1/chat/completions

- Nazwy modeli:

gemini-3-pro-preview - Poświadczenie:

Bearer YOUR_CometAPI_API_KEYnagłówek - Typ zawartości:

application/json.

Zobacz też Interfejs API GPT-5.1