Kiedy xAI ogłosiło Grok Code Fast 1 Pod koniec sierpnia 2025 roku społeczność AI otrzymała jasny sygnał: Grok nie jest już tylko asystentem konwersacyjnym — staje się bronią dla procesów pracy programistów. Grok Code Fast 1 (w skrócie: Kod szybki 1) to specjalnie zaprojektowany, nisko opóźniony i tani model wnioskowania, specjalnie dostosowany do zadań kodowania i agentowy Przepływy pracy związane z kodowaniem — czyli przepływy pracy, w których model może planować, wywoływać narzędzia i działać jak autonomiczny asystent kodowania w środowiskach IDE i potokach. Model ten zaczął już pojawiać się w integracjach partnerskich (w szczególności jako opcjonalny podgląd w GitHub Copilot) oraz w wielu katalogach dostawców chmurowych i zewnętrznych, takich jak CometAPI.

Czym jest Grok Code Fast 1 i dlaczego jest to ważne?

xAI grok-code-fast-1 Jako celowo skoncentrowany model kodowania o niskim opóźnieniu, którego celem jest aktywne współdziałanie z narzędziami programistycznymi i zautomatyzowanymi przepływami pracy. Jest on pozycjonowany jako praktyczny „programista parowy” zoptymalizowany pod kątem szybkości, wykorzystania narzędzi agentowych (wyszukiwanie, wywołania funkcji, edycja kodu, testy) oraz wnioskowania w szerokim kontekście w różnych repozytoriach. Jest to specjalistyczna odmiana rodziny Grok firmy xAI, która priorytetowo traktuje dwa elementy: interaktywna prędkość oraz ekonomiczne koszty tokenów do kodowania przepływów pracy. Zamiast konkurować o miano najszerszego, multimodalnego, uniwersalnego narzędzia, koncentruje się na codziennej pracy programisty: czytaniu kodu, proponowaniu zmian, wywoływaniu narzędzi (lintersów/testów) i szybkiej iteracji.

Dlaczego to ma teraz znaczenie:

- Zespoły coraz częściej oczekują natychmiastowej informacji zwrotnej w środowiskach IDE i CI — czekanie kilku sekund na każdą iterację asystenta zaburza płynność. Grok Code Fast 1 został specjalnie zaprojektowany, aby zmniejszyć to tarcie.

- Obsługuje wywoływanie funkcji, ustrukturyzowane wyniki i widoczne ślady rozumowania, umożliwiając lepszą automatyzację zadań wieloetapowych (wyszukiwanie → edycja → testowanie → walidacja). Dzięki temu idealnie pasuje do systemów kodowania agentowego i skoordynowanych asystentów programistycznych.

Dlaczego „agentowość” ma tu znaczenie

Modele agentowe to coś więcej niż tylko „automatyczne uzupełnianie”. Potrafią:

- zdecyduj, które narzędzie zewnętrzne wywołać (uruchomić testy, pobrać dokumentację pakietu),

- podzielić zadanie na podkroki i wykonać je,

- zwracaj ustrukturyzowane wyniki JSON lub wprowadzaj zmiany w stylu git programowo.

Grok Code Fast 1 celowo ujawnia ślady swojego rozumowania (aby programiści mogli analizować tok rozumowania podczas przesyłania strumieniowego) i kładzie nacisk na natywne wywoływanie narzędzi — dwie funkcje, które wspierają bezpieczne, sterowalne kodowanie agentowe.

Wydajność i szybkość Grok Code Fast 1

Jak Grok mierzy prędkość?

„Szybkość” w brandingu modelu odnosi się do wielu wymiarów:

- Opóźnienie wnioskowania — przepustowość tokenów i czas reakcji podczas generowania kodu lub śladów wnioskowania. Model jest zoptymalizowany pod kątem mniejszych opóźnień, dzięki czemu pasuje do interaktywnych pętli IDE (autouzupełnianie, podpowiedzi kodu, szybkie poprawki błędów), a nie tylko do długotrwałych zadań wsadowych.

- Efektywność kosztowa — ustalanie cen tokenów i konfiguracja modeli mają na celu obniżenie kosztów jednostkowych dla rutynowych zadań kodowania; zewnętrzne platformy handlowe oferują je po niższych stawkach w porównaniu z większymi, bardziej ogólnymi modelami.

- Produktywność programisty — postrzegana „prędkość” w przepływie pracy: jak szybko programista może przejść od kodu gotowego do uruchomienia, w tym zdolność modelu do wywoływania funkcji i zwracania ustrukturyzowanych, możliwych do przetestowania wyników.

Notatki dotyczące wydajności w warunkach rzeczywistych

| Akcja / Model | Grok Code Fast 1 (Observed) |

|---|---|

| Proste uzupełnianie linii | Chwilowy |

| Generowanie funkcji (5-10 wierszy) | <1 sekunda |

| Generowanie złożonych komponentów/plików (ponad 50 wierszy) | 2-5 sekund |

| Refaktoryzacja dużej funkcji | 5-10 sekund |

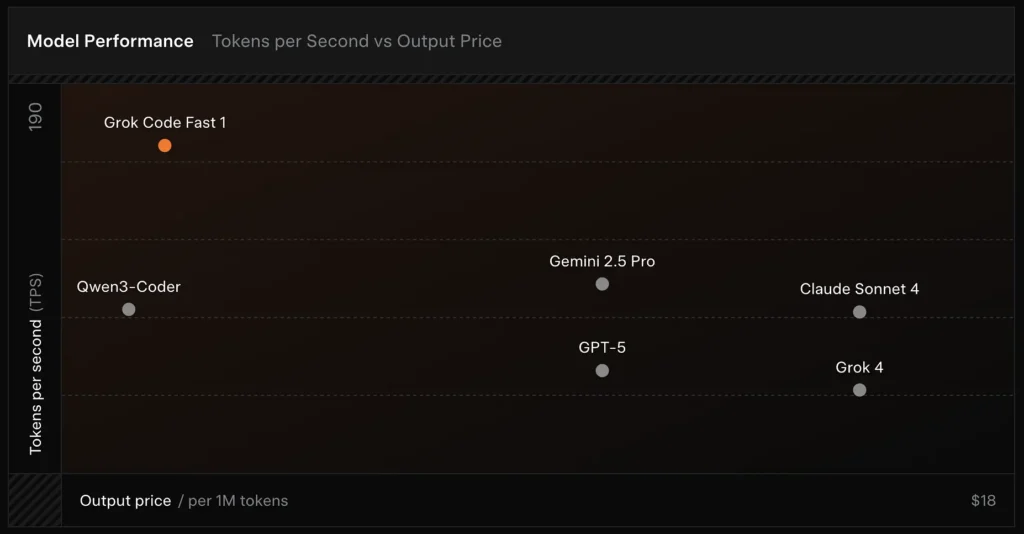

Porównanie wydajności

- Prędkość: Podczas testów osiągnięto 190 tokenów na sekundę.

- Porównanie cen: koszt GPT-5 wynosi około 18 USD za 1 mln tokenów, podczas gdy koszt Grok Code Fast-1 to zaledwie 1.50 USD.

- Dokładność: Wynik 70.8% w teście SWE-Bench-Verified.

Wybory projektowe umożliwiające szybkość

- Duże okno kontekstowe (256 tys. tokenów): umożliwia modelowi przetwarzanie dużych baz kodu lub długich historii konwersacji bez ich ucinania, zmniejszając potrzebę wielokrotnego przesyłania kontekstu.

- Monity przyjazne dla pamięci podręcznej: Model i platforma są zoptymalizowane pod kątem buforowania tokenów prefiksowych, które rzadko ulegają zmianie w trakcie wykonywania poszczególnych kroków agenta, co redukuje liczbę powtarzalnych obliczeń i zmniejsza opóźnienia w przypadku interakcji z narzędziami obejmujących wiele kroków.

- Natywny protokół wywoływania narzędzi: Zamiast doraźnego XML-a lub kruchych „wywołań funkcji” opartych na ciągach znaków, API Groka obsługuje ustrukturyzowane definicje funkcji/narzędzi, które model może wywołać podczas procesu wnioskowania (z podsumowaniami lub „śladami myślenia” przesyłanymi strumieniowo). Minimalizuje to pracę parsowania i pozwala modelowi niezawodnie łączyć wiele narzędzi.

Jakie funkcje oferuje Grok Code Fast 1?

Poniżej przedstawiono główne cechy, które sprawiają, że Grok Code Fast 1 jest atrakcyjnym rozwiązaniem dla integracji skierowanych do programistów.

Podstawowe możliwości

- Kodowanie agentowe: wbudowane wsparcie dla wywoływania narzędzi (programów do uruchamiania testów, linterów, wyszukiwania pakietów, operacji git) i tworzenia wieloetapowych przepływów pracy.

- Ślady rozumowania w strumieniowaniu: w trybie strumieniowym API wyświetla pośrednią „treść rozumowania”, dzięki czemu programiści i systemy mogą obserwować planowanie modelu i interweniować.

- Ustrukturyzowane wyniki i wywoływanie funkcji: zwraca wyniki w formacie JSON lub typowe, nadające się do programowego wykorzystania (a nie tylko tekst w dowolnej formie).

- Bardzo duży kontekst (256 tys. tokenów): wydajne w przypadku zadań wykonywanych w ramach jednej sesji i obejmujących wiele plików.

- Szybkie wnioskowanie: Innowacyjna technologia przyspieszania i natychmiastowa optymalizacja pamięci podręcznej znacznie poprawiają szybkość wnioskowania. Czas reakcji jest niezwykle szybki — użytkownik często musi wykonać dziesiątki wywołań narzędzi, zanim skończy czytać monit.

- Optymalizacja programowania agentowego: Popularne narzędzia programistyczne: grep, operacje terminalowe i edycja plików. Bezproblemowa integracja z głównymi środowiskami programistycznymi (IDE), takimi jak Cursor, GitHub Copilot i Cline.

- Zakres języków programowania: Doskonała znajomość różnych języków programowania: TypeScript, Python, Java, Rust, C++ i Go. Umiejętność radzenia sobie z pełnym zakresem zadań programistycznych, od budowania projektów od podstaw, po rozwiązywanie problemów ze złożonymi bazami kodu i wykonywanie szczegółowych poprawek błędów.

Ergonomia dla programistów

- Powierzchnia SDK zgodna z OpenAI: Interfejs API xAI kładzie nacisk na zgodność z popularnymi zestawami SDK i udostępnia wskazówki dotyczące migracji, aby skrócić proces wdrażania programistów.

- Obsługa CometAPI i BYOK: zewnętrzni dostawcy, tacy jak Interfejs API Comet Udostępnienie Grok Code Fast 1 za pośrednictwem REST dla zespołów, które preferują punkty końcowe zgodne z OpenAI. Ułatwia to integrację z łańcuchami narzędzi, które oczekują interfejsów API podobnych do OpenAI.

Czym Grok Code Fast 1 różni się od ogólnych kursów LLM?

Grok Code Fast 1 oferuje szeroki zakres flagowego modelu konwersacyjnego w zamian za ściślejsze dostosowanie kodu, narzędzi programistycznych i szybkich pętli narzędziowych. W praktyce oznacza to:

- Krótsze opóźnienie w przesyłaniu danych podczas generowania tokenów i wywoływania narzędzi.

- Bardziej przejrzyste, skoncentrowane na działaniu wyniki (ustrukturyzowane odpowiedzi, metadane JSON/wywołania funkcji).

- Model kosztów dostosowany do interakcji z kodem o dużej objętości (niższy koszt za token w wielu ofertach bramek)

Jak agentowy jest Grok Code Fast 1 — co w praktyce oznacza „kodowanie agentowe”?

„Agentny” oznacza, że model może planować i wykonywać wieloetapowe zadania z wykorzystaniem interakcji z narzędziami zewnętrznymi. W przypadku Grok Code Fast 1 moc agenta przybiera następujące formy:

- Wywołanie funkcji:Grok może żądać wywołań funkcji zewnętrznych (np. uruchamiania testów, pobierania plików, wywoływania linterów) i uwzględniać zwrócone wyniki w celu podejmowania dalszych decyzji.

- Widoczne ślady rozumowania:wyniki mogą zawierać rozumowanie krok po kroku, które można analizować i wykorzystywać do debugowania lub sterowania zachowaniem agenta. Ta transparentność pomaga w automatyzacji zmian w bazie kodu.

- Trwałe pętle narzędzi:Grok został zaprojektowany do stosowania w krótkich, powtarzalnych cyklach planowania→wykonywania→weryfikacji, a nie do oczekiwania pojedynczej, monolitycznej odpowiedzi.

Przykłady zastosowań, w których zachowanie agenta przynosi największe korzyści

- Automatyczna naprawa kodu: lokalizowanie nieudanych testów, proponowanie zmian, uruchamianie testów, iterowanie.

- Analiza repozytorium: wyszukiwanie wzorców wykorzystania w tysiącach plików, tworzenie podsumowań lub proponowanie refaktoryzacji z odniesieniami do konkretnych plików/linii.

- Wspomagane generowanie PR: tworzenie opisów PR, generowanie poprawek różnic i adnotacje do testów — wszystko w ramach zorganizowanego przepływu, który można uruchomić w ramach CI.

W jaki sposób programiści mogą uzyskać dostęp do interfejsu API Grok Code Fast 1 i z niego korzystać?

xAI udostępnia modele Grok poprzez swoje publiczne API i integracje partnerskie. Istnieją trzy popularne wzorce dostępu:

- Bezpośredni interfejs API xAI — utwórz konto xAI, wygeneruj klucz API w konsoli i wywołaj punkty końcowe REST. Dokumentacja xAI przedstawia bazę REST jako

https://api.x.aii określić standardowe uwierzytelnianie tokenem Bearer. Dokumentacja i przewodniki zawierają przykłady użycia curl i SDK oraz podkreślają kompatybilność z żądaniami w stylu OpenAI dla wielu warstw narzędzi. - Partnerzy IDE/usługowi (integracje w wersji zapoznawczej) — GitHub Copilot (publiczna wersja zapoznawcza z opcją zapisu) i inni partnerzy (Cursor, Cline itp.) zostali ogłoszeni jako współpracownicy przy uruchomieniu, udostępniając Grok Code Fast 1 w VS Code i podobnych narzędziach, czasami poprzez przepływy „przynieś własny klucz”. Jeśli korzystasz z Copilot w wersji Pro lub Enterprise, poszukaj opcji zapisu Grok Code Fast 1.

- Bramy zewnętrzne (CometAPI, agregatory API) — dostawcy normalizują wywołania API u różnych dostawców i czasami prezentują różne poziomy stawek (co jest pomocne przy prototypowaniu lub w przypadku zapasowych rozwiązań obejmujących wielu dostawców). Interfejs API Comet i inne rejestry zawierają konteksty modeli, przykładowe ceny i przykładowe wywołania.

Poniżej znajdują się dwa praktyczne przykłady kodu (strumieniowanie natywnego zestawu SDK języka Python i REST za pośrednictwem Interfejs API Comet) ilustrujące sposób wykorzystania Grok Code Fast 1 w prawdziwej aplikacji.

Zaprojektuj swoje narzędzia: zarejestruj definicje funkcji/narzędzi w żądaniu, aby model mógł je wywołać; w przypadku przesyłania strumieniowego przechwyć

reasoning_contentaby monitorować plan modelu.

Kod przypadku użycia: Python (natywny zestaw SDK xAI, próbnik strumieniowy)

Ten przykład został zaadaptowany ze wzorców dokumentacji xAI. Zastąp

XAI_API_KEYz prawdziwym kluczem i dostosuj definicje narzędzi do swojego środowiska. Streaming pokazuje tokeny i ślady wnioskowania.

# Save as grok_code_fast_example.py

import os

import asyncio

# Hypothetical xai_sdk per xAI docs

import xai_sdk

API_KEY = os.getenv("XAI_API_KEY") # store your key securely

async def main():

client = xai_sdk.Client(api_key=API_KEY)

# Example: ask the model to add a unit test and fix failing code

prompt = """

Repo structure:

/src/math_utils.py

/tests/test_math_utils.py

Task: run the tests, identify the first failing test case, and modify src/math_utils.py

to fix the bug. Show the minimal code diff and run tests again.

"""

# Start a streaming sample; we want to see reasoning traces

async for chunk in client.sampler.sample(

model="grok-code-fast-1",

prompt=prompt,

max_len=1024,

stream=True,

return_reasoning=True, # stream reasoning_content when available

):

# chunk may include tokens and reasoning traces

if hasattr(chunk, "delta"):

if getattr(chunk.delta, "reasoning_content", None):

# model is exposing its internal planning steps

print("", chunk.delta.reasoning_content, flush=True)

if getattr(chunk.delta, "token_str", None):

print(chunk.delta.token_str, end="", flush=True)

if __name__ == "__main__":

asyncio.run(main())

Komentarz

return_reasoning=Trueflaga reprezentuje wytyczne dokumentacji dotyczące strumieniowego śledzenia rozumowania — przechwytuj je i wyświetlaj, aby móc audytować plan modelu.- W rzeczywistym środowisku agentowym należy również zarejestrować narzędzia (np.

run_tests,apply_patch) i autoryzować model do ich wywołania. Model może następnie zdecydować o wywołaniurun_tests()i użyj wyników do poinformowania o poprawce.

Kod przypadku użycia: REST (zgodny z CometAPI / OpenAI)

Jeśli Twój stos oczekuje punktów końcowych REST w stylu OpenAI, Interfejs API Comet wystawiony

grok-code-fast-1jako zgodny ciąg modelu. Poniższy przykład wykorzystujeopenai-stylu wzorca klienta.

import os

import requests

CometAPI_KEY = os.getenv("CometAPI_API_KEY")

BASE = "https://api.cometapi.com/v1/chat/completions"

headers = {

"Authorization": f"Bearer {CometAPI_KEY}",

"Content-Type": "application/json",

}

payload = {

"model": "grok-code-fast-1",

"messages": [

{"role": "system", "content": "You are Grok Code Fast 1, a fast coding assistant."},

{"role": "user", "content": "Write a function in Python that merges two sorted lists into one sorted list."}

],

"max_tokens": 300,

"stream": False

}

resp = requests.post(BASE, json=payload, headers=headers)

resp.raise_for_status()

print(resp.json())

Komentarz

- Interfejs API Comet działa jako most, gdy dostęp do natywnego gRPC lub SDK w Twoim środowisku jest problematyczny; obsługuje ten sam kontekst 256k i udostępnia

grok-code-fast-1Sprawdź dostępność dostawcy i limity stawek.

Jakie są praktyczne wzorce integracji i najlepsze praktyki?

IDE-first (programowanie w parach)

Osadź Grok Code Fast 1 jako model uzupełniania/asystenta w VS Code lub innych IDE. Używaj krótkich monitów, które proszą o drobne, testowalne zmiany. Utrzymuj asystenta w ścisłej pętli: generuj poprawkę → uruchamiaj testy → ponownie uruchamiaj asystenta z nieudanym wynikiem testu.

Automatyzacja CI

Użyj Grok Code Fast 1 do selektywnej analizy niestabilnych awarii, sugerowania poprawek lub automatycznego generowania testów jednostkowych dla nowo dodanego kodu. Ze względu na cenę i architekturę zapewniającą niskie opóźnienia, Grok Code Fast 1 nadaje się do częstych uruchomień CI w porównaniu z droższymi modelami ogólnymi.

Orkiestracja agentów

Połącz model z solidnymi zabezpieczeniami narzędziowymi: zawsze wykonuj proponowane poprawki w piaskownicy, uruchamiaj pełny zestaw testów i wymagaj weryfikacji przez człowieka w przypadku nietrywialnych zmian w zabezpieczeniach lub projekcie. Używaj widocznych śladów wnioskowania, aby audytować działania i zapewnić ich powtarzalność.

Szybkie porady inżynierskie

- Dostarcz modelowi dokładne pliki lub małe, kontekstowe okno do edycji.

- Preferuj strukturalne schematy wyjściowe dla różnic lub podsumowań JSON — łatwiej je automatycznie zweryfikować.

- Podczas uruchamiania przepływów wieloetapowych rejestruj wywołania narzędzi i wyniki modelu, aby móc odtworzyć lub debugować zachowanie agenta.

Konkretny przypadek użycia: automatyczna naprawa nieudanego testu pytest

Poniżej znajduje się przykładowy przepływ pracy w Pythonie (uproszczony) pokazujący, w jaki sposób można zintegrować Grok Code Fast 1 z pętlą testowania i naprawiania błędów.

# pseudo-code: agentic test-fix loop with grok-code-fast-1

# 1) collect failing test output

failing_test_output = run_pytest_and_capture("tests/test_math.py")

# 2) ask Grok to propose a patch and tests

prompt = f"""

Pyproject: repo root

Failing test output:

{failing_test_output}

Please:

1) Explain root cause briefly.

2) Provide a patch in unified diff format that should fix the issue.

3) Suggest a minimal new/updated unit test to prove the fix.

"""

resp = call_grok_model("grok-code-fast-1", prompt, show_reasoning=True)

# 3) parse structured patch from response (validate!)

patch = extract_patch_from_response(resp)

if is_patch_safe(patch):

apply_patch(patch)

test_result = run_pytest_and_capture("tests/test_math.py")

report_back_to_grok(test_result)

else:

alert_human_review(resp)

Pętla ta pokazuje, w jaki sposób można wdrożyć zachowanie agenta (propozycja → walidacja → uruchomienie → iteracja), zachowując jednocześnie kontrolę nad wdrażaniem zmian.

Jak zacząć

CometAPI to ujednolicona platforma API, która agreguje ponad 500 modeli AI od wiodących dostawców — takich jak seria GPT firmy OpenAI, Gemini firmy Google, Claude firmy Anthropic, Midjourney, Suno i innych — w jednym, przyjaznym dla programistów interfejsie. Oferując spójne uwierzytelnianie, formatowanie żądań i obsługę odpowiedzi, CometAPI radykalnie upraszcza integrację możliwości AI z aplikacjami. Niezależnie od tego, czy tworzysz chatboty, generatory obrazów, kompozytorów muzycznych czy oparte na danych potoki analityczne, CometAPI pozwala Ci szybciej iterować, kontrolować koszty i pozostać niezależnym od dostawcy — wszystko to przy jednoczesnym korzystaniu z najnowszych przełomów w ekosystemie AI.

Deweloperzy mogą uzyskać dostęp Grok Code Fast 1 API poprzez CometAPI,najnowsza wersja modelu jest zawsze aktualizowany na oficjalnej stronie internetowej. Na początek zapoznaj się z możliwościami modelu w Plac zabaw i zapoznaj się z Przewodnik po API aby uzyskać szczegółowe instrukcje. Przed uzyskaniem dostępu upewnij się, że zalogowałeś się do CometAPI i uzyskałeś klucz API. Interfejs API Comet zaoferuj cenę znacznie niższą niż oficjalna, aby ułatwić Ci integrację.

Gotowy do drogi?→ Zarejestruj się w CometAPI już dziś !

Podsumowanie

Grok Code Fast 1 nie jest reklamowany jako jedyny „najlepszy” model do każdego zadania. To raczej specjalista — dostrojony do opartych na agentach, bogatych w narzędzia przepływów pracy, w których szybkość, szerokie okno kontekstowe i niski koszt iteracji mają największe znaczenie. To połączenie sprawia, że jest to praktyczne narzędzie codziennego użytku dla wielu zespołów inżynierskich: wystarczająco szybkie do pracy z edytorem na żywo, wystarczająco tanie do iteracji i wystarczająco transparentne, aby można je było bezpiecznie zintegrować z odpowiednimi ograniczeniami.