Quando a xAI anunciou Grok Code Fast 1 No final de agosto de 2025, a comunidade de IA recebeu um sinal claro: o Grok não é mais apenas um assistente de conversação — ele está sendo transformado em uma arma para fluxos de trabalho de desenvolvedores. Grok Code Fast 1 (resumo: Código Rápido 1) é um modelo de raciocínio de baixa latência e baixo custo, desenvolvido especificamente para tarefas de codificação e agente Fluxos de trabalho de codificação — ou seja, fluxos de trabalho em que o modelo pode planejar, chamar ferramentas e atuar como um assistente de codificação autônomo dentro de IDEs e pipelines. O modelo já começou a aparecer em integrações de parceiros (principalmente como uma prévia opt-in no GitHub Copilot) e em diversos catálogos de provedores de nuvem e de terceiros, como o CometAPI.

O que é o Grok Code Fast 1 e por que ele é importante?

xAI's grok-code-fast-1 Como um modelo de codificação deliberadamente focado e de baixa latência, que visa ser um parceiro ativo em ferramentas de desenvolvimento e fluxos de trabalho automatizados. Posicionado como um "programador em pares" prático, otimizado para velocidade, uso de ferramentas agênticas (busca, chamadas de função, edições de código, testes) e raciocínio de amplo contexto em repositórios, é uma variante especializada na família Grok da xAI que prioriza duas coisas: velocidade interativa e custos econômicos de tokens para fluxos de trabalho de codificação. Em vez de competir para ser o generalista mais amplo e multimodal, ele se concentra no ciclo diário do desenvolvedor: ler código, propor edições, chamar ferramentas (linters/testes) e iterar rapidamente.

Por que isso importa agora:

- As equipes esperam cada vez mais feedback instantâneo dentro de IDEs e CIs — esperar vários segundos para cada iteração do assistente interrompe o fluxo. O Grok Code Fast 1 foi projetado explicitamente para reduzir esse atrito.

- ele suporta chamadas de função, saídas estruturadas e rastros de raciocínio visíveis, permitindo melhor automação de tarefas multietapas (pesquisar → editar → testar → validar). Isso o torna uma opção natural para sistemas de codificação agêntica e assistentes de desenvolvimento orquestrados.

Por que “agente” é importante aqui

Os modelos Agentic são mais do que “autocompletar”. Eles podem:

- decidir qual ferramenta externa chamar (executar testes, buscar documentos do pacote),

- dividir uma tarefa em subetapas e executá-las,

- retornar resultados JSON estruturados ou fazer alterações no estilo git programaticamente.

O Grok Code Fast 1 expõe deliberadamente seus rastros de raciocínio (para que os desenvolvedores possam inspecionar a cadeia de pensamento durante o streaming) e enfatiza a chamada de ferramentas nativas — dois recursos que oferecem suporte à codificação de agente segura e orientável.

Desempenho e velocidade Grok Code Fast 1

Como o Grok mede a velocidade?

“Rápido” na marca do modelo refere-se a múltiplas dimensões:

- latência de inferência — taxa de transferência de tokens e tempo de resposta ao gerar código ou rastrear rastros de raciocínio. O modelo é otimizado para menor latência, permitindo loops interativos do IDE (preenchimento automático, sugestões de código, correções rápidas de bugs) em vez de apenas tarefas de lote longo.

- Eficiência de custos — o preço do token e a configuração do modelo visam reduzir o custo por uso para tarefas de codificação de rotina; mercados de terceiros o listam com taxas mais baixas em comparação com modelos maiores e mais gerais.

- Produtividade do desenvolvedor — “velocidade” percebida em um fluxo de trabalho: a rapidez com que um desenvolvedor pode ir do prompt ao código executável, incluindo a capacidade do modelo de chamar funções e retornar saídas estruturadas e testáveis.

Notas de desempenho no mundo real

| Ação / Modelo | Grok Code Fast 1 (Observado) |

|---|---|

| Completação de linha simples | Instantâneo |

| Geração de funções (5-10 linhas) | <1 segundo |

| Geração de componentes/arquivos complexos (mais de 50 linhas) | segundo 2-5 |

| Refatorando uma função grande | segundo 5-10 |

Comparação de desempenho

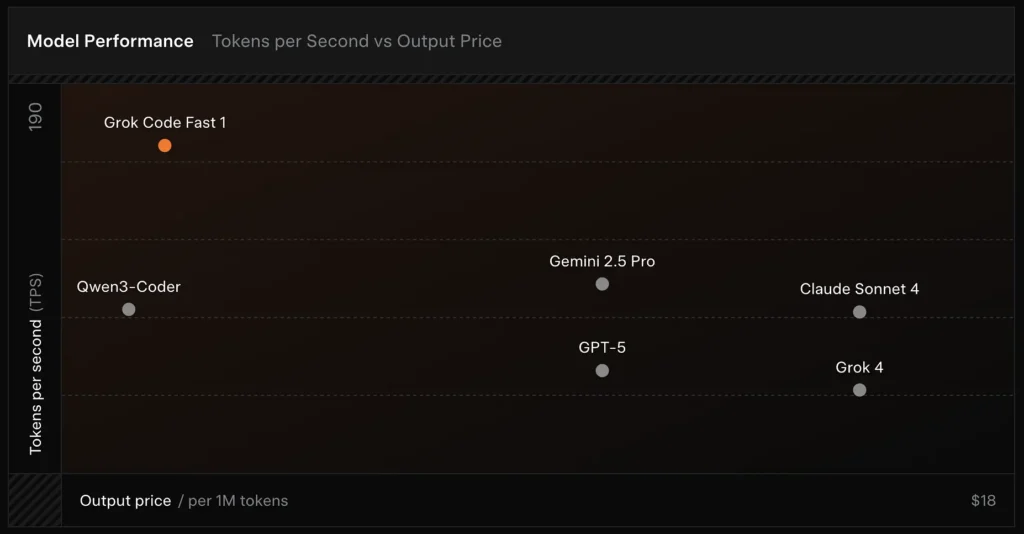

- Velocidade: Atingiu 190 tokens/segundo no teste.

- Comparação de preços: a saída do GPT-5 custa aproximadamente US$ 18 por 1 milhão de tokens, enquanto o Grok Code Fast-1 custa apenas US$ 1.50.

- Precisão: obteve 70.8% no benchmark SWE-Bench-Verified.

Escolhas de design que permitem velocidade

- Grande janela de contexto (256 mil tokens): permite que o modelo ingira grandes bases de código ou longos históricos de conversas sem truncamento, reduzindo a necessidade de uploads repetidos de contexto.

- Prompt amigável ao cache: o modelo e a plataforma são otimizados para armazenar em cache tokens de prefixo que raramente mudam entre as etapas do agente, o que reduz a computação repetida e melhora a latência para interações de ferramentas em várias etapas.

- Protocolo de chamada de ferramenta nativa: Em vez de XML ad hoc ou "chamadas de função" baseadas em strings frágeis, a API da Grok suporta definições estruturadas de funções/ferramentas que o modelo pode invocar durante seu processo de raciocínio (com resumos ou "rastros de pensamento" transmitidos de volta). Isso minimiza o trabalho de análise e permite que o modelo combine várias ferramentas de forma confiável.

Quais recursos o Grok Code Fast 1 oferece?

Abaixo estão os principais recursos que tornam o Grok Code Fast 1 atraente para integrações voltadas para desenvolvedores.

Capacidades principais

- Codificação agêntica: suporte integrado para chamar ferramentas (executores de teste, linters, pesquisas de pacotes, operações git) e compor fluxos de trabalho de várias etapas.

- Rastros de raciocínio em streaming: quando usada no modo de streaming, a API exibe “conteúdo de raciocínio” intermediário para que desenvolvedores e sistemas possam observar o planejamento do modelo e intervir.

- Saídas estruturadas e chamadas de função: retorna JSON ou resultados digitados adequados para consumo programático (não apenas texto de formato livre).

- Contexto muito grande (256 mil tokens): poderoso para tarefas de sessão única e entre arquivos.

- Inferência rápida: A tecnologia de aceleração inovadora e a otimização do cache de prompt melhoram significativamente a velocidade de inferência. A velocidade de resposta é extremamente rápida, muitas vezes concluindo dezenas de chamadas de ferramentas antes que o usuário termine de ler um prompt.

- Otimização de Programação Agêntica: Ferramentas comuns de desenvolvimento: grep, operações de terminal e edição de arquivos. Integração perfeita com os principais IDEs, como Cursor, GitHub Copilot e Cline.

- Cobertura de Linguagem de Programação: Excelentes habilidades em diversas linguagens: TypeScript, Python, Java, Rust, C++ e Go. Capaz de lidar com uma gama completa de tarefas de desenvolvimento, desde a criação de projetos do zero até a solução de problemas de bases de código complexas e a execução de correções detalhadas de bugs.

Ergonomia do desenvolvedor

- Superfície do SDK compatível com OpenAI: A API do xAI enfatiza a compatibilidade com SDKs populares e fornece orientação de migração para encurtar a integração do desenvolvedor.

- Suporte a CometAPI e BYOK: provedores terceirizados como CometAPI Exponha o Grok Code Fast 1 via REST para equipes que preferem endpoints compatíveis com OpenAI. Isso facilita a integração em cadeias de ferramentas que esperam APIs semelhantes às do OpenAI.

Como o Grok Code Fast 1 é diferente dos LLMs de uso geral?

O Grok Code Fast 1 troca parte da amplitude de um modelo conversacional emblemático por um ajuste mais preciso em relação ao código, às ferramentas de desenvolvimento e aos ciclos rápidos de ferramentas. Na prática, isso significa:

- Latência de ida e volta mais rápida para geração de tokens e chamadas de ferramentas.

- Resultados mais nítidos e focados em ações (respostas estruturadas, metadados de chamadas de função/JSON).

- Modelo de custo ajustado para interações de código de alto volume (mais barato por token em muitas listagens de gateway)

Quão agêntico é o Grok Code Fast 1 — o que significa “codificação agêntica” na prática?

“Agentic” significa que o modelo pode planejar e executar tarefas multietapas com interações de ferramentas externas. Para o Grok Code Fast 1, o poder agentic assume as seguintes formas:

- Chamada de função: O Grok pode solicitar chamadas para funções externas (por exemplo, executar testes, buscar arquivos, chamar linters) e incorporar os resultados retornados para decisões de acompanhamento.

- Traços de raciocínio visíveis: as saídas podem incluir raciocínio passo a passo que você pode inspecionar e usar para depurar ou direcionar o comportamento do agente. Essa transparência ajuda na automatização de alterações em uma base de código.

- Loops de ferramentas persistentes: O Grok foi projetado para ser usado em ciclos curtos e repetidos de planejamento→execução→verificação, em vez de esperar uma única resposta monolítica.

Casos de uso que mais se beneficiam do comportamento do agente

- Reparo automatizado de código: localize testes com falha, proponha edições, execute testes, itere.

- Análise de repositório: pesquise padrões de uso em milhares de arquivos, crie resumos ou proponha refatorações com citações para arquivos/linhas exatos.

- Geração de RP assistida: componha descrições de RP, gere patches de diferenças e anote testes — tudo dentro de um fluxo orquestrado que pode ser executado em CI.

Como os desenvolvedores podem acessar e usar a API do Grok Code Fast 1?

O xAI expõe os modelos Grok por meio de sua API pública e integrações com parceiros. Há três padrões de acesso comuns:

- API xAI direta — crie uma conta xAI, gere uma chave de API no console e chame os endpoints REST. A documentação do xAI mostra a base REST como

https://api.x.aie especificar a autenticação padrão do token Bearer. Os documentos e guias fornecem exemplos de curl e SDK e enfatizam a compatibilidade com solicitações no estilo OpenAI para diversas camadas de ferramentas. - Parceiros de IDE/serviço (integrações de pré-visualização) — O GitHub Copilot (prévia pública opcional) e outros parceiros (Cursor, Cline, etc.) foram anunciados como colaboradores de lançamento, habilitando o Grok Code Fast 1 dentro do VS Code e ferramentas similares, às vezes por meio de fluxos "traga sua própria chave". Se você usa o Copilot para os níveis Pro ou Enterprise, procure a opção de adesão do Grok Code Fast 1.

- Gateways de terceiros (CometAPI, agregadores de API) — os fornecedores normalizam as chamadas de API entre provedores e, às vezes, apresentam diferentes níveis de taxas (útil para prototipagem ou fallbacks de vários provedores). CometAPI e outros registros listam contextos de modelos, preços de amostra e chamadas de exemplo.

Abaixo estão dois exemplos práticos de código (streaming de SDK nativo Python e REST via CometAPI) que ilustram como você pode executar o Grok Code Fast 1 em um aplicativo real.

Projete suas ferramentas: registrar definições de função/ferramenta na solicitação para que o modelo possa chamá-las; para streaming, capturar

reasoning_contentpara monitorar o plano do modelo.

Código do caso de uso: Python (SDK xAI nativo, amostrador de streaming)

Este exemplo é uma adaptação dos padrões de documentação do xAI. Substituir

XAI_API_KEYcom sua chave real e ajuste as definições da ferramenta ao seu ambiente. O streaming mostra tokens e rastros de raciocínio.

# Save as grok_code_fast_example.py

import os

import asyncio

# Hypothetical xai_sdk per xAI docs

import xai_sdk

API_KEY = os.getenv("XAI_API_KEY") # store your key securely

async def main():

client = xai_sdk.Client(api_key=API_KEY)

# Example: ask the model to add a unit test and fix failing code

prompt = """

Repo structure:

/src/math_utils.py

/tests/test_math_utils.py

Task: run the tests, identify the first failing test case, and modify src/math_utils.py

to fix the bug. Show the minimal code diff and run tests again.

"""

# Start a streaming sample; we want to see reasoning traces

async for chunk in client.sampler.sample(

model="grok-code-fast-1",

prompt=prompt,

max_len=1024,

stream=True,

return_reasoning=True, # stream reasoning_content when available

):

# chunk may include tokens and reasoning traces

if hasattr(chunk, "delta"):

if getattr(chunk.delta, "reasoning_content", None):

# model is exposing its internal planning steps

print("", chunk.delta.reasoning_content, flush=True)

if getattr(chunk.delta, "token_str", None):

print(chunk.delta.token_str, end="", flush=True)

if __name__ == "__main__":

asyncio.run(main())

Notas

- O

return_reasoning=TrueO sinalizador representa a orientação dos documentos para transmitir rastros de raciocínio — capture e exiba-os para que você possa auditar o plano do modelo. - Em uma configuração de agente real, você também registraria ferramentas (por exemplo,

run_tests,apply_patch) e autorizar o modelo a chamá-los. O modelo pode então decidir invocarrun_tests()e usar saídas para informar um patch.

Código do caso de uso: REST (compatível com CometAPI / OpenAI)

Se sua pilha espera endpoints REST no estilo OpenAI, CometAPI expõe

grok-code-fast-1como uma string de modelo compatível. O exemplo abaixo usa oopenaipadrão de cliente estilo.

import os

import requests

CometAPI_KEY = os.getenv("CometAPI_API_KEY")

BASE = "https://api.cometapi.com/v1/chat/completions"

headers = {

"Authorization": f"Bearer {CometAPI_KEY}",

"Content-Type": "application/json",

}

payload = {

"model": "grok-code-fast-1",

"messages": [

{"role": "system", "content": "You are Grok Code Fast 1, a fast coding assistant."},

{"role": "user", "content": "Write a function in Python that merges two sorted lists into one sorted list."}

],

"max_tokens": 300,

"stream": False

}

resp = requests.post(BASE, json=payload, headers=headers)

resp.raise_for_status()

print(resp.json())

Notas

- CometAPI atua como uma ponte quando o acesso nativo ao gRPC ou SDK é problemático em seu ambiente; ele suporta o mesmo contexto de 256k e expõe

grok-code-fast-1. Verifique a disponibilidade do provedor e os limites de tarifas.

Quais são os padrões de integração práticos e as melhores práticas?

IDE-first (programação em pares)

Incorpore o Grok Code Fast 1 como modelo de conclusão/assistente dentro do VS Code ou outros IDEs. Use prompts curtos que solicitem pequenas edições testáveis. Mantenha o assistente em um ciclo preciso: gere o patch → execute os testes → execute o assistente novamente com a saída do teste com falha.

Automação de CI

Use o Grok Code Fast 1 para triar falhas, sugerir correções ou gerar testes unitários automaticamente para código recém-adicionado. Por ter um preço e arquitetura projetados para baixa latência, ele é adequado para execuções frequentes de CI em comparação com modelos generalistas mais caros.

Orquestração de agentes

Combine o modelo com proteções de ferramentas robustas: sempre execute os patches propostos em uma sandbox, execute o conjunto completo de testes e exija revisão humana para alterações não triviais de segurança ou design. Use rastros de raciocínio visíveis para auditar ações e torná-las reproduzíveis.

Dicas rápidas de engenharia

- Forneça ao modelo os arquivos exatos ou uma pequena janela de contexto focada para edições.

- Prefira esquemas de saída estruturados para diffs ou resumos JSON — eles são mais fáceis de validar automaticamente.

- Ao executar fluxos de várias etapas, registre as chamadas de ferramentas e os resultados do modelo para que você possa reproduzir ou depurar o comportamento do agente.

Caso de uso concreto: correção automática de um teste pytest com falha

Abaixo está um fluxo de trabalho Python ilustrativo (simplificado) mostrando como você pode integrar o Grok Code Fast 1 em um loop de teste e correção.

# pseudo-code: agentic test-fix loop with grok-code-fast-1

# 1) collect failing test output

failing_test_output = run_pytest_and_capture("tests/test_math.py")

# 2) ask Grok to propose a patch and tests

prompt = f"""

Pyproject: repo root

Failing test output:

{failing_test_output}

Please:

1) Explain root cause briefly.

2) Provide a patch in unified diff format that should fix the issue.

3) Suggest a minimal new/updated unit test to prove the fix.

"""

resp = call_grok_model("grok-code-fast-1", prompt, show_reasoning=True)

# 3) parse structured patch from response (validate!)

patch = extract_patch_from_response(resp)

if is_patch_safe(patch):

apply_patch(patch)

test_result = run_pytest_and_capture("tests/test_math.py")

report_back_to_grok(test_result)

else:

alert_human_review(resp)

Este loop mostra como o comportamento do agente (propor → validar → executar → iterar) pode ser implementado enquanto o desenvolvedor mantém o controle sobre a aplicação das alterações.

Começando a jornada

A CometAPI é uma plataforma de API unificada que agrega mais de 500 modelos de IA de provedores líderes — como a série GPT da OpenAI, a Gemini do Google, a Claude da Anthropic, a Midjourney e a Suno, entre outros — em uma interface única e amigável ao desenvolvedor. Ao oferecer autenticação, formatação de solicitações e tratamento de respostas consistentes, a CometAPI simplifica drasticamente a integração de recursos de IA em seus aplicativos. Seja para criar chatbots, geradores de imagens, compositores musicais ou pipelines de análise baseados em dados, a CometAPI permite iterar mais rapidamente, controlar custos e permanecer independente de fornecedores — tudo isso enquanto aproveita os avanços mais recentes em todo o ecossistema de IA.

Os desenvolvedores podem acessar API Grok Code Fast 1 através do CometAPI,a versão mais recente do modelo está sempre atualizado com o site oficial. Para começar, explore as capacidades do modelo no Playground e consulte o Guia de API para obter instruções detalhadas. Antes de acessar, certifique-se de ter feito login no CometAPI e obtido a chave da API. CometAPI oferecem um preço muito mais baixo que o preço oficial para ajudar você a se integrar.

Pronto para ir?→ Inscreva-se no CometAPI hoje mesmo !

Conclusão

O Grok Code Fast 1 não é considerado o “melhor” modelo para todos os trabalhos. Em vez disso, é um especialista — otimizado para fluxos de trabalho de codificação com agentes e ferramentas avançadas, onde velocidade, uma ampla janela de contexto e baixo custo por iteração são os mais importantes. Essa combinação o torna um recurso prático para o dia a dia de muitas equipes de engenharia: rápido o suficiente para experiências de editor ao vivo, barato o suficiente para iterar e suficientemente transparente para ser integrado com segurança dentro dos limites apropriados.