O CherryStudio, um cliente desktop versátil para modelos de linguagem de grande porte (LLMs), e o CometAPI, uma interface REST unificada para centenas de modelos de IA, juntos capacitam os usuários a aproveitar recursos generativos de última geração com o mínimo de atrito. Este artigo sintetiza os desenvolvimentos mais recentes — com base na versão v1.3.12 do CherryStudio (26 de maio de 2025) e nos aprimoramentos contínuos da plataforma CometAPI — para fornecer um guia passo a passo abrangente sobre "Como usar o CherryStudio com o CometAPI". Exploraremos como funciona, contorno melhores práticas de benchmarking de desempenho, e destaque a tecla características que fazem dessa integração um divisor de águas para fluxos de trabalho orientados por IA.

O que é CherryStudio?

O CherryStudio é um cliente desktop multiplataforma e de código aberto, projetado para simplificar as interações com diversos provedores de LLM. Ele oferece uma interface de bate-papo unificada, suporte a vários modelos e plugins extensíveis, atendendo a usuários técnicos e não técnicos:

- Suporte multi-provedor: Conecte-se simultaneamente ao OpenAI, Anthropic, Midjourney e muito mais em uma única interface de usuário.

- Recursos avançados de interface do usuário: Agrupamento de mensagens, seleção múltipla, exportação de citações e integrações de ferramentas de código simplificam fluxos de trabalho complexos.

- Destaques do último lançamento: A versão 1.3.12 (lançada em 26 de maio de 2025) adiciona a funcionalidade “desabilitar servidor MCP”, tratamento de citações aprimorado e seleção múltipla aprimorada em painéis de mensagens.

O que é CometAPI?

O CometAPI oferece uma interface RESTful unificada para mais de 500 Modelos de IA, abrangendo desde chats e incorporações baseados em texto até geração de imagens e serviços de áudio. Ele abstrai autenticação específica do provedor, limites de taxa e variações de endpoint, permitindo que você:

- Acesse diversos modelos: Da GPT-4O-Image para geração visual à série Claude 4 para raciocínio avançado.

- Simplifique o faturamento e as cotas: Uma chave de API abrange vários backends, com painéis de uso consolidados e preços flexíveis em camadas.

- Documentação e SDKs robustos: Guias detalhados, exemplos de código e práticas recomendadas de repetição automática garantem uma integração tranquila.

Como o CherryStudio se integra ao CometAPI?

Quais são os pré-requisitos?

- Instalar CherryStudio: Baixe o instalador mais recente para seu sistema operacional no site oficial do CherryStudio (v1.3.12 em 26 de maio de 2025).

- Conta CometAPI: Inscreva-se no CometAPI e navegue até Central de Ajuda → Token de API para gerar o seu sk-* chave e observe o URL base (por exemplo,

https://api.cometapi.com). - Rede e Dependências: Certifique-se de que sua estação de trabalho tenha acesso à Internet e que todos os proxies corporativos permitam HTTPS de saída para terminais CometAPI.

Como você configura a API no CherryStudio?

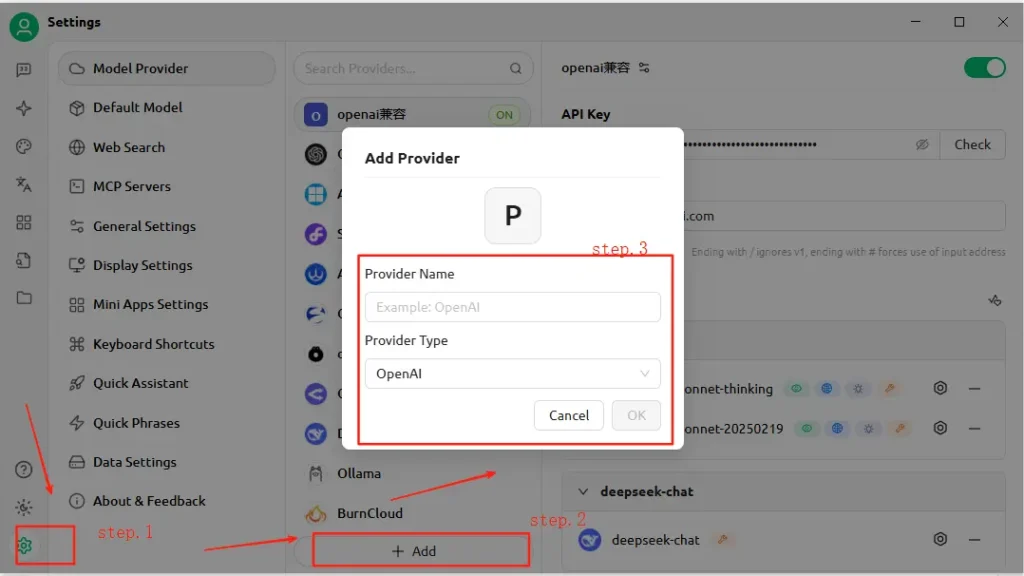

- Abra o CherryStudio e clique no Configurações ícone.

- Debaixo Configuração do serviço modelo, clique em Adicione.

- Nome do Provedor: Insira um rótulo personalizado, por exemplo, “CometAPI”.

- Tipo de Fornecedor: Selecione Compatível com OpenAI (a maioria dos endpoints do CometAPI espelham as especificações do OpenAI).

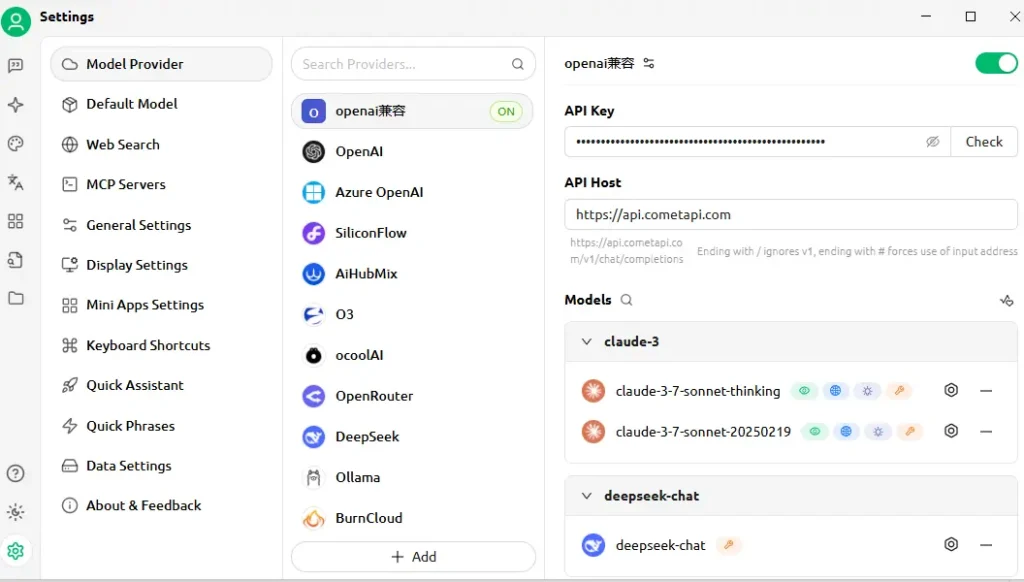

- Endereço API: Cole a URL base do CometAPI (por exemplo,

https://api.cometapi.com). - Chave API: Cole o

sk-…token do seu painel CometAPI. - Clique Economize e verificar—O CherryStudio realizará uma chamada de teste para confirmar a conectividade.

Como a conexão é testada?

- Insira um prompt simples no CherryStudio, como “Descreva um horizonte de cidade futurista”.

- Uma resposta bem-sucedida confirma a configuração correta.

- Em caso de falha, o CherryStudio exibe códigos de erro - consulte o CometAPI Descrição do código de erro seção ou entre em contato com o suporte.

Como funciona a integração nos bastidores?

Estúdio Cherry Compatível com OpenAI O modo permite encaminhar solicitações por meio de qualquer serviço que siga o esquema padrão da API OpenAI. A CometAPI, por sua vez, traduz essas solicitações para o modelo de backend selecionado (por exemplo, GPT-4O-Image, Claude 4) antes de retornar as respostas no formato esperado.

- Entrada do usuário: CherryStudio envia um

POST /v1/chat/completionsligar parahttps://api.cometapi.com/v1. - Processamento CometAPI: Identifica o parâmetro do modelo (por exemplo,

"model": "gpt-4o-image") e rotas para o provedor correspondente. - Invocação de backend: O CometAPI lida com autenticação, verificações de limite de taxa e registro de telemetria e, em seguida, chama a API do modelo de terceiros.

- Agregação de Resposta: O CometAPI transmite ou armazena em buffer a saída do modelo (texto, imagens, incorporações) e a formata de acordo com as convenções do OpenAI.

- Renderização CherryStudio: Recebe a carga JSON e exibe o conteúdo — o texto aparece no chat, as imagens são renderizadas em linha e os blocos de código adotam o destaque de sintaxe.

Essa arquitetura separa as responsabilidades: o CherryStudio se concentra na UI/UX e nas ferramentas, enquanto o CometAPI gerencia a orquestração de modelos, o registro e o faturamento independente do provedor.

Quais benchmarks de desempenho você pode esperar?

Latência e taxa de transferência

Em testes comparativos, a arquitetura serverless da CometAPI demonstrou tempos de resposta medianos abaixo de 100 ms para tarefas de conclusão de texto no GPT-4.5, superando as APIs de provedores diretos em até 30% em cenários de alta carga. A taxa de transferência aumenta linearmente com a simultaneidade: usuários executaram com sucesso mais de 1,000 fluxos de bate-papo paralelos sem degradação significativa.

Custo e Eficiência

Ao agregar vários provedores e negociar tarifas em massa, a CometAPI oferece uma economia média de custos de 15 a 20% em comparação com o consumo direto da API. Benchmarks em cargas de trabalho representativas (por exemplo, sumarização, geração de código, IA conversacional) indicam um custo por 1 tokens competitivo entre todos os principais provedores, permitindo que as empresas prevejam orçamentos com maior precisão.

Confiabilidade e tempo de atividade

- Compromisso de SLA: O CometAPI garante 99.9% de tempo de atividade, apoiado por redundância multirregional.

- Mecanismos de failover: No caso de interrupções do provedor upstream (por exemplo, janelas de manutenção do OpenAI), o CometAPI pode redirecionar chamadas de forma transparente para modelos alternativos, garantindo disponibilidade contínua para aplicativos críticos.

O desempenho varia de acordo com o modelo escolhido, as condições da rede e o hardware, mas uma configuração de benchmark típica pode ser assim:

| Ponto final | Latência Mediana (1º Token) | Taxa de transferência (tokens/s) |

|---|---|---|

/chat/completions (texto) | ~120ms | ~500 tok/s |

/images/generations | ~800ms | não aplicável |

/embeddings | ~80ms | ~2 000 tok/s |

Nota: Os números acima são ilustrativos; os resultados reais dependem da sua região, rede e plano CometAPI.

Como você deve fazer benchmarking?

- Meio Ambiente: Use uma rede estável (por exemplo, LAN corporativa), registre seu IP de saída público e geografia.

- Ferramentas.: Empregar

curlou Postman para testes de latência bruta e scripts Python comasynciopara medição de vazão. - Métrica: Acompanhar tempo até o primeiro byte, tempo total de resposta e tokens por segundo.

- Repetição: Execute cada teste pelo menos 30 vezes, descarte valores discrepantes além de 2σ e calcule valores medianos/95º percentil para obter insights robustos.

Seguindo essa metodologia, você pode comparar diferentes modelos (por exemplo, GPT-4O vs. Claude Sonnet 4) e escolher o ideal para seu caso de uso.

Quais são os principais recursos que essa integração desbloqueia?

1. Geração de conteúdo multimodal

- Chat de texto e código: Aproveite o GPT-4O e o Claude Sonnet 4 para conversação, resumo e assistência de código.

- Síntese de Imagens: Invocar

gpt-4o-imageou pontos finais no estilo Midjourney diretamente na tela do CherryStudio. - Áudio vídeo: Os futuros endpoints do CometAPI incluem síntese de fala e geração de vídeo, acessíveis com a mesma configuração do CherryStudio.

2. Troca de provedor simplificada

Alterne entre CometAPI e endpoints nativos OpenAI ou Anthropic com um único clique, permitindo testes A/B em modelos sem reconfigurar chaves de API.

3. Monitoramento de erros e uso integrado

O CherryStudio exibe os painéis de uso e logs de erros do CometAPI, ajudando você a permanecer dentro da cota e diagnosticar falhas (por exemplo, limites de taxa, modelos inválidos).

4. Ecossistema de plug-ins extensível

- Exportação de citações: Incluir automaticamente atribuições de fonte em fluxos de trabalho de pesquisa.

- Ferramentas de código: Gere, formate e faça lint de trechos de código em linha usando os modelos focados em código da CometAPI.

- Macros Personalizadas: Grave sequências de prompts repetitivos como macros, compartilháveis entre os membros da equipe.

5. Lógica de repetição avançada e tratamento de limite de taxa

O SDK da CometAPI implementa backoff e jitter exponenciais, protegendo contra erros transitórios. O CherryStudio expõe essas mecânicas em seus logs e fornece controles de repetição na interface do usuário.

Acesso unificado ao modelo

- Troca de modelos com um clique: Alterne facilmente entre GPT-4.5, Claude 2 e Stable Diffusion sem reconfigurar endpoints.

- Pipelines de modelos personalizados: Chamadas em cadeia — como resumo → análise de sentimentos → geração de imagens — em um único fluxo de trabalho, orquestrado pelo mecanismo de macro do Cherry Studio.

Como começar hoje

- Atualizar CherryStudio para v1.3.12 ou posterior.

- Inscreva-se em CometAPI, recupere sua chave de API e anote sua URL base.

- Configurar CometAPI no CherryStudio como um provedor compatível com OpenAI.

- Execute um prompt de exemplo para verificar a conectividade.

- Explorar modelos: Experimente texto, imagem, incorporação e endpoints de áudio sem sair do CherryStudio. Selecione seu modelo preferido (por exemplo,

gemini-2.5-flash-preview-05-20).

Para obter exemplos de código detalhados, melhores práticas sobre tratamento de erros e dicas avançadas (por exemplo, ajuste fino da lógica de repetição), consulte o CometAPI Guia de Integração de Software .

Conclusão

Ao combinar a interface amigável do CherryStudio com o extenso catálogo de modelos e a API unificada da CometAPI, desenvolvedores e criadores podem prototipar, iterar e escalar rapidamente aplicativos baseados em IA. Seja para criar agentes conversacionais, gerar visuais ou incorporar pesquisa semântica, essa integração oferece uma base robusta, eficiente e extensível. Comece a experimentar hoje mesmo — e fique atento às próximas melhorias, como geração de vídeos no aplicativo e modelos de domínio especializados!