Выпуск GLM-5, представленного на этой неделе компанией Zhipu AI из Китая (публичный бренд Z.AI / zai-org во многих девелоперских каналах), знаменует ещё один шаг в ускоряющемся темпе релизов крупных моделей. Новая модель позиционируется как флагман Zhipu: более крупная по масштабу, настроенная на агентные задачи с длинным горизонтом и созданная с инженерными решениями, призванными снизить стоимость инференса при сохранении длинного контекста. Ранние отраслевые репорты и заметки разработчиков указывают на значимые улучшения в кодинге, многошаговом рассуждении и оркестрации агентов по сравнению с предыдущими итерациями GLM — и в некоторых тестах она даже бросает вызов Claude 4.5.

Что такое GLM-5 и кто его создал?

GLM-5 — это последний крупный релиз в семействе GLM: большая открытая базовая модель, разработанная и опубликованная Z.ai (команда, стоящая за серией GLM). Анонсированная в начале февраля 2026 года, GLM-5 представлена как модель следующего поколения, специально настроенная для «агентных» задач — то есть многошаговых, длинных рабочих процессов, где модель должна планировать, вызывать инструменты, исполнять и поддерживать контекст для длинных разговоров или автоматизированных агентов. Релиз примечателен не только дизайном модели, но и тем, как и где она обучалась: Z.ai использовала сочетание отечественного китайского оборудования и инструментальных цепочек в рамках курса на технологическую самодостаточность.

Согласно заявленным данным об архитектуре и обучении:

- Масштаб параметров: GLM-5 масштабируется примерно до 744B параметров (с меньшим числом «активных» экспертов по некоторым техзаметкам, напр., 40B активных), тогда как размеры семейства GLM-4 ранее составляли около 355B/32B активных.

- Данные предобучения: Объём обучающего корпуса, по сообщениям, увеличен с ~23 трлн токенов (поколение GLM-4) до ~28,5 трлн токенов для GLM-5.

- Разрежённое внимание / DeepSeek Sparse Attention (DSA): Схема разрежённого внимания для сохранения длинного контекста при снижении вычислительных затрат на инференсе.

- Акценты проектирования: инженерные решения, ориентированные на оркестрацию агентов, рассуждение на длинных контекстах и экономичный инференс.

Происхождение и позиционирование

GLM-5 развивает линию, включавшую GLM-4.5 (релиз в середине 2025 года) и несколько итеративных обновлений, таких как 4.7. Z.ai позиционирует GLM-5 как скачок от «vibe coding» (быстрые одношаговые выводы кода) к «агентной инженерии»: устойчивое рассуждение, оркестрация нескольких инструментов и системный синтез на больших окнах контекста. Публичные материалы подчёркивают, что GLM-5 спроектирована для решения сложных задач системной инженерии — построения, координации и поддержки многошагового поведения агентов, а не только для ответа на изолированные запросы.

Какие новые возможности в GLM-5?

Ключевые архитектурные изменения

- Массивное разрежённое масштабирование (MoE): GLM-5 переходит к гораздо более крупной разрежённой архитектуре Mixture-of-Experts. Публичные данные на страницах для разработчиков и независимых обзорах указывают на конфигурацию примерно 744B общих параметров с ~40B активных на токен — заметный шаг вперёд по сравнению с конфигурацией GLM-4.5 ~355B / 32B активных. Такое разрежённое масштабирование обеспечивает очень большую суммарную ёмкость при сохраняемой вычислительной доступности на токен.

- DeepSeek Sparse Attention (DSA): Для сохранения способности работать с длинным контекстом без линейного роста стоимости инференса GLM-5 интегрирует механизм разрежённого внимания (брендирован как DeepSeek), который удерживает важные дальнодействующие зависимости, одновременно снижая стоимость внимания на сверхдлинных контекстах.

Агентная инженерия как базовая цель дизайна

Одна из ключевых особенностей GLM-5 — явная нацеленность на агентную инженерию: модель предназначена не только для одноходового чата или суммаризации, но и как «мозг» многошаговых агентов, способных планировать, вызывать инструменты, управлять состоянием и рассуждать на длинных контекстах. Z.ai позиционирует GLM-5 в роли ядра оркестрационных циклов: разбиение сложных задач, вызов внешних инструментов/API и отслеживание длительных задач на многих шагах.

Почему агентный дизайн важен

Агентные рабочие процессы — основа реальной автоматизации: автоматизированные исследовательские ассистенты, автономные программисты, оркестрация операций и управление симуляциями. Модель, созданная для такого мира, должна обладать сильным планированием, стабильным поведением при вызове инструментов и устойчивостью на тысячах токенов контекста.

Улучшенные возможности в программировании, рассуждении и поведении на длинных горизонтах

GLM-5 делает акцент на улучшении генерации кода и рассуждения. Z.ai заявляет целевые улучшения в способности модели писать, рефакторить и отлаживать код, а также более последовательное многошаговое рассуждение в ходе длинных взаимодействий. Независимые отчёты раннего доступа и оценки партнёров отмечают заметный рост возможностей в задачах для разработчиков по сравнению с предыдущими поколениями GLM.

Практические возможности для разработчиков

- Более длинные окна контекста для удержания документации, кодовых баз и состояния диалога.

- Примитивы для безопасного вызова инструментов и обработки результатов.

- Лучшая работа в few-shot и chain-of-thought для декомпозиции и выполнения сложных задач.

- Агентные функции и вызов инструментов: GLM-5 делает упор на нативную поддержку агентов: вызов функций/инструментов, состояние сеансов и улучшенное управление длинными диалогами и последовательностями использования инструментов. Это упрощает создание агентов, интегрирующих веб-поиск, базы данных или автоматизацию задач.

Как GLM-5 показывает себя на бенчмарках?

Ключевые моменты по бенчмаркам

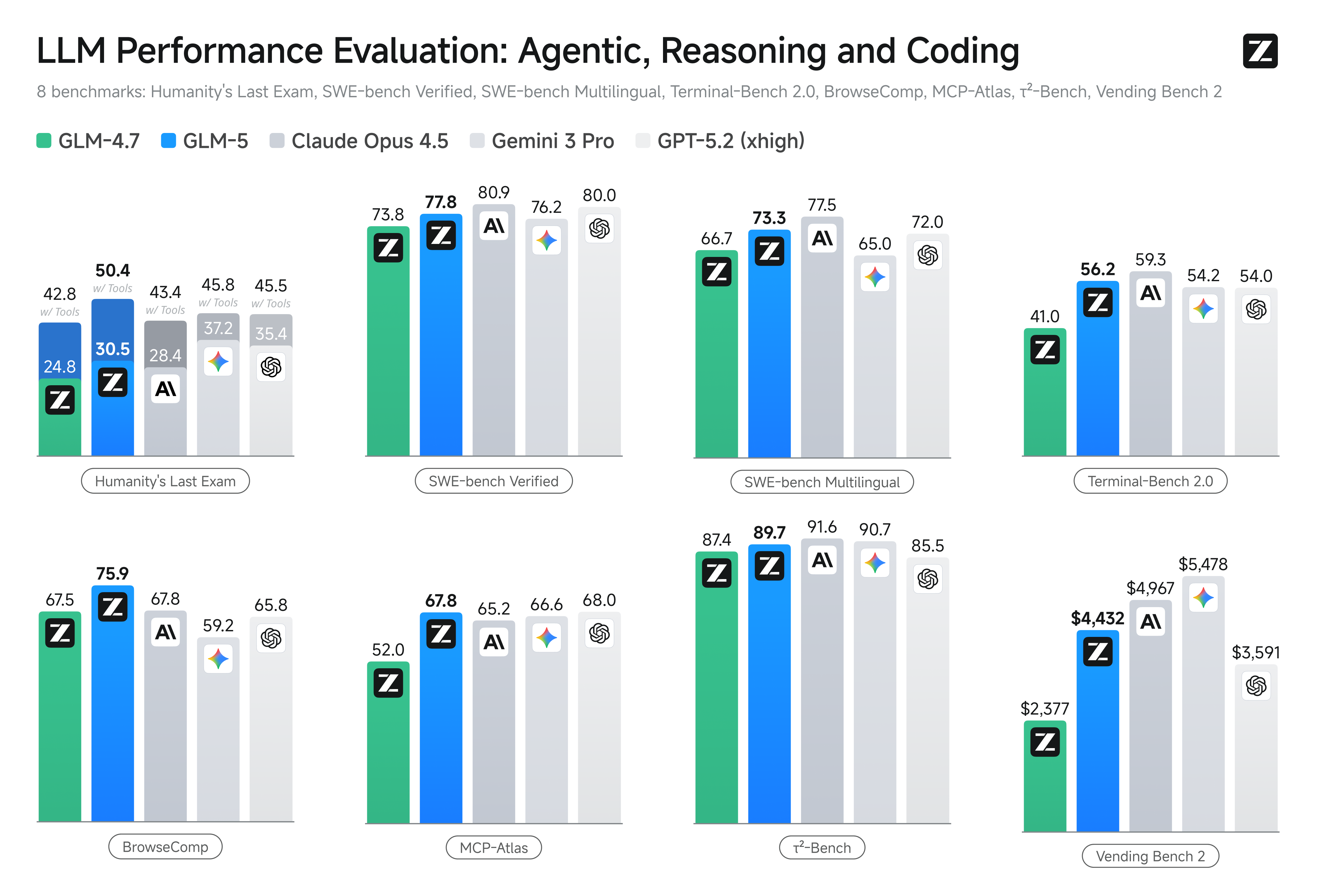

- Кодинг-бенчмарки: GLM-5 приближается (а в некоторых случаях и сопоставима) к результатам по кодированию высокооптимизированных проприетарных моделей, таких как Claude Opus 4.5 от Anthropic, в отдельных задачах. Эти результаты зависят от задач (юнит-тесты, алгоритмическое программирование, работа с API), но они демонстрируют явный прогресс по сравнению с GLM-4.5.

- Тесты на рассуждение и агентность: На наборах для оценки многошагового рассуждения и агентного поведения (например, мультитуровое планирование, бенчмарки декомпозиции задач) GLM-5 достигла лучших результатов среди открытых моделей и по некоторым метрикам превзошла конкурирующие закрытые модели на целевых задачах.

Как получить доступ к GLM-5 и попробовать его?

GLM-5 — это языковая модель пятого поколения от Zhipu AI (Z.ai), построенная на архитектуре Mixture-of-Experts (~745 B всего, ~44 B активных) и ориентированная на сильное рассуждение, кодинг и агентные рабочие процессы. Она официально запущена около 12 февраля 2026 года.

На данный момент есть два основных способа доступа:

A) Официальный доступ по API (Z.ai или агрегаторы)

Сама Zhipu AI предоставляет API для своих моделей, и вы можете вызывать GLM-5 через эти API.

Типичные шаги:

- Зарегистрируйте аккаунт Z.ai/Open BigModel API.

- Получите ключ API в кабинете.

- Используйте OpenAPI-стиль или REST-эндпоинт с именем модели (например,

glm-5).

(Аналогично вызовам моделей GPT у OpenAI). - Задайте промпты и отправляйте HTTP-запросы.

👉 Страница цен Z.ai показывает официальные цены на токены GLM-5:

- ~$1.0 за миллион входных токенов

- ~$3.2 за миллион выходных токенов

B) Обёртки сторонних API —— CometAPI

Такие API, как CometAPI или WaveSpeed, объединяют несколько моделей ИИ (OpenAI, Claude, Z.ai и др.) за единым интерфейсом.

- С сервисами вроде CometAPI вы можете вызывать модели GLM, просто переключая ID модели.

(CometAPI сейчас поддерживает GLM-5/GLM-4.7.) - Цены на glm-5 от CometAPI составляют 20% от официальной цены.

| Тип использования | Цена |

|---|---|

| Входные токены | ~$0.8 за 1M токенов |

| Выходные токены | ~$2.56 за 1M токенов |

Почему это важно: Вы сохраняете свой существующий OpenAI-совместимый клиентский код и просто меняете базовый URL/ID модели.

C) Самостоятельный хостинг через Hugging Face / весовые файлы

Существуют неофициальные репозитории весов GLM-5 (например, версии с именами glm-5/glm-5-fp8) в списках моделей Hugging Face.

С ними вы можете:

- Скачать веса модели.

- Использовать инструменты вроде vLLM, SGLang, xLLM или Transformers для локального обслуживания или развёртывания в вашем облачном GPU-кластере.

Плюсы: максимальный контроль, отсутствие постоянных затрат на API.

Минусы: огромные вычислительные требования — вероятно, несколько топовых GPU и большой объём памяти (сотни гигабайт), что делает это непрактичным на небольших системах.

Так стоит ли переходить на GLM-5 и нужно ли оставаться с GLM-4.7?

Короткий ответ (краткое резюме)

- Если вам нужны надёжное многошаговое агентное поведение, продакшн-уровень генерации кода или системная автоматизация: GLM-5 стоит оценить немедленно. Её архитектура, масштаб и настройка ориентированы именно на эти результаты.

- Если вам важны экономичность и высокая пропускная способность микросервисов (короткие чаты, классификация, лёгкие промпты): GLM-4.7, вероятно, остаётся самым экономичным выбором. GLM-4.7 сохраняет сильные возможности при значительно меньшей стоимости за токен у многих провайдеров и уже обкатана в продакшене.

Более развёрнутый ответ (практическая рекомендация)

Примените многоуровневую стратегию по моделям: используйте GLM-4.7 для повседневных, массовых взаимодействий, а GLM-5 — для высокоценностных инженерных задач и оркестрации агентов. Запустите пилот GLM-5 на небольшой части продукта, где задействованы длинный контекст, интеграция инструментов и корректность кода; измеряйте как экономию инженерного времени, так и прирост стоимости модели. Со временем вы поймёте, оправдывает ли прирост возможностей GLM-5 более широкий переход.

С CometAPI вы можете переключаться между GLM-4.7 и GLM-5 в любое время.

Практические сценарии, где GLM-5 особенно силён

1. Сложная оркестрация агентов

Фокус GLM-5 на многошаговом планировании и вызове инструментов делает её подходящей для систем, которым нужно координировать поиск, вызовы API и выполнение программ (например: автоматизированные исследовательские ассистенты, итеративные генераторы кода или многошаговые сервисные агенты, которым необходимо обращаться к базам данных и внешним API).

2. Длительная инженерия и рассуждение по кодовой базе

Когда нужно, чтобы модель анализировала, рефакторила или синтезировала информацию по множеству файлов или большой кодовой базе, расширенный контекст и разрежённое внимание GLM-5 дают прямые преимущества — меньше сбоев из‑за обрезанного контекста и лучшая согласованность на длинных отрезках.

3. Знаниеёмкий синтез

Аналитики и продуктовые команды, формирующие сложные отчёты — многоразделные исследовательские обзоры, юридические резюме или регуляторные документы — могут выиграть от улучшений модели в стабильном многошаговом рассуждении и снижении галлюцинаций по результатам тестов, опубликованных поставщиком.

4. Агентная автоматизация рабочих процессов

Команды, строящие автоматизацию, которая должна оркестрировать несколько систем (например, планирование + тикеты + пайплайны деплоймента), могут использовать GLM-5 как центральный планировщик и исполнитель, подкреплённый фреймворками вызова инструментов и оболочками безопасности.

Заключение

GLM-5 — важный релиз в быстро меняющемся ландшафте передовых моделей. Её акцент на агентной инженерии, улучшенном кодинге и рассуждении, а также доступность весов делают её привлекательной для команд, создающих инструментально-обогащённые ИИ‑системы с длинным горизонтом. Реальные улучшения в выбранных задачах и обнадёживающий баланс цена/производительность — но заказчикам стоит оценить GLM-5 на своих конкретных задачах и провести контролируемые бенчмарки перед внедрением в продакшен.

Разработчики уже могут получить доступ к GLM-5 через CometAPI. Чтобы начать, изучите возможности модели в Playground и обратитесь к руководству по API за подробными инструкциями. Перед доступом убедитесь, что вы вошли в CometAPI и получили ключ API. CometAPI предлагает цену значительно ниже официальной, чтобы упростить интеграцию.

Готовы начать?→ Зарегистрируйтесь для glm-5 уже сегодня!

Если вы хотите узнавать больше советов, гайдов и новостей об ИИ, подписывайтесь на нас в VK, X и Discord!