28 апреля 2025 года Alibaba Cloud представила Qwen 3, последнюю итерацию в своем семействе больших языковых моделей (LLM). Этот релиз знаменует собой важную веху в развитии ИИ с открытым исходным кодом, предлагая набор моделей, которые удовлетворяют разнообразные приложения и потребности пользователей. Независимо от того, являетесь ли вы разработчиком, исследователем или предприятием, понимание того, как получить доступ и использовать Qwen 3, может открыть новые возможности в обработке естественного языка и за его пределами.

Что такое Qwen 3?

Qwen 3 — это третье поколение LLM с открытым исходным кодом Alibaba Cloud, построенное на основе, заложенной его предшественниками. Выпущенный 28 апреля 2025 года, Qwen 3 представляет ряд моделей с различными размерами параметров, включая как плотные, так и разреженные архитектуры. Эти модели были обучены на обширном наборе данных из 36 триллионов токенов на 119 языках и диалектах, что позиционирует Qwen 3 как универсальный инструмент для глобальных приложений.

Основные характеристики Qwen 3

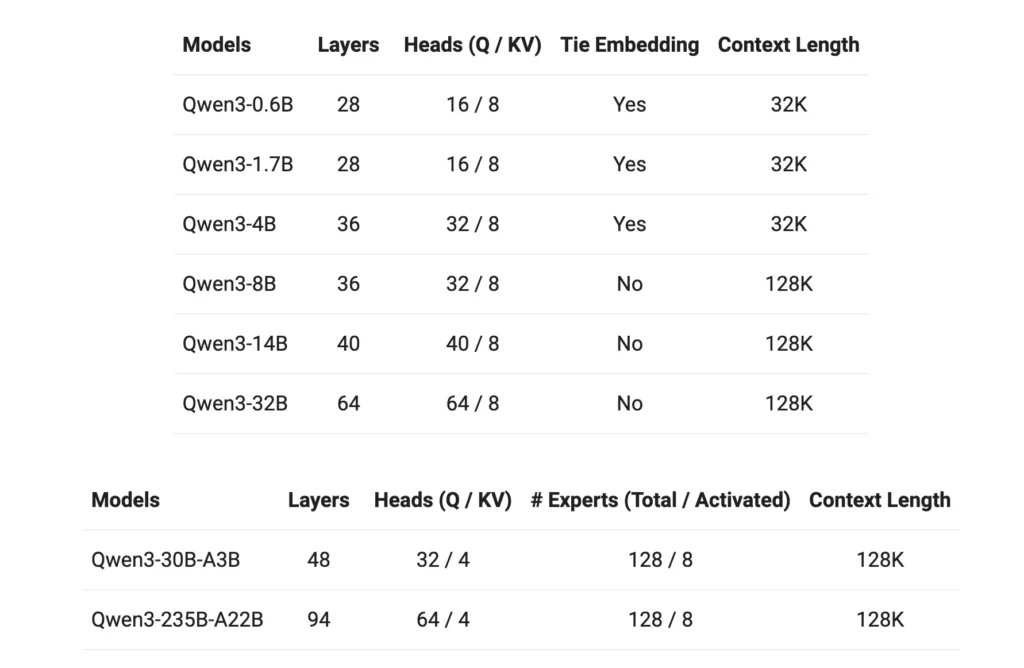

- Варианты модели: Qwen 3 предлагает плотные модели с параметрами 0.6B, 1.7B, 4B, 8B, 14B и 32B, а также разреженные модели с 30B (активированные параметры 3B) и 235B (активированные параметры 22B).

- Окно расширенного контекста: Большинство моделей поддерживают контекстное окно токена размером 128 КБ, что упрощает обработку длинного контента.

- Рассуждения: Расширенные функции рассуждений можно переключать с помощью токенизатора, что позволяет адаптировать производительность в зависимости от конкретных задач.

- Многоязычное владение: Благодаря учебным данным, охватывающим 119 языков и диалектов, Qwen 3 готов к разнообразным лингвистическим приложениям.

- Лицензирование: Все модели выпускаются под лицензией Apache 2.0, что способствует сотрудничеству и инновациям с открытым исходным кодом.

Как получить доступ к Qwen3?

Доступ к Qwen 3, последнему набору больших языковых моделей (LLM) Alibaba Cloud, прост и универсален. Независимо от того, являетесь ли вы разработчиком, стремящимся интегрировать передовые возможности ИИ в свои приложения, или исследователем, изучающим передовые модели, Qwen 3 предлагает несколько точек доступа для удовлетворения различных потребностей.

1. Через веб-интерфейс QwenChat

Для мгновенного взаимодействия без какой-либо настройки QwenChat предоставляет удобный веб-интерфейс:

- Посетите QwenChat: Перейти к Платформа QwenChat,

- Выберите модель: Выбирайте из доступных моделей, таких как Qwen3-8B, Qwen3-14B или Qwen3-32B, в зависимости от ваших требований.

- Начать чат: взаимодействуйте с моделью напрямую через интерфейс чата для решения таких задач, как вопросы и ответы, создание контента или помощь в кодировании.

2. Доступ к API через Alibaba Cloud

Интегрируйте Qwen 3 в свои приложения, используя API-сервисы Alibaba Cloud:

Получить учетные данные API: Зарегистрируйтесь в Alibaba Cloud и получите свой ключ API.

Выберите метод доступа:

- API, совместимый с OpenAI: Используйте конечную точку, совместимую с OpenAI, для бесшовной интеграции.

bashPOST https://dashscope-intl.aliyuncs.com/compatible-mode/v1/chat/completions

- DashScope SDK: В качестве альтернативы используйте DashScope SDK для более настраиваемого взаимодействия.

- Настройка среды: Настройте среду разработки, установив ключ API как переменную среды и установив необходимые SDK.

3. Доступ через Hugging Face и ModelScope

Для разработчиков, предпочитающих платформы с открытым исходным кодом:

- Обнимая лицо: Получите доступ к моделям Qwen 3 через организацию Qwen на Hugging Face.

pythonfrom transformers import AutoTokenizer, AutoModelForCausalLM tokenizer = AutoTokenizer.from_pretrained("Qwen/Qwen3-14B") model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen3-14B")

- МодельОбласть: Изучите модели на ModelScope, предлагающем ряд вариантов Qwen 3.

4. Варианты локального развертывания

Разверните модели Qwen 3 локально для улучшенного управления и настройки:

Оллама: Платформа, упрощающая локальное управление моделями.

- Установка:: Загрузите и установите Ollama с сайта ollama.com,

- Развертывание модели: Используйте CLI Ollama для локального запуска моделей Qwen 3.

bashollama run qwen3-14b

vLLM: Оптимизирован для обслуживания с высокой пропускной способностью и малой задержкой.

- Установка:: Установите vLLM с помощью pip.

bashpip install -U vllm

- Обслуживание моделей: Подавайте модели Qwen 3 с возможностями рассуждения.

bashvllm serve Qwen/Qwen3-30B-A3B \ --enable-reasoning \ --reasoning-parser deepseek_r1

Взаимодействие: Доступ к модели через сервер API по умолчанию по адресу http://localhost:8000,

5. Сторонние платформы: CometAPI

Используйте Qwen 3 через CometAPI предлагая бесплатный доступ:

- CometAPI: Зарегистрируйтесь, чтобы получить бесплатный ключ API и выбрать одну из моделей, например Qwen3-8B, Qwen3-30B или Qwen3-235B, для интеграции в ваши проекты.

Как начать играть в Qwen 3

Чтобы начать использовать Qwen 3:

- Определите свой вариант использования: Определите, нужен ли вам веб-интерфейс, интеграция API или локальное развертывание.

- Выберите подходящую модель: Выберите вариант модели, соответствующий вашим вычислительным ресурсам и сложности задачи.

- Настройте среду: Следуйте инструкциям по установке и настройке в зависимости от выбранного вами метода доступа.

- Интеграция и тестирование: Включите Qwen 3 в свои приложения и проведите тестирование, чтобы обеспечить оптимальную производительность.

Выполнив эти шаги, вы сможете эффективно использовать возможности Qwen 3 для улучшения своих проектов и исследовательских начинаний.

Реализация Qwen 3: Практические соображения

Системные требования

Развертывание моделей Qwen 3, особенно более крупных вариантов, требует существенных вычислительных ресурсов. Пользователи должны убедиться, что у них есть доступ к соответствующим возможностям GPU и памяти для размещения размеров моделей и требований к обработке.

Интеграция и настройка

Природа Qwen 3 с открытым исходным кодом допускает обширную настройку. Разработчики могут настраивать модели на основе данных, специфичных для домена, корректировать параметры для оптимизации производительности и интегрировать модели в существующие системы для улучшения функциональности.

Сообщество и поддержка

Взаимодействие с сообществом Qwen 3 через форумы, обсуждения на GitHub и другие платформы для совместной работы может обеспечить ценные идеи и поддержку. Обмен опытом и решениями способствует коллективному развитию технологии.

Заключение

Qwen 3 представляет собой значительный прогресс в области больших языковых моделей с открытым исходным кодом. Благодаря разнообразным предложениям моделей, обширной языковой поддержке и доступным платформам он предоставляет надежный набор инструментов для широкого спектра приложений. Понимая, как получить доступ к Qwen 3 и внедрить его, пользователи могут использовать его возможности для стимулирования инноваций и повышения эффективности в своих областях.

Первые шаги

Разработчики могут получить доступ Квен 3 API через CometAPI. Для начала изучите возможности модели на игровой площадке и обратитесь к API-руководство для получения подробных инструкций. Обратите внимание, что некоторым разработчикам может потребоваться проверить свою организацию перед использованием модели.