DeepSeek-V3.1 คือโมเดลการใช้เหตุผลแบบไฮบริดล่าสุดจาก DeepSeek ที่รองรับทั้งโหมดแชทแบบ “ไม่ใช้ความคิด” ที่รวดเร็ว และโหมด “ใช้ความคิด/ใช้เหตุผล” ที่ละเอียดกว่า นำเสนอบริบทที่ยาว (สูงสุด 128K) เอาต์พุตที่มีโครงสร้าง และการเรียกใช้ฟังก์ชัน และสามารถเข้าถึงได้โดยตรงผ่าน API ที่รองรับ OpenAI ของ DeepSeek ผ่านจุดสิ้นสุดที่รองรับ Anthropic หรือผ่าน CometAPI ด้านล่างนี้ ผมจะอธิบายเกี่ยวกับโมเดลนี้ จุดเด่นของเกณฑ์มาตรฐานและค่าใช้จ่าย ฟีเจอร์ขั้นสูง (การเรียกใช้ฟังก์ชัน เอาต์พุต JSON โหมดการใช้เหตุผล) และตัวอย่างโค้ดแบบ end-to-end ที่เป็นรูปธรรม ได้แก่ การเรียกใช้ DeepSeek REST โดยตรง (curl / Node / Python) การใช้งานไคลเอนต์ Anthropic และการเรียกใช้ผ่าน CometAPI

DeepSeek-V3.1 คืออะไร และมีอะไรใหม่ในรุ่นนี้?

DeepSeek-V3.1 เป็นรุ่นล่าสุดในตระกูล DeepSeek V3 ซึ่งเป็นไลน์ผลิตภัณฑ์ภาษาขนาดใหญ่ที่มีความจุสูง ผสมผสานผู้เชี่ยวชาญ และมาพร้อมกับ การออกแบบการอนุมานแบบไฮบริด ด้วย "โหมด" การทำงานสองแบบ — แบบรวดเร็ว การสนทนาแบบไม่ใช้ความคิด โหมดและ การคิด / การใช้เหตุผล โหมดที่สามารถเปิดเผยร่องรอยแบบห่วงโซ่แห่งความคิดสำหรับงานการใช้เหตุผลที่ยากขึ้นและการใช้ตัวแทน/เครื่องมือ การเปิดตัวนี้เน้นย้ำถึงความล่าช้าในการ "คิด" ที่เร็วขึ้น ความสามารถของเครื่องมือ/ตัวแทนที่ได้รับการปรับปรุง และการจัดการบริบทที่ยาวนานขึ้นสำหรับเวิร์กโฟลว์ระดับเอกสาร

ข้อสรุปเชิงปฏิบัติที่สำคัญ:

- สองโหมดการทำงาน:

deepseek-chatสำหรับปริมาณงานและต้นทุนdeepseek-reasoner(แบบจำลองการใช้เหตุผล) เมื่อคุณต้องการร่องรอยของความคิดแบบต่อเนื่องหรือความเที่ยงตรงในการใช้เหตุผลที่สูงขึ้น - อัปเกรดการจัดการตัวแทน/เครื่องมือและการปรับปรุงโทเค็นไนเซอร์/บริบทสำหรับเอกสารยาว

- ความยาวบริบท: โทเค็นสูงสุดถึง ~128K (เปิดใช้งานเอกสารยาว ฐานโค้ด บันทึก)

ความก้าวหน้าครั้งสำคัญ

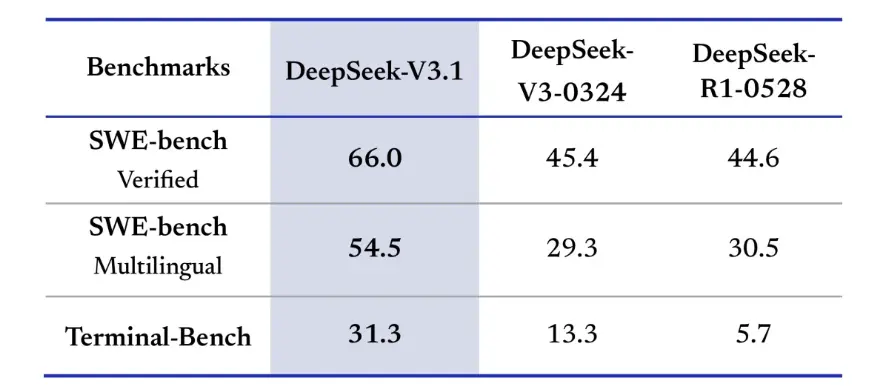

DeepSeek-V3.1 แสดงให้เห็นถึงการปรับปรุงที่สำคัญในความท้าทายด้านการเขียนโค้ดในโลกแห่งความเป็นจริง ในการประเมิน SWE-bench Verified ซึ่งวัดความถี่ที่โมเดลแก้ไขปัญหา GitHub เพื่อให้มั่นใจว่าการทดสอบยูนิตจะผ่าน V3.1 มีอัตราความสำเร็จ 66% เทียบกับ 45% ในทั้ง V3-0324 และ R1 ในเวอร์ชันหลายภาษา V3.1 แก้ไขปัญหาได้ 54.5% ซึ่งเกือบสองเท่าของอัตราความสำเร็จประมาณ 30% ของเวอร์ชันอื่นๆ ในการประเมิน Terminal-Bench ซึ่งทดสอบว่าโมเดลสามารถทำงานในสภาพแวดล้อม Linux แบบสดได้หรือไม่ DeepSeek-V3.1 ประสบความสำเร็จในการทำงาน 31% เทียบกับ 13% และ 6% ในเวอร์ชันอื่นๆ ตามลำดับ การปรับปรุงเหล่านี้แสดงให้เห็นว่า DeepSeek-V3.1 มีความน่าเชื่อถือมากขึ้นในการรันโค้ดและใช้งานในสภาพแวดล้อมเครื่องมือโลกแห่งความเป็นจริง

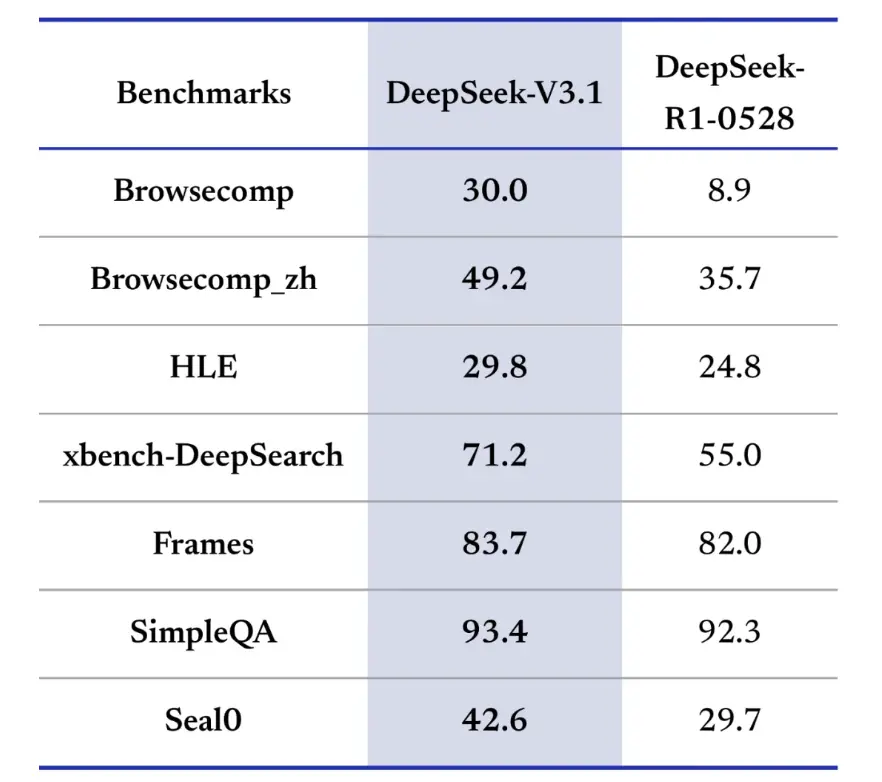

เกณฑ์มาตรฐานการดึงข้อมูลยังสนับสนุน DeepSeek-V3.1 ในด้านการค้นหา การค้นหา และการตอบคำถาม ในการประเมินของ BrowseComp ซึ่งกำหนดให้ต้องนำทางและดึงคำตอบจากหน้าเว็บ V3.1 ตอบคำถามได้อย่างถูกต้อง 30% เมื่อเทียบกับ R9 ที่ทำได้ 1% ในเวอร์ชันภาษาจีน DeepSeek-V3.1 มีความแม่นยำ 49% เมื่อเทียบกับ R36 ที่ทำได้ 1% ในการสอบ Hard Language Exam (HLE) V3.1 มีประสิทธิภาพสูงกว่า R1 เล็กน้อย โดยมีความแม่นยำ 30% และ 25% ตามลำดับ สำหรับงานค้นหาเชิงลึก เช่น xbench-DeepSearch ซึ่งต้องอาศัยการสังเคราะห์ข้อมูลจากหลายแหล่ง V3.1 ทำคะแนนได้ 71% เทียบกับ R1 ที่ทำได้ 55% DeepSeek-V3.1 ยังแสดงให้เห็นถึงความเหนือกว่าเล็กน้อยแต่สม่ำเสมอในเกณฑ์มาตรฐานต่างๆ เช่น (การใช้เหตุผลเชิงโครงสร้าง), SimpleQA (การตอบคำถามข้อเท็จจริง) และ Seal0 (การตอบคำถามเฉพาะด้าน) โดยรวมแล้ว V3.1 มีประสิทธิภาพเหนือกว่า R1 อย่างมากในการค้นหาข้อมูลและการตอบคำถามน้ำหนักเบา

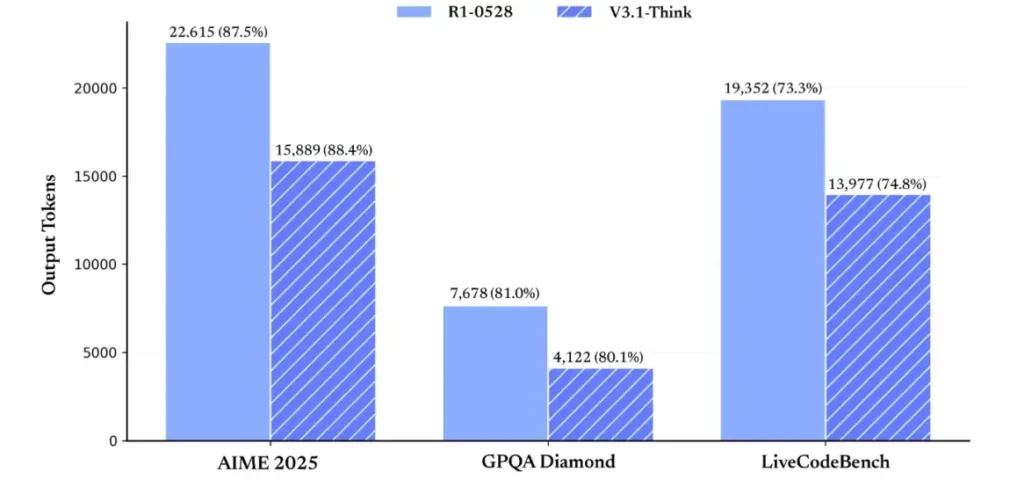

ในด้านประสิทธิภาพการใช้เหตุผล ผลการใช้โทเค็นแสดงให้เห็นถึงประสิทธิภาพ ใน AIME 2025 (ข้อสอบคณิตศาสตร์ที่ยาก) V3.1-Think มีความแม่นยำเทียบเท่าหรือสูงกว่า R1 เล็กน้อย (88.4% เทียบกับ 87.5%) แต่ใช้โทเค็นน้อยกว่าประมาณ 30% ใน GPQA Diamond (ข้อสอบแบบหลายโดเมน) ทั้งสองโมเดลมีความแม่นยำเกือบเท่ากัน (80.1% เทียบกับ 81.0%) แต่ V3.1 ใช้โทเค็นเกือบครึ่งหนึ่งของ R1 ในเกณฑ์มาตรฐาน LiveCodeBench ซึ่งประเมินการใช้เหตุผลของโค้ด V3.1 ไม่เพียงแต่มีความแม่นยำมากกว่า (74.8% เทียบกับ 73.3%) เท่านั้น แต่ยังกระชับกว่าด้วย ซึ่งแสดงให้เห็นว่า V3.1-Think สามารถให้เหตุผลได้อย่างละเอียดโดยไม่ใช้คำฟุ่มเฟือย

โดยรวมแล้ว V3.1 ถือเป็นก้าวกระโดดครั้งสำคัญเมื่อเทียบกับ V3-0324 เมื่อเทียบกับ R1 แล้ว V3.1 มีความแม่นยำสูงกว่าในเกือบทุกเกณฑ์มาตรฐาน และมีประสิทธิภาพมากกว่าในงานวิเคราะห์เชิงเหตุผลที่ซับซ้อน เกณฑ์มาตรฐานเดียวที่ R1 ทำได้คือ GPQA แต่มีค่าใช้จ่ายสูงกว่าเกือบสองเท่า

ฉันจะรับรหัส API และตั้งค่าบัญชีพัฒนาได้อย่างไร

ขั้นตอนที่ 1: ลงทะเบียนและสร้างบัญชี

- เยี่ยมชมพอร์ทัลนักพัฒนาของ DeepSeek (เอกสาร DeepSeek / คอนโซล) สร้างบัญชีด้วยผู้ให้บริการอีเมลหรือ SSO ของคุณ

- ดำเนินการตรวจสอบข้อมูลประจำตัวหรือตั้งค่าการเรียกเก็บเงินตามที่พอร์ทัลกำหนด

ขั้นตอนที่ 2: สร้างคีย์ API

- ในแดชบอร์ดไปที่ คีย์ API → สร้างคีย์. ตั้งชื่อคีย์ของคุณ (เช่น

dev-local-01). - คัดลอกคีย์และจัดเก็บไว้ในตัวจัดการความลับที่ปลอดภัย (ดูแนวทางปฏิบัติดีที่สุดในการผลิตด้านล่าง)

เคล็ดลับ: เกตเวย์และเราเตอร์ของบริษัทอื่นบางตัว (เช่น CometAPI) ช่วยให้คุณใช้คีย์เกตเวย์เดียวเพื่อเข้าถึงโมเดล DeepSeek ผ่านเกตเวย์เหล่านั้น ซึ่งมีประโยชน์สำหรับการสำรองข้อมูลของผู้ให้บริการหลายราย (ดู API ของ DeepSeek V3.1 มาตรา).

ฉันจะตั้งค่าสภาพแวดล้อมการพัฒนาของฉัน (Linux/macOS/Windows) ได้อย่างไร

นี่เป็นการตั้งค่าที่เรียบง่ายและสามารถทำซ้ำได้สำหรับ Python และ Node.js ที่ใช้งานได้กับ DeepSeek (จุดสิ้นสุดที่เข้ากันได้กับ OpenAI), CometAPI และ Anthropic

เบื้องต้น

- Python 3.10+ (แนะนำ), pip, virtualenv

- Node.js 18+ และ npm/yarn

- curl (สำหรับการทดสอบอย่างรวดเร็ว)

สภาพแวดล้อม Python (ทีละขั้นตอน)

- สร้างไดเร็กทอรีโครงการ:

mkdir deepseek-demo && cd deepseek-demo

python -m venv .venv

source .venv/bin/activate # macOS / Linux

# .venv\Scripts\activate # Windows PowerShell

- ติดตั้งแพ็คเกจขั้นต่ำ:

pip install --upgrade pip

pip install requests

# Optional: install an OpenAI-compatible client if you prefer one:

pip install openai

- บันทึกคีย์ API ของคุณไปยังตัวแปรสภาพแวดล้อม (ไม่ต้องคอมมิต):

export DEEPSEEK_KEY="sk_live_xxx"

export CometAPI_KEY="or_xxx"

export ANTHROPIC_KEY="anthropic_xxx"

(การใช้ Windows PowerShell $env:DEEPSEEK_KEY = "…")

สภาพแวดล้อมโหนด (ทีละขั้นตอน)

- เริ่มต้น:

mkdir deepseek-node && cd deepseek-node

npm init -y

npm install node-fetch dotenv

- สร้าง

.envไฟล์:

DEEPSEEK_KEY=sk_live_xxx

CometAPI_KEY=or_xxx

ANTHROPIC_KEY=anthropic_xxx

ฉันจะเรียก DeepSeek-V3.1 โดยตรงได้อย่างไร — ตัวอย่างโค้ดทีละขั้นตอน?

API ของ DeepSeek เข้ากันได้กับ OpenAI ด้านล่างนี้คือ คัดลอกวาง ตัวอย่าง: curl, Python (คำขอและรูปแบบ SDK ของ openai) และ Node

ขั้นตอนที่ 1: ตัวอย่างการม้วนงอแบบง่าย

curl https://api.deepseek.com/v1/chat/completions \

-H "Authorization: Bearer $DEEPSEEK_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "deepseek-chat-v3.1",

"messages": [

{"role":"system","content":"You are a concise engineering assistant."},

{"role":"user","content":"Give a 5-step secure deployment checklist for a Django app."}

],

"max_tokens": 400,

"temperature": 0.0,

"reasoning_enabled": true

}'

หมายเหตุ: reasoning_enabled สลับโหมดคิด (แฟล็กผู้ขาย) ชื่อแฟล็กที่แน่นอนอาจแตกต่างกันไปตามผู้ให้บริการ — ตรวจสอบเอกสารประกอบรุ่น

ขั้นตอนที่ 2: Python (คำขอ) พร้อมการวัดระยะไกลแบบง่าย

import os, requests, time, json

API_KEY = os.environ

URL = "https://api.deepseek.com/v1/chat/completions"

payload = {

"model": "deepseek-chat-v3.1",

"messages": [

{"role": "system", "content": "You are a helpful coding assistant."},

{"role": "user", "content": "Refactor this Flask function to be testable: ..."}

],

"max_tokens": 600,

"temperature": 0.1,

"reasoning_enabled": True

}

start = time.time()

r = requests.post(URL, headers={

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

}, json=payload, timeout=60)

elapsed = time.time() - start

print("Status:", r.status_code, "Elapsed:", elapsed)

data = r.json()

print(json.dumps(data, indent=2))

CometAPI: เข้าถึง DeepSeek V3.1 ได้ฟรีโดยสมบูรณ์

สำหรับนักพัฒนาที่ต้องการเข้าถึงได้ทันทีโดยไม่ต้องลงทะเบียน CometAPI นำเสนอทางเลือกที่น่าสนใจสำหรับ DeepSeek V3.1 (ชื่อโมเดล: deepseek-v3-1-250821; deepseek-v3.1) บริการเกตเวย์นี้รวบรวมโมเดล AI หลายแบบผ่าน API แบบรวมศูนย์ ช่วยให้เข้าถึง DeepSeek ได้ และมอบสิทธิประโยชน์อื่นๆ รวมถึงการเฟลโอเวอร์อัตโนมัติ การวิเคราะห์การใช้งาน และการเรียกเก็บเงินข้ามผู้ให้บริการที่ง่ายขึ้น

ขั้นแรกให้สร้างบัญชี CometAPI ที่ https://www.cometapi.com/—กระบวนการทั้งหมดใช้เวลาเพียงสองนาทีและต้องใช้เพียงการยืนยันที่อยู่อีเมล เมื่อเข้าสู่ระบบแล้ว ให้สร้างคีย์ใหม่ในส่วน "คีย์ API" https://www.cometapi.com/ มอบเครดิตฟรีสำหรับบัญชีใหม่ และส่วนลด 20% จากราคา API อย่างเป็นทางการ

การใช้งานทางเทคนิคจำเป็นต้องมีการเปลี่ยนแปลงโค้ดเพียงเล็กน้อย เพียงเปลี่ยนจุดสิ้นสุด API ของคุณจาก URL DeepSeek โดยตรงเป็นเกตเวย์ CometAPI

หมายเหตุ: API รองรับการสตรีมมิ่ง (

stream: true),max_tokens, อุณหภูมิ, ลำดับการหยุด และฟีเจอร์การเรียกฟังก์ชันที่คล้ายกับ API อื่นๆ ที่เข้ากันได้กับ OpenAI

ฉันจะเรียก DeepSeek โดยใช้ Anthropic SDK ได้อย่างไร

DeepSeek มอบจุดสิ้นสุดที่เข้ากันได้กับ Anthropic เพื่อให้คุณสามารถนำ Anthropc SDK หรือเครื่องมือ Claude Code มาใช้ซ้ำได้โดยการชี้ SDK ไปที่ https://api.deepseek.com/anthropic และตั้งชื่อรุ่นเป็น deepseek-chat (หรือ deepseek-reasoner ที่ได้รับการสนับสนุน)

เรียกใช้ DeepSeek Model ผ่าน Anthropic API

ติดตั้ง Anthropic SDK: pip install anthropic กำหนดค่าสภาพแวดล้อมของคุณ:

export ANTHROPIC_BASE_URL=https://api.deepseek.com/anthropic

export ANTHROPIC_API_KEY=YOUR_DEEPSEEK_KEY

สร้างข้อความ:

import anthropic

client = anthropic.Anthropic()

message = client.messages.create(

model="deepseek-chat",

max_tokens=1000,

system="You are a helpful assistant.",

messages=[

{

"role": "user",

"content": [

{

"type": "text",

"text": "Hi, how are you?"

}

]

}

]

)

print(message.content)

ใช้ DeepSeek ใน Claude Code

ติดตั้ง: npm install -g @anthropic-ai/claude-code กำหนดค่าสภาพแวดล้อมของคุณ:

export ANTHROPIC_BASE_URL=https://api.deepseek.com/anthropic

export ANTHROPIC_AUTH_TOKEN=${YOUR_API_KEY}

export ANTHROPIC_MODEL=deepseek-chat

export ANTHROPIC_SMALL_FAST_MODEL=deepseek-chat

เข้าสู่ไดเร็กทอรีโครงการและดำเนินการรหัส Claude:

cd my-project

claude

ใช้ DeepSeek ใน Claude Code ผ่าน CometAPI

CometAPI รองรับ Claude Code หลังจากติดตั้งแล้ว เมื่อกำหนดค่าสภาพแวดล้อม เพียงแทนที่ URL พื้นฐานด้วย https://www.cometapi.com/console/ และแทนที่คีย์ด้วยคีย์ของ CometAPI เพื่อใช้โมเดล DeepSeek ของ CometAPI ใน Claude Code

# Navigate to your project folder cd your-project-folder

# Set environment variables (replace sk-... with your actual token)

export ANTHROPIC_AUTH_TOKEN=sk-...

export ANTHROPIC_BASE_URL=https://www.cometapi.com/console/

# Start Claude Code

claude

หมายเหตุ:

- DeepSeek แมปชื่อโมเดล Anthropic ที่ไม่รองรับ

deepseek-chat. - เลเยอร์ความเข้ากันได้ของ Anthropic รองรับ

system,messages,temperatureการสตรีม การหยุดลำดับ และการคิดแบบอาร์เรย์

แนวทางปฏิบัติที่ดีที่สุดในการผลิตที่เป็นรูปธรรม (ความปลอดภัย ต้นทุน ความน่าเชื่อถือ) คืออะไร

ด้านล่างนี้เป็นรูปแบบการผลิตที่แนะนำซึ่งใช้ได้กับ DeepSeek หรือการใช้งาน LLM ปริมาณสูง

ความลับและตัวตน

- เก็บคีย์ API ไว้ในตัวจัดการความลับ (อย่าใช้

.envใน prod) หมุนเวียนคีย์เป็นประจำและสร้างคีย์ต่อบริการด้วยสิทธิ์ที่น้อยที่สุด - ใช้โครงการ/บัญชีแยกกันสำหรับการพัฒนา/การจัดเตรียม/การผลิต

ขีดจำกัดอัตราและการลองใหม่

- Implement การถอยกลับแบบเอ็กซ์โปเนนเชียล บน HTTP 429/5xx ที่มีความสั่นไหว จำกัดจำนวนครั้งในการลองใหม่ (เช่น 3 ครั้ง)

- ใช้คีย์ idempotency สำหรับการร้องขอที่อาจเกิดซ้ำ

ตัวอย่าง Python — ลองใหม่อีกครั้งด้วยการถอยกลับ

import time, random, requests

def post_with_retries(url, headers, payload, attempts=3):

for i in range(attempts):

r = requests.post(url, json=payload, headers=headers, timeout=60)

if r.status_code == 200:

return r.json()

if r.status_code in (429, 502, 503, 504):

backoff = (2 ** i) + random.random()

time.sleep(backoff)

continue

r.raise_for_status()

raise RuntimeError("Retries exhausted")

การจัดการต้นทุน

- ลิมิตสวิตช์

max_tokensและหลีกเลี่ยงการขอผลลัพธ์จำนวนมากโดยไม่ได้ตั้งใจ - การตอบสนองของโมเดลแคช หากเหมาะสม (โดยเฉพาะอย่างยิ่งสำหรับการแจ้งเตือนซ้ำๆ) DeepSeek จะแยกความแตกต่างระหว่างแคชที่ได้รับผลกระทบและแคชที่ไม่ได้รับในการกำหนดราคาอย่างชัดเจน — การแคชช่วยประหยัดเงิน

- ใช้

deepseek-chatสำหรับการตอบกลับเล็กๆ น้อยๆ ตามปกติ สำรองไว้deepseek-reasonerสำหรับกรณีที่จำเป็นต้องใช้ CoT จริงๆ (ราคาแพงกว่า)

การสังเกตและการบันทึกข้อมูล

- บันทึกเฉพาะข้อมูลเมตาเกี่ยวกับคำขอในรูปแบบข้อความธรรมดา (แฮชพร้อมท์ จำนวนโทเค็น เวลาแฝง) หลีกเลี่ยงการบันทึกข้อมูลผู้ใช้ทั้งหมดหรือเนื้อหาที่ละเอียดอ่อน จัดเก็บรหัสคำขอ/การตอบกลับสำหรับการสนับสนุนและการตรวจสอบความถูกต้องของการเรียกเก็บเงิน

- ติดตามการใช้งานโทเค็นตามคำขอและเปิดเผยงบประมาณ/การแจ้งเตือนเกี่ยวกับต้นทุน

การควบคุมความปลอดภัยและอาการประสาทหลอน

- ใช้ ผลลัพธ์ของเครื่องมือและตัวตรวจสอบแบบกำหนดแน่นอน สำหรับทุกสิ่งที่สำคัญต่อความปลอดภัย (ทางการเงิน กฎหมาย การแพทย์)

- สำหรับผลลัพธ์ที่มีโครงสร้าง ให้ใช้

response_format+รูปแบบ JSON และตรวจสอบผลลัพธ์ก่อนดำเนินการที่ไม่สามารถย้อนกลับได้

รูปแบบการปรับใช้

- รันการเรียกโมเดลจากกระบวนการเวิร์กเกอร์เฉพาะเพื่อควบคุมการทำงานพร้อมกันและการเข้าคิว

- โอนงานหนักไปยังเวิร์กเกอร์แบบอะซิงค์ (งาน Celery, Fargate, งาน Cloud Run) และตอบกลับผู้ใช้ด้วยตัวบ่งชี้ความคืบหน้า

- หากต้องการความล่าช้า/ปริมาณงานสูง ควรพิจารณา SLA ของผู้ให้บริการ และพิจารณาว่าจะโฮสต์เองหรือใช้ตัวเร่งความเร็วของผู้ให้บริการ

การปิดบันทึก

DeepSeek-V3.1 เป็นโมเดลไฮบริดที่ใช้งานได้จริง ออกแบบมาสำหรับทั้งการแชทที่รวดเร็วและงานที่ซับซ้อนของเอเจนต์ รูปแบบ API ที่เข้ากันได้กับ OpenAI ทำให้การย้ายข้อมูลเป็นเรื่องง่ายสำหรับหลายโครงการ ขณะที่เลเยอร์ความเข้ากันได้ของ Anthropic และ CometAPI ทำให้มีความยืดหยุ่นสำหรับระบบนิเวศที่มีอยู่ ผลการทดสอบประสิทธิภาพและรายงานจากชุมชนแสดงให้เห็นถึงการแลกเปลี่ยนระหว่างต้นทุนและประสิทธิภาพที่น่าพึงพอใจ แต่เช่นเดียวกับโมเดลใหม่ๆ ควรตรวจสอบความถูกต้องของโมเดลกับเวิร์กโหลดที่ใช้งานจริง (การแจ้งข้อผิดพลาด การเรียกใช้ฟังก์ชัน การตรวจสอบความปลอดภัย ความล่าช้า) ก่อนการเปิดตัวผลิตภัณฑ์เต็มรูปแบบ

บน CometAPI คุณสามารถรันได้อย่างปลอดภัยและโต้ตอบกับมันผ่าน API ที่เข้ากันได้กับ OpenAI หรือ API ที่เป็นมิตรต่อผู้ใช้ สนามเด็กเล่น, โดยไม่มีข้อจำกัดอัตรา

👉 ติดตั้ง DeepSeek-V3.1 บน CometAPI ทันที!

เหตุใดจึงต้องใช้ CometAPI?

- ผู้ให้บริการมัลติเพล็กซ์: เปลี่ยนผู้ให้บริการโดยไม่ต้องเขียนโค้ดใหม่

- การเรียกเก็บเงิน/เมตริกแบบรวม:หากคุณกำหนดเส้นทางโมเดลหลายตัวผ่าน CometAPI คุณจะได้รับพื้นผิวการรวมเพียงอันเดียว

- เมตาดาต้าของโมเดล: ดูความยาวบริบทและพารามิเตอร์ที่ใช้งานอยู่ต่อตัวแปรโมเดล