Việc phát hành GLM-5, được công bố trong tuần này bởi Zhipu AI của Trung Quốc (được giới thiệu công khai là Z.AI / zai-org trên nhiều kênh dành cho nhà phát triển), đánh dấu một bước tiến nữa trong nhịp độ phát hành các mô hình lớn đang tăng tốc. Mô hình mới được định vị là sản phẩm chủ lực của Zhipu: quy mô lớn hơn, tinh chỉnh cho các tác vụ tác nhân dài hạn, và được xây dựng với các lựa chọn kỹ thuật nhằm giảm chi phí suy luận đồng thời vẫn giữ ngữ cảnh dài. Các báo cáo sớm trong ngành và ghi chú thực nghiệm từ nhà phát triển cho thấy những cải thiện đáng kể về khả năng lập trình, suy luận nhiều bước và điều phối tác nhân so với các phiên bản GLM trước — và trong một số thử nghiệm, nó thậm chí còn thách thức Claude 4.5.

GLM-5 là gì và ai xây dựng?

GLM-5 là bản phát hành lớn mới nhất trong họ GLM: một mô hình nền tảng mã nguồn mở quy mô lớn được phát triển và công bố bởi Z.ai (đội ngũ đứng sau dòng GLM). Được công bố vào đầu tháng 2 năm 2026, GLM-5 được giới thiệu như một mô hình thế hệ tiếp theo được tinh chỉnh đặc biệt cho các tác vụ “agentic” — tức là các quy trình nhiều bước, dài hạn nơi mô hình phải lập kế hoạch, gọi công cụ, thực thi và duy trì ngữ cảnh cho các cuộc hội thoại kéo dài hoặc các tác nhân tự động. Bản phát hành này đáng chú ý không chỉ bởi thiết kế mô hình mà còn bởi cách thức và nơi nó được huấn luyện: Z.ai đã sử dụng kết hợp phần cứng và chuỗi công cụ trong nước Trung Quốc như một phần của nỗ lực hướng tới tự chủ.

Các số liệu kiến trúc và huấn luyện được báo cáo gồm:

- Mở rộng tham số: GLM-5 mở rộng lên khoảng 744B tham số (với số chuyên gia “active” nhỏ hơn được đề cập trong một số ghi chú kỹ thuật, ví dụ 40B active), so với kích thước họ GLM-4 trước đây khoảng 355B/32B active.

- Dữ liệu tiền huấn luyện: Kích thước corpora huấn luyện được cho là tăng từ ~23 nghìn tỷ token (thế hệ GLM-4) lên ~28,5 nghìn tỷ token cho GLM-5.

- Sparse attention / DeepSeek Sparse Attention (DSA): Một cơ chế chú ý thưa nhằm giữ ngữ cảnh dài trong khi giảm chi phí tính toán ở giai đoạn suy luận.

- Nhấn mạnh thiết kế: các lựa chọn kỹ thuật tập trung vào điều phối tác nhân, suy luận ngữ cảnh dài và suy luận chi phí hiệu quả.

Nguồn gốc và định vị

GLM-5 kế thừa từ dòng sản phẩm bao gồm GLM-4.5 (phát hành giữa năm 2025) và một số cập nhật lặp như 4.7. Z.ai định vị GLM-5 là bước chuyển từ “vibe coding” (xuất mã nhanh một bước) sang “agentic engineering”: suy luận bền vững, điều phối đa công cụ và tổng hợp hệ thống trong các cửa sổ ngữ cảnh dài. Tài liệu công khai nhấn mạnh rằng GLM-5 được thiết kế để xử lý các tác vụ kỹ thuật hệ thống phức tạp — xây dựng, phối hợp và duy trì các hành vi tác nhân nhiều bước thay vì chỉ trả lời các truy vấn đơn lẻ.

GLM-5 có những tính năng mới gì?

Thay đổi kiến trúc chính

- Mở rộng thưa ở quy mô lớn (MoE): GLM-5 chuyển sang kiến trúc Mixture-of-Experts thưa với quy mô lớn hơn nhiều. Số liệu công khai từ các trang dành cho nhà phát triển và các bài viết độc lập liệt kê mô hình khoảng 744B tổng tham số với ~40B active mỗi token — một bước tăng đáng kể so với cấu hình ~355B / 32B active của GLM-4.5. Việc mở rộng thưa cho phép mô hình có dung lượng tổng thể rất lớn đồng thời giữ chi phí tính toán trên mỗi token ở mức khả thi.

- DeepSeek Sparse Attention (DSA): Để duy trì khả năng ngữ cảnh dài mà không tăng tuyến tính chi phí suy luận, GLM-5 tích hợp cơ chế chú ý thưa (thương hiệu DeepSeek) nhằm giữ các phụ thuộc dài hạn quan trọng ở quy mô lớn trong khi cắt giảm chi phí chú ý trên các ngữ cảnh siêu dài.

“Agentic engineering” là mục tiêu thiết kế nền tảng

Một trong những tính năng nổi bật của GLM-5 là nó được thiết kế rõ ràng cho “agentic engineering” — nghĩa là mô hình dự định được sử dụng không chỉ cho trò chuyện một lượt hay tóm tắt, mà như “bộ não” của các tác nhân nhiều bước có thể lập kế hoạch, phát lệnh gọi công cụ, quản lý trạng thái và suy luận trên ngữ cảnh dài. Z.ai định vị GLM-5 để phục vụ trong các vòng điều phối: phân rã vấn đề phức tạp, gọi công cụ/API bên ngoài, và theo dõi các tác vụ dài qua nhiều lượt.

Vì sao thiết kế “agentic” quan trọng

Các quy trình tác nhân là trung tâm của tự động hóa thực tế: trợ lý nghiên cứu tự động, kỹ sư phần mềm tự chủ, điều phối vận hành và điều khiển mô phỏng. Một mô hình xây cho thế giới này cần khả năng lập kế hoạch mạnh, hành vi gọi công cụ ổn định và độ bền vững trên hàng nghìn token ngữ cảnh.

Cải thiện về lập trình, suy luận và hành vi “dài hạn”

GLM-5 nhấn mạnh cải thiện về sinh mã và suy luận. Z.ai cho biết các nâng cấp có mục tiêu trong khả năng viết, tái cấu trúc và gỡ lỗi mã, cùng suy luận nhiều bước nhất quán hơn trong các tương tác dài. Các báo cáo quyền truy cập sớm và đánh giá từ đối tác nhận thấy mô hình mạnh mẽ đáng kể ở các tác vụ hướng tới nhà phát triển so với các thế hệ GLM trước.

Tính năng thực tế cho nhà phát triển

- Cửa sổ ngữ cảnh lớn hơn để chứa tài liệu, codebase và trạng thái hội thoại.

- Các nguyên thủy tooling cho việc gọi công cụ an toàn và xử lý kết quả.

- Hiệu suất few-shot và chain-of-thought tốt hơn để phân rã và thực thi các tác vụ phức tạp.

- Tính năng tác nhân và gọi công cụ: GLM-5 nhấn mạnh hỗ trợ gốc cho tác nhân: gọi hàm/công cụ, phiên có trạng thái, và quản lý tốt hơn các đối thoại dài cùng chuỗi sử dụng công cụ. Điều này giúp việc xây dựng tác nhân tích hợp tìm kiếm web, cơ sở dữ liệu hoặc tự động hóa tác vụ trở nên dễ dàng hơn.

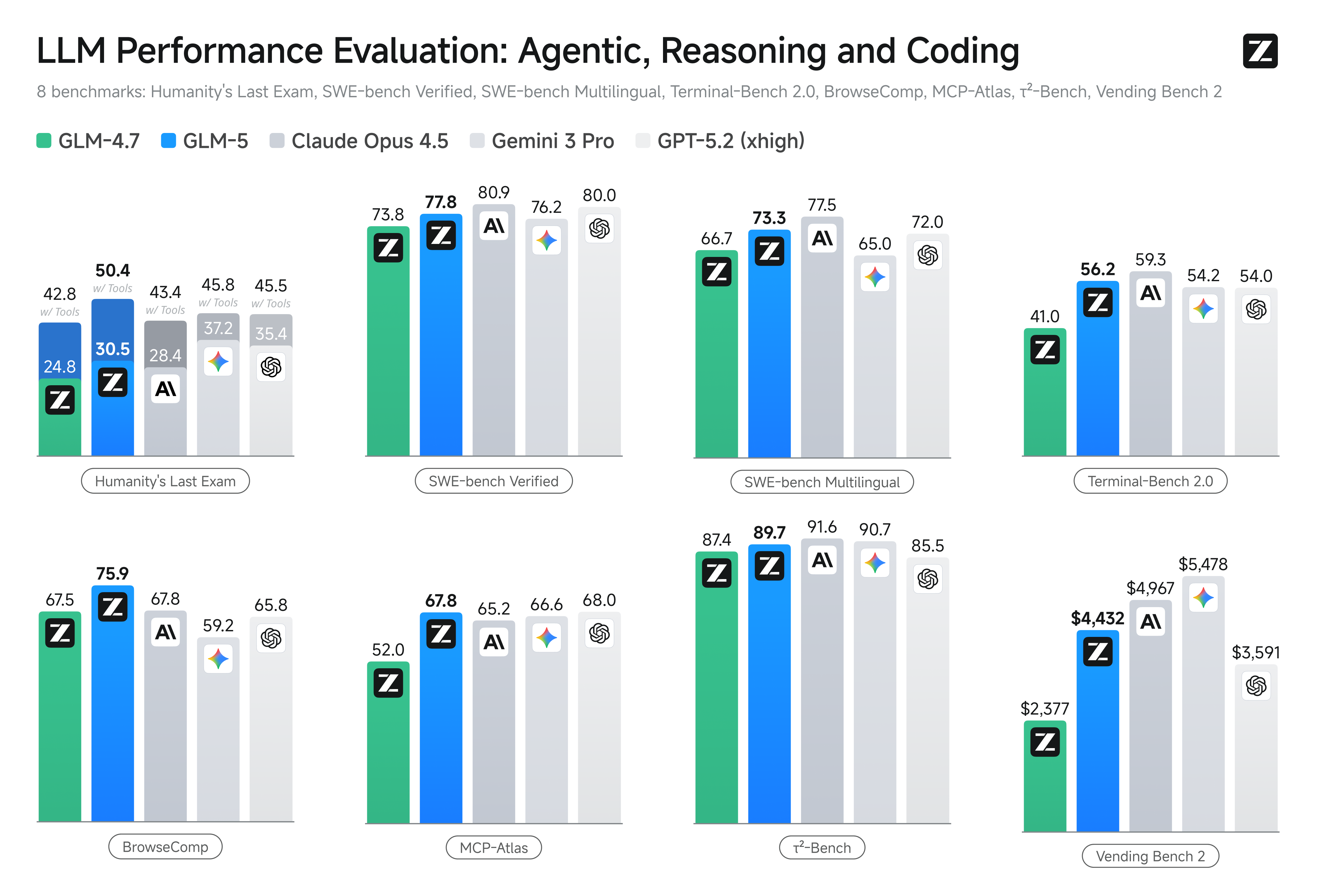

GLM-5 hoạt động thế nào trên các benchmark?

Những điểm nổi bật cụ thể

- Benchmark lập trình: GLM-5 tiến gần (và trong một số trường hợp, sánh ngang) với hiệu năng lập trình của các mô hình độc quyền được tối ưu cao như Claude Opus 4.5 của Anthropic trên các tác vụ mã cụ thể. Kết quả phụ thuộc theo tác vụ (kiểm thử đơn vị, lập trình thuật toán, sử dụng API), nhưng ghi nhận cải thiện rõ rệt so với GLM-4.5.

- Suy luận và bài kiểm tra tác nhân: Trên các bộ đánh giá suy luận nhiều bước và tác nhân (ví dụ lập kế hoạch nhiều lượt, benchmark phân rã nhiệm vụ), GLM-5 đạt kết quả dẫn đầu trong các mô hình mã nguồn mở và ở một số chỉ số đã vượt các mô hình đóng trên những tác vụ mục tiêu.

Làm sao để truy cập và thử GLM-5?

GLM-5 là mô hình ngôn ngữ lớn thế hệ thứ năm từ Zhipu AI (Z.ai), xây dựng với kiến trúc Mixture-of-Experts (~745 B tổng, ~44 B active) và hướng tới suy luận mạnh, lập trình, cùng các quy trình tác nhân. Nó được ra mắt chính thức khoảng ngày 12/02/2026.

Hiện có hai cách chính để mọi người truy cập:

A) Truy cập API chính thức (Z.ai hoặc các bộ tổng hợp)

Zhipu AI cung cấp API cho các mô hình của mình, và bạn có thể gọi GLM-5 thông qua các API này.

Các bước thông thường:

- Đăng ký tài khoản Z.ai/Open BigModel API.

- Lấy khóa API từ bảng điều khiển.

- Sử dụng endpoint OpenAPI-style hoặc REST với tên mô hình (ví dụ,

glm-5).

(Tương tự cách bạn gọi các mô hình GPT từ OpenAI). - Đặt prompt và gửi yêu cầu HTTP.

👉 Trang giá của Z.ai hiển thị mức giá token chính thức của GLM-5 như:

- ~$1,0 mỗi triệu token đầu vào

- ~$3,2 mỗi triệu token đầu ra

B) Trình bao API bên thứ ba ——CometAPI

Các API như CometAPI hoặc WaveSpeed gói nhiều mô hình AI (OpenAI, Claude, Z.ai, v.v.) sau một giao diện thống nhất.

- Với các dịch vụ như CometAPI, bạn có thể gọi các mô hình GLM bằng cách chuyển đổi ID mô hình.

(CometAPI hiện hỗ trợ GLM-5/GLM-4.7.) - glm-5 của CometAPI được định giá ở mức 20% so với giá chính thức.

| Loại sử dụng | Giá |

|---|---|

| Token đầu vào | ~$0,8 per 1M tokens |

| Token đầu ra | ~$2,56 per 1M tokens |

Vì sao điều này quan trọng: Bạn giữ nguyên mã client tương thích OpenAI hiện có và chỉ cần đổi base URL/ID mô hình.

C) Tự lưu trữ qua Hugging Face / Weights

Có các kho trọng số GLM-5 không chính thức (ví dụ các phiên bản tên glm-5/glm-5-fp8) xuất hiện trong danh sách mô hình trên Hugging Face.

Với các kho đó, bạn có thể:

- Tải trọng số mô hình.

- Sử dụng các công cụ như vLLM, SGLang, xLLM, hoặc Transformers để phục vụ cục bộ hoặc trên cụm GPU đám mây của bạn.

Ưu điểm: kiểm soát tối đa, không chi phí API liên tục.

Nhược điểm: yêu cầu tính toán khổng lồ — có thể cần nhiều GPU cao cấp và bộ nhớ (hàng trăm GB), không khả thi trên các hệ thống nhỏ.

Vậy — GLM-5 có đáng giá không, và bạn có nên giữ GLM-4.7?

Câu trả lời ngắn gọn (tóm tắt cấp quản lý)

- Nếu công việc của bạn cần hành vi tác nhân nhiều bước vững chắc, sinh mã cấp sản xuất, hoặc tự động hóa cấp hệ thống: nên đánh giá GLM-5 ngay. Kiến trúc, quy mô và tinh chỉnh của nó ưu tiên đúng các kết quả này.

- Nếu bạn cần dịch vụ vi mô hiệu quả chi phí, thông lượng cao (trò chuyện ngắn, phân loại, prompt nhẹ): GLM-4.7 nhiều khả năng vẫn là lựa chọn tiết kiệm nhất. GLM-4.7 giữ tập khả năng mạnh với chi phí mỗi token thấp hơn đáng kể trong nhiều bảng giá và đã được thực chiến.

Câu trả lời dài (khuyến nghị thực tế)

Áp dụng chiến lược phân tầng mô hình: dùng GLM-4.7 cho các tương tác hằng ngày khối lượng lớn và dành GLM-5 cho các bài toán kỹ thuật giá trị cao và điều phối tác nhân. Thí điểm GLM-5 trên một lát sản phẩm nhỏ có bài tập ngữ cảnh dài, tích hợp công cụ và độ đúng của mã; đo lường thời gian kỹ thuật tiết kiệm và chi phí mô hình tăng thêm. Theo thời gian, bạn sẽ biết liệu mức nâng khả năng của GLM-5 có xứng đáng để mở rộng áp dụng hay không.

Với CometAPI, bạn có thể chuyển đổi giữa GLM-4.7 và GLM-5 bất kỳ lúc nào.

Các trường hợp sử dụng thực tế nơi GLM-5 tỏa sáng

1. Điều phối tác nhân phức tạp

Trọng tâm thiết kế của GLM-5 vào lập kế hoạch nhiều bước và gọi công cụ khiến nó phù hợp với các hệ thống phải phối hợp tìm kiếm, gọi API và thực thi chương trình (ví dụ: trợ lý nghiên cứu tự động, trình sinh mã lặp, hoặc tác nhân chăm sóc khách hàng nhiều bước phải tham vấn cơ sở dữ liệu và API bên ngoài).

2. Kỹ thuật nội dung dài & suy luận trên codebase

Khi bạn cần mô hình phân tích, tái cấu trúc hoặc tổng hợp trên nhiều tệp hay một codebase lớn, ngữ cảnh mở rộng và chú ý thưa của GLM-5 là lợi thế trực tiếp — ít lỗi do ngữ cảnh bị cắt và tính nhất quán dài hạn tốt hơn.

3. Tổng hợp tri thức chuyên sâu

Những người phân tích và đội sản phẩm tạo báo cáo phức tạp — bản tổng hợp nghiên cứu nhiều mục, tóm tắt pháp lý hoặc hồ sơ quy định — có thể hưởng lợi từ cải thiện về suy luận nhiều bước ổn định và giảm ảo tưởng trong các thử nghiệm do nhà cung cấp báo cáo.

4. Tự động hóa tác nhân cho quy trình công việc

Các đội xây dựng tự động hóa phải điều phối nhiều hệ thống (ví dụ: lập kế hoạch + ticketing + pipeline triển khai) có thể dùng GLM-5 như bộ lập kế hoạch và thực thi trung tâm, được hỗ trợ bởi khung gọi công cụ và lớp an toàn.

Kết luận

GLM-5 là một bản phát hành quan trọng trong bối cảnh mô hình tiên phong đang phát triển nhanh. Sự nhấn mạnh vào “agentic engineering”, cải thiện lập trình và suy luận, cùng việc mở trọng số khiến nó hấp dẫn cho các đội xây dựng hệ thống AI có ngữ cảnh dài và tích hợp công cụ. Ghi nhận lợi ích thực trên các tác vụ chọn lọc và cân bằng chi phí/hiệu năng đầy hứa hẹn — nhưng người dùng nên đánh giá GLM-5 trên tác vụ cụ thể của mình và chạy benchmark kiểm soát trước khi đưa vào sản xuất.

Nhà phát triển có thể truy cập GLM-5 qua CometAPI ngay bây giờ. Để bắt đầu, hãy khám phá khả năng của mô hình trong Playground và tham khảo Hướng dẫn API để có chỉ dẫn chi tiết. Trước khi truy cập, vui lòng đảm bảo bạn đã đăng nhập CometAPI và lấy khóa API. CometAPI cung cấp mức giá thấp hơn nhiều so với giá chính thức để giúp bạn tích hợp.

Sẵn sàng bắt đầu?→ Sign up fo glm-5 today !

Nếu bạn muốn biết thêm mẹo, hướng dẫn và tin tức về AI hãy theo dõi chúng tôi trên VK, X và Discord!