2025 年 4 月 28 日,Alibaba Cloud 发布了 Qwen 3,这是其大语言模型(LLM)家族的最新版本。本次发布是开源 AI 发展历程中的重要里程碑,提供了一系列可满足多样化应用与用户需求的模型。无论你是开发者、研究人员,还是企业,了解如何访问和使用 Qwen 3 都能在自然语言处理及更广泛领域开启新的可能。

什么是 Qwen 3?

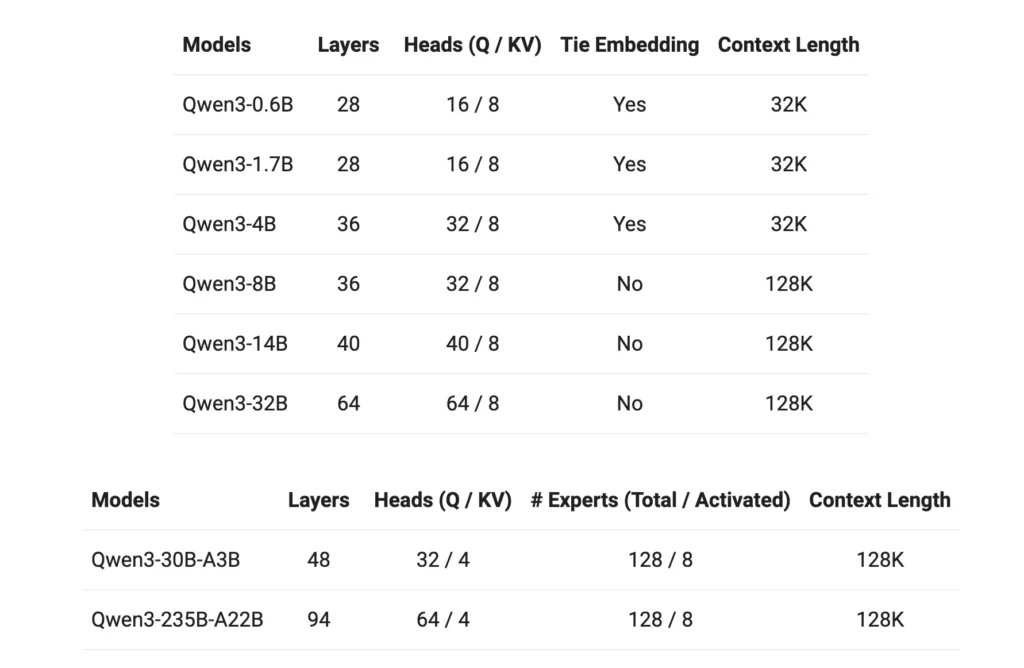

Qwen 3 是 Alibaba Cloud 开源 LLM 的第三代产品,建立在前代基础之上。于 2025 年 4 月 28 日发布的 Qwen 3 引入了多种参数规模的模型,涵盖稠密与稀疏架构。模型基于覆盖 119 种语言和方言的 36 万亿 token 数据集进行训练,使 Qwen 3 能够胜任全球化应用。

Qwen 3 的主要特性

- 模型变体:Qwen 3 提供参数规模为 0.6B、1.7B、4B、8B、14B 和 32B 的稠密模型,以及 30B(激活参数 3B)和 235B(激活参数 22B)的稀疏模型。

- 扩展的上下文窗口:大多数模型支持 128K token 的上下文窗口,便于处理长篇内容。

- 推理能力:增强的推理功能可通过 tokenizer 切换,便于根据具体任务调整性能。

- 多语言能力:训练数据涵盖 119 种语言和方言,使 Qwen 3 能够胜任多语场景。

- 许可:所有模型均以 Apache 2.0 许可证发布,促进开源协作与创新。

如何访问 Qwen3?

访问 Qwen 3(Alibaba Cloud 最新的大语言模型套件)简便且灵活。无论你是希望将先进 AI 能力集成到应用中的开发者,还是探索前沿模型的研究者,Qwen 3 都提供多种接入方式以满足不同需求。

1. 通过 QwenChat Web 界面

若希望零配置即刻交互,QwenChat 提供了友好的网页界面:

- 访问 QwenChat:前往 QwenChat 平台。

- 选择模型:在可用模型中选择如 Qwen3-8B、Qwen3-14B 或 Qwen3-32B 等,依据你的需求。

- 开始对话:通过聊天界面直接进行问答、内容生成或编码辅助等任务。

2. 通过 Alibaba Cloud 的 API 访问

通过 Alibaba Cloud 的 API 服务将 Qwen 3 集成到你的应用中:

获取 API 凭证:在 Alibaba Cloud 注册并获取你的 API key。

选择访问方式:

- 与 OpenAI 兼容的 API:使用与 OpenAI 兼容的端点实现无缝集成。

bashPOST https://dashscope-intl.aliyuncs.com/compatible-mode/v1/chat/completions

- DashScope SDK:或者使用 DashScope SDK 以获得更定制的交互。

- 配置环境:将 API key 设置为环境变量并安装所需 SDK。

3. 通过 Hugging Face 和 ModelScope 访问

适用于偏好开源平台的开发者:

- Hugging Face:通过 Hugging Face 上的 Qwen 组织访问 Qwen 3 模型。

pythonfrom transformers import AutoTokenizer, AutoModelForCausalLM tokenizer = AutoTokenizer.from_pretrained("Qwen/Qwen3-14B") model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen3-14B")

- ModelScope:在 ModelScope 上探索多种 Qwen 3 变体。

4. 本地部署选项

在本地部署 Qwen 3 模型以获得更高的控制力与定制化:

Ollama:简化本地模型管理的平台。

- 安装:从 ollama.com 下载并安装 Ollama。

- 模型部署:使用 Ollama 的 CLI 在本地运行 Qwen 3 模型。

bashollama run qwen3-14b

vLLM:为高吞吐、低延迟服务优化。

- 安装:使用 pip 安装 vLLM。

bashpip install -U vllm

- 模型服务:以启用推理能力的方式提供 Qwen 3 模型服务。

bashvllm serve Qwen/Qwen3-30B-A3B \ --enable-reasoning \ --reasoning-parser deepseek_r1

交互:通过默认 API 服务器 http://localhost:8000 访问模型。

5. 第三方平台:CometAPI

通过 CometAPI 使用 Qwen 3,并提供免费访问:

- CometAPI:注册获取免费 API key,并在集成项目时选择 Qwen3-8B、Qwen3-30B 或 Qwen3-235B 等模型。

如何开始使用 Qwen 3

开始使用 Qwen 3:

- 明确你的使用场景:确定你需要网页界面、API 集成还是本地部署。

- 选择合适的模型:根据计算资源与任务复杂度选择合适的模型变体。

- 配置环境:按照所选接入方式完成安装与配置步骤。

- 集成与测试:将 Qwen 3 集成到应用中并进行测试以确保最佳性能。

遵循以上步骤,你即可有效利用 Qwen 3 的能力,提升项目与研究工作的效果。

实施 Qwen 3:实践注意事项

系统要求

部署 Qwen 3 模型,尤其是更大规模的变体,需要充足的计算资源。请确保具备足够的 GPU 能力与内存,以满足模型规模与处理需求。

集成与自定义

Qwen 3 的开源特性允许进行广泛的定制。开发者可在特定领域数据上微调模型、调整参数以优化性能,并将模型集成到现有系统中以增强功能。

社区与支持

通过论坛、GitHub 讨论区及其他协作平台参与 Qwen 3 社区,可获得宝贵洞见与支持。分享经验与解决方案有助于推动技术的共同进步。

结论

Qwen 3 标志着开源大语言模型领域的重大进步。凭借多样的模型选择、广泛的语言支持与便捷的接入平台,它为众多应用场景提供了强大的工具集。掌握 Qwen 3 的访问与实施方式,能帮助用户在各自领域推动创新与效率提升。

开始使用

开发者可通过 CometAPI 访问 Qwen 3 API。开始之前,可在 Playground 中探索模型能力,并参阅 API 指南 获取详细说明。请注意,部分开发者在使用该模型前可能需要完成组织验证。