Qwen2.5-Omni-7B API 为开发者提供与 OpenAI 兼容的方法与模型交互,支持处理文本、图像、音频和视频输入,并可实时生成文本与自然语音响应。

什么是 Qwen2.5-Omni-7B?

Qwen2.5-Omni-7B 是 Alibaba 的旗舰多模态 AI 模型,拥有 70 亿参数。其设计用于处理与理解多种数据模态,支持文本、图像、音频和视频输入。该模型可实现实时语音与视频交互,使其成为适用于多种应用的多功能工具。

Qwen2.5-Omni-7B 的关键特性

- 多模态处理: 能够处理包括文本、图像、音频和视频在内的多样输入,实现对数据的全面理解。

- 实时交互: 支持低延迟处理,允许进行实时语音与视频对话。

- Thinker-Talker 架构: 采用双架构系统,其中‘Thinker’负责数据处理与理解,‘Talker’生成流畅的语音输出。

- 时间对齐的多模态 RoPE(TMRoPE): 通过 TMRoPE 精确对齐不同模态的时间数据,确保一致的理解与响应生成。

性能指标

基准测试成绩

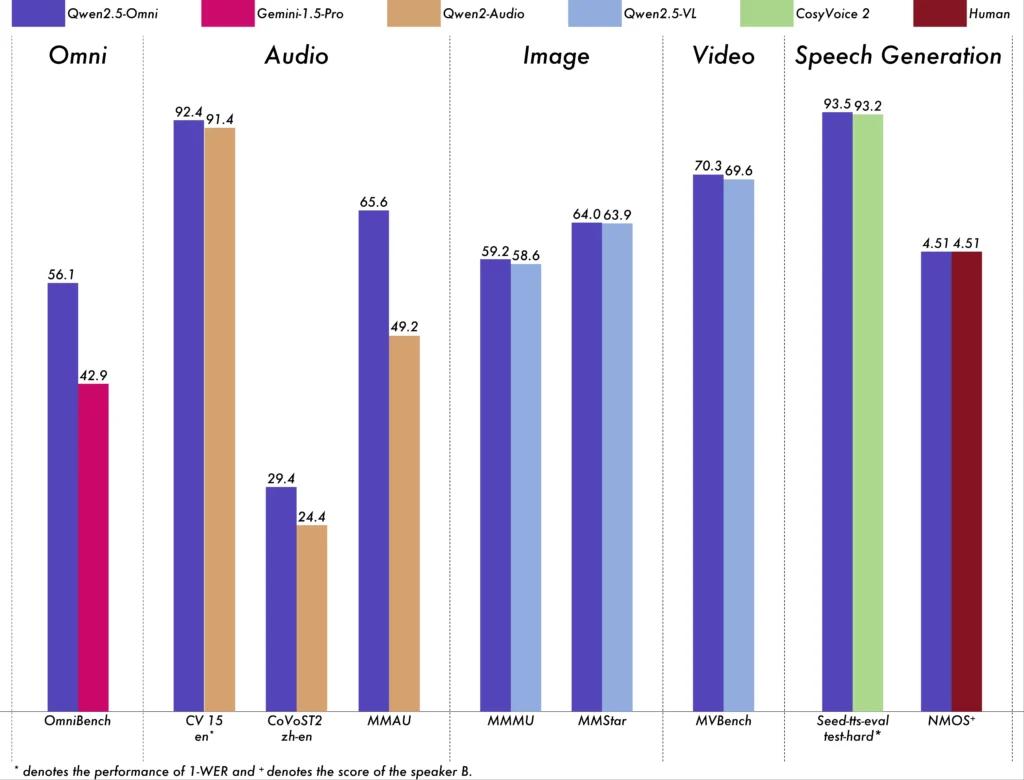

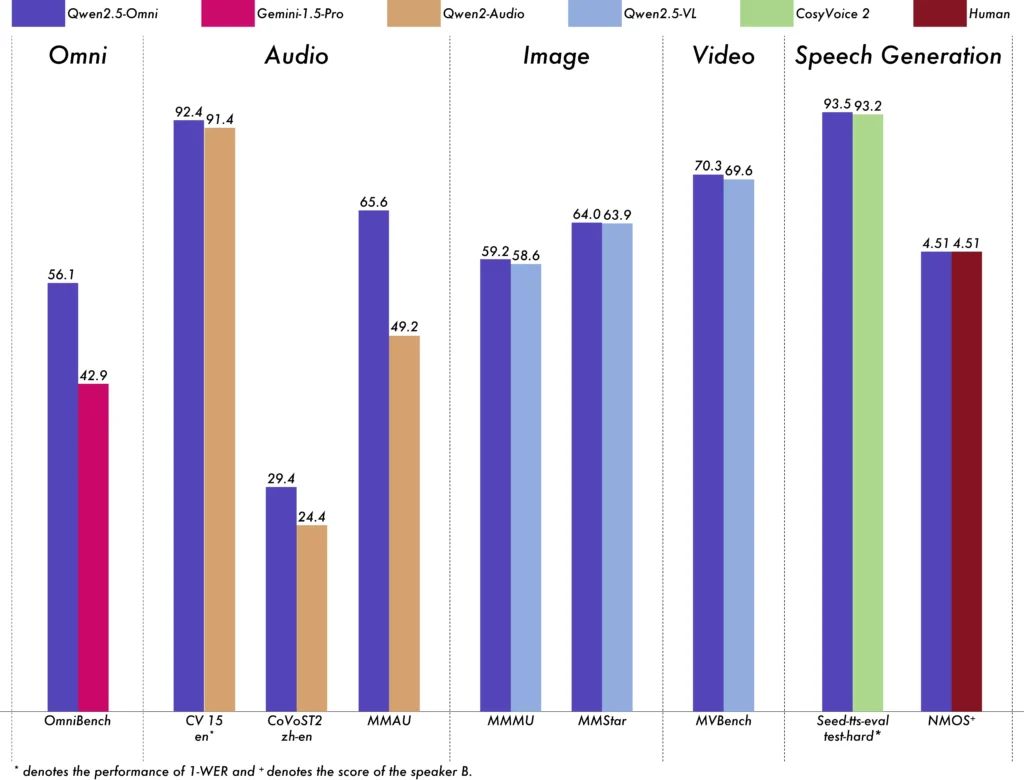

Qwen2.5-Omni-7B 在多项基准测试中展现了卓越性能:

- OmniBench: 平均得分 56.13%,超过 Gemini-1.5-Pro(42.91%)和 MIO-Instruct(33.80%)。

- 语音识别: 在 Librispeech 数据集上,词错误率范围为 1.6% 至 3.5%,与 Whisper-large-v3 等专用模型相当。

- 声音事件识别: 在 Meld 数据集上取得 0.570 的分数,树立了该领域的新基准。

- 音乐理解: 在 GiantSteps Tempo 基准上获得 0.88 分,凸显其对音乐理解的能力。

实时处理能力

面向实时应用场景,Qwen2.5-Omni-7B 支持分块流式传输,以极低延迟即时生成音频。该特性对需要快速响应的应用(如虚拟助手与交互式 AI 系统)尤为有益。

技术规格

架构设计

- Thinker-Talker 框架: ‘Thinker’ 组件处理并理解多模态输入,生成高层语义表示与文本输出;‘Talker’ 将这些表示转换为自然、流畅的语音,确保 AI 系统与用户之间的顺畅沟通。

- TMRoPE 机制: 通过对齐视频与音频输入的时间戳,解决来自不同来源的时间数据同步难题,促进一致的多模态理解。

训练方法

该模型经历了三阶段的训练过程:

- 第一阶段: 固定语言模型参数,同时使用大量音频-文本与图像-文本配对训练视觉与音频编码器,以增强多模态理解。

- 第二阶段: 解冻全部参数,并在包含图像、视频、音频与文本的多样化数据集上训练,进一步提升全面的多模态理解。

- 第三阶段: 重点进行长序列数据训练,以增强模型处理复杂、长篇输入的能力。

Qwen 模型的演进

从 Qwen 到 Qwen2.5 的进展

从 Qwen 到 Qwen2.5 的演进标志着 AI 模型开发的重大飞跃:

- 参数增强: Qwen2.5 扩展至最多 720 亿参数的模型,为多样应用提供可扩展解决方案。

- 上下文扩展处理: 引入最多可处理 128,000 token 的能力,便于应对长文档与复杂对话。

- 编码能力: Qwen2.5-Coder 变体支持超过 92 种编程语言,助力代码生成、调试与优化。

Qwen2.5-Omni-7B 的优势

全面的多模态整合

通过高效处理文本、图像、音频与视频,Qwen2.5-Omni-7B 提供面向广泛应用的整体式 AI 解决方案。

实时交互

其低延迟处理确保即时响应,提升交互式应用的用户体验。

开源可用性

作为开源模型,Qwen2.5-Omni-7B 促进透明性,并允许开发者在无专有限制的前提下定制与集成到各类平台。

技术指标

- 模型参数: 70 亿

- 输入模态: 文本、图像、音频、视频

- 输出模态: 文本、语音

- 处理能力: 实时语音与视频交互

- 性能基准:

- OmniBench: 平均得分 56.13%

- Librispeech(词错误率): Test-clean: 1.8%,Test-other: 3.4%

应用场景

交互式虚拟助手

Qwen2.5-Omni-7B 的实时处理与多模态理解使其非常适合能够看、听并自然响应的虚拟助手。

多媒体内容创作

内容创作者可利用该模型生成引人入胜的多媒体内容,无缝融合文本、图像与音频。

辅助技术

该模型的能力可帮助残障人士,例如为视觉内容提供描述性音频。

使用提示

性能优化

为获得最佳性能,尤其在实时应用中,建议使用硬件加速器并确保充足的 GPU 内存。

与现有系统集成

开发者在与现有应用集成时应考虑模型的输入与输出格式,以确保兼容性并最大化效率。

保持更新

定期查看官方仓库与文档获取更新与最佳实践,以充分发挥 Qwen2.5-Omni-7B 的能力。

结论

Qwen2.5-Omni-7B 体现了前沿 AI 研究与实际应用的融合,为各行业的众多任务提供多功能且高效的解决方案。其开源特性确保其保持可访问与可适配性,为多模态 AI 的未来创新铺平道路。

如何通过 CometAPI 调用 Qwen2.5-Omni-7B API

1.登录 到 cometapi.com。如果您尚未成为我们的用户,请先注册

2.获取接口的访问凭证 API 密钥。在个人中心的 API token 处点击“Add Token”,获取令牌密钥:sk-xxxxx 并提交。

-

获取本站的 url:https://api.cometapi.com/

-

选择 Qwen2.5-Omni-7B 的 endpoint 发送 API 请求并设置请求体。请求方法与请求体可从我们的网站 API 文档获取。我们的网站也提供 Apifox 测试以便您使用。

-

处理 API 响应以获取生成的答案。发送 API 请求后,您将收到一个包含生成结果的 JSON 对象。