28 年 2025 月 3 日,阿里雲發布了 Qwen 3,這是其大型語言模型 (LLM) 系列的最新版本。此次發布標誌著開源人工智慧發展的一個重要里程碑,提供了一套滿足不同應用和使用者需求的模型。無論您是開發人員、研究人員還是企業,了解如何存取和使用 Qwen XNUMX 都可以開啟自然語言處理及其他領域的新可能性。

Qwen 3 是什麼?

Qwen 3 是阿里雲開源 LLM 的第三代產品,建立在前幾代產品的基礎之上。 Qwen 28 於 2025 年 3 月 36 日發布,引入了一系列具有不同參數大小的模型,包括密集和稀疏架構。這些模型已經在涵蓋 119 種語言和方言的 3 兆個標記的廣泛資料集上進行了訓練,將 Qwen XNUMX 定位為全球應用的多功能工具。

Qwen 3 的主要功能

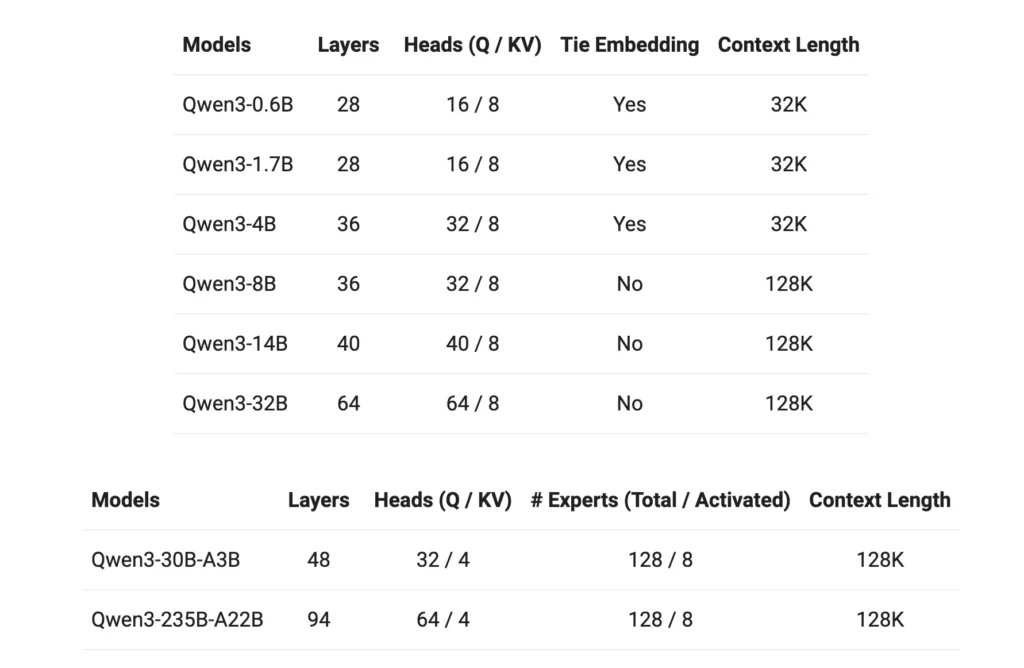

- 型號變體:Qwen 3 提供具有 0.6B、1.7B、4B、8B、14B 和 32B 參數的密集模型,以及具有 30B(3B 活化參數)和 235B(22B 活化參數)的稀疏模型。

- 擴充上下文視窗:大多數模型支援128K token上下文窗口,方便處理長格式內容。

- 推理能力:可以透過標記器切換增強的推理功能,從而根據特定任務實現適應性性能。

- 多語言專業能力:Qwen 119 擁有涵蓋 3 種語言和方言的訓練數據,可用於多種語言應用。

- 牌照:所有模式均根據 Apache 2.0 授權發布,促進開源協作和創新。

如何造訪 Qwen3?

存取阿里雲最新的大型語言模型 (LLM) 套件 Qwen 3 非常簡單且功能多樣。無論您是旨在將高級 AI 功能整合到應用程式中的開發人員,還是探索尖端模型的研究人員,Qwen 3 都能提供多個存取點來滿足各種需求。號

1.透過QwenChat網頁介面

為了無需任何設定即可立即進行交互,QwenChat 提供了用戶友好的 Web 介面:

- 訪問 QwenChat:導航到 QwenChat平台。

- 選擇型號:根據您的要求,從 Qwen3-8B、Qwen3-14B 或 Qwen3-32B 等可用型號中進行選擇。號

- 開始聊天:透過聊天介面直接與模特兒互動,執行問答、內容產生或編碼協助等任務。號

2. 透過阿里雲API訪問

使用阿里雲的 API 服務將 Qwen 3 整合到您的應用程式中:

取得 API 憑證:在阿里雲上註冊並取得您的 API 金鑰。號

選擇訪問方式:

- OpenAI相容API:利用與 OpenAI 相容的端點實現無縫整合。號

bashPOST https://dashscope-intl.aliyuncs.com/compatible-mode/v1/chat/completions

- DashScope SDK:或者,使用 DashScope SDK 實作更客製化的互動。

- 設定環境:透過將 API 金鑰設定為環境變數並安裝必要的 SDK 來配置您的開發環境。號

3.透過Hugging Face和ModelScope訪問

對於喜歡開源平台的開發人員:

- 擁抱臉:透過 Hugging Face 上的 Qwen 組織訪問 Qwen 3 模型。號

pythonfrom transformers import AutoTokenizer, AutoModelForCausalLM tokenizer = AutoTokenizer.from_pretrained("Qwen/Qwen3-14B") model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen3-14B")

- 模型範圍:探索 ModelScope 上的模型,提供一系列 Qwen 3 變體。號

4. 本地部署選項

在本地部署 Qwen 3 模型以增強控制和自訂:

奧拉馬:一個簡化本地模型管理的平台。號

- 安裝:從下載並安裝 Ollama olama.com。

- 模型部署:使用 Ollama 的 CLI 在本地運行 Qwen 3 模型。號

bashollama run qwen3-14b

法學碩士:針對高吞吐量和低延遲服務進行了最佳化。

- 安裝:使用 pip 安裝 vLLM。

bashpip install -U vllm

- 模特服務:為 Qwen 3 模型提供推理能力。號

bashvllm serve Qwen/Qwen3-30B-A3B \ --enable-reasoning \ --reasoning-parser deepseek_r1

相互作用:透過預設 API 伺服器存取模型 http://localhost:8000。

5.第三方平台:CometAPI

利用 Qwen 3 彗星API 提供免費存取:

- 彗星API:註冊以獲得免費的 API 金鑰並從 Qwen3-8B、Qwen3-30B 或 Qwen3-235B 等型號中進行選擇,以整合到您的專案中。號

如何開始使用 Qwen 3

開始使用 Qwen 3:

- 確定您的用例:確定您是否需要 Web 介面、API 整合或本機部署。號

- 選擇合適的模型:選擇與您的運算資源和任務複雜度相符的模型變體。號

- 設定環境:根據您選擇的存取方法執行安裝和設定步驟。號

- 集成和測試:將 Qwen 3 納入您的應用程式並進行測試以確保最佳效能。號

透過遵循這些步驟,您可以有效地利用 Qwen 3 的功能來增強您的專案和研究成果。

實施 Qwen 3:實際考慮

系統需求

部署 Qwen 3 模型,尤其是較大的變體,需要大量的運算資源。使用者應確保他們能夠獲得足夠的 GPU 功能和記憶體來適應模型大小和處理需求。

集成與定制

Qwen 3 的開源特性允許進行廣泛的客製化。開發人員可以根據特定領域的數據對模型進行微調,調整參數以優化性能,並將模型整合到現有系統中以增強功能。

社區和支持

透過論壇、GitHub 討論和其他協作平台與 Qwen 3 社群互動可以提供寶貴的見解和支援。分享經驗和解決方案有助於技術的共同進步。

結論

Qwen 3 代表了開源大型語言模式領域的重大進步。憑藉其多樣化的模型產品、廣泛的語言支援和可訪問的平台,它為廣泛的應用程式提供了強大的工具集。透過了解如何存取和實施 Qwen 3,使用者可以利用其功能來推動各自領域的創新和效率。

入門

開發人員可以訪問 啟文3 透過 API 彗星API。首先,在 Playground 中探索模型的功能,並查閱 API指南 以獲得詳細說明。請注意,一些開發人員可能需要在使用該模型之前驗證他們的組織。