Le 28 avril 2025, Alibaba Cloud a dévoilé Qwen 3, la dernière version de sa gamme de grands modèles de langage (LLM). Cette version marque une étape importante dans l'évolution de l'IA open source, offrant une suite de modèles répondant à diverses applications et besoins utilisateurs. Que vous soyez développeur, chercheur ou entreprise, comprendre comment accéder à Qwen 3 et l'utiliser peut ouvrir de nouvelles perspectives en matière de traitement du langage naturel et au-delà.

Qu'est-ce que Qwen 3 ?

Qwen 3 est la troisième génération des LLM open source d'Alibaba Cloud, s'appuyant sur les fondations de ses prédécesseurs. Lancé le 28 avril 2025, Qwen 3 propose une gamme de modèles avec des tailles de paramètres variables, incluant des architectures denses et éparses. Ces modèles ont été entraînés sur un vaste ensemble de données de 36 119 milliards de jetons répartis dans 3 langues et dialectes, faisant de Qwen XNUMX un outil polyvalent pour les applications mondiales.

Principales caractéristiques de Qwen 3

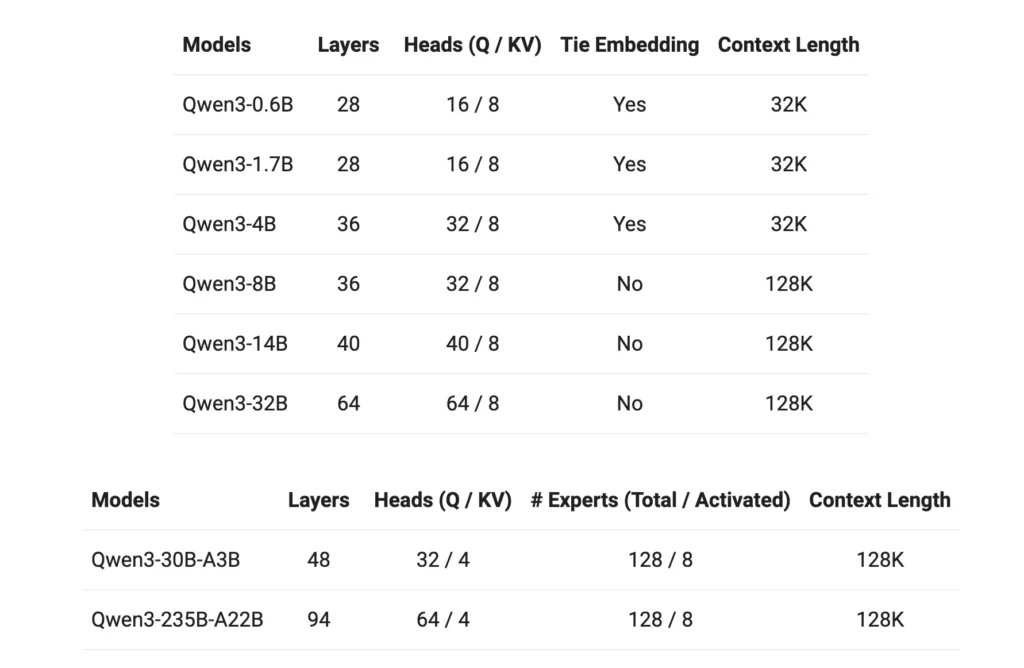

- Variantes de modèle:Qwen 3 propose des modèles denses avec des paramètres de 0.6B, 1.7B, 4B, 8B, 14B et 32B, ainsi que des modèles clairsemés avec 30B (3B paramètres activés) et 235B (22B paramètres activés).

- Fenêtre de contexte étendue:La plupart des modèles prennent en charge une fenêtre de contexte de jeton de 128 Ko, facilitant le traitement du contenu long.

- Capacités de raisonnement:Les fonctions de raisonnement améliorées peuvent être activées via le tokenizer, permettant des performances adaptables en fonction de tâches spécifiques.

- Compétence multilingue:Avec des données de formation couvrant 119 langues et dialectes, Qwen 3 est équipé pour diverses applications linguistiques.

- Licence:Tous les modèles sont publiés sous la licence Apache 2.0, favorisant la collaboration et l'innovation open source.

Comment accéder à Qwen3 ?

L'accès à Qwen 3, la dernière suite de modèles de langages étendus (LLM) d'Alibaba Cloud, est simple et polyvalent. Que vous soyez un développeur souhaitant intégrer des fonctionnalités d'IA avancées à vos applications ou un chercheur explorant des modèles de pointe, Qwen 3 offre de multiples points d'accès pour répondre à différents besoins.

1. Via l'interface Web de QwenChat

Pour une interaction immédiate sans aucune configuration, QwenChat fournit une interface Web conviviale :

- Visitez QwenChat: Accédez au Plateforme QwenChat.

- Sélectionnez un modèle: Choisissez parmi les modèles disponibles tels que Qwen3-8B, Qwen3-14B ou Qwen3-32B en fonction de vos besoins.

- Commencer à discuter: Interagissez directement avec le modèle via l'interface de chat pour des tâches telles que les questions-réponses, la génération de contenu ou l'assistance au codage.

2. Accès API via Alibaba Cloud

Intégrez Qwen 3 dans vos applications à l'aide des services API d'Alibaba Cloud :

Obtenir les informations d'identification de l'API: Inscrivez-vous sur Alibaba Cloud et obtenez votre clé API.

Choisissez la méthode d'accès:

- API compatible OpenAI:Utilisez le point de terminaison compatible OpenAI pour une intégration transparente.

bashPOST https://dashscope-intl.aliyuncs.com/compatible-mode/v1/chat/completions

- Kit de développement logiciel (SDK) DashScope:Vous pouvez également utiliser le SDK DashScope pour des interactions plus personnalisées.

- Configurer l'environnement:Configurez votre environnement de développement en définissant la clé API comme variable d'environnement et en installant les SDK nécessaires.

3. Accès via Hugging Face et ModelScope

Pour les développeurs préférant les plateformes open source :

- Étreindre le visage:Accédez aux modèles Qwen 3 via l'organisation Qwen sur Hugging Face.

pythonfrom transformers import AutoTokenizer, AutoModelForCausalLM tokenizer = AutoTokenizer.from_pretrained("Qwen/Qwen3-14B") model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen3-14B")

- ModèlePortée: Explorez les modèles sur ModelScope, proposant une gamme de variantes de Qwen 3.

4. Options de déploiement local

Déployez les modèles Qwen 3 localement pour un contrôle et une personnalisation améliorés :

Ollama:Une plateforme simplifiant la gestion des modèles locaux.

- en un clic: Téléchargez et installez Ollama depuis ollama.com.

- Déploiement de modèle:Utilisez la CLI d'Ollama pour exécuter les modèles Qwen 3 localement.

bashollama run qwen3-14b

vLLM:Optimisé pour un service à haut débit et à faible latence.

- en un clic: Installez vLLM en utilisant pip.

bashpip install -U vllm

- Modèle de service:Servez Qwen 3 modèles avec des capacités de raisonnement.

bashvllm serve Qwen/Qwen3-30B-A3B \ --enable-reasoning \ --reasoning-parser deepseek_r1

Interaction:Accédez au modèle via le serveur API par défaut à l'adresse http://localhost:8000.

5. Plateformes tierces : CometAPI

Utilisez Qwen 3 à travers API Comet offrant un accès gratuit :

- API Comet: Inscrivez-vous pour obtenir une clé API gratuite et choisissez parmi des modèles tels que Qwen3-8B, Qwen3-30B ou Qwen3-235B pour l'intégration dans vos projets.

Comment démarrer avec Qwen 3

Pour commencer à utiliser Qwen 3 :

- Déterminez votre cas d'utilisation: Identifiez si vous avez besoin d’une interface Web, d’une intégration API ou d’un déploiement local.

- Sélectionnez le modèle approprié: Choisissez une variante de modèle qui correspond à vos ressources de calcul et à la complexité de vos tâches.

- Configurer l'environnement:Suivez les étapes d'installation et de configuration en fonction de la méthode d'accès choisie.

- Intégrer et tester:Intégrez Qwen 3 dans vos applications et effectuez des tests pour garantir des performances optimales.

En suivant ces étapes, vous pouvez exploiter efficacement les capacités de Qwen 3 pour améliorer vos projets et vos efforts de recherche.

Mise en œuvre de Qwen 3 : considérations pratiques

Configuration requise

Le déploiement des modèles Qwen 3, en particulier des plus grandes variantes, nécessite des ressources de calcul importantes. Les utilisateurs doivent s'assurer de disposer de capacités GPU et de mémoire suffisantes pour gérer la taille des modèles et les exigences de traitement.

Intégration et personnalisation

Le caractère open source de Qwen 3 permet une personnalisation poussée. Les développeurs peuvent affiner les modèles en fonction de données spécifiques à un domaine, ajuster les paramètres pour optimiser les performances et intégrer les modèles aux systèmes existants pour améliorer leurs fonctionnalités.

Communauté et soutien

Interagir avec la communauté Qwen 3 via les forums, les discussions GitHub et d'autres plateformes collaboratives peut apporter des informations et un soutien précieux. Le partage d'expériences et de solutions contribue à l'avancement collectif de la technologie.

Conclusion

Qwen 3 représente une avancée significative dans le domaine des grands modèles de langage open source. Grâce à ses offres de modèles diversifiées, à sa prise en charge linguistique étendue et à ses plateformes accessibles, il offre un ensemble d'outils robustes pour un large éventail d'applications. En comprenant comment accéder à Qwen 3 et l'implémenter, les utilisateurs peuvent exploiter ses capacités pour stimuler l'innovation et l'efficacité dans leurs domaines respectifs.

Pour commencer

Les développeurs peuvent accéder Qwen 3 API via API CometPour commencer, explorez les capacités du modèle dans le Playground et consultez le Guide de l'API Pour des instructions détaillées, veuillez noter que certains développeurs devront peut-être vérifier leur organisation avant d'utiliser le modèle.