L'API Qwen2.5-Omni-7B fornisce agli sviluppatori metodi compatibili con OpenAI per interagire con il modello, consentendo l'elaborazione di input di testo, immagini, audio e video e generando risposte sia di testo che di parlato naturale in tempo reale.

Che cos'è Qwen2.5-Omni-7B?

Qwen2.5-Omni-7B è il modello AI multimodale di punta di Alibaba, che vanta 7 miliardi di parametri. Progettato per elaborare e comprendere più modalità di dati, supporta input di testo, immagini, audio e video. Il modello facilita le interazioni vocali e video in tempo reale, rendendolo uno strumento versatile per varie applicazioni.

Caratteristiche principali di Qwen2.5-Omni-7B

- Elaborazione multimodale: In grado di gestire input diversi, tra cui testo, immagini, audio e video, consentendo una comprensione completa dei dati.

- Interazione in tempo reale: Supporta l'elaborazione a bassa latenza, consentendo conversazioni vocali e video in tempo reale.

- Architettura del pensatore-parlatore: Utilizza un sistema a doppia architettura in cui il "pensatore" gestisce l'elaborazione e la comprensione dei dati, mentre il "parlatore" genera output vocali fluidi.

- RoPE multimodale allineato nel tempo (TMRoPE): Utilizza TMRoPE per la sincronizzazione precisa dei dati temporali tra diverse modalità, garantendo una comprensione coerente e la generazione di risposte.

Metriche delle prestazioni

Risultati di riferimento

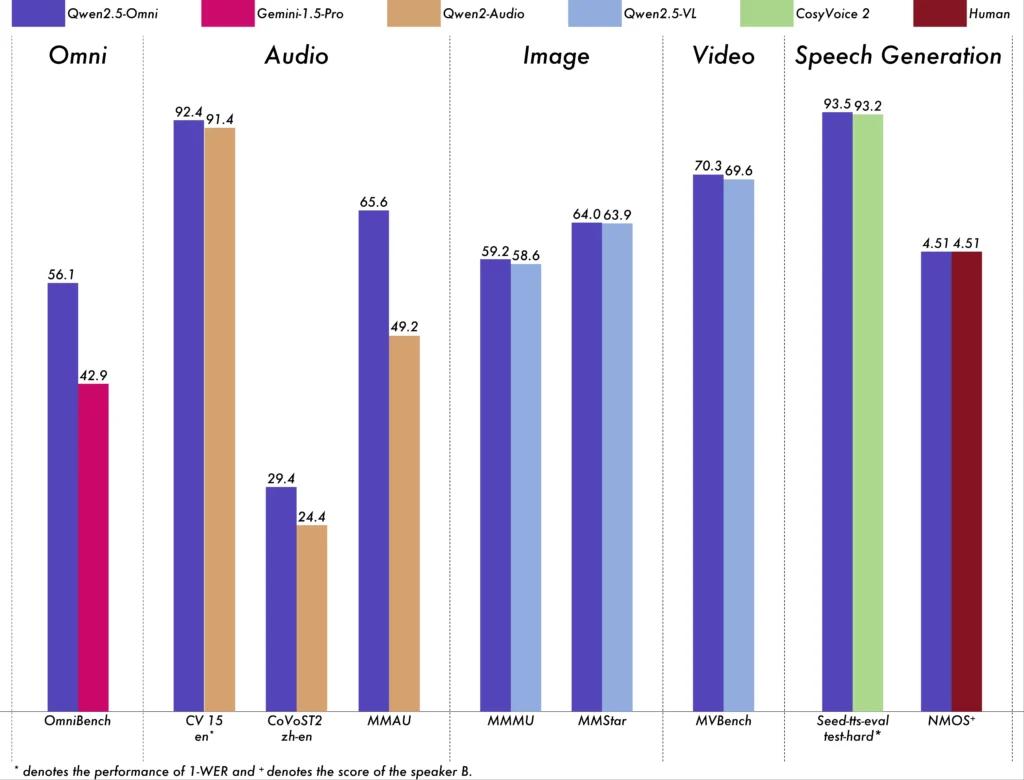

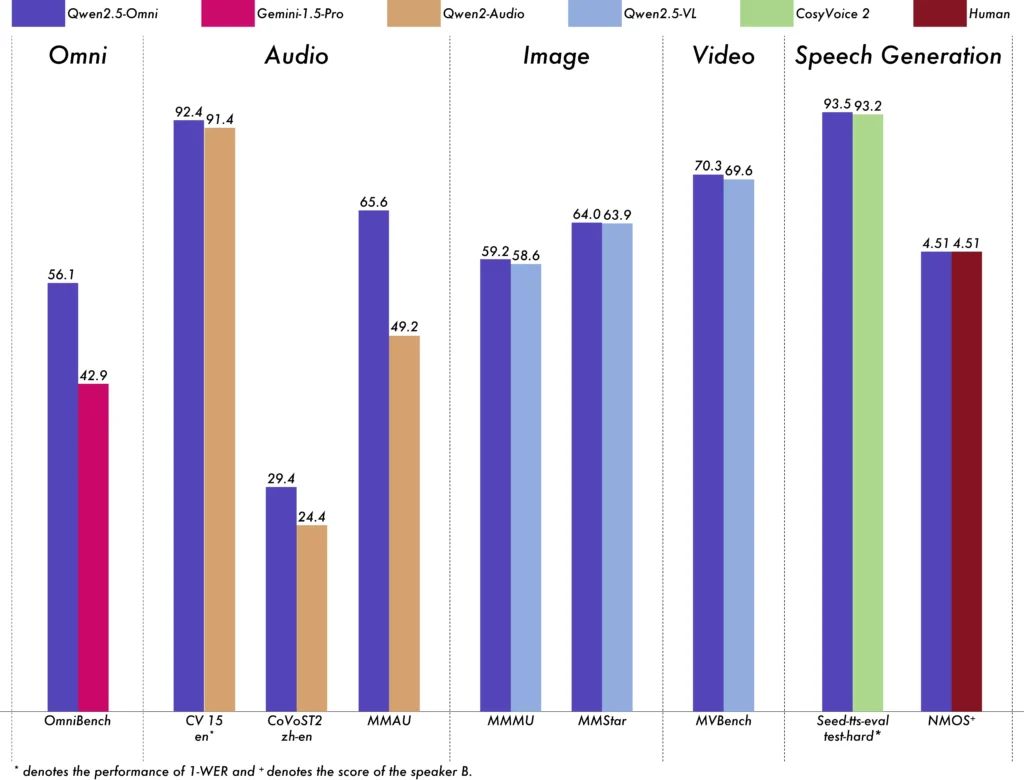

Qwen2.5-Omni-7B ha dimostrato prestazioni eccezionali in vari benchmark:

- OmniBench: Ha ottenuto un punteggio medio del 56.13%, superando modelli come Gemini-1.5-Pro (42.91%) e MIO-Instruct (33.80%).

- Riconoscimento vocale: Nel set di dati Librispeech, sono stati raggiunti tassi di errore di parola compresi tra l'1.6% e il 3.5%, paragonabili a modelli specializzati come Whisper-large-v3.

- Riconoscimento degli eventi sonori: Ottenuto un punteggio di 0.570 sul set di dati Meld, stabilendo un nuovo punto di riferimento nel settore.

- Comprensione musicale: Ha ottenuto un punteggio di 0.88 nel benchmark GiantSteps Tempo, evidenziando la sua competenza nella comprensione musicale.

Capacità di elaborazione in tempo reale

Progettato per applicazioni in tempo reale, Qwen2.5-Omni-7B supporta lo streaming blocco per blocco, consentendo la generazione audio immediata con latenza minima. Questa funzionalità è particolarmente utile per le applicazioni che richiedono risposte rapide, come assistenti virtuali e sistemi AI interattivi.

Specifiche tecniche

Progettazione architettonica

- Struttura del pensatore-parlatore: Il componente 'Thinker' elabora e comprende input multimodali, generando rappresentazioni semantiche di alto livello e output testuali. Il 'Talker' converte queste rappresentazioni in un discorso naturale e fluente, assicurando una comunicazione fluida tra il sistema AI e gli utenti.

- Meccanismo TMRoPE: Risolve la sfida di sincronizzare i dati temporali provenienti da diverse fonti allineando i timestamp degli input video e audio, facilitando una comprensione multimodale coerente.

Metodologia di formazione

Il modello è stato sottoposto a un processo di formazione in tre fasi:

- Fase uno: Parametri del modello linguistico fissi durante l'addestramento di codificatori visivi e audio utilizzando coppie estese di audio-testo e immagine-testo per migliorare la comprensione multimodale.

- Fase due: Sbloccati tutti i parametri e addestrati su un set di dati eterogeneo comprendente immagini, video, audio e testo, migliorando ulteriormente la comprensione multimodale completa.

- Fase tre: Concentrato sull'addestramento dei dati a lunga sequenza per rafforzare la capacità del modello di gestire input complessi ed estesi.

Evoluzione dei modelli Qwen

Progressione da Qwen a Qwen2.5

L'evoluzione da Qwen a Qwen2.5 rappresenta un balzo in avanti sostanziale nello sviluppo dei modelli di intelligenza artificiale:

- Parametri migliorati: Qwen2.5 è stato ampliato con modelli fino a 72 miliardi di parametri, offrendo soluzioni scalabili per diverse applicazioni.

- Elaborazione del contesto esteso: È stata introdotta la possibilità di elaborare fino a 128,000 token, semplificando la gestione di documenti estesi e conversazioni complesse.

- Funzionalità di codifica: La variante Qwen2.5-Coder supporta oltre 92 linguaggi di programmazione, facilitando le attività di generazione, debug e ottimizzazione del codice.

Vantaggi di Qwen2.5-Omni-7B

Integrazione multimodale completa

Elaborando efficacemente testo, immagini, audio e video, Qwen2.5-Omni-7B fornisce una soluzione di intelligenza artificiale olistica adatta a un'ampia gamma di applicazioni.

Interazione in tempo reale

L'elaborazione a bassa latenza garantisce risposte immediate, migliorando l'esperienza utente nelle applicazioni interattive.

Accessibilità open source

In quanto modello open source, Qwen2.5-Omni-7B promuove la trasparenza e consente agli sviluppatori di personalizzare e integrare il modello in varie piattaforme senza restrizioni proprietarie.

Indicatori tecnici

- Parametri del modello: 7 miliardi

- Modalità di input: Testo, Immagine, Audio, Video

- Modalità di output: Testo, Discorso

- Capacità di elaborazione: Interazione vocale e video in tempo reale

- Benchmark delle prestazioni:

- OmniBench: Punteggio medio del 56.13%

- Librispeech (tasso di errore delle parole): Test pulito: 1.8%, Test altro: 3.4%

Scenari di applicazione

Assistenti virtuali interattivi

L'elaborazione in tempo reale e la comprensione multimodale di Qwen2.5-Omni-7B lo rendono ideale per gli assistenti virtuali in grado di vedere, sentire e rispondere in modo naturale.

Creazione di contenuti multimediali

I creatori di contenuti possono sfruttare il modello per generare contenuti multimediali accattivanti, combinando testo, immagini e audio in modo fluido.

Tecnologie assistive

Le funzionalità del modello possono essere di aiuto alle persone con disabilità, ad esempio fornendo audio descrittivi per contenuti visivi.

Suggerimenti per l'uso

Ottimizzazione delle prestazioni

Per ottenere prestazioni ottimali, soprattutto nelle applicazioni in tempo reale, si consiglia di utilizzare acceleratori hardware e di garantire una memoria GPU sufficiente.

Integrazione con sistemi esistenti

Gli sviluppatori dovrebbero considerare i formati di input e output del modello durante l'integrazione con le applicazioni esistenti, per garantire la compatibilità e massimizzare l'efficienza.

Rimanere aggiornato

Controllare regolarmente i repository ufficiali e la documentazione per aggiornamenti e best practice per sfruttare appieno le funzionalità di Qwen2.5-Omni-7B.

Argomenti correlati Come eseguire il modello Qwen2.5-Omni-7B

Conclusione

Qwen2.5-Omni-7B esemplifica la convergenza della ricerca avanzata sull'IA e dell'applicazione pratica, offrendo una soluzione versatile ed efficiente per una moltitudine di attività in vari settori. La sua natura open source garantisce che rimanga accessibile e adattabile, aprendo la strada a future innovazioni nell'IA multimodale.

Come chiamare l'API Qwen2.5-Omni-7B da CometAPI

1.Accesso a cometapi.comSe non sei ancora un nostro utente, registrati prima

2.Ottieni la chiave API delle credenziali di accesso dell'interfaccia. Fai clic su "Aggiungi token" nel token API nel centro personale, ottieni la chiave del token: sk-xxxxx e invia.

-

Ottieni l'URL di questo sito: https://api.cometapi.com/

-

Selezionare l'endpoint Qwen2.5-Omni-7B per inviare la richiesta API e impostare il corpo della richiesta. Il metodo e il corpo della richiesta sono ottenuti da il nostro documento API del sito webPer vostra comodità, il nostro sito web fornisce anche il test Apifox.

-

Elabora la risposta API per ottenere la risposta generata. Dopo aver inviato la richiesta API, riceverai un oggetto JSON contenente il completamento generato.