28년 2025월 3일, 알리바바 클라우드는 대규모 언어 모델(LLM) 제품군의 최신 버전인 Qwen 3를 공개했습니다. 이번 릴리스는 오픈소스 AI 발전에 있어 중요한 이정표로, 다양한 애플리케이션과 사용자 요구를 충족하는 모델 제품군을 제공합니다. 개발자, 연구원, 기업 등 누구든 Qwen XNUMX에 액세스하고 활용하는 방법을 이해하면 자연어 처리는 물론 그 이상의 분야에서 새로운 가능성을 열 수 있습니다.

Qwen 3는 무엇인가요?

Qwen 3는 알리바바 클라우드의 오픈소스 LLM 28세대로, 이전 모델들이 구축한 기반을 기반으로 합니다. 2025년 3월 36일에 출시된 Qwen 119는 밀도(dense) 및 희소(sparse) 아키텍처를 포함하여 다양한 매개변수 크기를 가진 다양한 모델을 제공합니다. 이 모델들은 3개 언어와 방언에 걸쳐 XNUMX조 개의 토큰으로 구성된 방대한 데이터 세트를 기반으로 학습되었으며, Qwen XNUMX는 글로벌 애플리케이션을 위한 다재다능한 도구로 자리매김했습니다.

Qwen 3의 주요 기능

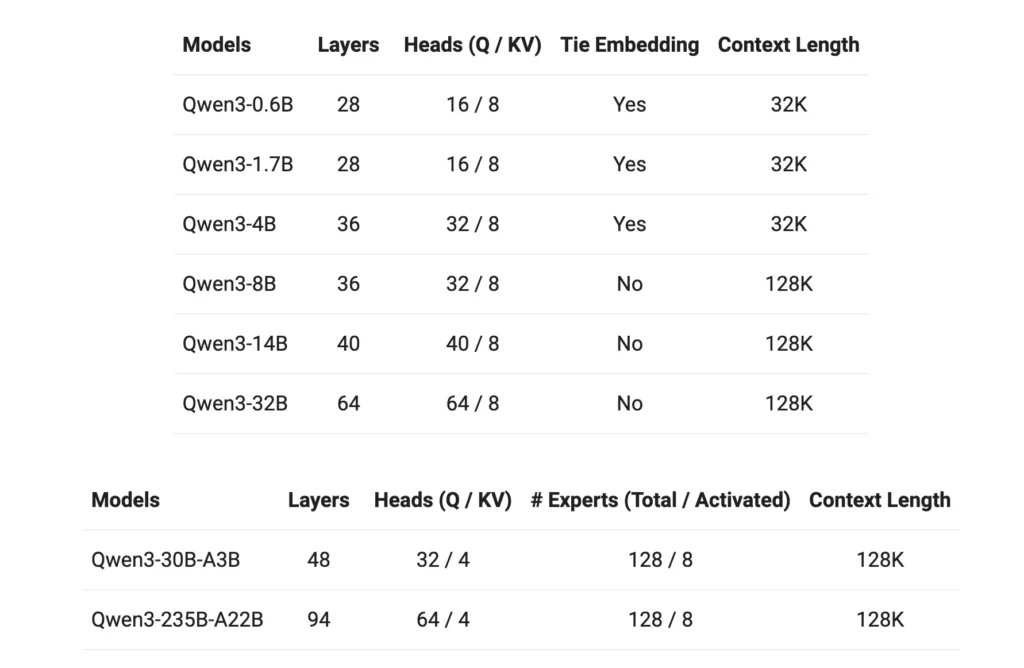

- 모델 변형: Qwen 3은 0.6B, 1.7B, 4B, 8B, 14B, 32B 매개변수를 갖는 고밀도 모델과 30B(3B 활성화 매개변수) 및 235B(22B 활성화 매개변수)를 갖는 희소 모델을 제공합니다.

- 확장된 컨텍스트 창: 대부분의 모델은 128K 토큰 컨텍스트 창을 지원하여 긴 형식의 콘텐츠 처리를 용이하게 합니다.

- 추론 능력: 토크나이저를 통해 향상된 추론 기능을 전환하여 특정 작업에 따라 적응형 성능을 얻을 수 있습니다.

- 다국어 역량: Qwen 119은 3개 언어와 방언을 포함하는 교육 데이터를 갖추고 있어 다양한 언어 응용 분야에 적합합니다.

- Licensing: 모든 모델은 Apache 2.0 라이선스에 따라 출시되어 오픈 소스 협업과 혁신을 촉진합니다.

Qwen3에 어떻게 접속할 수 있나요?

알리바바 클라우드의 최신 대규모 언어 모델(LLM) 제품군인 Qwen 3에 액세스하는 것은 간편하고 다재다능합니다. 고급 AI 기능을 애플리케이션에 통합하려는 개발자든 최첨단 모델을 탐색하는 연구자든, Qwen 3은 다양한 요구에 맞는 여러 액세스 포인트를 제공합니다.

1. QwenChat 웹 인터페이스를 통해

QwenChat은 어떠한 설정 없이도 즉각적인 상호작용을 위해 사용자 친화적인 웹 인터페이스를 제공합니다.

- QwenChat 방문: QwenChat 플랫폼.

- 모델 선택: 요구 사항에 따라 Qwen3-8B, Qwen3-14B 또는 Qwen3-32B와 같은 사용 가능한 모델 중에서 선택하세요.

- 채팅 시작: Q&A, 콘텐츠 생성, 코딩 지원 등의 작업을 위해 채팅 인터페이스를 통해 모델과 직접 소통합니다.

2. Alibaba Cloud를 통한 API 접근

Alibaba Cloud의 API 서비스를 사용하여 Qwen 3을 애플리케이션에 통합하세요.

API 자격 증명 얻기: Alibaba Cloud에 가입하고 API 키를 받으세요.

접속 방법 선택:

- OpenAI 호환 API: 원활한 통합을 위해 OpenAI 호환 엔드포인트를 활용하세요.

bashPOST https://dashscope-intl.aliyuncs.com/compatible-mode/v1/chat/completions

- DashScope SDK: 또는 더욱 맞춤화된 상호작용을 위해 DashScope SDK를 활용하세요.

- 환경 설정: API 키를 환경 변수로 설정하고 필요한 SDK를 설치하여 개발 환경을 구성합니다.

3. Hugging Face 및 ModelScope를 통한 접근

오픈 소스 플랫폼을 선호하는 개발자의 경우:

- 포옹하는 얼굴: Hugging Face의 Qwen 조직을 통해 Qwen 3 모델에 접근하세요.

pythonfrom transformers import AutoTokenizer, AutoModelForCausalLM tokenizer = AutoTokenizer.from_pretrained("Qwen/Qwen3-14B") model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen3-14B")

- 모델 범위: ModelScope에서 다양한 Qwen 3 변형을 제공하는 모델을 탐색해 보세요.

4. 로컬 배포 옵션

향상된 제어 및 사용자 정의를 위해 Qwen 3 모델을 로컬로 배포하세요.

올라마: 로컬 모델 관리를 간소화하는 플랫폼입니다.

- 설치: Ollama를 다운로드하고 설치하세요 ollama.com.

- 모델 배포: Ollama의 CLI를 사용하여 Qwen 3 모델을 로컬로 실행합니다.

bashollama run qwen3-14b

vLLM: 높은 처리량과 낮은 지연 시간의 서비스를 제공하도록 최적화되었습니다.

- 설치: pip를 사용하여 vLLM을 설치합니다.

bashpip install -U vllm

- 모델 서빙: 추론 기능을 갖춘 3가지 모델을 제공합니다.

bashvllm serve Qwen/Qwen3-30B-A3B \ --enable-reasoning \ --reasoning-parser deepseek_r1

상호 작용: 기본 API 서버를 통해 모델에 액세스합니다. http://localhost:8000.

5. 타사 플랫폼: CometAPI

Qwen 3을 통해 활용하세요 코멧API 무료 액세스를 제공합니다:

- 코멧API: 등록하고 무료 API 키를 받으세요. 프로젝트에 통합할 Qwen3-8B, Qwen3-30B, Qwen3-235B 등의 모델 중에서 선택하세요.

Qwen 3를 시작하는 방법

Qwen 3 사용을 시작하려면:

- 사용 사례 결정: 웹 인터페이스, API 통합 또는 로컬 배포가 필요한지 확인하세요.

- 적절한 모델을 선택하세요: 컴퓨팅 리소스와 작업 복잡성에 맞는 모델 변형을 선택하세요.

- 환경 설정: 선택한 액세스 방법에 따라 설치 및 구성 단계를 따르세요.

- 통합 및 테스트: Qwen 3을 애플리케이션에 통합하고 테스트를 수행하여 최적의 성능을 확인하세요.

이러한 단계를 따르면 Qwen 3의 기능을 효과적으로 활용하여 프로젝트와 연구 활동을 강화할 수 있습니다.

Qwen 3 구현: 실용적인 고려 사항

시스템 요구 사항

Qwen 3 모델, 특히 더 큰 변형 모델을 배포하려면 상당한 컴퓨팅 리소스가 필요합니다. 사용자는 모델 크기와 처리 요구 사항을 충족할 수 있는 적절한 GPU 성능과 메모리를 확보해야 합니다.

통합 및 맞춤화

Qwen 3는 오픈 소스이므로 광범위한 사용자 정의가 가능합니다. 개발자는 도메인별 데이터에 따라 모델을 미세 조정하고, 최적화된 성능을 위해 매개변수를 조정하고, 기존 시스템에 모델을 통합하여 기능을 향상시킬 수 있습니다.

커뮤니티 및 지원

포럼, GitHub 토론, 기타 협업 플랫폼을 통해 Qwen 3 커뮤니티와 소통하면 귀중한 통찰력과 지원을 얻을 수 있습니다. 경험과 솔루션을 공유함으로써 기술의 공동 발전에 기여할 수 있습니다.

결론

Qwen 3는 오픈 소스 대규모 언어 모델 분야에서 상당한 발전을 이루었습니다. 다양한 모델 제공, 광범위한 언어 지원, 그리고 접근성 높은 플랫폼을 통해 광범위한 애플리케이션을 위한 강력한 툴셋을 제공합니다. 사용자는 Qwen 3의 접근 및 구현 방법을 이해함으로써 해당 기능을 활용하여 각자의 분야에서 혁신과 효율성을 증진할 수 있습니다.

시작 가이드

개발자는 액세스할 수 있습니다 퀀 3 API를 통해 코멧API시작하려면 Playground에서 모델의 기능을 탐색하고 다음을 참조하세요. API 가이드 자세한 지침은 를 참조하세요. 일부 개발자는 모델을 사용하기 전에 소속 기관을 확인해야 할 수도 있습니다.