28 kwietnia 2025 r. Alibaba Cloud zaprezentowała Qwen 3, najnowszą wersję swojej rodziny dużych modeli językowych (LLM). Ta wersja stanowi znaczący kamień milowy w ewolucji AI typu open source, oferując zestaw modeli, które odpowiadają różnorodnym aplikacjom i potrzebom użytkowników. Niezależnie od tego, czy jesteś programistą, badaczem czy przedsiębiorstwem, zrozumienie, jak uzyskać dostęp do Qwen 3 i jak go wykorzystać, może otworzyć nowe możliwości w zakresie przetwarzania języka naturalnego i nie tylko.

Czym jest Qwen 3?

Qwen 3 to trzecia generacja open-source'owych LLM Alibaba Cloud, bazująca na fundamentach położonych przez poprzedników. Wydany 28 kwietnia 2025 r. Qwen 3 wprowadza szereg modeli o różnych rozmiarach parametrów, w tym zarówno gęste, jak i rzadkie architektury. Modele te zostały wytrenowane na rozległym zestawie danych 36 bilionów tokenów w 119 językach i dialektach, co pozycjonuje Qwen 3 jako wszechstronne narzędzie do globalnych aplikacji.

Główne cechy Qwen 3

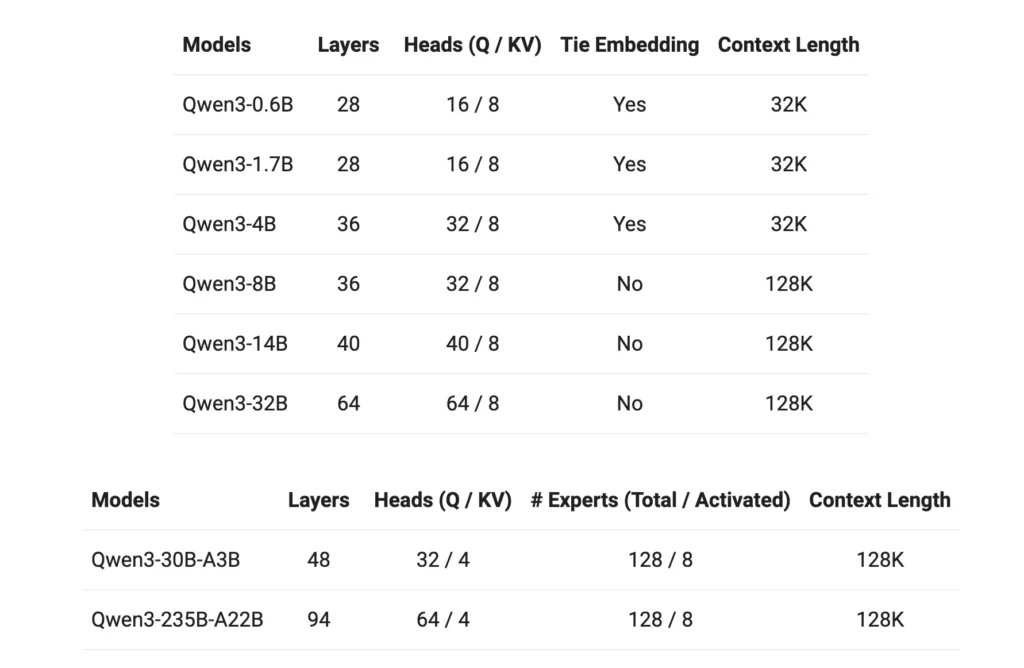

- Warianty modelu:Qwen 3 oferuje gęste modele z parametrami 0.6B, 1.7B, 4B, 8B, 14B i 32B, a także rzadkie modele z parametrami 30B (3B aktywnych parametrów) i 235B (22B aktywnych parametrów).

- Rozszerzone okno kontekstowe:Większość modeli obsługuje okno kontekstowe tokena o rozmiarze 128 KB, co ułatwia przetwarzanie treści o długiej formie.

- Możliwości rozumowania:Ulepszone funkcje wnioskowania można włączać i wyłączać za pomocą tokenizera, co pozwala na dostosowanie wydajności do konkretnych zadań.

- Znajomość wielu języków:Dzięki danym treningowym obejmującym 119 języków i dialektów, Qwen 3 jest przygotowany do różnorodnych zastosowań lingwistycznych.

- Koncesjonowanie:Wszystkie modele są udostępniane na licencji Apache 2.0, promującej współpracę i innowacyjność w ramach oprogramowania typu open source.

Jak uzyskać dostęp do Qwen3?

Dostęp do Qwen 3, najnowszego pakietu dużych modeli językowych (LLM) Alibaba Cloud, jest prosty i wszechstronny. Niezależnie od tego, czy jesteś deweloperem, który chce zintegrować zaawansowane możliwości AI ze swoimi aplikacjami, czy badaczem badającym najnowocześniejsze modele, Qwen 3 oferuje wiele punktów dostępu, aby zaspokoić różne potrzeby.

1. Poprzez interfejs internetowy QwenChat

Aby umożliwić natychmiastową interakcję bez konieczności konfiguracji, QwenChat zapewnia przyjazny dla użytkownika interfejs internetowy:

- Odwiedź QwenChat: Przejdź do Platforma QwenChat.

- Wybierz model: Wybierz spośród dostępnych modeli, takich jak Qwen3-8B, Qwen3-14B lub Qwen3-32B, w zależności od swoich potrzeb.

- Zacząć gadać:Nawiąż kontakt z modelką bezpośrednio za pomocą interfejsu czatu, aby wykonać takie zadania, jak sesja pytań i odpowiedzi, generowanie treści lub pomoc w kodowaniu.

2. Dostęp do API poprzez Alibaba Cloud

Zintegruj Qwen 3 ze swoimi aplikacjami, korzystając z usług API Alibaba Cloud:

Uzyskaj dane uwierzytelniające API:Zarejestruj się w Alibaba Cloud i zdobądź swój klucz API.

Wybierz metodę dostępu:

- API zgodne z OpenAI: Wykorzystaj punkt końcowy zgodny z OpenAI, aby zapewnić bezproblemową integrację.

bashPOST https://dashscope-intl.aliyuncs.com/compatible-mode/v1/chat/completions

- Zestaw SDK DashScope:Alternatywnie można zastosować pakiet DashScope SDK w celu uzyskania bardziej dostosowanych interakcji.

- Skonfiguruj środowisko: Skonfiguruj środowisko programistyczne, ustawiając klucz API jako zmienną środowiskową i instalując niezbędne pakiety SDK.

3. Dostęp przez Hugging Face i ModelScope

Dla programistów preferujących platformy typu open source:

- Przytulanie Twarzy:Dostęp do modeli Qwen 3 uzyskasz poprzez organizację Qwen na Hugging Face.

pythonfrom transformers import AutoTokenizer, AutoModelForCausalLM tokenizer = AutoTokenizer.from_pretrained("Qwen/Qwen3-14B") model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen3-14B")

- Zakres modelu:Przeglądaj modele na ModelScope, oferujące szereg wariantów Qwen 3.

4. Opcje wdrażania lokalnego

Wdróż modele Qwen 3 lokalnie, aby uzyskać lepszą kontrolę i możliwość personalizacji:

Ollama:Platforma upraszczająca zarządzanie modelami lokalnymi.

- instalacja sprzętu:Pobierz i zainstaluj Ollamę z ollama.com.

- Wdrożenie modelu: Użyj wiersza poleceń Ollama CLI do lokalnego uruchomienia modeli Qwen 3.

bashollama run qwen3-14b

vLLM:Zoptymalizowany pod kątem obsługi o wysokiej przepustowości i niskich opóźnieniach.

- instalacja sprzętu: Zainstaluj vLLM za pomocą pip.

bashpip install -U vllm

- Wzorcowe serwowanie:Obsługuj 3 modele Qwen ze zdolnością rozumowania.

bashvllm serve Qwen/Qwen3-30B-A3B \ --enable-reasoning \ --reasoning-parser deepseek_r1

Wzajemne oddziaływanie:Dostęp do modelu za pośrednictwem domyślnego serwera API pod adresem http://localhost:8000.

5. Platformy zewnętrzne: CometAPI

Wykorzystaj Qwen 3 do Interfejs API Comet oferujący bezpłatny dostęp:

- Interfejs API Comet: Zarejestruj się, aby uzyskać bezpłatny klucz API i wybrać spośród modeli, takich jak Qwen3-8B, Qwen3-30B lub Qwen3-235B, aby zintegrować je ze swoimi projektami.

Jak zacząć grać w Qwen 3

Aby rozpocząć korzystanie z Qwen 3:

- Określ swój przypadek użycia: Określ, czy potrzebujesz interfejsu internetowego, integracji API czy wdrożenia lokalnego.

- Wybierz odpowiedni model: Wybierz wariant modelu odpowiadający Twoim zasobom obliczeniowym i złożoności zadania.

- Skonfiguruj środowisko: Wykonaj kroki instalacji i konfiguracji w zależności od wybranej metody dostępu.

- Zintegruj i przetestuj:Wdrażaj Qwen 3 w swoich aplikacjach i przeprowadzaj testy, aby zapewnić optymalną wydajność.

Postępując zgodnie z poniższymi krokami, możesz efektywnie wykorzystać możliwości Qwen 3 do ulepszenia swoich projektów i badań.

Wdrażanie Qwen 3: Rozważania praktyczne

Wymagania systemowe

Wdrażanie modeli Qwen 3, zwłaszcza większych wariantów, wymaga znacznych zasobów obliczeniowych. Użytkownicy powinni upewnić się, że mają dostęp do odpowiednich możliwości GPU i pamięci, aby sprostać rozmiarom modelu i wymaganiom przetwarzania.

Integracja i dostosowywanie

Otwarty charakter Qwen 3 pozwala na rozległą personalizację. Deweloperzy mogą dostrajać modele na danych specyficznych dla domeny, dostosowywać parametry w celu zoptymalizowania wydajności i integrować modele z istniejącymi systemami w celu zwiększenia funkcjonalności.

Społeczność i wsparcie

Angażowanie się w społeczność Qwen 3 poprzez fora, dyskusje GitHub i inne platformy współpracy może zapewnić cenne spostrzeżenia i wsparcie. Dzielenie się doświadczeniami i rozwiązaniami przyczynia się do zbiorowego rozwoju technologii.

Podsumowanie

Qwen 3 stanowi znaczący postęp w dziedzinie dużych modeli językowych typu open source. Dzięki różnorodnym ofertom modeli, rozbudowanemu wsparciu językowemu i dostępnym platformom zapewnia solidny zestaw narzędzi dla szerokiej gamy aplikacji. Rozumiejąc, jak uzyskać dostęp do Qwen 3 i wdrożyć go, użytkownicy mogą wykorzystać jego możliwości, aby napędzać innowacyjność i wydajność w swoich domenach.

Jak zacząć

Deweloperzy mogą uzyskać dostęp Qwen3 API poprzez Interfejs API CometNa początek zapoznaj się z możliwościami modelu w Playground i skonsultuj się z Przewodnik po API aby uzyskać szczegółowe instrukcje. Należy pamiętać, że niektórzy deweloperzy mogą potrzebować zweryfikować swoją organizację przed użyciem modelu.