DeepSeek выпущен ДипСик V3.2 и высокопроизводительный вариант DeepSeek-V3.2-Speciale, с новым механизмом разреженного внимания (DSA), улучшенным поведением агента/инструмента и режимом «мышления» (цепочка мыслей), выявляющим внутренние рассуждения. Обе модели доступны через API DeepSeek (конечные точки, совместимые с OpenAI), а артефакты моделей и технические отчёты публикуются публично.

Что такое DeepSeek V3.2?

DeepSeek V3.2 — это преемник в семействе DeepSeek V3 — крупном семействе генеративных моделей с длинным контекстом, специально разработанном для рассуждение-сначала Рабочие процессы и использование агентов. Версия 3.2 объединяет предыдущие экспериментальные улучшения (V3.2-Exp) в линейку основных моделей, доступную через приложение DeepSeek, веб-интерфейс и API. Она поддерживает как быстрые диалоговые выводы, так и выделенный мышление режим (цепочка мыслей), подходящий для многошаговых задач на рассуждение, таких как математика, отладка и планирование.

Почему V3.2 важен (краткий обзор)

DeepSeek V3.2 примечателен по трем практическим причинам:

- Длинный контекст: До 128 тыс. окон контекста токенов, что делает его пригодным для длинных документов, юридических контрактов или многодокументных исследований.

- Дизайн, основанный на рассуждениях: Модель интегрирует цепочку мыслей («мышление») в рабочие процессы и использование инструментов — переход к агентным приложениям, которым требуются промежуточные этапы рассуждения.

- Стоимость и эффективность: Введение DSA (разреженного внимания) сокращает объем вычислений для длинных последовательностей, позволяя значительно удешевить вывод для больших контекстов.

Что такое DeepSeek-V3.2-Speciale и чем он отличается от базовой версии v3.2?

Что делает вариант «Speciale» особенным?

DeepSeek V3.2-Speciale — это высокопроизводительный, высокоинтеллектуальный Вариант семейства v3.2. По сравнению со сбалансированным вариантом v3.2, Speciale настроен (и прошёл постобучение) специально для многошаговых рассуждений, математических и агентных задач; он использует дополнительное обучение с подкреплением на основе обратной связи с человеком (RLHF) и расширенную внутреннюю цепочку рассуждений во время обучения. Эта временная конечная точка и доступ к API Speciale были объявлены ограниченными по времени (ссылка на истечение срока действия конечной точки для пути Speciale 15 декабря 2025 года).

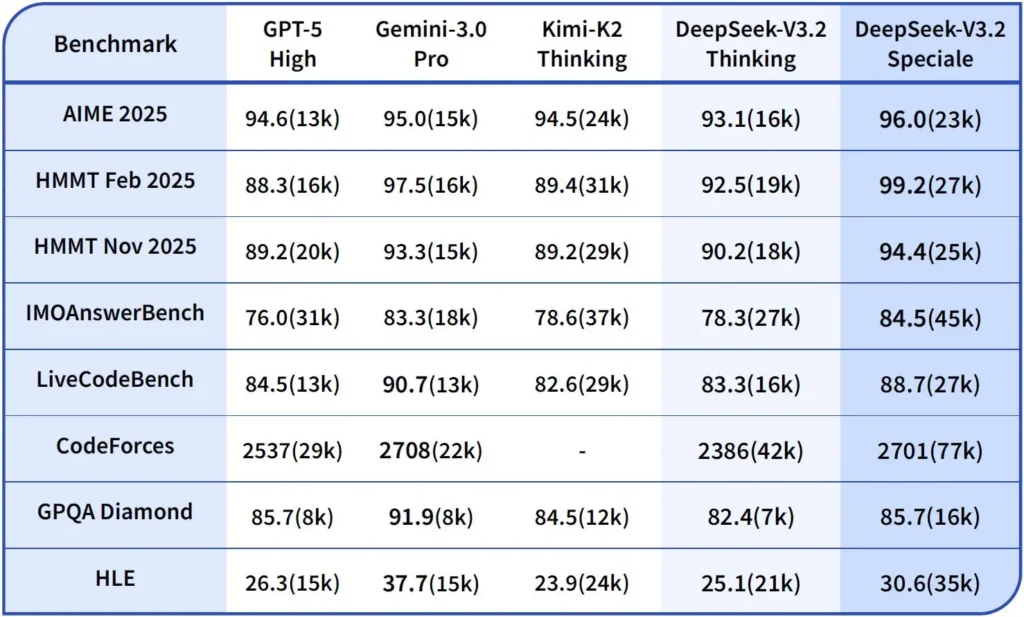

Производительность и тесты

DeepSeek-V3.2-Speciale — это высокопроизводительная версия V3.2, оптимизированная для рассуждений. Версия Speciale интегрирует предыдущую математическую модель DeepSeek-Math-V2. Она позиционируется как модель, используемая в случаях, когда рабочая нагрузка требует максимально глубокая цепочка мыслей, многошаговое решение проблем, конкурентное рассуждение (например, в стиле математической олимпиады) и сложная агентная организация.

Он может самостоятельно доказывать математические теоремы и проверять логические рассуждения. Он добился выдающихся результатов в многочисленных соревнованиях мирового уровня:

- Золотая медаль ММО (Международной математической олимпиады)

- Золотая медаль Китайской математической олимпиады (CMO)

- ICPC (Международный чемпионат по программированию) 2-е место (соревнование среди людей)

- IOI (Международная олимпиада по информатике) 10-е место (Человеческий конкурс)

Что такое режим рассуждения в DeepSeek v3.2?

DeepSeek раскрывает явный режим мышления/рассуждения что заставляет модель производить Цепочка мыслей (CoT) как дискретная часть выходного сигнала до Окончательный ответ. API предоставляет доступ к этому CoT, чтобы клиентские приложения могли его просматривать, отображать или анализировать.

Механика — что предоставляет API

reasoning_contentполе: когда включен режим мышления, структура ответа включаетreasoning_contentполе (CoT) на том же уровне, что и финальноеcontent. Это позволяет клиентам программно получать доступ к внутренним этапам.- Инструментальные вызовы во время размышлений: V3.2 поддерживает вызовы инструментов одной траектория мышления: модель может чередовать этапы рассуждения и вызовы инструментов, что повышает производительность сложных задач.

Как API DeepSeek v3.2 реализует рассуждения

В версии 3.2 представлен стандартизированный механизм API цепочки рассуждений для поддержания единообразной логики рассуждений в многооборотных диалогах:

- Каждый запрос на обоснование содержит

reasoning_contentполе внутри модели; - Если пользователь хочет, чтобы модель продолжила рассуждения, это поле необходимо передать обратно на следующий ход;

- Когда начинается новый вопрос, старый

reasoning_contentдолжны быть очищены, чтобы предотвратить логическое загрязнение; - Модель может многократно выполнять цикл «рассуждение → вызов инструмента → повторное рассуждение» в режиме рассуждения.

Как получить доступ и использовать API DeepSeek v3.2?

Кратко: CometAPI — это шлюз в стиле OpenAI, который предоставляет доступ ко многим моделям (включая семейства DeepSeek) через https://api.cometapi.com/v1 поэтому вы можете менять модели, изменяя model Строка в запросах. Зарегистрируйтесь на CometAPI и получите свой ключ API первым.

Почему следует использовать CometAPI вместо прямого DeepSeek?

- CometAPI централизует выставление счетов, ограничения скорости и выбор модели (удобно, если вы планируете сменить провайдера, не меняя код).

- Прямые конечные точки DeepSeek (например,

https://api.deepseek.com/v1) всё ещё существуют и иногда предоставляют функции, специфичные для поставщика; для удобства выберите CometAPI или прямую конечную точку поставщика для собственных элементов управления поставщика. Прежде чем использовать какие-либо функции (например, Speciale, экспериментальные конечные точки) доступны через CometAPI.

Шаг A — Создайте учетную запись CometAPI и получите ключ API

- Перейдите в CometAPI (регистрация / консоль) и сгенерируйте ключ API (панель управления обычно показывает

sk-...). Сохраните это в тайне. CometAPI

Шаг Б — Подтвердите точное название доступной модели

- Запросите список моделей, чтобы подтвердить точную строку модели, предоставляемую CometAPI (имена моделей могут включать суффиксы вариантов). Используйте конечную точку моделей перед жёстким кодированием имён:

curl -s -H "Authorization: Bearer $COMET_KEY" \

https://api.cometapi.com/v1/models | jq .

Найдите запись DeepSeek (например, deepseek-v3.2 or deepseek-v3.2-exp) и запишите точный идентификатор. CometAPI предоставляет /v1/models листинг.

Шаг C — Совершить простой чат-звонок (curl)

Замените <COMET_KEY> и deepseek-v3.2 с подтвержденным вами идентификатором модели:

curl https://api.cometapi.com/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer <COMET_KEY>" \

-d '{

"model": "deepseek-v3.2",

"messages": [

{"role":"system","content":"You are a helpful assistant."},

{"role":"user","content":"Summarize DeepSeek v3.2 in two sentences."}

],

"max_tokens":300

}'

Это тот же шаблон вызова в стиле OpenAI — CometAPI перенаправляет запрос выбранному провайдеру.

Совместимость и меры предосторожности

- Поддерживает включение режима «Think Mode» в среде Claude Code;

- В командной строке (CLI) просто введите имя модели deepseek-reasoner;

- Однако на данный момент он может быть несовместим с нестандартными инструментами, такими как Cline и RooCode;

- Рекомендуется использовать режим «Не-Думать» для обычных задач и режим «Думать» для сложных логических рассуждений.

Практические модели внедрения: несколько примеров архитектур

1 — Вспомогательный агент для рабочих процессов разработчиков

- Режим: Специальный (режим мышления) вызывается для сложной генерации кода и создания тестов; режим быстрого чата для встроенного помощника.

- Безопасность: Используйте проверки конвейера непрерывной интеграции и изолированное выполнение тестов для сгенерированного кода.

- хостинг: API или самостоятельное размещение на vLLM + кластер с несколькими GPU для большого контекста.

2 — Анализ документов для юридических/финансовых отделов

- Режим: V3.2 с оптимизацией длинного контекста DSA для обработки длинных контрактов и создания структурированных сводок и списков действий.

- Безопасность: Подписание юристом последующих решений; редактирование персональных данных перед отправкой на размещенные конечные точки.

3 — Автономный оркестратор конвейера данных

- Режим: Режим мышления для планирования многошаговых задач ETL, вызова инструментов для запросов к базам данных и вызова проверочных тестов.

- Безопасность: Реализуйте подтверждение действий и проверяемые проверки перед любой необратимой операцией (например, деструктивной записью в базу данных).

Каждый из вышеперечисленных шаблонов сегодня осуществим с моделями семейства V3.2, но вы должны сочетать модель с инструментами проверки и консервативным управлением.

Как оптимизировать затраты и производительность с помощью версии 3.2?

Используйте двойной режим намеренно

- Быстрый режим для микровзаимодействий: используйте режим «не думающего» инструмента для быстрого извлечения данных, преобразования форматов или прямых вызовов API, где задержка имеет значение.

- Режим размышлений для планирования и проверки: направляйте сложные задачи, многофункциональные агенты или решения, требующие повышенной безопасности, в режим размышлений. Фиксируйте промежуточные этапы и запускайте проверку (автоматизированную или выполняемую человеком) перед выполнением критически важных действий.

Какую модель мне выбрать?

- deepseek-v3.2 — сбалансированная производственная модель для общих агентских задач.

- deepseek-v3.2-Speciale — специализированный вариант с интенсивным рассуждением; изначально может быть доступен только на уровне API и использоваться, когда вам нужна максимально возможная производительность рассуждений/тестов (и вы готовы к потенциально более высокой стоимости).

Практические советы и контроль затрат

- Инженерные подсказки: сделайте системные инструкции лаконичными, избегайте отправки избыточного контекста. Явные системные инструкции: используйте системные подсказки, которые указывают на намерение режима, например: «Вы находитесь в режиме РАЗМЫШЛЕНИЯ — перечислите свой план перед вызовом инструментов». Для режима инструментов добавьте ограничения, например: «При взаимодействии с API калькулятора выводить только JSON со следующими полями».

- Расширение возможностей фрагментации и поиска: использование внешнего извлекателя для отправки только наиболее релевантных сегментов по каждому вопросу пользователя.

- Температура и отбор проб: понизьте температуру для взаимодействия инструментов, чтобы повысить детерминизм; повысьте ее в исследовательских задачах или задачах по генерации идей.

Оценка и измерение

- Относитесь к выходным данным как к ненадёжным, пока они не будут проверены: даже рассуждения могут быть неверными. Добавляйте детерминированные проверки (модульные тесты, проверки типов), прежде чем предпринимать необратимые действия.

- Проведите A/B-тестирование на тестовой рабочей нагрузке (задержка, использование токенов, корректность) перед принятием решения о выборе варианта. Версия 3.2 показала значительный прирост производительности в тестах на рассуждение, но реальное поведение приложения зависит от дизайна подсказок и распределения входных данных.

FAQ

В: Какой рекомендуемый способ получения CoT из модели?

A: Использовать deepseek-reasoner модель или набор thinking/thinking.type = enabled В вашем запросе. Ответ включает reasoning_content (CoT) и финал content.

В: Может ли модель вызывать внешние инструменты, находясь в режиме мышления?

О: Да — в версии 3.2 появилась возможность использовать инструменты как в режиме мышления, так и в режиме без мышления; модель может генерировать структурированные вызовы инструментов во время внутренних рассуждений. Использование strict режим и очистите схемы JSON, чтобы избежать неправильно сформированных вызовов.

В: Увеличивает ли использование режима мышления стоимость?

О: Да — режим мышления выдаёт промежуточные токены CoT, что увеличивает использование токенов и, следовательно, стоимость. Разрабатывайте систему так, чтобы мышление включалось только при необходимости.

В: Какую конечную точку и базовый URL-адрес мне следует использовать?

A: CometAPI предоставляет конечные точки, совместимые с OpenAI. Базовый URL по умолчанию: https://api.cometapi.com и основная конечная точка чата — это /v1/chat/completions (или /chat/completions (в зависимости от выбранного вами базового URL-адреса).

В: Нужны ли специальные инструменты для использования вызова инструментов?

О: Нет — API поддерживает структурированные объявления функций в формате JSON. Вам необходимо предоставить tools Параметр, схемы инструментов и управление жизненным циклом JSON-функции в вашем приложении: получение JSON-данных, вызов функции, выполнение функции и возврат результатов в модель для продолжения или завершения. Режим мышления добавляет требование передачи данных обратно. reasoning_content наряду с результатами работы инструмента.

Заключение

DeepSeek V3.2 и DeepSeek-V3.2-Speciale представляют собой явный шаг к открытый, ориентированный на рассуждение Программы магистратуры (LLM), которые делают цепочку мыслей явной и поддерживают рабочие процессы с использованием агентских инструментов. Они предлагают новые мощные примитивы (DSA, режим мышления, обучение использованию инструментов), которые могут упростить создание надёжных агентов, при условии учёта стоимости токенов, тщательного управления состоянием и операционного контроля.

Разработчики могут получить доступ API Deepseek v3.2 и т.д. через CometAPI, последняя версия модели Всегда обновляется на официальном сайте. Для начала изучите возможности модели в Детская Площадка и проконсультируйтесь с API-руководство для получения подробных инструкций. Перед доступом убедитесь, что вы вошли в CometAPI и получили ключ API. CometAPI предложить цену намного ниже официальной, чтобы помочь вам интегрироваться.

Готовы к работе?→ Бесплатная пробная версия deepseek v3.2 !

Если вы хотите узнать больше советов, руководств и новостей об искусственном интеллекте, подпишитесь на нас VK, X и Discord!